Seedream 4.0: Toward Next-generation Multimodal Image Generation

Seedream 4.0(即梦 4.0): 面向下一代多模态图像生成

字节跳动

论文地址:

https://arxiv.org/abs/2509.20427#:~:text=We%20introduce%20Seedream%204.0%2C%20an%20efficient%20and%20high-performance,editing%2C%20and%20multi-image%20composition%20within%20a%20single%20framework.

2025

【论文总结】

Seedream 4.0 是字节跳动推出的一款多模态图像生成系统,其特点包括:

- 高效架构设计:使用精心设计的扩散变换器(DiT)与高压缩比VAE相结合,相比Seedream 3.0,训练和推理速度提升了超过10倍;

- 联合多模态后续训练:通过持续训练(CT)、监督微调(SFT)及人类反馈强化学习(RLHF)三个阶段的策略,将文本到图像生成与图像编辑任务统一训练,并通过集成VLM模型作为提示工程(PE)模块来实现智能任务路由和提示重写;

- 对抗加速框架:融合Hyper-SD、RayFlow等技术,为每个样本定制自适应去噪路径,采用对抗蒸馏后训练(ADP)和对抗分布匹配(ADM)两个阶段的策略,显著减少函数评估次数(NFE),从而实现少步高质量采样;

- 硬件感知量化:采用自适应4/8位混合量化,结合离线平滑处理异常值、基于搜索的层次优化和后训练量化(PTQ),配合硬件特定操作实现无损性能的推理加速;

- 推测解码优化:通过条件化特征预测和KV缓存损失函数,解决了随机采样的不确定性问题。该系统在Artificial Analysis Arena的文本到图像和图像编辑两项榜单中均位居首位,实现了2K图像1.4秒的推理速度,支持最高4K分辨率的原生生成。

Abstract

We present Seedream 4.0, a streamlined and robust multimodal image creation system that integrates text-to-image (T2I) synthesis, image editing, and multi-image composition into one cohesive framework. We have engineered a highly effective diffusion transformer paired with a potent VAE, which significantly decreases the number of image tokens. This facilitates efficient training of our model, enabling rapid generation of high-definition images (e.g., 1K-4K). Seedream 4.0 undergoes pretraining on a vast corpus of text-image pairs encompassing a wide range of categories and knowledge-focused concepts. Extensive data gathering from numerous vertical scenarios, combined with refined strategies, ensures steady and extensive training, with robust generalization. By integrating a meticulously fine-tuned VLM model, we conduct multi-modal post-training to jointly train both T2I and image editing tasks. To expedite inference, we incorporate adversarial distillation, distribution alignment, and quantization, along with speculative decoding. It attains an inference speed of up to 1.4 seconds for producing a 2K image (excluding a LLM/VLM as PE model). Thorough assessments show that Seedream 4.0 can deliver top-tier results in both T2I and multimodal image editing. Notably, it excels in intricate tasks, such as accurate image editing and contextual reasoning, and supports multi-image referencing, capable of generating multiple output images. This transforms traditional T2I systems into a more interactive and multidimensional creative instrument, advancing the frontiers of generative AI for both creative and professional uses. Seedream 4.0 is currently available on Volcano Engineα.

【翻译】我们介绍Seedream 4.0,这是一个高效且高能的多模态图像生成系统,在单一框架内统一了文本到图像(T2I)合成、图像编辑和多图像组合。我们设计了一个高效的扩散变换器,配备强大的VAE,可以显著降低图像token的数量。这使我们的模型能够高效训练,并能够迅速生成原生高分辨率图像(例如1K-4K)。Seedream 4.0在数十亿个文本-图像对上进行了预训练,涵盖了多样化的类别和以知识为中心的概念。跨越数百个垂直领域的全面数据收集,结合优化策略,确保了稳定的大规模训练和强大的泛化能力。通过整合精细调整的VLM模型,我们对T2I和图像编辑任务进行了联合多模态后训练。为了加快推理速度,我们集成了对抗蒸馏、分布匹配、量化以及推测解码。在生成2K图像时实现了最高1.4秒的推理时间(不使用LLM/VLM作为PE模型)。全面评估表明,Seedream 4.0在T2I和多模态图像编辑方面均能达到顶尖的结果。尤其,它在复杂任务中展示了卓越的多模态能力,包括精准的图像编辑和上下文推理,还支持多图像参照,并能生成多个输出图像。这将传统的T2I系统拓展为更加互动和多维的创意工具,推动了生成式AI在创意和专业应用方面的边界。Seedream 4.0现可在Volcano Engineα上获取。

【解析】传统的图像生成系统通常将文本到图像生成、图像编辑和多图像合成视为独立的任务,需要不同的模型和框架,这增加了系统的复杂性,也限制了任务间的协同效果。Seedream 4.0通过单一框架整合这些功能,使不同任务间能够共享表征和知识。

Official Page: https://seed.bytedance.com/seedream4_0

Model ID: Doubao-Seedream-4.0

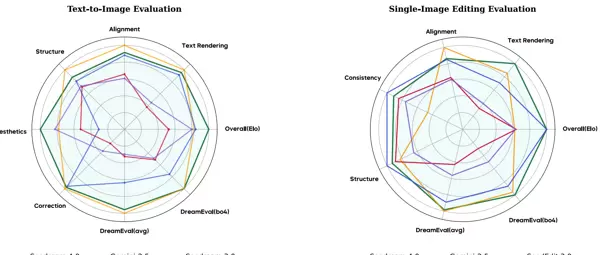

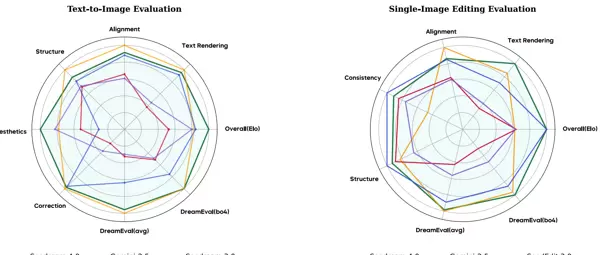

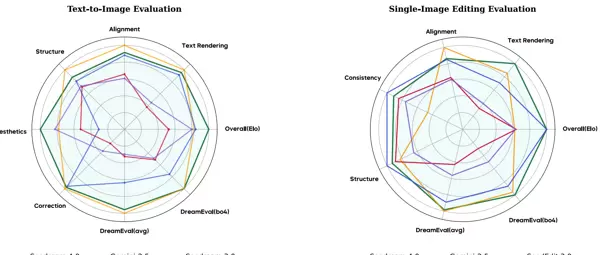

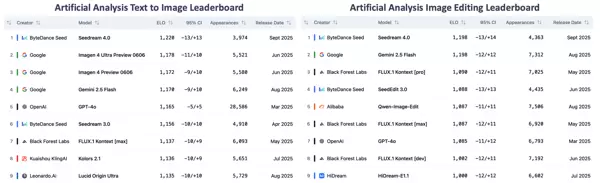

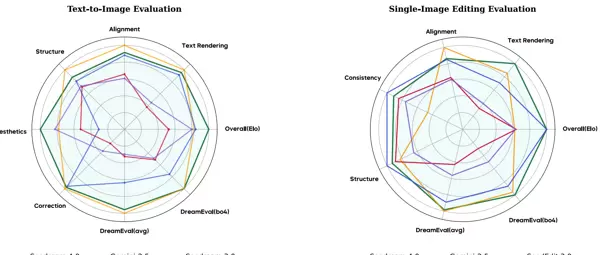

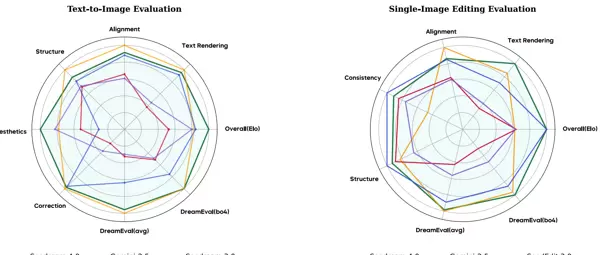

Figure 1 Overall evaluation. Left: Text-to-Image results; Right: Image-Editing results. The Elo scores are obtained from the Artificial Analysis Arena. Seedream 4.0 ranks first in both T2I and image-editing leaderboards, by September 18, 2025.

【翻译】图1 整体评估。左:文本到图像结果;右:图像编辑结果。Elo分数来自Artificial Analysis Arena。截至2025年9月18日,Seedream 4.0在T2I和图像编辑排行榜上均位列第一。

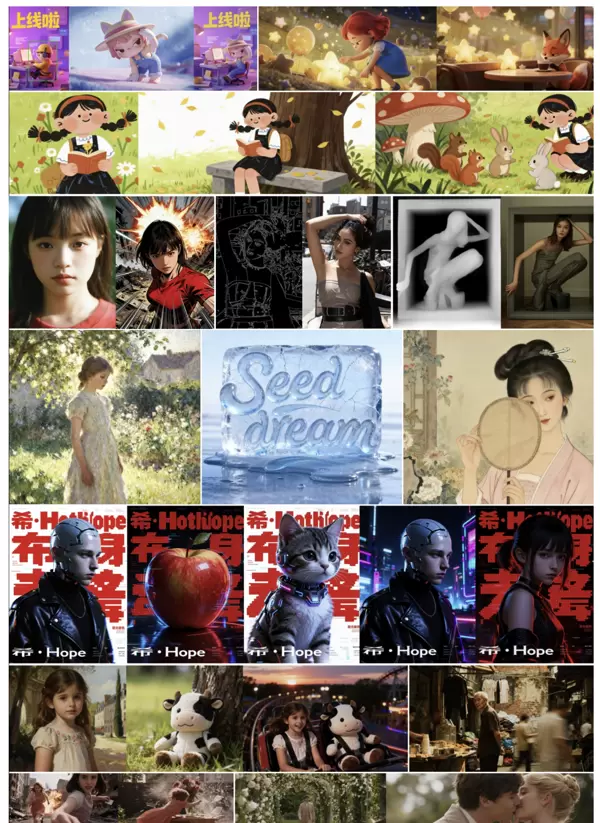

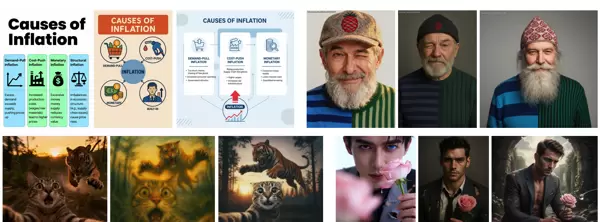

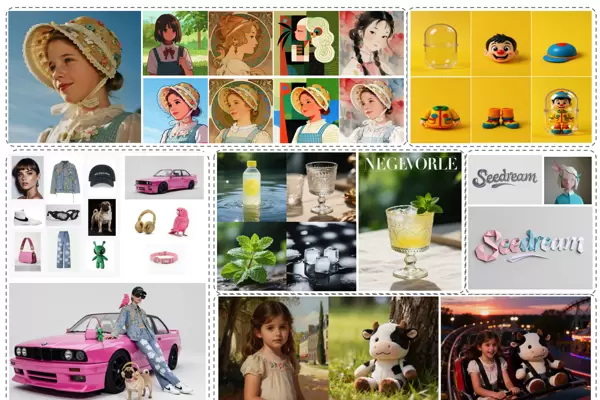

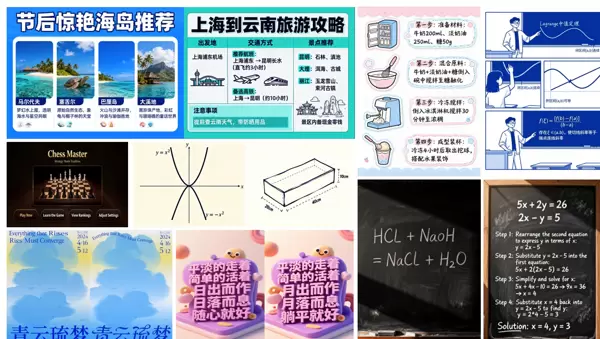

Figure 2 Seedream 4.0 visualization.

【翻译】图2 Seedream 4.0可视化展示。

1 引言

扩散模型引领了生成式AI的新纪元,使得图像的合成具有惊人的保真度和多样性。基于近期在扩散变换器(DiTs)上的进展,出现了诸如Stable Diffusion [18]、FLUX系列 [7, 8]、Seedream模型 [3, 4, 21]、GPT-4o图像生成 [15] 和Gemini 2.5闪电 [5]等先进的开源和商业系统。然而,随着对更高图像质量、更强控制能力和强大多模态能力(例如,文本到图像(T2I)合成和图像编辑)需求的增加,当前模型通常存在关键的可扩展性瓶颈。

【翻译】扩散模型引领了生成式AI的新纪元,能够创造具备卓越真实感和多样性的图像。最近基于扩散变换器(DiTs)的进步,催生了多个前沿的开源和商业系统,比如Stable Diffusion [18]、FLUX系列 [7, 8]、Seedream模型 [3, 4, 21]、GPT-4o图像生成 [15]和Gemini 2.5 flash [5]。然而,随着对更高图像品质、更强控制力和复杂多模态能力(如文本转图像(T2I)合成和图像编辑)的需求日益增长,现有模型通常存在重要的可扩展性障碍。

【解析】扩散模型通过逐步消除噪声的方法生成图像,此技术在图像品质和多样性上取得了显著进步。扩散变换器(DiTs)是将Transformer架构引入扩散模型中,利用了Transformer处理序列信息的强大功能。当前市场上主要的系统如Stable Diffusion使用了U-Net架构,而像FLUX和Seedream这样的新系统则转向了基于Transformer的架构。尽管这些系统的性能持续提升,但它们面临着可扩展性的挑战:当模型需处理更高分辨率的图像、支持更复杂的多模态互动时,计算成本和内存需求会迅速增加,限制了模型的实际应用和发展。

In this paper, we introduce Seedream 4.0, a robust multimodal generative model designed for scalability and efficiency. We have crafted an efficient and scalable DiT backbone that significantly boosts the model's capacity while markedly decreasing the training and inference FLOPs. To further improve model efficiency, particularly for generating high-resolution images, we have devised an efficient Variational Autoencoder (VAE) with a high compression rate, drastically reducing the number of image tokens in the latent space. This architectural design (including our DiT and VAE) renders our model highly efficient, easily scalable, and hardware-friendly during both training and inference. Our training strategy is thoughtfully crafted to fully harness the capabilities of our architecture, achieving over 10 × 10\times 10 × the inference speed compared to Seedream 3.0 [3], alongside notably superior performance. This enables the model to efficiently train on billions of text–image pairs at native resolutions from 1K to 4K, encompassing a broad spectrum of taxonomic and knowledge-centered concepts.

【翻译】在本文中,我们推出了Seedream 4.0,这是一款旨在实现可扩展性和效率的强大多模态生成模型。我们设计了一种高效且可扩展的DiT主干网络,显著增强了模型的能力,同时大幅度降低了训练和推理的FLOPs。为了进一步提升模型效率,尤其是针对高分辨率图像生成,我们开发了一种具有高压缩率的高效变分自编码器(VAE),极大地减少了潜在空间中的图像token数量。这种架构设计(包括我们的DiT和VAE)让我们的模型在训练和推理过程中都表现出极高的效率、易于扩展且对硬件友好。我们的训练策略经过深思熟虑,旨在充分发挥架构的优势,与Seedream 3.0 [3]相比,实现了超过 10 × 10\times 10 × 的推理速度提升,同时性能也显著增强。这使得模型能够在从1K到4K的原生分辨率下高效地训练数十亿个文本-图像对,覆盖广泛的知识分类和概念。

在后训练阶段,我们将具备强大多模态输入理解能力的VLM模型融入我们的系统,如同在SeedEdit [21]中所设计的,这增强了其强大的多模态生成能力。我们创新性地提出了联合后训练方法,通过在DiT框架中设计的因果扩散技术,将文本到图像生成与图像编辑相结合。我们的后训练阶段首先进行持续训练(CT),以拓宽模型的基础知识和多任务能力。随后,通过监督微调(SFT)来培养特定的艺术特性。接着,我们采用基于人类反馈的强化学习(RLHF),以精细地调整模型输出,使之符合复杂的人类偏好。之后,开发了提示工程(PE)模块,旨在广泛用户输入条件下最大化模型的潜能。为了实现DiT上的极速推理,我们提出了一种以对抗学习框架为核心的整体加速方案。这一关键算法进步与硬件感知量化和预测解码技术相辅相成,最终构建了一个在保证质量的同时提供秒级生成体验的系统。

后训练阶段是在预训练完成后对模型进行进一步优化的过程。VLM(视觉-语言模型)的引入是为了系统能够同时处理视觉和文本信息,即具备多模态理解能力。联合后训练的创新之处在于将原先独立的文本到图像生成和图像编辑任务整合到同一训练框架内,使模型能够在不同任务之间共享知识和表示。在DiT框架中采用因果扩散确保生成过程的时间一致性和逻辑连贯性。持续训练(CT)阶段通过在更广泛的数据集上继续训练,以增强模型的基础能力,这类似于人类学习中的知识累积过程。监督微调(SFT)则更为集中,通过高质量的标注数据来培养模型在特定领域(例如艺术创作)的专业技能。RLHF的引入,即利用人类反馈来优化模型的行为,使其更符合人类的价值观和审美标准。提示工程(PE)模块的功能是优化用户输入的处理,将自然语言描述转化为模型更容易理解的形式。在推理加速方面,对抗学习框架通过训练一个鉴别器来指导生成器产生更高质量的输出,同时减少生成步骤。硬件感知量化依据特定的计算硬件特性来优化模型参数的精度,在保持性能的同时降低计算成本。推测解码则通过预测未来的计算步骤来实现并行处理,大幅提高推理速度。

总之,Seedream 4.0展现了以下优势:

- 高效且可扩展的架构。我们的模型包含精心设计的DiT架构以及强大的VAE,同时具有高压缩比。这使得其架构不仅高效,而且相比Seedream 3.0 [3]在训练和推理加速(以计算FLOPS衡量)上提升了超过10倍,同时获得了显著更好的性能。Seedream 4.0的高效架构在模态容量、任务覆盖范围和多模态泛化方面表现出强大的可扩展性。

- 强大的多模态生成能力。我们基于Seededit 3.0 [20]的架构进行了扩展,用于多模态生成,并对我们预训练的DiT模型执行了T2I和图像编辑任务的多模态联合后训练。这使得Seedream 4.0具备了强大的多模态能力,支持单图或多图输入和输出。

- 专业的创作场景。除了艺术图像外,Seedream 4.0还展示了生成结构化、专业和知识型内容的强大能力,如图表、公式和设计材料,弥合了创意生成与实际行业应用之间的差距。

Extremely rapid inference speed. Through an efficient architectural design, we have made significant optimizations to our framework to achieve remarkable inference acceleration. This enables our model to conduct ultrafast image creation and modification at high resolutions (such as 2K or 4K), significantly improving user interaction and production efficiency.

By September 2025, Seedream 4.0 has been successfully integrated into several platforms, including Doubao and Jimeng. It is also available on Volcano Engine α α α . We believe Seedream 4.0 will become a practical tool for enhancing productivity across various aspects of work and daily life.

【Summary】In summary, Seedream 4.0 boasts the following advantages:

- Efficient and scalable architecture. Our model features a meticulously designed DiT architecture and a robust VAE, alongside a high compression ratio. This results in an effective structure that, compared to Seedream 3.0 [3], achieves over 10 × 10× 10 × acceleration in training and inference (measured by the number of floating-point operations), with notably superior performance. The efficient architecture of Seedream 4.0 exhibits strong scalability in modal capacity, task coverage, and multi-model generalization.

- Powerful multimodal generation. We have extended the architecture of Seededit 3.0 [20] for multimodal generation, performing joint post-training for T2I and image editing tasks on our pretrained DiT model. This endows Seedream 4.0 with potent multimodal capabilities, enabling single or multi-image input and output.

- Professional creation scenarios. Beyond artistic images, Seedream 4.0 demonstrates a strong ability to generate structured, professional, and knowledge-based content, such as charts, formulas, and design materials, bridging the gap between creative generation and practical industrial applications.

- Ultrafast inference speed. By leveraging an efficient architectural design, we have further actively optimized our framework to achieve extreme inference acceleration. This allows our model to perform ultrafast image generation and editing at high resolutions (for example, 2K or 4K), greatly enhancing user interaction and production efficiency.

As of September 2025, Seedream 4.0 has been successfully integrated into multiple platforms, including Doubao and Jimeng. It is also accessible on Volcano Engine α α α . We believe Seedream 4.0 will become a practical tool for boosting productivity in all aspects of work and daily life.

【Analysis】

The four advantages of Seedream 4.0 are summarized. Firstly, architectural efficiency, where the DiT (Diffusion Transformer) architecture offers better parallelism and scalability compared to traditional U-Net architectures, while the high compression ratio of VAEs (Variational Autoencoders) reduces computational complexity by using less latent space to encode image information. Modal capacity refers to the model's ability to handle different types of data, and task coverage indicates the range of tasks the model can perform. Secondly, multimodal generation capability, where the joint post-training strategy allows the model to learn both text-to-image generation and image editing simultaneously, making this unified training approach more efficient than training two separate models and facilitating knowledge transfer between different tasks. The third advantage is the generation of professional content, breaking the limitation of traditional image generation models being primarily used for artistic creation and expanding into practical commercial and academic scenarios. Generating structured content like charts and formulas requires the model to possess stronger logical understanding and precise control capabilities. Lastly, inference speed, where high-resolution image generation typically demands substantial computational resources, but Seedream 4.0 achieves a significant increase in speed while maintaining quality through architectural optimization and algorithmic improvements.

Data, Model Training, and Acceleration

Model Pretraining

Data. In Seedream 3.0, we introduced a dual-axis collaborative data sampling framework that jointly optimizes pre-training data across two dimensions: visual morphology and semantic distribution. However, we identified two limitations when employing a purely top-down resampling strategy:

It disproportionately favors natural images in the overall distribution.

It inadequately represents fine-grained, knowledge-focused concepts (e.g., instructional content and mathematical expressions).

To tackle these issues, we redesigned the pipeline specifically for knowledge-related data, including instructional images and formulas.

【翻译】数据。在Seedream 3.0中,我们引入了双轴协作数据采样框架,该框架沿着两个维度联合优化预训练数据:视觉形态和语义分布。然而,我们在应用纯粹的自上而下重采样策略时观察到两个局限性:

- 它在整体分布中不成比例地偏向自然图像。

- 它对细粒度、以知识为中心的概念(例如教学内容和数学表达式)代表性不足。

为了解决这些问题,我们专门为知识相关数据重新设计了流水线,包括教学图像和公式。

【解析】

双轴协作数据采样框架是Seedream 3.0提出的数据处理方法,其核心思想是同时考虑图像的视觉特征和语义内容来优化训练数据的选择。视觉形态指的是图像的外观特征,如颜色、纹理、构图等视觉元素;语义分布则关注图像所表达的概念和含义的分布情况。自上而下的重采样策略是指根据预设的规则或标准来筛选和调整数据分布,但这种方法存在系统性偏差。偏向自然图像的问题是因为模型在训练时会更多地学习到自然场景的特征,而对人工创造的内容(如图表、公式、设计图等)的理解能力相对较弱。细粒度知识概念的代表性不足说明模型对专业领域的深层理解存在缺陷,特别是需要精确理解和生成的教学材料和数学公式。作者重新设计流水线的目的是通过更加精细化的数据处理策略来平衡不同类型数据的分布,确保模型能够获得更全面和均衡的训练。

In our pipeline, knowledge data are categorized into natural and synthetic subsets. For natural images, we collect high-quality figures from PDF documents that include in-house textbooks, research articles, and novels. We first deploy a low-quality classifier to filter out undesirable samples (e.g., blurry images, cluttered, or noisy backgrounds). Next, we train a difficulty rating classifier with three levels: easy, medium, and hard, and we annotate all images accordingly. Images with extreme difficulty are down-sampled during pre-training. For synthetic data, we use both OCR output and LaTeX source code (when available) to generate diverse formula images that vary in structure (layout, symbol density) and resolution. This synthesis strategy broadens the coverage of fine-grained concepts and reduces the biases introduced by top-down resampling.

【翻译】在我们的工作流程中,知识数据被划分为自然和合成两类。对于自然图像,我们从PDF文件中获取高质量的插图,这些文件包括内部教材、研究论文和小说。我们首先应用一个低品质筛选器来剔除不理想的样本(比如模糊图片、混乱或嘈杂的背景)。随后,我们训练一个具有三个等级难度评估器:容易、中等和困难,并对所有图像进行相应的标记。特别难的图像在预训练时被减少采样。对于合成数据,我们利用OCR输出和LaTeX源码(如果存在)来创建结构(布局、符号密度)和分辨率多样化的公式图像。这种合成方法扩展了细粒度概念的覆盖面,并减少了自顶向下重采样带来的偏见。

【解析】

这里的自然图像是指从实际文档中提取的原始图像,这些图像具备真实的使用环境和自然的视觉特性,但质量不一。合成数据是通过算法生成的模拟图像,可以精确控制其特性和质量。从PDF文件中提取图像的好处在于这些图像通常具有明确的教育或学术价值,并已通过一定的质量检查。低品质筛选器的功能是自动辨识并排除那些可能影响模型学习效果的次质图像,即数据净化。难度评估器的设计基于教育理论,不同难度的内容对模型学习的贡献各不相同。简单内容有助于构建基本理解,中等难度内容是主要的学习目标,而特别难的内容可能会引入干扰或导致过度拟合,因此需要减少其在训练中的比例。OCR(光学字符识别)输出提供了图像中文字的结构化表述,而LaTeX源码则包含了数学公式的精确语义信息。通过整合这两种信息源,可以生成视觉表现各异但语义相同的公式图像,数据增强能提升模型对数学符号和公式结构的理解力。符号密度的变化有助于模型学习处理不同程度复杂的数学表达式,而分辨率的变化则确保模型能在不同清晰度下准确识别和生成公式。

Beyond knowledge-related data, we introduce several module-level upgrades compared to our previous version. (1) We train a text-quality classifier to identify low-quality text in the original caption; (2) We integrate semantic and low-level visual embeddings in the deduplication process to enhance the deduplication outcomes, balancing the fine-grained distribution; (3) We refine the captioning model for more detailed visual descriptions; and (4) We employ a more robust cross-modal embedding for image-text alignment, significantly improving our multimodal retrieval system.

【翻译】除了与知识相关的数据外,与我们先前的版本相比,我们引入了几项模块级别的改进。(1) 我们训练了一个文本质量分类器来识别原始说明中的低质量文本;(2) 我们在去重过程中结合了语义和低级视觉嵌入,以加强去重效果,平衡细粒度分布;(3) 我们优化了标题生成模型,以实现更详细的视觉描述;(4) 我们采用了一个更强大的跨模态嵌入用于图像-文本对齐,显著提升了我们的多模态检索系统。

【解析】

这里阐述了Seedream 4.0在数据处理上的改进。文本质量分类器的作用是自动识别并去除那些描述不准确、有语法错误或信息不全的图像标题,这对于训练高质量的图像生成模型至关重要,因为低质量的文本标签会引导模型学习错误的图像-文本对应关系。语义嵌入捕捉的是文本或图像的高层次意义和概念信息,而低级视觉嵌入则关注颜色、纹理、边缘等基础视觉特征。将两者结合起来用于去重,可以更准确地识别内容相似但视觉表现略有差异的图像,避免训练数据中的重复。细粒度分布的均衡确保了不同种类和风格的图像在训练集中得到适当的表现。标题生成模型的优化使得图像描述更为精确和详尽,影响最终生成图像的质量及其与文本提示的匹配度。跨模态嵌入作为连接图像和文本两大不同领域的桥梁,更强的跨模态嵌入能更好地理解图像内容与文本描述之间的关联,从而提高多模态检索的准确性和相关性。

训练策略。类似于Seedream 3.0 [3],我们实施多阶段训练以提升训练效能。在初始阶段,我们在平均分辨率为 51 2 2 512^{2} 51 2 2 (拥有不同的长宽比)下训练我们的DiT。在后续阶段,我们在从 102 4 2 1024^{2} 102 4 2 到 409 6 2 4096^{2} 409 6 2 的较高分辨率范围内对模型进行微调。得益于我们模型的设计效率,在这些最高达4K的高分辨率上进行训练依然有效。

多阶段训练是将复杂训练任务拆分为多个较为简单的子任务,逐步提升模型性能。在图像生成任务中,直接在高分辨率上训练模型会遇到巨大的计算资源消耗和训练不稳定性问题。通过先在较低分辨率 51 2 2 512^{2} 51 2 2 上训练,模型能首先掌握图像的基础结构、色彩分布和语义信息,建立稳固的特征表达能力。不同长宽比的训练确保模型能够适应多种图像格式,而不仅限于正方形图像。第二阶段的高分辨率微调是在已有基础之上的精细训练,此时模型已具备基本的图像理解和生成能力,只需学习如何在更高分辨率下保持细节的清晰和一致性。从 102 4 2 1024^{2} 102 4 2 到 409 6 2 4096^{2} 409 6 2 的逐步分辨率提升进一步简化了训练难度,使模型能够逐渐适应更高的分辨率要求。DiT架构的高效设计确保即使在4K分辨率下训练也能维持合理的计算成本和训练稳定性。

训练基础设施。为了实现DiT模型的高效大规模预训练,我们设计了一个高度优化的训练系统,该系统突出硬件效率、可扩展性和稳健性。主要组成部分概述如下。

并行性和内存优化。我们采用混合分片数据并行(HSDP)来高效地分割权重,并支持大规模训练,无需依赖张量或专家并行。通过及时释放隐藏状态、激活卸载和增强的FSDP支持来优化内存使用,从而在可用的GPU资源内训练大型模型。

训练基础设施是支持大规模深度学习模型训练的基础技术架构,涵盖硬件资源管理、并行计算策略和内存优化机制。对于像DiT这样的大型扩散变换器模型,传统的单一机器训练方法无法满足其巨大的参数数量和计算需求,因此需要开发专用的分布式训练系统。硬件效率着重于如何最大限度地发挥GPU等计算资源的效能,防止资源空闲和计算瓶颈。可扩展性确保训练系统能随着模型规模和数据量的增加而平稳扩展,不会因规模扩大而出现性能骤降。鲁棒性则确保训练过程的稳定性,能够处理硬件故障、网络中断等异常状况。混合分片数据并行(HSDP)是一种先进的分布式训练策略,它将模型参数在多个GPU间智能分割,每个GPU只需存储和计算部分参数,从而克服单个GPU的内存限制。与传统的张量并行(将单个张量分割到多个设备)和专家并行(将不同的专家模块分配到不同设备)相比,HSDP在通信成本和实现复杂度上具有优势。隐藏状态的即时释放指在前向传播过程中,一旦某层的隐藏状态不再需要用于后续计算,就立即从内存中删除,避免内存累积。激活卸载技术将部分激活值暂时存储到CPU内存或硬盘中,在反向传播时再重新加载,这样可以显著减少GPU内存占用。FSDP(Fully Sharded Data Parallel)是Facebook提出的一种全分片数据并行技术,通过将优化器状态、梯度和参数都进行分割,进一步减少每个GPU的内存需求。增强的FSDP表明作者在原有技术基础上进行了改进和优化,使其更适应DiT模型的训练特性。

内核和工作负载优化。通过结合torch.compile与手工编写的CUDA内核和操作融合,加速性能关键操作,减少冗余内存访问。为解决可变序列长度引起的工作负载不平衡问题,我们引入了全局贪婪样本分配策略和异步管道,实现了更均衡的每GPU利用率。

【翻译】内核和工作负载优化。通过将torch.compile与手工制作的CUDA内核和算子融合相结合,加速性能关键操作,减少冗余内存访问。为了解决可变序列长度导致的工作负载不平衡问题,我们引入了一个全局贪心样本分配策略和异步流水线,实现了更平衡的每GPU利用率。

【解析】

内核和工作负载优化直接影响训练效率和资源利用率。torch.compile 是PyTorch框架提供的即时编译技术,能够将Python代码动态编译成更高效的机器代码,减少解释执行的开销。手工编写的CUDA内核是针对特定计算模式专门优化的GPU计算程序,与通用的库函数相比,这些定制内核能够更充分地利用GPU的并行计算能力和内存层次结构。操作融合技术将多个连续的数学运算合并为单个内核执行,避免了中间结果在GPU内存中的重复读写,显著降低了内存带宽需求和延迟。可变序列长度是自然语言处理和多模态任务中的常见现象,不同样本的输入长度差异较大,直接导致各GPU处理时间不一致,形成计算瓶颈。全局贪婪样本分配策略通过智能调度算法,将计算量相近的样本分配给同一GPU批次,最大化并行效率。异步流水线技术允许数据预处理、模型计算和结果后处理同时进行,隐藏数据传输和预处理的延迟,确保GPU始终保持高负载状态。这种优化策略对于大规模分布式训练尤为重要,因为任何单个GPU的性能瓶颈都会影响整个训练集群的效率。

容错性。系统内置了多层次的容错机制,包括定期检查点保存模型、优化器和数据加载器状态,启动前健康检查以排除故障节点,以及减少初始化开销。这些措施确保了长期分布式训练期间的稳定性和持续吞吐量。

【翻译】容错性。系统集成了多层次的错误容忍机制,包括定时保存模型、优化器及数据加载器的状态、运行前的健康检查以排除有问题的节点,以及降低启动时的资源消耗。这些措施确保了长时间分布式训练过程中的稳定性和持续的数据处理速率。

【解析】

容错性是大规模分布式训练系统的关键,因为在涉及成百上千个GPU的训练场景中,硬件故障、网络问题和软件异常是常见的现象。多层次的容错机制采取了分层保护策略,从多个角度确保训练的连续性。定时保存检查点是最基本的容错方法,定期将模型参数、优化器状态(例如动量、学习率调度器状态)和数据加载器的位置等重要信息存入持久化存储。这样即便遇到故障,训练也可以从最近的检查点恢复,而无需重新开始。检查点的频率需在容错效果和存储成本之间取得平衡,过高的频率可能影响训练效率,过低则可能导致大量训练进展的损失。运行前的健康检查是一种预防措施,通过系统地测试每个计算节点的GPU状况、内存大小、网络连接性和存储访问能力,提前发现并移除可能导致训练中断的问题节点。这种主动的检测方式避免了训练过程中因硬件问题而导致的中断,节约了计算资源和时间。减少启动时的资源消耗涉及优化模型权重的加载、分布式通信的建立和数据预处理流程的启动,从而最小化从检查点恢复训练所需的时间。在长时间的分布式训练中,这些容错措施的共同作用可以确保训练过程能应对各种异常情况,保持稳定的计算效率,最终确保训练任务的顺利完成。

2.2 模型后训练

We conduct an extensive post-training to boost the multimodal capabilities of our model, encompassing text-to-image generation (T2I), single image editing, and multi-image referencing and output. Specifically, we undertake joint training across multiple tasks via multistage post-training, which includes continuous training (CT), supervised fine-tuning (SFT), and human feedback alignment (RLHF) [11, 23–25]; alongside this, a meticulously refined prompt engineering (PE) model has been developed. Performance is enhanced steadily and substantially at each substage, leading to superior outcomes compared to models trained on individual tasks. Notably, the CT phase primarily boosts the model's capability to follow instructions for image editing, while the SFT significantly improves the alignment between the reference and edited images.

【翻译】我们实施了深入的后训练,以提升模型的多模态功能,涵盖文本转图像生成(T2I)、单一图像编辑以及多图像参照与输出。具体而言,我们通过多阶段后训练执行多任务联合训练,包括持续训练(CT)、监督微调(SFT)和人机反馈对齐(RLHF)[11, 23–25];同时,还开发了一个经过精细调整的提示工程(PE)模型。每个子阶段的表现都有了持续且显著的提升,与仅在单个任务上训练的模型相比,表现更佳。特别地,CT阶段主要提升了模型在图像编辑方面的指令遵循能力,而SFT则大幅提高了参考图像与编辑后图像之间的一致性。

【解析】

后训练是在预训练基础上实施的专门化训练过程,旨在让通用模型具备特定任务的专业技能。对于多模态图像生成模型来说,后训练尤其关键,因为在预训练阶段主要习得的是基本的图像-文本对应关系,而在实际应用中所需的精准控制、风格转变、局部编辑等高级功能需通过后训练实现。多阶段后训练采取逐步提升能力的策略,每个阶段均设有明确的训练目标和数据配置。持续训练(CT)阶段基于预训练模型继续利用大规模数据进行训练,但会调整数据分布和训练目标,着重提高模型对编辑指令的理解与执行能力。此阶段的核心在于使模型掌握将自然语言指令转换为具体图像变换操作的技能。监督微调(SFT)阶段运用高质量的标注数据对模型进行精细调整,特别注重输入参考图像与输出编辑图像之间的一致性保持。该阶段的训练数据通常包含准确的编辑前后的对比样本,助力模型在执行编辑指令时保持图像其他部分的不变性。人类反馈对齐(RLHF)通过人类评估者的偏好反馈进一步优化模型行为,确保生成结果符合人类的审美标准和实用性需求。提示工程(PE)模型是一个专门的辅助模型,负责将用户的自然语言输入转换成更适配主模型理解的结构化提示,这种设计能显著改善用户体验和模型性能。多任务联合训练的优势在于不同任务间的知识可以互相迁移和增强,防止单任务训练可能引发的过拟合和能力局限。

We construct a large amount of editing data that is used in the CT and SFT stages. Each data sample typically has a reference image and a target image, along with an editing instruction. Image captions are generated for both the reference and target images. We have devised three types of captions with varying levels of detail, serving as a form of data augmentation during training. Additionally, we promote the use of consistent terminology in captions to depict similarities between reference and target images.

【翻译】我们构建了大量用于CT和SFT阶段的编辑数据。每个数据样本通常包含一个参考图像和一个目标图像,以及一个编辑指令。为参考图像和目标图像都生成了图像标题。我们设计了三种不同详细程度的标题类型,在训练过程中起到数据增强的作用。此外,我们鼓励在标题中使用一致的术语来描述参考图像和目标图像之间的相似性。

【解析】

编辑数据的构建是图像编辑模型训练的核心环节,数据质量直接影响模型的编辑能力和效果。每个训练样本的三元组结构(参考图像、目标图像、编辑指令)为模型提供了全面的学习信号:参考图像告知模型编辑的起始点,目标图像展示预期的编辑结果,编辑指令则阐述了从起始到目标的转换要求。这种结构化的数据设计使模型能够学习到指令与视觉变化之间的精确映射关系。为参考图像和目标图像分别生成标题具有多重意义:首先,标题提供图像内容的文本描述,帮助模型建立更牢固的图像-文本对应关系;其次,通过对比两个标题的差异,模型可以更深入地理解编辑操作的具体内容和范围。三种不同详细程度的标题设计体现了数据增强的策略理念:简要标题关注主要对象和场景,中等详细程度的标题包含更多属性描述,详尽标题则涵盖细节特征和空间关系。这种多层次的描述方式让模型在训练时接触到不同粒度的文本信息,提升了对各种复杂度指令的适应能力。一致术语的使用确保了模型学习到稳定的概念映射,避免由于描述方式的变化而造成的理解困难。例如,在描述颜色、材质、风格等属性时,使用标准化的词汇有助于模型建立可靠的特征识别和生成能力。

We developed an end-to-end vision language model (VLM) as our PE model based on Seed1.5-VL [6]. This VLM model handles user inputs, such as a text prompt, a solitary reference image, or several images, and produces the relevant outputs (for instance, the captions for the reference image and the target or forecasted image, similar to what SeedEdit 3.0 [20] accomplished), which are subsequently utilized as input for the DiT model. The capabilities of the PE model also encompass task routing, prompt refinement (with automated reasoning), and optimal aspect ratio assessment. To harmonize latency and efficiency, our model dynamically modifies its reasoning budgets according to task intricacy, drawing inspiration from AdaCoT [12]. This cohesive strategy empowers Seedream 4.0 to more accurately interpret user intentions, conduct intricate reasoning, and produce a sequence of images from a single request.

【翻译】我们基于Seed1.5-VL [6]开发了一个端到端的视觉语言模型(VLM)作为我们的PE模型。该VLM模型处理用户输入,包括文本提示、单独的参考图像或多个图像,并生成相应的输出(例如,参考图像和目标或预测图像的标题,类似SeedEdit 3.0 [20]所实现的),随后将这些输出用作DiT模型的输入。PE模型的功能还包括任务路由、提示精炼(带有自动化推理)和最优宽高比评估。为了调和延迟和效率,我们的模型根据任务复杂性动态调整其推理预算,灵感来源于AdaCoT [12]。这种综合策略使Seedream 4.0能够更准确地理解用户意图,进行复杂推理,并从单个请求生成一系列图像。

【解析】提示工程(PE)模型在整个Seedream 4.0系统中充当中介角色,是连接用户自然语言输入和底层图像生成模型的桥梁。基于Seed1.5-VL构建的视觉语言模型具备同时理解和处理文本与图像信息的能力,其多模态理解能力用于应对复杂的图像编辑和生成任务。该模型的输入处理能力覆盖了多种模式组合:纯文本提示适合从头开始生成图像,单图像输入支持图像编辑和风格转换,多图像输入则能处理更为复杂的合成和参考任务。输出生成过程不仅包含对输入内容的理解和描述,还涉及到对预期结果的预测和规划,这种前瞻性处理方式为后续的DiT模型提供了更加精确和结构化的指导信息。任务路由功能通过分析用户输入的特性与意图,自动判定应采取何种处理策略和模型配置;提示精炼功能通过自动化推理机制对用户的原始输入进行优化和扩展,将模糊或不完整的信息转化为更具体和详尽的指令,这一过程类似于专业设计师对客户需求的理解和细化。最优宽高比评估根据内容特性和用户意图自动确定生成图像的最佳尺寸比例,避免了用户手动设定的麻烦和可能的不当选择。动态推理预算调整机制借鉴了AdaCoT的自适应计算理念,依据任务的复杂程度分配不同的计算资源和处理时间,简单任务快速完成以减少延迟,复杂任务深入分析以确保质量。这种平衡策略在实际应用中至关重要,因为用户既要求响应速度快又要求结果质量高。集成方法的优势在于将多个功能模块整合在一个框架内,实现了信息的无缝流动和协同优化,使得Seedream 4.0能够从单一的用户请求中理解复杂的创作意图,并生成符合需求的图像系列。

2.3 模型加速

高效、高质量合成。我们的加速框架融合了Hyper-SD [17]、RayFlow [19]、APT [10] 和 ADM [13] 的原则,以加速扩散变换器(DiTs)。我们的方法构建了一个创新的范式,其中每个样本遵循优化的自适应轨迹,而非通向高斯先验的共同路径。这种定制化减少了轨迹重叠,并降低了不稳定性。为了有效学习这些路径,我们采用了对抗匹配框架来替代固定的差异度量,避免了模式崩溃,并显著提升了生成稳定性和样本多样性。这通过两阶段过程实现,首先是强大的对抗蒸馏后训练(ADP)阶段,使用混合判别器确保稳定的初始化。接着,对抗分布匹配(ADM)框架采用可学习的、基于扩散的判别器进行微调,实现对复杂分布的更精细匹配。我们的统一流水线实现了高效的少步采样,大幅减少了函数评估次数(NFE),同时在美学质量、文本-图像对齐和结构保真度等关键维度上达到或超过需要数十步的基准方法,有效平衡了质量、效率和多样性。

传统的扩散模型需要数十甚至上百次的迭代采样才能生成高品质图像,这在实际应用中导致了显著的延迟问题。作者提出了一种加速框架,通过融合多项先进技术的核心理念,创建了一个新的生成模式。在传统扩散模型中,所有样本均遵循相同的去噪路径,从随机噪声逐渐收敛至高斯先验分布,这种方式忽视了不同样本的个性化需求。创新的自适应路径设计为每个样本提供了个性化的去噪路线,依据样本的内容特性和复杂性动态调整采样步骤和参数,从而使得简单的样本能以更少的步骤迅速收敛,复杂的样本则得到更为精细的处理。路径重叠最小化确保了不同样本的生成路径尽可能独立,减少了互相干扰带来的质量下降。对抗匹配框架是该方法的核心技术,它放弃了传统的固定散度测量(如KL散度、Wasserstein距离等),转而使用动态学习的匹配策略。固定的散度测量通常无法精确捕捉复杂数据分布的微妙差异,而对抗匹配通过判别网络自动学习最优的分布比较方法。模式崩溃是生成模型常见的问题,指的是模型只能生成有限种类的样本模式,缺乏多样性。对抗匹配框架通过动态调整匹配策略有效地解决了这一问题。两阶段训练策略是逐步优化的过程:对抗蒸馏后训练(ADP)阶段利用混合判别器建立稳定的基线,混合判别器融合了多种判别策略的优点,保证了训练初期的稳定性。对抗分布匹配(ADM)阶段则采用更细致的基于扩散的判别器,这种判别器本身具有扩散模型的特点,能够更准确地理解和匹配复杂的数据分布。函数评估次数(NFE)是衡量扩散模型效率的关键指标,每次函数评估都需要进行一次完整的神经网络前向传播,计算成本较高。该方法通过优化采样路径和匹配策略,在保持甚至提高生成质量的同时大幅减少了所需的评估次数,实现了质量、效率和多样性的最佳平衡。

量化。为了在不牺牲质量的前提下进一步提升推理性能,我们采用了结合量化和稀疏性的硬件感知框架。我们的方法使用自适应4/8位混合量化,包含离线平滑处理异常值、基于搜索的优化来确定敏感层的最佳粒度和缩放,以及后训练量化(PTQ)来最终确定参数。我们与高效的、硬件特定的操作符协同设计,适用于各种位宽和粒度,以最大化性能。

传统的深度学习模型通常采用32位浮点数来表达参数和激活值,而量化技术则将这些数值转变为较低精度的形式,例如8位整数或4位整数。硬件感知框架指出,这种量化策略并非一概而论,而是针对特定的硬件平台(如GPU、TPU、移动处理器等)的特点进行了优化。由于不同硬件对各种位宽运算的支持程度不一,因此硬件感知设计能够更充分地利用目标硬件的计算资源。稀疏性与量化的结合进一步增强了压缩效果,稀疏性通过将某些参数设为零来减少实际所需的存储和计算量。自适应4/8位混合量化是一种细致的量化策略,根据不同层和参数的重要性和敏感度选择不同的量化精度。关键层和敏感参数采用8位量化以维持较高的精度,而对精度需求较低的部分则采用4位量化以达到更高的压缩率。离线平滑是预处理的一个步骤,旨在处理参数分布中的异常值。异常值可能严重影响量化效果,因为量化过程需要将连续的浮点数映射到离散的整数空间,异常值可能导致量化范围过宽,从而降低其他常规值的量化精度。离线平滑通过统计分析和数值变换技术减轻异常值的影响。基于搜索的优化是一种自动化调整超参数的过程,针对每层自动寻找最佳的量化粒度(如按通道量化、按张量量化等)和缩放因子。敏感层指的是对量化误差特别敏感的网络层,这些层的量化精度直接影响到模型的最终表现。后训练量化(PTQ)是在模型训练完成后进行的量化过程,与训练时量化相比,PTQ无需重新训练模型,降低了实施成本。硬件特定算子的协同设计确保了量化后的模型能在目标硬件上高效运行,不同的位宽和粒度组合需要相应的底层计算内核支持。

对于PE的推测解码,我们的方法建立在Hyper-Bagel[14]的基础研究之上,旨在解决由随机token采样导致的推测解码中的固有不确定性。我们的方案将特征预测基于前序特征序列和提前一个时间步的token序列。这提供了一个明确的目标,解决了采样不确定性,并大幅提升了预测的准确性。此外,我们通过在Key-Value(KV)缓存上应用损失函数来进一步改善这一过程,以促进推理期间的高效重用,并在logits上使用辅助交叉熵损失来精炼草稿模型。

推测解码是一种加快大型语言模型推理速度的技术,其基本思路是利用一个小规模的草稿模型来预测多个未来的token,之后由主模型进行验证和修正。这种方法面临的最大挑战是由随机性引发的不确定性:当草稿模型执行token采样时,由于采样的随机性质,相同的输入可能会产生不同的输出,导致预测的不稳定性。基于Hyper-Bagel的工作,作者提出了一种新的条件预测方法。传统的方法仅依赖于先前的特征序列,而新方法同时考虑了先前的特征序列和提前一个时间步的token序列。这种双重条件的设计创建了一个确定的预测目标,因为在给定相同输入条件下,模型始终会产生相同的预测结果,从而消除了采样过程中的随机影响。键值缓存是transformer架构的关键组成部分,存储了注意力机制中的键和值矩阵,可以在推理过程中避免重复计算。通过在KV缓存上引入专门的损失函数,模型能够学习生成更利于重用的缓存表示,提升推理效率。辅助交叉熵损失应用于logits(即模型输出的原始得分),有助于草稿模型更有效地学习主模型的行为模式,使预测更加精准。多层次的优化策略不仅提高了推测解码的准确性,还确保了推理过程的高效性和稳定性。

Figure 3 Results from the Artificial Analysis Arena: Seedream 4.0 leads in both the Text-to-Image and Image Editing tracks.

【翻译】图3 来自Artificial Analysis Arena的结果:Seedream 4.0在文本到图像和图像编辑两个赛道中都处于领先地位。

【解析】

Artificial Analysis Arena是一个专业的AI模型评估平台,通过标准化的测试环境和评估指标来对比不同模型的表现。该平台的评估结果具有较高的权威性和可靠性,因为其采用了统一的测试标准和大规模的评估数据集。图3显示Seedream 4.0在两个重要的图像生成任务上均表现最优。文本到图像生成用于衡量模型将自然语言描述转化为视觉内容的能力,而图像编辑则测试模型在保持原始图像结构和风格的同时,根据指令进行精确修改的能力。在两个赛道中均取得领先地位,表明Seedream 4.0不仅在单一任务上表现优异,更在多模态理解和生成的综合能力上达到了行业领先水平。

3 模型性能

In this section, we present a thorough evaluation of Seedream 4.0. Initially, we report the overall ELO score from a public platform, Artificial Analysis Arena [1], as depicted in Figure 3. By sustaining a real-time competitive arena, Artificial Analysis Arena consistently integrates newly released models and offers dynamic leaderboards. The competitors include the Seedream series (Seedream 3.0 [3], Seedream 4.0, and SeedEdit 3.0 [20]), along with other top-tier models, such as GPT-Image-1 [16], Gemini-2.5 Flash Image [5] (referred to as Gemini-2.5), and open-source models like Qwen-Image [22] and FLUX-Kontext[8]. The findings show that Seedream 4.0 ranks first in both the single-image editing and text-to-image tracks.

【翻译】在本节中,我们对Seedream 4.0进行了详尽评估。首先,我们报告了来自公共平台Artificial Analysis Arena [1]的整体ELO评分结果,如图3所示。通过维持实时竞技场,Artificial Analysis Arena不断整合新发布的模型并提供动态排行榜。参赛者包括Seedream系列(Seedream 3.0 [3]、Seedream 4.0和SeedEdit 3.0 [20])以及其他顶级模型,如GPT-Image-1 [16]、Gemini-2.5 Flash Image [5](简称Gemini-2.5)和开源模型如Qwen-Image [22]和FLUX-Kontext[8]。结果显示,Seedream 4.0在单图像编辑和文本到图像两个赛道中均排名第一。

为了更深入地了解Seedream 4.0的精细能力,我们提供了人工评估和自动化基准测试结果。在多种任务和维度中,Seedream 4.0持续表现出卓越的性能。最终,我们强调了其优秀的多模态图像生成能力。通过灵活结合输入和输出模式,Seedream 4.0能够支持广泛的艺术应用。我们还展示了这些功能的具体示例,同时指出通过用户互动还有更多潜力有待发掘。

【翻译】为了进一步探索Seedream 4.0的细粒度能力,我们提供了人工评估和自动化基准测试结果。在各种任务和维度上,Seedream 4.0始终提供顶级性能。最后,我们突出了其出色的多模态图像生成能力。通过灵活组合输入和输出模态,Seedream 4.0可以支持广泛的创意应用。我们还展示了这些功能的说明性示例,同时注意到通过用户交互仍有更多可能性有待探索。

3.1 综合人工评估

为了对比Seedream 4.0与其他顶级图像生成模型的性能,我们建立了一个全面的多模态基准测试MagicBench 4.0。此基准测试包括三个主要任务类别:文本到图像(T2I)生成、单图像编辑和多图像编辑。这三项任务分别包含325个、300个和100个提示;每个提示均提供中文和英文版本。在以下章节中,我们将详细分析各模型在这项任务中的表现。

【翻译】为了对比Seedream 4.0与其他顶级图像生成模型的性能,我们构建了一个综合性的多模态基准测试MagicBench 4.0。该基准测试涵盖三个主要任务类别:文本到图像(T2I)生成、单图像编辑和多图像编辑。这三个赛道分别包含325个提示、300个提示和100个提示;每个提示都提供中文和英文两个版本。在接下来的章节中,我们将详细分析各种模型在这些任务中的表现。

3.1.1 文本到图像

作为图像生成模型的基本能力,文本到图像(T2I)生成始终是Seedream系列的关键关注点。除了传统的方面,如提示一致性、结构稳定性和视觉美感,我们还从两个额外的角度评估模型的表现:密集文本呈现和内容理解。后者尤其适用于需要高级情境推理或专业知识的提示。如图1所示,与前一代相比,Seedream 4.0在所有评估方面都显示出显著的改进。特别是,它在视觉美感方面明显优于竞争对手的模型。图4展示了通过对比Seedream 4.0与GPT-Image-1和Gemini-2.5的几个具有挑战性的T2I实例。这些示例展示了模型在确保强指令遵守、精确文本呈现和跨模型稳定视觉质量方面的表现,而Seedream 4.0因其卓越的视觉效果而脱颖而出,包括动态的动感、自然的光线和协调的色彩组合。

Figure 4 Text-to-Image comparisons. Within each group, images are arranged from left to right as Seedream 4.0, GPT-Image-1, and Gemini-2.5. Prompt1: Draw an infographic illustrating the factors causing inflation.; Prompt2: A studio-style portrait of an elderly gentleman: he …, with his left eye firmly shut in a humorous and clever way… Prompt3: 狸花猫第一视角自拍,老虎在后面追,超现实主义,写实,黄昏背景; Prompt4: A dashing male model whose left eye iris is blue wears a tattered suit with a pink rose in his left hand; there is only a single dewdrop distinctly visible on the edge of the rose petal, seemingly about to drop from the petal to the ground in the following second.

【翻译】图4 文本到图像比较。在每组中,图像从左到右排列为Seedream 4.0、GPT-Image-1和Gemini-2.5。提示1:绘制一个展示通胀因素的信息图表。提示2:一位老先生的工作室风格肖像:他…,左眼紧闭,表情幽默机智。提示3:狸花猫第一视角自拍,老虎在后面追,超现实主义,写实,黄昏背景;提示4:一位帅气的男模特,左眼虹膜是蓝色的,穿着破旧的西装,左手拿着一朵粉红色玫瑰;玫瑰花瓣边缘只有一滴露珠清晰可见,仿佛下一秒就要从花瓣掉落到地面。

3.1.2 Single-Image Editing

Figure 5 Single-Image Editing Comparisons. Within each group, images are arranged from left to right as the original image, Seedream 4.0, GPT-Image-1, and Gemini-2.5. Prompt1: Convert the two dogs in the picture to a LEGO style.; Prompt2: Translate the text of the product image into English. Prompt3: Adjust the photo's perspective to make it appear as though it was taken directly facing the stairs.; Prompt4: Add a giraffe at the red box location in the picture.

【翻译】图5 单图像编辑比较。在每组中,图像从左到右排列为原始图像、Seedream 4.0、GPT-Image-1和Gemini-2.5。提示1:将图中的两只狗改为乐高风格。提示2:将产品图像的文本翻译成英文。提示3:调整照片的视角,使其看起来像是直接面对楼梯拍摄的。提示4:在图中红框位置添加一只长颈鹿。

Seedream 4.0 在统一的流程中融合了编辑和生成功能,使其能够互相提升,并且提供了超越前一版本 SeedEdit 3.0 的性能。图像编辑的一个主要难题在于指令遵守和一致性之间的平衡,这同样是我们的评估重点。此外,我们还考量了结构完整性和文本编辑效能。如图 1 所示,结果显示了所有领先模型的独特模式。GPT-Image-1 在指令遵守方面达到了最高的精确度,但在一致性方面排名垫底,这是被普遍指出的一个局限。相反,Gemini-2.5 在保留方面表现出众,但在指令遵守能力上较为有限,尤其是在风格转换和视角变换等任务上,如图 5 所示;它在文本编辑方面也面临挑战,特别是处理中文时。相比之下,Seedream 4.0 在所有方面都展现了更为均衡的表现。它支持多种编辑任务,保持了良好的一致性,因此实现了更高的实用价值。

单一图像编辑的技术难点在于如何在执行用户命令的同时维持原始图像的核心特性。统一的流程设计使得编辑和生成功能可以共享基础的特征表示和学习机制,互相促进优化。指令遵守与一致性的平衡是该领域的基本挑战:过分强调指令遵守可能导致对原始图像的过度改动,而过于重视一致性则可能使模型难以精确执行复杂的编辑指令。不同模型在这一平衡上的倾向明显:GPT-Image-1 倾向于严格遵循指令但可能会破坏原始图像的一致性,Gemini-2.5 则更加注重保持原始特性但在复杂编辑任务上表现不佳。结构完整性评估模型是否能在编辑过程中保持图像的空间关系和几何结构,而文本编辑效能则测试模型对图像中文本内容的理解和处理能力。Seedream 4.0 通过均衡的设计在各个维度上均达到了较高的水平,具备较高的适用性和可靠性。

3.1.3 多图像编辑

图6 多图像编辑比较。左:整体评估结果。右:两个示例,虚线框表示输入参考,输出从左至右展示为Seedream 4.0、GPT-Image-1和Gemini-2.5。在最右侧的示例中,右上方的图像源自Seedream 4.0。提示1:参照图二中的色彩表,将房间和所有家具转变为多巴胺风格。提示2:将图一中的物品置于柜子的上层架子上。将图二中的物品置于中间架子上。将图三中的物品置于柜子的下层架子上。

多图像编辑不仅涉及多个图像的简单组合;它还需要模型对不同输入中的对象进行丰富的上下文理解。我们使用一个综合指标(GSB),包含三个客观维度:指令的一致性、连贯性和结构,来对比Seedream 4.0与GPT-Image-1和Gemini-2.5的表现。如图6所示,结果反映了单图像编辑的情况:GPT-Image-1在指令响应方面表现出色但一致性较差,而Gemini-2.5在保持性方面优秀但在响应性上有所欠缺。相比之下,Seedream 4.0在所有维度上的表现均为最佳,其GSB指标比其他两款模型高出几乎20%。

在多图像编辑中,一个关键考量是结构的完整性。我们观察到,随着参考图像数量的增加,其他模型的输出往往会遭受结构退化的问题。然而,即使提供超过十个参考图像,Seedream 4.0仍能保持更加稳定和连贯的结构,展现出强大的性能。

【翻译】多图像编辑不仅限于多个图像的简单合并;它需要模型对不同输入中的对象有丰富的背景理解。我们采用了一个包含三个客观维度的整体指标(GSB),来对比Seedream 4.0与GPT-Image-1和Gemini-2.5的表现:指令对齐、一致性和结构。如图6所示,结果与单图像编辑类似:GPT-Image-1在指令响应性方面表现突出,但在一致性上稍显不足,而Gemini-2.5在保持一致性方面表现优秀,但在响应性上有所欠缺。相比之下,Seedream 4.0在所有维度上均展现出最高水准,在GSB指标上比其他两个模型高出近20%。多图像编辑中的一个重要考量因素是结构完整性。我们注意到,随着参考图像数量的增加,其他模型的输出往往会结构退化。然而,Seedream 4.0在提供超过十张参考图像时,仍能保持更为稳定和连贯的结构,表现出强大的性能。

3.2 Automatic Evaluation with DreamEval

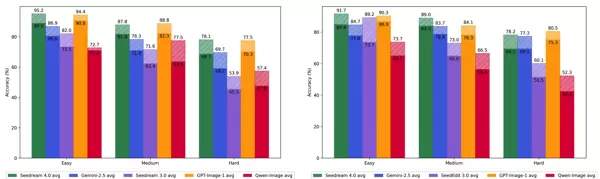

Figure 7 Automatic Evaluation with DreamEval. Left: Text-to-Image; Right: Single-Image Editing.

【翻译】图7 使用DreamEval进行自动评估。左:文本到图像;右:单图像编辑。

自动评估是模型评估的关键部分,因为它可以进行大规模测试,并且与纯粹的人工评估相比,提供更加稳定和迅速的反馈。我们引入了DreamEval,这是一个包含四个生成场景的全面多模态基准测试,包含128个子任务和1,600个提示。评分过程被细化为每个提示的详细视觉问答,使得评估更加透明和确定。特别是,DreamEval还包括分层难度级别,分别评估基本生成技能、高级生成能力和高阶理解和推理能力。

Figure 8 Examples of precise editing.

【翻译】图8 精确编辑示例。

The comprehensive outcomes for instruction compliance are displayed in Figure 1 and Figure 6, aligning closely with human assessments. The detailed performance across three difficulty tiers in the T2I and single-image editing tasks is illustrated in Figure 6. Several insights can be gleaned:

- Seedream 4.0 and GPT-4o surpass other models in instruction adherence, though Seedream 4.0 shows more variation: it has a marginally lower average score, yet its "best-of-4" outcomes are superior, indicating that users can achieve better results through sampling.

- Seedream 4.0 excels at the Easy and Medium levels, demonstrating robust generative responsiveness; however, its performance declines at the Hard level, particularly in single-image editing. This underscores the necessity for enhancing multi-modal comprehension and reasoning, an area that will benefit from scaling our models with pertinent data.

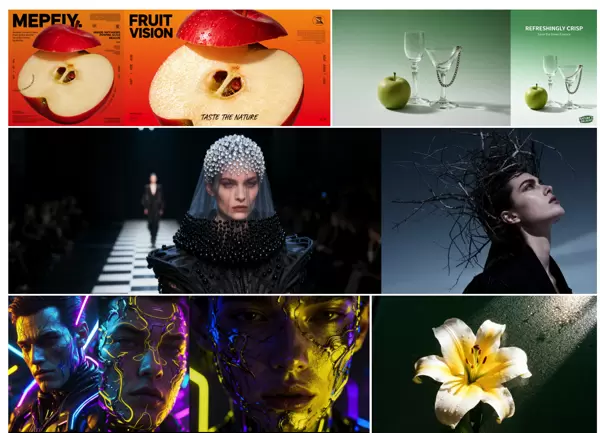

3.3 Leveraging Creativity with Seedream 4.0

We showcase a few representative use cases of Seedream 4.0 in this section. These examples highlight only a fraction of its potential, as additional innovative applications will arise through user engagement.

3.3.1 Precise Editing

图像编辑长久以来一直是生成模型的重要难题,主要障碍在于在保留大部分原始视觉特征的同时实现所需更改。Seedream 4.0仅通过基于提示的输入即可实现高质量的图像编辑。它展示了强大的指令遵循能力,在基本保持周围视觉内容完整性的前提下提供精准的修改。如图8所示,除了添加、删除、修改和替换等标准任务外,Seedream 4.0在多种实际编辑情境中表现出色。例如,在背景替换中,它能将前景与其他元素无缝融合;在人像修饰中,它提供具有摄影真实感的效果。

图9 参考生成示例。

与图像编辑不同,基于参考的生成面临更大的保留与创新之间的权衡难题。这种困难源于应保留内容的内在模糊定义。这可能是某人的身份或知识产权、特定的艺术风格,甚至是一个抽象的概念。因此,可能的应用范围更广且更多样化。如图9所示,Seedream 4.0支持在2D/3D领域内不同视角下的无缝转换。它可以从单一参考图像生成衍生设计,如玩偶、服装或表情包。此外,得益于Seedream 4.0的强大一致性,它可以在身份敏感场景中有效应用,包括生成不同风格的人像照片或为电影创建角色。

【翻译】与图像编辑不同,基于参考的生成在保持连贯性和创新性之间表现出更为棘手的平衡。这种挑战源自于应保持哪些元素的定义本质上是不明确的。这可能涉及一个人的身份或知识产权、特定的艺术风格,甚至抽象的概念。因此,潜在的应用领域更加宽广、多样化。如图9所示,Seedream 4.0支持在不同的2D/3D视角之间进行平滑转换。它能从单一参考图像生成派生设计,比如玩偶、服饰或表情符号。此外,得益于Seedream 4.0的高度一致性,它可有效地应用于身份敏感的情境,包括生成不同风格的肖像或为电影创造角色。

3.3.3 视觉信号可控生成

视觉信号,例如Canny边缘、素描、修复掩码或深度图,长期以来一直是可控生成的重要组成部分。它们使传递通常难以用语言表达的信息成为可能,如人体姿态或精确的空间布局,从而实现更精准和定向的生成。传统上,这种能力是利用多种专门模型(如ControlNet [9, 26])开发出来的。相反,Seedream 4.0原生地将这些功能整合到一个模型中。除了支持常见的视觉引导形式外,它还通过简单的线条或素描接纳创意输入,甚至可以实现由视觉信号驱动的新多图像组合。图10提供了示例。

Figure 10 Examples of visual signal controllable generation.

【翻译】图10 视觉信号可控生成示例。

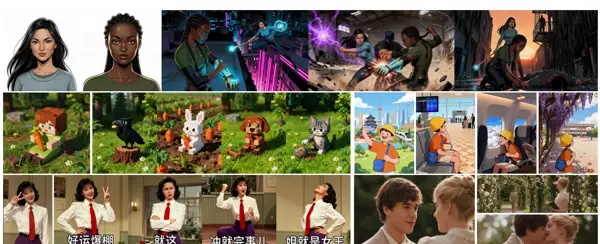

3.3.4 上下文推理生成

As the intelligence of multimodal models grows, a novel approach to in-context reasoning generation has arisen. Conventional image creation focuses mainly on generating outputs that closely adhere to the provided instructions. By contrast, reasoning-driven generation demands the model to take an additional step: it needs to discern implicit contextual hints and deduce plausible results before creating the image. This procedure might include broadening the initial prompt and analyzing reference images. As depicted in Figure 11, Seedream 4.0 showcases reasoning abilities across diverse in-context comprehension tasks, such as interpreting the physical and temporal limitations of the real world, as well as envisioning three-dimensional spaces. Moreover, Seedream 4.0 is capable of performing tasks like puzzle solving, crossword filling, and comic continuation, all while accurately maintaining the visual style and intricate details of the input provided.

【翻译】随着多模态模型智能水平的提升,一种新的上下文推理生成模式已经形成。传统图像生成主要侧重于产生紧密遵循所提供指令的输出。相比之下,推理驱动的生成要求模型再进一步:它需要在创建图像前识别隐含的上下文线索并推测合理的结论。此过程可能包括扩大初始提示和解析参考图像。如图11所示,Seedream 4.0在多种上下文理解任务中展示了推理能力,例如解释现实世界的物理和时间限制,以及构想三维空间。此外,Seedream 4.0还能完成诸如解谜、填字游戏和漫画续写等任务,同时精确地保持所提供的输入的视觉风格和细微特征。

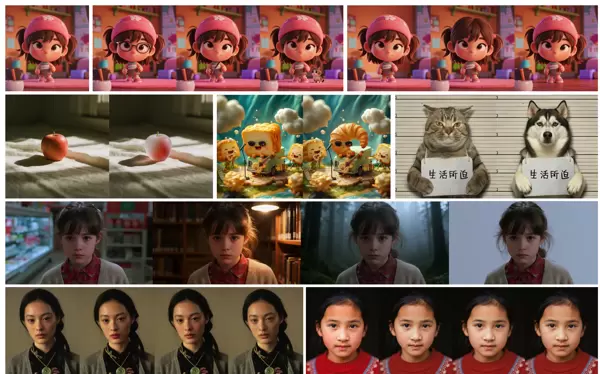

3.3.5 多图像参考生成

得益于多幅图像提供的更详尽信息,多图像参考能够实现更加富有创造力和多样性的应用。除了虚拟试衣或图像拼接等常规任务外,它还支持多个角色或物体的灵活编排,以及抽象风格的转换。不同于需要明确指出属性或风格的文本条件,多图像编辑促使模型自主从参考图像中提取关键特征,并将这些特征转移到目标上。如图12所示,Seedream 4.0能够处理超过十张输入图像的基于参考的编辑,同时在转移折纸或巴洛克美学等抽象风格时保持高度的忠实性。此外,它有效地管理了相对物体的比例,并生成了有意义的多物体编排,例如组装机械部件,展现了对物理世界结构的强大理解。

3.3.6 多图像输出

单幅图像生成不足以满足许多需要连贯多图像输出的创意场景。借助强大的全局规划和上下文一致性能力,Seedream 4.0支持生成既角色一致又风格统一的图像序列。如图13所示,这使得基于给定角色的连续图像生成成为可能,特别有利于故事板和漫画创作。Seedream 4.0还可以生成具有视觉一致性的一系列图像,这一功能对于基于IP的产品设计和表情符号的创建尤为宝贵。

【翻译】单一图像生成对于许多需要连贯多图像输出的创意场合来说是不足的。借助其在全球规划和上下文一致性上的强大能力,Seedream 4.0能生成既保持角色一致又风格统一的图像系列。如图13所示,这使得根据给定角色的连续图像生成成为可能,尤其有利于分镜头脚本和漫画创作。Seedream 4.0还能生成具有统一视觉身份的图像集合,这项功能对基于IP的产品设计和表情符号创作非常有价值。

Figure 11 Examples of reasoning generation.

【翻译】图11 推理生成示例。

3.3.7 高级文本渲染

Seedream 4.0 引入了加强的文本渲染功能,不仅限于简单的展示,而是服务于实际用途。通过智能理解与扩展及高精度密集文本渲染能力,它支持多种复杂的文本与图形生成任务,包括设计用户界面、海报或示意图的布局,以及生成知识密集型的可视化内容,例如数学公式、化学方程式或统计图表,如图14所示。这些功能使该模型能够直接生成教育资料、技术手册或营销内容。此外,Seedream 4.0 还支持精准的文本感知编辑,包括内容替换、布局调整和字体修改,从而将其渲染能力扩展到实际工作流中,为工作相关的场景提供支持。

3.3.8 自适应宽高比和4K生成

传统生成模型通常需要设定特定的分辨率,选择不合适的长宽比可能会导致构图和布局不佳。Seedream 4.0引入了一种自适应长宽比机制(同时仍然支持用户指定的尺寸),使模型能够根据语义需求或参考对象的形状自动调整画布。如图15所示,这使得生成的图像在美学上更加吸引人且上下文更为合适。此外,Seedream 4.0进一步将支持的分辨率提升至4K。这一进展不仅超越了研究原型,还提供了适用于商业应用的图像质量。

Figure 12 Examples of multi-image composition.

【翻译】图12 多图像组合示例。

Figure 13 Examples of multi-image output generation.

【翻译】图13 多图像输出生成示例。4 结论

In this report, we introduce Seedream 4.0, an advanced multimodal image creation framework that combines an efficient and scalable diffusion transformer with a high-compression VAE, achieving over tenfold speedup compared to the preceding Seedream 3.0 model, while offering superior performance across all areas. Through joint post-training on T2I and image modification tasks, Seedream 4.0 delivers robust multimodal generation capabilities, supporting a wide range of inputs and outputs. It exhibits vast potential for creative exploration, including precise image editing, reference-based creation, multi-image compositing, and multi-image output. Specifically, the model's architecture is notably efficient and stable, enabling effective scaling and significant performance enhancements in ongoing development. Moreover, leveraging advanced inference acceleration techniques, Seedream 4.0 facilitates ultra-fast image creation and editing at high resolutions. Additionally, it excels in supporting complex content generation for professional settings, such as knowledge-centric creation, a challenge for earlier models. Integrated into platforms like Doubao and Jimeng/Dreamina [2], Seedream 4.0 holds substantial promise as a potent productivity tool in content production, suitable for both professional and daily use.

【翻译】在本报告中,我们介绍了Seedream 4.0,这是一个先进的多模态图像生成框架,它结合了高效且可扩展的扩散变换器和高压缩VAE,与前代Seedream 3.0模型相比,实现了超过十倍的速度提升,同时在所有领域都表现出卓越的性能。通过在T2I和图像修改任务上的联合后训练,Seedream 4.0提供了强大的多模态生成能力,支持多种输入和输出。它展示了广泛的创意探索潜力,包括精确的图像编辑、基于参考的创建、多图像合成和多图像输出。特别地,该模型的架构非常高效且稳定,使得我们可以有效地扩展它,并在持续的研发中实现显著的性能提升。此外,借助先进的推理加速技术,Seedream 4.0可以在高分辨率下实现超快的图像生成和编辑。此外,它在支持专业环境中的复杂内容生成方面表现出色,例如知识中心化生成,这是早期模型难以完成的任务。随着其集成到豆包和即梦/Dreamina [2]等平台中,Seedream 4.0在内容制作中作为强大的生产力工具展现出了巨大的潜力,既适合专业用途也适合日常使用。

Figure 14 Examples of advanced text rendering.

【翻译】图14 高级文本渲染示例。

Figure 15 Examples of adaptive ratio and 4K generation.

【译文】图15 适应性宽高比和4K生成实例。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号