摘要

微软Copilot“咖啡与代码”的营销叙事,因严重脱离工程实践而引发开发者群嘲,暴露了AI工具在现实开发流程中的信任赤字与应用鸿沟。

引言

技术圈的叙事构建,往往在理想主义的愿景与冰冷的工程现实之间摇摆。最近,微软的一则营销文案,就精准地踩在了这条裂缝上。其官方社交账号发布的一条推文——“在你喝完咖啡之前,Copilot就把代码写完了”——非但没有收获预期的掌声,反而点燃了开发者社区的集体“炮轰”。这并非孤立事件。数天前,Windows负责人关于“智能体操作系统(Agentic OS)”的宏大构想,同样因其模糊性与潜在的不可控性,在引发强烈反弹后被迫关闭评论区。这两起连续的舆论风波,共同指向一个核心问题:当一家科技巨头的产品基础体验尚存争议时,其过于激进的AI营销,不仅无法说服最核心的用户群体——开发者,甚至会反噬自身的品牌信誉。

这篇文章不打算简单复述事件的始末,而是希望深入技术与文化的肌理,剖析这场营销“翻车”背后,开发者群体真实的焦虑、AI编码工具在当前阶段的技术局限,以及工程文化与市场宣传之间那道难以逾越的鸿沟。

一、一场营销风暴的复盘

1.1 “咖啡标语”点燃的导火索

事件的起点,是微软在X平台发布的一条宣传其AI编程助手Copilot的推文。这条推文试图描绘一幅极具吸引力的画面,开发者只需片刻闲暇,复杂的编码工作便可由AI自动完成。这种“氛围编程”(Vibe Coding)的愿景,旨在凸显Copilot的极致效率。然而,这幅图景在专业开发者眼中,显得既不真实,甚至有些冒犯。评论区迅速被负面反馈淹没。大量评论认为,这种说法严重简化了软件开发的复杂性,将一项严谨的工程活动描绘成了近乎全自动的流水线作业。

| 营销叙事 | 开发者反馈 |

|---|---|

| 喝杯咖啡,代码完成 | “这是在钓鱼吗?” |

| 突出AI的自动化能力 | “Copilot帮我写完代码,可不是什么炫耀点。” |

| 描绘轻松高效的编程体验 | “这完全脱离了真实的用户需求。” |

1.2 并非孤立事件的舆论背景

“咖啡标语”之所以能引发如此剧烈的反应,离不开一个关键的舆论背景,微软当前的产品口碑,尤其是Windows 11的基础体验,正处于一个微妙的低谷。用户普遍认为,微软应当优先投入资源修复操作系统中存在的各种问题,提升其稳定性和性能。在这种情绪下,任何关于AI新功能的宣传,都容易被解读为“不务正业”。当用户还在为基础功能的Bug苦恼时,公司却在大谈特谈AI如何“加速”开发,这种错位自然会引发抵触。此前,“Windows正朝agentic OS发展”的表述,已经让社区感到不安。一个更加“智能”但也可能更不可控的操作系统,叠加现有产品的体验争议,使得开发者对微软的AI战略抱有天然的警惕。因此,Copilot的这次营销,恰好撞上了用户情绪的“枪口”。

1.3 对社区情绪的致命误判

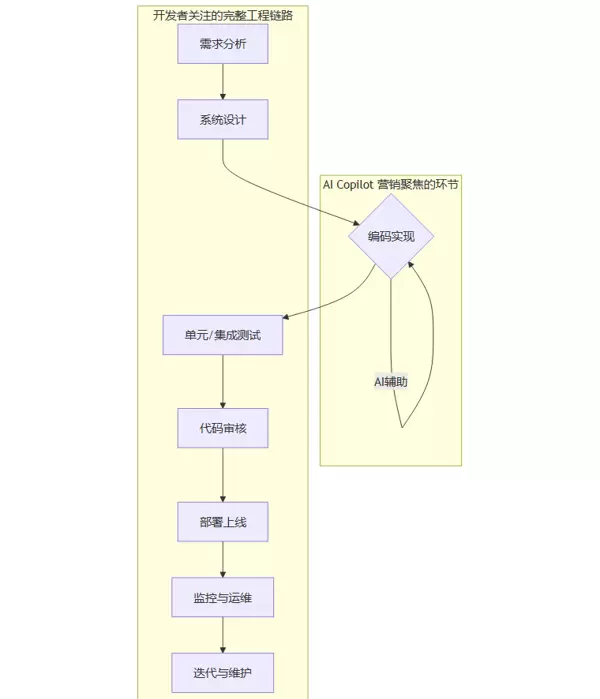

这次营销失败的核心,在于对开发者社区情绪的致命误判。开发者群体对“AI自动写完代码”这类口号天然免疫,甚至反感。原因在于,这套说辞完全忽视了软件工程的真正核心与痛点。软件开发远不止“写代码”这一个环节。它是一个包含需求分析、设计、编码、测试、审核(Code Review)、部署、运维和维护的完整闭环。

上图清晰地展示了AI工具当前主要作用的环节(编码实现),与整个软件生命周期的对比。微软的营销,恰恰将焦点过度集中在占比有限的“编码”环节,并试图将其简化为一键完成的任务。这在开发者看来,是对其专业性的轻视。他们深知,代码的诞生只是开始,后续的验证、调试与长期维护,才是成本与风险的真正所在。

二、工程现实的冷水:AI编码的技术局限

营销口号的浮夸,根植于对技术局限性的选择性忽视。当前,以Copilot为代表的AI代码生成工具,在严肃的工程实践中,面临着一系列难以回避的挑战。这些挑战构成了开发者“不信任”的坚实基础。

2.1 正确性与可靠性悖论

AI生成的代码,最首要的问题是无法保证100%的正确性。它可能在大多数情况下工作正常,但在某些边界条件或特定输入下,会产生难以预料的错误。

- 隐性逻辑缺陷:AI可能生成一段语法正确、看似能运行的代码,但其内部逻辑存在瑕疵。例如,在一个复杂的算法中,它可能忽略了一个关键的并发锁,导致在多线程环境下出现数据竞争。

- 对上下文的误解:大型语言模型(LLM)依赖于其接收到的上下文(Prompt)。如果上下文信息不完整或有歧义,AI很可能“脑补”出错误的需求,生成功能偏离预期的代码。

- API的错误使用:AI可能调用一个已被废弃(Deprecated)的API,或者以一种不符合最佳实践的方式使用某个库函数,埋下未来维护的隐患。

开发者需要投入大量的时间和精力来验证AI生成的“黑箱”产物,这种验证的成本有时甚至超过了自行编写的成本。

2.2 可解释性和可维护性的挑战

优秀的代码不仅需要能够正确运行,还需要易于理解和维护。然而,AI生成的代码在这方面的表现通常不尽如人意。

- 缺乏设计意图:AI并不了解为何要这样编写代码,它仅基于概率模型组合出最可能的代码序列。这导致代码缺乏清晰的设计理念和必要的注释,使得后续开发人员难以理解其背后的逻辑。

- “意大利面式”代码:为了实现特定功能,AI有时会生成结构混乱且高度耦合的代码,这增加了未来重构和扩展的难度。

- 技术债务增加:如果团队不加选择地采纳AI的建议,项目中的技术债务可能会迅速累积。这些潜在的问题和不合理的设计在项目后期集中显现,导致维护成本急剧上升。

最终,AI生成的代码的所有权和维护责任仍需由开发者承担。对于任何负责任的工程团队而言,无法解释其工作原理的代码片段犹如一颗定时炸弹。

2.3 一致性与架构遵循的难题

在任何具有一定规模的项目中,保持代码风格、设计模式和整体架构的一致性极为重要,而AI对此却知之甚少。

- 编码规范冲突:AI生成的代码可能不符合项目团队内部的编码规范,例如变量命名、缩进和注释格式等。这需要开发者手动修正,增加了额外的工作负担。

- 架构模式破坏:项目可能采用了微服务、领域驱动设计(DDD)或特定的分层架构。AI生成的代码片段可能会破坏这些架构约束,如在表现层直接调用数据访问逻辑,违背了分层原则。

- 技术栈混用:AI可能在一个纯原生JavaScript项目中推荐使用jQuery的方法,或者在一个约定使用特定状态管理库(如Redux)的React项目中,生成了处理复杂全局状态的原生代码。

useState

2.4 安全、隐私与合规性问题

企业级应用对安全、隐私和合规性的要求非常高,而这是AI编码工具的一个显著弱点。

2.4.1 无意识复制的安全漏洞

由于AI的训练数据来自大量的公开代码库,其中包含了许多存在安全漏洞的代码。AI在学习过程中无法辨别代码的质量,因此有很大几率会复制这些不安全的编码模式。

| 常见安全漏洞 | AI可能生成的风险代码示例 |

|---|---|

| SQL注入 | 直接将用户输入拼接到SQL查询字符串中。 |

| 跨站脚本(XSS) | 未对用户输出进行充分的HTML转义。 |

| 不安全的依赖 | 建议使用已知存在漏洞的第三方库版本。 |

| 硬编码密钥 | 将API密钥、密码等敏感信息直接写入代码中。 |

2.4.2 数据隐私的潜在风险

使用云AI编码工具时,开发者输入的代码片段、注释甚至整个文件内容都可能被发送到服务商的服务器进行处理,这引发了严重的隐私问题。

- 商业机密泄露:公司的核心算法、商业逻辑等敏感代码可能在传输和处理过程中被记录,存在泄露的风险。

- 合规性挑战:对于金融、医疗等行业,受到严格的数据保护法规(如GDPR、HIPAA)的监管,将代码数据传给第三方服务可能直接违反合规要求。

2.4.3 许可证合规的“雷区”

AI生成的代码片段可能来源于受严格开源许可证(如GPL)保护的项目。若不注意将这些代码片段用于商业闭源产品中,可能会引发严重的法律纠纷和知识产权风险。目前,AI工具尚无法提供清晰可靠的代码溯源和许可证声明,这使得企业在采用时顾虑重重。

三、“高使用、低信任”:开发者与AI的微妙张力

尽管存在许多技术限制,但不可否认的是,AI编码工具正被越来越多的开发者使用。这形成了一个独特的情景——高使用率与低信任度共存。开发者们处于与AI工具既合作又博弈的微妙关系中。

3.1 AI作为“放大器”的双重效果

行业内逐渐达成的共识是,AI编码工具扮演着“放大器”(Amplifier)的角色。

- 对高效团队:对于经验丰富、工程素养高的团队,AI可以成为强大的生产力工具。他们能够迅速评估AI建议的质量,利用其完成样板代码、编写单元测试、生成文档注释等重复性任务,从而将更多精力集中在核心架构设计和复杂逻辑实现上。AI放大了他们的能力。

- 对低效团队:对于经验不足、流程混乱的团队,AI可能成为一个“灾难放大器”。团队成员可能不加批判地接受所有AI建议,导致项目中充满低质量、不安全、难以维护的代码。AI放大了他们的缺点,加速了项目的衰退。

行业调查数据显示,只有大约30%的开发者表示“高度信任”AI生成的代码,而且这一比例还在下降。这表明,随着使用深度的增加,开发者对AI局限性的认识更加清晰。

3.2 “氛围编程”背后的隐性成本转移

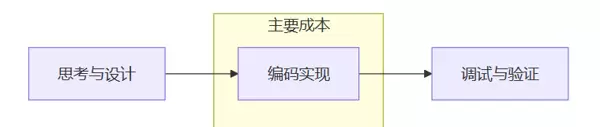

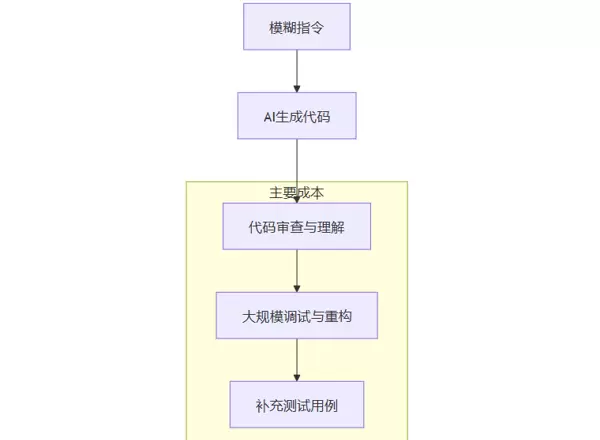

微软推广的“氛围编程”概念,在实践中往往演变为一种危险的工作方式,即草率地将复杂任务交给AI,随后花费更多的时间进行修复。这种模式并没有减少工作量,而是将成本从“编码阶段”转移到了“调试与验证阶段”。

让我们通过一个流程图来比较两种开发模式的成本结构。

传统开发模式:

“氛围编程”模式:

如上图所示,在“氛围编程”模式下,尽管前期的编码时间明显减少,但后期的理解、调试、重构和测试成本显著增加。更为不利的是,这些后期成本难以准确预估和控制,可能导致项目延期和质量问题。开发者们对此现象的批评,实际上是对项目管理中成本意识不足的讽刺。

3.3 从“自动驾驶”到“高级辅助”的角色认知

在开发者社区中普遍达成的共识是,当前AI编码工具的功能类似于汽车的L2级“高级驾驶辅助系统”(ADAS),而不是L5级“完全自动驾驶”。以下是两者的主要区别:

| 特性 | L2级驾驶辅助 (AI编码助手) | L5级自动驾驶 (营销愿景) |

|---|---|---|

| 责任主体 | 驾驶员 (开发者) | 系统 (AI) |

| 核心功能 | 提供建议、减轻重复性任务、预警风险 | 独立完成所有任务 |

| 使用方式 | 持续监督、随时准备接管 | 设定目标,无需干预 |

| 信任前提 | 批判性地采纳系统建议 | 完全信任系统决策 |

将一个“辅助”工具描述为能够“自动完成”的工具,这是微软在营销与开发者认知间存在的最大分歧。开发者们欢迎能够辅助他们工作的工具,但他们不愿意将项目的成败完全依赖于尚未成熟的技术。

四、微软的困境:当AI战略遭遇产品口碑

Copilot的营销争议不仅仅是文案上的失误,它更深刻地揭示了微软在推进AI战略与维护用户口碑方面面临的结构性挑战。

4.1 Windows 11口碑的“原罪”

自Windows 11发布以来,其用户体验一直饱受争议。无论是界面设计的不一致性,性能优化的问题,还是基础功能的改动,这些问题累积了大量用户的不满。在这种背景下,微软任何强调新技术(如AI、元宇宙等)的举措,都可能被解读为忽视了基本的用户需求。

用户的需求很简单:“先修复好现有的问题”,而微软则在积极推广“车载AI音响”。这种需求与供给的错配,使得每次关于AI战略的宣传都可能成为用户不满的导火索。

4.2 CEO言论引发的“信任联动”

微软CEO萨提亚·纳德拉曾公开表示,公司内部有20%至30%的代码是由AI生成的。这一声明旨在展示微软对AI技术的承诺和Copilot的强大功能。然而,在当前的产品口碑不佳的情况下,这一数据引发了负面的连锁反应。

在社区中,人们开始形成一种讽刺的观点:

- 前提一:Windows 11等微软产品存在质量问题。

- 前提二:微软内部广泛使用AI生成代码。

- 结论:产品的质量问题可能源于这些不可靠的AI代码。

尽管这种逻辑并不严密,但在情感上非常具有说服力,并迅速传播开来。原本用来证明AI能力的数据,反而变成了损害产品声誉、加剧用户不信任的“证据”。这使得微软在推广Copilot时陷入了两难境地,既需要宣传其优势,又需避免将其与现有产品的问题联系在一起。

4.3 营销与用户真实需求的错位

从根本上说,这场风波揭示了微软的营销策略与用户实际需求之间的严重脱节。

从微软的角度来看,AI是推动公司增长的关键技术,是展示技术领导力的重要手段。通过展示AI的革命性能力,微软希望巩固自己在未来科技领域的领先地位。

但从开发者的角度来看,工具的价值在于解决实际问题。他们需要的是稳定、可靠、能够无缝集成到现有工作流程中并真正提高效率的工具,而不是一个充满不确定性和额外负担的“智能体”。

当营销策略沉迷于描绘宏伟的未来蓝图时,用户却被眼前的现实问题所困扰。这种沟通上的偏差,是造成品牌与用户之间隔阂的根本原因。

五、破局之路:从“自动完工者”到“可信赖的副驾”

面对当前的困境,微软不仅需要调整营销文案,还需要从产品定位、技术实现到沟通策略进行全面的变革,以重新赢得开发者的信任。

5.1 产品定位的回归:成为“可验证的助理”

首先,微软应该放弃“自动完工者”的夸大宣传,明确将Copilot定位为“可验证、可追溯、可信赖的开发助理”。这意味着产品的重点应从“生成更多代码”转向“生成更高质量、更易于验证的代码”。具体改进方向包括:

- 提供可追溯的建议:为生成的代码片段标注其来源(如特定的开源项目或文档),并附上相关许可证信息。

- 内置质量与安全扫描:在生成代码的同时,进行静态分析、安全漏洞扫描和性能评估,并以可视化方式展示潜在风险。

- 集成测试生成:不仅生成功能代码,还要生成配套的、高覆盖率的单元测试和集成测试,帮助开发者快速验证代码的正确性。

- 提供多种实现选项:针对同一需求,提供多种不同风格或设计模式的实现方案,并解释各自的优缺点,使开发者能够做出知情选择,而不是被动接受。

5.2 沟通策略的调整:用工程指标替代夸张标语

在沟通方面,微软需要用开发者熟悉和认可的语言——即工程数据和可复现的实例——来证明Copilot的价值。具体措施包括:

- 补齐基础体验短板:解决现有产品中存在的问题,提高基础功能的稳定性和可靠性。

- 展示实际效果:通过具体的案例和数据,展示Copilot如何在实际开发过程中提高效率和质量。

- 透明化开发过程:公开分享Copilot的开发进展和技术细节,增强用户对产品的信心。

在大规模推广AI之前,应优先集中资源解决如Windows 11等核心产品的遗留问题。通过实际行动展现公司对产品质量基础的重视,这是恢复客户信任的关键。

明确应用场景,设定清晰界限

避免使用“完成所有编码”的不具体承诺。应专注于AI特别擅长且价值显著的具体领域,例如:

- 代码重构:展示如何利用Copilot安全地重构复杂函数。

- 样板代码生成:说明如何迅速生成符合项目标准的API控制器或数据模型。

- 测试用例生成:提供数据支持,证明Copilot生成的测试案例如何将测试覆盖率从X%提高到Y%。

- 技术迁移脚本:演示如何借助AI编写从旧技术框架迁移到新平台的脚本。

设立公开评估标准

与外部机构合作,创建一系列公开的标准来评估AI编码工具的质量,涵盖代码准确性、安全漏洞检测率及性能影响等方面,确保通过透明的数据来评价工具的有效性。

结论

微软Copilot所经历的“咖啡与代码”营销风波,虽然成本高昂,但也带来了宝贵的市场教训。它清楚地揭示了,当新技术的宣传故事与目标用户的工程文化及实际体验产生冲突时,即便是最美好的愿景也可能引发反感。

尽管AI编码工具有着巨大的潜力,但鉴于其目前的技术成熟度,它更适合扮演开发者的助手角色,而不是完全替代开发者。在AI生成的代码仍需人类工程师严格审查的现阶段,任何将其描述为“喝杯咖啡就能完成工作”的自动化解决方案,都是对软件工程专业的轻视和不尊重。

对于微软而言,未来的道路既明确又充满挑战。只有回到工程实践的现实中,切实提高AI代码的可靠性、安全性和易维护性,并以谦虚和实事求是的态度与开发者交流,才能使Copilot从一个有争议的‘网络红人’,转变为开发者工具箱中不可或缺且值得信赖的伙伴。

【省心锐评】

AI营销中的夸张言辞碰上了工程现实的冰冷障碍。微软应该销售的是‘高级辅助’的价值,而不是‘全自动驾驶’的幻想。与其空谈理想,不如先解决眼前的问题,修复那些亟待改进的地方。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号