作为一名已经理解GPT-2的在校学生,在面对ChatGLM、CPM、Llama、Bloom等众多开源大语言模型时,出现选择困惑是再正常不过的现象。当前大模型领域发展迅速,新技术与新框架不断涌现,但对于初学者而言,找到合适的学习路径并选对入门模型,远比盲目追逐热点更为关键。本文结合行业专家的实践经验以及主流开源生态的特点,为你整理出一套从模型选型到实际落地的系统性学习方案,帮助你高效入门、少走弯路。

一、开源模型入门选型:适合的才是最好的

选择合适的开源大语言模型,主要应基于三个核心因素:个人技术基础、学习目标以及可用资源(包括算力和时间投入)。结合当前主流技术生态和对新手的友好程度,以下四款模型尤为值得关注,它们覆盖了不同的技术路线,能够满足从理论理解到应用实践的多样化需求。

1. Llama系列(Meta开源):行业标杆,生态完备

Llama(包括Llama 2 和 Llama 3)无疑是当前开源大模型中的“标准参考”,被广泛视为入门首选。Meta发布后,围绕该模型构建了极为丰富的社区支持体系,涵盖了大量工具链、教学资源和衍生项目,几乎所有大模型工程化场景中都能找到基于Llama的实际案例。

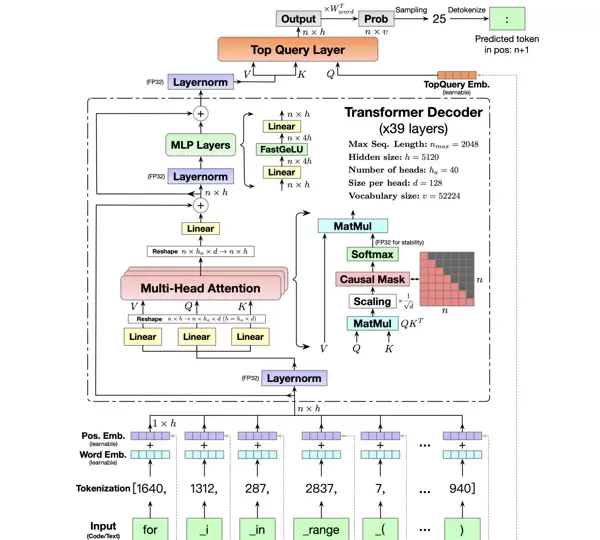

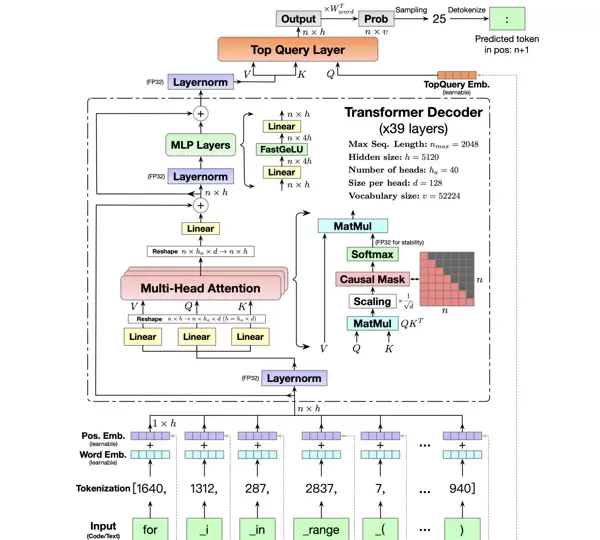

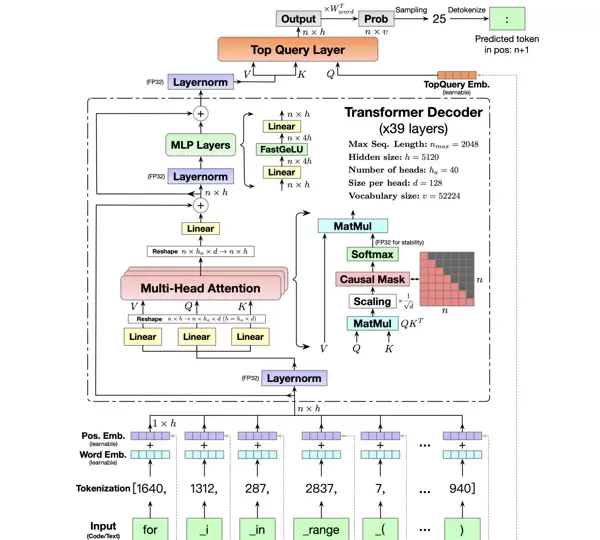

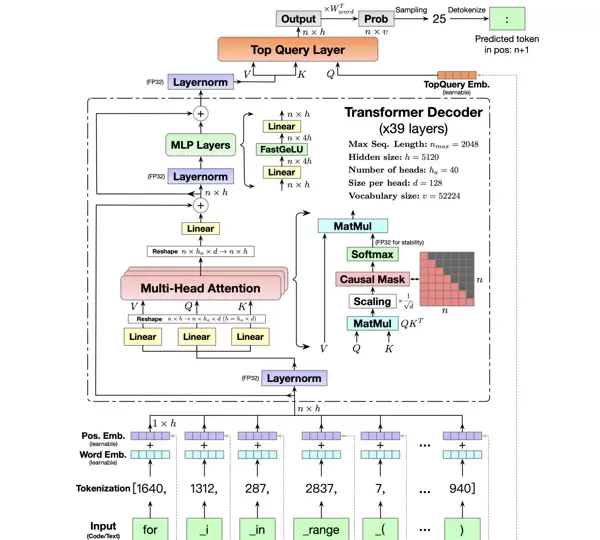

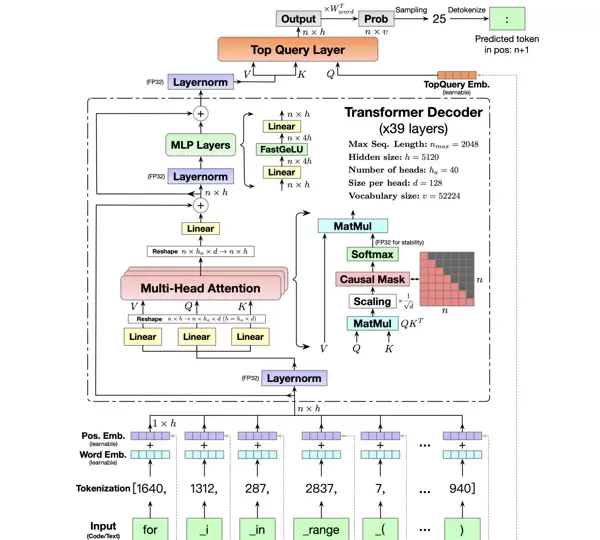

对于已掌握GPT-2的学生来说,Llama的技术门槛较低——它延续了GPT系列典型的decoder-only架构,采用自回归语言建模作为预训练任务,核心机制与GPT-2高度一致。但在细节上进行了多项优化,例如引入RoPE位置编码和SwiGLU激活函数,提升了性能表现。更重要的是,Llama 3提供了8B、70B等多种参数规模版本,其中8B版本可在消费级显卡(如3090或4090)上完成微调,甚至在CPU环境下也能运行推理任务。

学习Llama的优势显著:资料丰富,问题易查;配套工具成熟,支持微调(如LlamaFactory)和高效推理(如vLLM);就业导向明确,企业实际部署中Llama系列使用率极高,掌握其微调与部署流程将极大增强求职竞争力。唯一需要注意的是,若用于商业用途,需遵守Meta的开源协议,但个人学习完全不受限制。

2. Qwen千问(阿里达摩院开源):专注中文,即装即用

如果你的学习方向侧重中文应用场景,或希望快速开发中文相关功能(如对话系统、摘要生成、信息抽取),那么Qwen千问可能是比Llama更优的选择。作为国产开源代表,Qwen在中文语料处理方面做了深度优化,其中文理解和生成能力明显优于原生Llama,并且完全开放可商用,无协议限制。

Qwen同样采用decoder-only结构,技术路线与Llama相近,但在预训练阶段融合了海量中文互联网文本和专业文献数据,使其对中文语境具有更强适应性。它提供从0.5B到72B的完整参数谱系,其中Qwen-7B-Chat版本无需额外配置即可直接进行中文对话,非常适合初学者快速体验大模型的实际效果;而Qwen-1.8B则更加轻量,可在普通笔记本GPU上完成微调实验。

此外,Qwen拥有详尽的官方文档,配套工具链(如Qwen-Agent、Qwen-Deploy)专为中文开发者设计,同时提供丰富的微调教程及面向金融、医疗、电商等行业的适配方案,有助于你从“跑通模型”顺利过渡到“真实应用落地”。

3. ChatGLM系列(清华团队开源):中文强化,原理透明

ChatGLM是国内最早发布的开源大语言模型之一,凭借“以中文为核心、结构清晰”的设计理念,成为许多中文开发者的启蒙模型。它采用独特的Prefix LM预训练方式,融合了encoder与decoder的优点,在中文问答、多轮对话等任务中表现优异。同时,模型结构简洁,源码可读性强,非常利于深入理解内部工作机制。

ChatGLM 3 提供2B、6B、13B等多个版本,其中6B版本可在16GB显存的GPU上实现全参数微调,2B版本甚至可在CPU上完成推理测试。对于已经熟悉GPT-2的同学而言,阅读ChatGLM源码是掌握“中文大模型定制化优化策略”的绝佳机会——其在中文分词处理、语义连贯性维护、上下文记忆等方面的设计思路,能帮助你深入理解如何让大模型更好地服务于特定语言环境。

尽管其生态系统相比Llama和Qwen稍显局限,但基本的微调脚本、部署方案均已完善,且中文社区活跃,存在大量教程与二次开发项目,足以支撑初学者完成从理论学习到动手实践的全过程。

4. Bloom(Hugging Face开源):多语言支持,研究导向

如果你的研究兴趣集中在多语言建模,或学习目标偏向学术探索(例如预训练目标改进、跨语言迁移学习等),Bloom是一个极具价值的选择。该项目由Hugging Face主导,支持超过100种语言,采用encoder-decoder架构,训练数据涵盖全球多个语种,强调“开放性”与“包容性”的设计哲学。

Bloom特别适合希望了解大规模多语言统一建模机制的学习者。其开源性质确保了研究透明度,且所有代码和权重均可自由获取。虽然在单语言(尤其是中文)上的表现不如专门优化的模型,但其语言多样性为探索语言迁移、低资源语言建模等问题提供了理想平台。此外,由于其与Hugging Face生态无缝集成,调试、训练和评估流程都较为便捷,适合有志于科研方向的学生深入钻研。

Bloom 的突出优势体现在其架构的高度灵活性以及文档的全面性。Hugging Face 不仅提供了涵盖训练、微调到部署的完整技术教程,还实现了与 Transformers 库的深度整合,真正做到“即引即用”。对于刚入门大模型的学习者而言,Bloom 是一个极佳的学习平台,可用于掌握多语言模型的设计理念、跨语言数据处理方法,以及 encoder-decoder 结构在文本生成类任务中的实际应用,例如机器翻译和自动摘要等。

然而,Bloom 也存在一些显著短板:其最小版本参数量已达 7.1B,对计算资源的需求高于 Llama 8B 和 Qwen 7B;在中文支持方面弱于 Qwen 和 ChatGLM 系列。因此,若项目重心为中文场景,Bloom 的优先级建议适当后移。

模型选型决策指南:一表厘清选择逻辑

| 模型系列 | 核心优势 | 适用场景 | 学习难度 | 算力要求 |

|---|---|---|---|---|

| Llama系列 | 生态成熟、学习资料丰富、契合就业需求 | 通用任务、工程实践、求职导向 | 低-中 | 中(8B版本微调需16GB显存) |

| Qwen千问 | 中文优化出色、开箱即用、支持商用 | 中文开发、快速原型落地 | 低 | 低-中(1.8B版本可在8GB显存运行) |

| ChatGLM系列 | 专注中文优化、代码清晰、原理易懂 | 中文任务、模型机制学习 | 低 | 低-中(6B版本微调需12GB显存) |

| Bloom | 支持多语言、结构灵活 | 多语言研究、学术探索 | 中 | 中-高(7.1B版本需16GB显存) |

针对大多数初学者,我的推荐策略是优先考虑 Llama 3(8B) 或 Qwen 7B。如果你的核心应用场景集中于中文领域,建议直接选用 Qwen 系列;若更看重行业通用性与技术生态的完整性,则 Llama 3 更为合适。与其分散精力同时研究多个模型,不如先深入掌握一个主流模型,待理解透彻后再横向拓展,这种学习路径效率更高。

二、必备前置知识:构建扎实基础才能走得更远

在正式进入开源大模型学习之前,务必确保已掌握以下关键技能,否则后续实操过程将频繁受阻。这些基础知识看似基础,却是贯穿整个 LLM 学习链条的核心支撑。

1. 编程与框架能力

- 熟练掌握 Python:熟悉函数定义、类与对象、装饰器、生成器等高级语法,具备高效的数据处理能力,包括文件读写、字符串操作等。

- 掌握 PyTorch 框架:理解张量(Tensor)运算机制、自动求导系统(autograd),并能独立搭建神经网络模块,能够阅读模型源码中的层结构定义和训练流程。

- 熟悉 Hugging Face Transformers 库:作为当前 LLM 开发的“万能工具包”,需掌握如何加载预训练模型、处理输入文本、执行微调任务。建议提前完成官方 NLP 入门课程(Hugging Face NLP Course)以建立实操基础。

2. 深度学习与自然语言处理核心理论

- 深入理解 Transformer 架构:这是所有现代大模型的技术基石,必须掌握自注意力机制、多头注意力、位置编码(如 RoPE)、编码器-解码器结构的工作原理。推荐结合《Attention Is All You Need》原始论文与 Jalammar 的图解教程进行学习。

- 掌握预训练与微调机制:明确不同预训练目标(如自回归语言建模、掩码语言建模)的设计逻辑,理解微调在适配下游任务中的作用,并了解参数高效微调(PEFT)的基本思想(如 LoRA、Adapter)。

- 熟悉典型 NLP 任务:包括文本分类、命名实体识别、问答系统、文本生成等,同时了解各类任务常用的评估指标,如困惑度(Perplexity)、ROUGE、BLEU 等。

3. 工程工具与环境配置技能

- 熟悉 Linux 操作系统:多数大模型训练和部署均在 Linux 环境下完成,需掌握基本命令行操作、conda 虚拟环境管理、GPU 使用情况监控(nvidia-smi)等实用技能。

- 熟练使用 Git 与 GitHub:能够克隆开源项目、查看提交历史、解决依赖冲突,GitHub 是获取高质量学习资源和参与社区协作的主要渠道。

- 了解算力资源获取方式:初学者无需购置高价 GPU 设备,可借助 Kaggle 提供的免费 GPU 资源(无需翻墙)或阿里云 ModelScope 平台的免费额度(配备 24G 显存 A10 卡),足以支撑 7B 规模以下模型的微调实验。

如果上述基础尚不牢固,建议预留 1–2 个月时间系统补强。推荐学习资源包括:吴恩达的《机器学习》与《深度学习专项课程》、李沐的《动手学深度学习》、斯坦福大学 CS224n(自然语言处理课程),这些内容有助于快速构建完整的知识体系。

三、分阶段进阶路径:由浅入深,稳扎稳打

大模型学习没有捷径,但有清晰的成长路线。建议按照“原理理解 → 实战微调 → 应用落地 → 工程优化”四个阶段有序推进,每个阶段聚焦核心目标,避免贪多嚼不烂。

第一阶段:深入原理(2–3 周)——从 GPT-2 到现代 LLM 的演进脉络

你已经理解了 GPT-2,这是一个非常理想的起点。本阶段的核心目标是弄清楚“现代大模型相较于 GPT-2 做了哪些关键改进”,重点在于理解技术演进的内在逻辑,而非死记硬背模型结构。

核心任务一:精读 Llama 3 或 Qwen 的技术报告

重点关注其预训练目标的设计(如 Llama 3 改进的自回归目标)、架构层面的优化(如 SwiGLU 激活函数、RoPE 位置编码)、以及数据处理策略(语料构成、去重方法)。通过与 GPT-2 的对比,分析这些改动如何提升模型性能和训练稳定性。

核心任务二:手写简化版大模型

推荐跟随 Karpathy 的 “nn-zero-to-hero” 教学项目,从零开始搭建神经网络,逐步实现一个微型 GPT 模型。通过亲手编写注意力机制、层归一化、生成推理等模块,彻底摆脱“只会调包”的局限,真正掌握模型底层运作机制。

核心任务3:深入理解四大基础模型架构

在掌握GPT系列所采用的decoder-only架构之外,还需系统学习其他三种主流架构:encoder-only(如BERT)、encoder-decoder(如T5)、以及Prefix LM(如ChatGLM)。重点在于厘清它们在结构设计、预训练目标和典型应用场景上的差异。例如,BERT基于双向编码器,擅长语义理解类任务,如文本分类、实体抽取;T5采用编码-解码框架,适用于同时涉及理解和生成的任务,如机器翻译、摘要生成;而Prefix LM则通过在输入前缀上进行自回归生成,在保持一定生成能力的同时提升效率。理解这些差异有助于建立“任务与架构匹配”的系统性思维。

第二阶段:实战微调(3-4周)——实现从“使用模型”到“改造模型”的跨越

微调是大语言模型(LLM)实际落地的关键环节,也是企业在招聘中最为看重的核心实践能力。本阶段目标为掌握全参数微调与参数高效微调(PEFT)两种主流方式,并具备独立完成特定任务适配的能力。

工具推荐:优先选用LlamaFactory框架

LlamaFactory目前是国内最成熟的LLM微调平台之一,支持包括Llama、Qwen、ChatGLM在内的多种主流模型,能够一键式实现LoRA、QLoRA及全参数微调等功能,无需手动搭建复杂的训练流程,极大提升了开发效率。

核心任务1:从QLoRA入手,快速入门微调

对于初学者而言,建议以QLoRA(结合4比特量化与LoRA技术)作为起点。该方法显著降低显存需求(例如7B级别模型仅需约8GB显存即可完成微调),同时性能接近全参微调。可选择“中文情感分析”或“产品评论摘要”等简单下游任务,借助公开数据集(如THUCNews、CSL),完整走通数据清洗、格式转换、训练配置到模型微调的全流程。

核心任务2:掌握微调的本质逻辑——数据驱动

微调成败的关键不在超参调节,而在数据质量。需重点掌握三项技能:一是数据清洗,剔除噪声和冗余样本;二是数据格式化,统一组织为“指令-响应”对的形式;三是合理配置数据比例,平衡通用知识与领域专精内容。例如构建金融问答系统时,应将通用对话数据与金融专业知识库按3:7或2:8的比例混合,确保模型兼具泛化能力和专业深度。

核心任务3:开展模型评估并持续迭代优化

微调完成后,必须通过科学手段评估模型表现。可借助Ragas评估生成结果的相关性和准确性,利用Perplexity衡量语言流畅度。根据评估反馈,动态调整训练策略,如修改学习率、batch size或训练轮数。始终牢记:优秀的模型是靠高质量数据“喂”出来的,而不是单纯依靠调参得来的。

第三阶段:应用落地(4-6周)——从“调整模型”迈向“打造产品”

LLM的真正价值体现在实际应用中。本阶段目标是掌握主流应用场景的开发路径,涵盖RAG系统、对话机器人、AI Agent等,逐步培养解决真实问题的产品化思维。

场景1:构建RAG知识增强问答系统

RAG(检索增强生成)是当前最常见的LLM应用模式,有效缓解模型知识陈旧和事实错误的问题。推荐使用LangChain或LlamaIndex框架,实施步骤如下:收集领域文档(PDF、Markdown等)→ 进行文本分块处理 → 使用BGE或Sentence-BERT生成向量嵌入 → 存储至向量数据库(轻量级推荐Chroma,高性能可选Qdrant)→ 实现检索与生成协同工作。建议从个人知识库(如读书笔记、科研论文)起步,逐步扩展至行业级知识体系(如医疗指南、法律条文)。

[此处为图片2]场景2:开发专用对话机器人

基于已微调的模型,结合Prompt工程技巧(如思维链推理、Few-Shot示例),实现面向具体场景的对话功能。例如,“编程助手”应在Prompt中明确要求“帮助用户调试代码,提供详细解释与可运行示例”;而“校园服务机器人”则需整合课程安排、宿舍管理、奖学金政策等本地信息。关键在于实现对话状态管理,使机器人具备记忆上下文的能力,支持多轮自然交互。

场景3:探索AI Agent的基本构建

AI Agent代表LLM的高阶应用形态,具备自主规划、工具调用和长期记忆能力。建议从微软AutoGen或CrewAI框架入手,尝试搭建一个多Agent协作系统,例如“论文写作助手”,包含“文献检索Agent”“内容撰写Agent”和“格式审查Agent”,各司其职共同完成复杂任务。此过程有助于深入理解Agent的核心构成要素:任务规划机制、外部工具集成方式以及状态记忆管理。

第四阶段:工程化优化(可选,视需求深入)——从“能运行”到“可上线”

若职业方向为LLM工程师,则需进一步掌握工程层面的优化技术,重点关注推理速度、显存消耗与系统稳定性,满足企业级部署的实际要求。

核心技能1:模型量化与推理加速

学习使用GPTQ、AWQ等工具对模型进行低比特量化(如4bit、8bit),在几乎不损失性能的前提下大幅减少内存占用。同时熟悉主流推理加速框架:vLLM适用于高吞吐场景,Llama.cpp支持CPU端运行,Text Generation Inference适合工业级服务部署。还需了解PagedAttention、FlashAttention等底层优化技术的工作原理,提升系统整体效率。

核心技能2:模型部署与服务封装

掌握如何将训练好的模型封装为API接口,常用工具包括FastAPI和Flask,支持高并发访问。学习Docker容器化技术,将模型及其依赖打包成镜像,便于跨环境迁移与维护。此外,初步接触云平台部署方案(如阿里云、腾讯云),利用云端GPU资源提供稳定、可扩展的服务支撑。

核心技能3:安全与风控能力构建

掌握大语言模型的安全防护与风险控制是不可或缺的一环。可借助Guardrails AI等工具实现对输出内容的有害信息过滤,并规范生成格式;同时需了解基本的隐私保护机制,例如数据加密、联邦学习(初学者建议从数据脱敏入手);此外,应熟练使用模型监控平台如Arize Phoenix,实时追踪推理性能、响应延迟及错误发生率,确保系统稳定运行并能及时定位异常。

四、高效学习资源汇总:工具、课程与书籍全覆盖

深入学习LLM离不开高质量资源的支持。以下精选经过实践验证的学习资料清单,涵盖课程教程、实战项目、技术书籍以及算力和社区平台,助你系统化提升能力。

1. 核心课程与学习路径

- 入门基础:吴恩达《面向开发者的LLM提示工程》(中文版)、李沐《动手学深度学习》中的LLM相关章节、斯坦福大学CS324课程《Large Language Models》。

- 进阶实战:Karpathy在GitHub发布的“nn-zero-to-hero”项目(含完整视频讲解)、Hugging Face官方NLP课程、微软推出的“Generative AI for Beginners”全栈系列(共21讲)。

- 中文友好资源:DataWhale团队编写的《大语言模型实战》、知乎盐选专栏《大语言模型入门到实战》、李宏毅教授《机器学习》课程中关于LLM的专题内容。

2. 推荐实战项目分类整理

- 原理理解类:rasbt/LLMs-from-scratch(手写LLM实现)、karpathy/nanogpt(微型GPT构建)、minbpe(分词器底层逻辑演练)。

- 微调支持工具:LlamaFactory(提供图形化界面一键微调)、PEFT库(Hugging Face官方推出的参数高效微调方案)。

- 应用开发框架:LangChain(通用AI应用开发框架)、LlamaIndex(结构化数据接入工具)、AutoGen(多智能体协作系统)、Qwen-Agent(专为中文场景优化的Agent工具链)。

- 工程部署组件:vLLM(高性能推理加速引擎)、Chroma(轻量级向量数据库)、Ragas(评估指标集成工具)、Phoenix(可观测性分析平台)。

3. 必备参考书单

- 入门级别:《大规模语言模型:从理论到实践》《大语言模型应用开发实战》——适合快速建立整体认知。

- 进阶阅读:《深度学习进阶:自然语言处理》《动手学强化学习》(重点覆盖RLHF相关内容)、《爱丽丝梦游可微仙境》(夯实数学推导基础)。

- 理论深研:原始论文《Attention Is All You Need》合集、《LLM Papers Survey》(前沿论文综述汇编)。

4. 算力支持与活跃社区推荐

- 免费计算资源:Kaggle平台(每月赠送GPU时长)、ModelScope魔搭(阿里云提供24G显存A10 GPU免费额度)、Google Colab(需网络访问支持)。

- 交流与求助渠道:GitHub开源项目的Issues区、知乎LLM话题圈、Hugging Face社区问答板块、Discord上的Llama与Qwen官方社群。

五、新手避坑指南:五大常见误区警示

在LLM学习热潮中,不少初学者因方向偏差而耗费大量时间。结合一线经验,总结出以下五个高频陷阱,务必警惕:

- 盲目追求大模型参数规模

许多人误以为“参数越大越好”,一上来就想运行70B甚至175B级别的模型。然而对于初学者而言,7B或8B模型已足够——其架构设计与大模型一致,且对硬件要求较低,便于快速实验迭代。建议先彻底掌握小模型的训练、微调与部署流程,再逐步扩展至更大规模。 - 过度关注超参调整,忽视数据质量

部分学习者沉迷于调节学习率、batch size等超参数,却忽略了数据本身的重要性。事实上,在LLM微调过程中,数据质量的影响占比超过70%。低质数据即便反复调参也难以产出理想结果;相反,高质量数据配合默认参数往往就能取得良好效果。推荐将80%精力投入数据清洗与构造,仅留20%用于参数优化与效果评估。 - 只看理论不重实践

LLM属于高度实践导向的技术领域,仅阅读论文或源码远远不够。必须亲自完成模型运行、微调训练、应用搭建等环节,才能真正理解关键技术点。例如“文档分块”看似简单,实操中却涉及块大小设定、重叠策略选择等细节问题,唯有通过动手才能掌握。 - 忽略工程化技能积累

许多初学者专注于算法层面,却轻视Linux操作、Docker容器化部署、API接口开发等工程能力。但在实际企业落地中,工程稳定性往往比模型精度更重要——一个可稳定服务、支持高并发的7B模型,远胜于一个无法上线的70B模型。建议从早期就开始练习将实验成果封装为可调用服务,培养全流程交付意识。 - 试图追逐所有新兴技术

LLM领域更新极快,每天都有新模型、新技术涌现,如LoRA-Pro、MoE架构、新型评估标准等。初学者容易陷入“技术焦虑”,希望样样精通。但需认识到,核心原理(如Transformer结构、预训练+微调范式)长期稳定。应优先夯实基础能力,再有选择地跟进趋势演进,做到“以不变应万变”。

六、总结:稳扎稳打,在实践中持续进化

学习大语言模型如同攀登高峰,虽无捷径可走,但只要路线正确、步伐坚定,终将登顶。作为一名已经掌握GPT-2基础的学习者,你已具备良好起点。接下来的关键在于:聚焦核心技能,善用优质资源,坚持动手实践,逐步构建完整的知识体系与工程能力。

重视实践与数据:通过动手运行实际项目、系统整理数据资料,在解决具体问题的过程中不断积累实战经验;

遵循科学学习路径:从深入理解模型原理开始,逐步过渡到实战中的微调操作,最终实现应用落地,坚持循序渐进,避免急于求成;

保持持续学习:紧跟开源社区的最新动态,定期回顾和复盘所学内容,持续优化与迭代个人知识体系;

选择合适的入门模型:建议优先考虑Llama 3(8B)或Qwen 7B,集中精力深入掌握其中一个模型,打牢基础。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号