摘要

随着深度伪造技术门槛的急剧降低,其滥用现象已日益普遍。本文深入剖析该技术的底层机制与高级伪造特征,提出系统化的识别方法,并解读当前治理现状及未来发展方向。

引言

“如果你是温峥嵘,那我是谁?”这句充满荒诞感的质问,出自演员温峥嵘本人之口。她在自己的直播间发现有人使用AI换脸技术冒充她进行直播,前去交涉反遭拉黑。这一事件并非孤例,而是生成式AI被滥用的冰山一角。从全红婵的声音被克隆用于带货直播,到央视主持人形象出现在虚假广告中,再到社交平台上泛滥的“AI整蛊”视频,我们正逐步进入一个“眼见不一定为实”的数字纪元。

技术的普及本应推动创新与便利,但当仅需几条文本指令即可生成高度逼真的虚假内容时,其负面效应也随之凸显——社会的信任成本正在迅速攀升。借助AI外衣传播的虚假信息、网络诈骗和名誉侵权行为,变得更加隐蔽且难以识别。

本文将从技术原理、攻防策略以及治理框架等多个维度出发,全面解析深度伪造问题的本质。我们将揭示其核心技术逻辑,提供适用于普通用户与专业人员的辨别指南,并探讨在技术发展、法律规范与伦理约束交织的背景下,如何构建一个更具可信度的数字生态。这不仅是一次对技术的审视,更关乎我们在数字时代的基本生存法则。

一、滥用常态化:失控的数字拟像

生成式AI的内容滥用已由零星个案演变为广泛存在的社会现象,渗透至公共、私人乃至整个社会信任体系之中,主要体现在以下三个层面:

1.1 公共领域的商业侵权与舆论操控

1.1.1 肖像与声音的非法商用

公众人物因其知名度高,成为AI滥用的主要目标,背后的驱动力往往是流量变现。

- AI换脸直播:通过实时替换主播面部为明星或网红形象,利用粉丝效应进行商品推广或获取打赏,直接侵犯了他人的肖像权。

- 仿声带货:仅凭少量音频样本即可构建特定人物的声音模型(Voice Cloning),用于制作营销语音或短视频配音。例如,运动员全红婵、孙颖莎的声音曾被用于推销土鸡蛋,引发广泛关注。

- 虚假代言广告:冒用权威人士如央视主持人的形象与语调为其产品站台,误导消费者,构成典型的虚假宣传行为。

1.1.2 虚假热点的制造与传播

AI也被用于虚构或篡改新闻事件,以操纵舆论、博取关注或制造恐慌。比如,在灾难发生期间,利用AI生成“被困废墟中的儿童”等图像,煽动公众情绪,干扰正常救援秩序。此类行为严重污染了信息环境,削弱了媒体机构的公信力。

1.2 私人空间的社交操控与权利侵害

1.2.1 “AI整蛊”娱乐边界的模糊化

短视频平台上的“AI整蛊”内容正大量涌现,如“流浪汉进家骗老公”“AI模仿领导查岗”等桥段。尽管标榜为娱乐,实则潜藏多重风险:

- 诱发盲目模仿:平台算法助推此类内容病毒式扩散,导致大量用户跟风复制,形成不良社会风气。

- 伦理与情感伤害:在当事人不知情的情况下实施欺骗,可能造成真实的心理创伤与人际关系破裂。

- 隐私权侵犯:未经许可使用亲友的肖像制作并发布视频,涉嫌侵犯肖像权与个人隐私。

1.2.2 深度伪造驱动的网络诈骗

这是目前危害最严重的AI滥用形式之一。不法分子利用AI合成语音或视频实施精准诈骗:

- 冒充熟人诈骗:通过获取社交数据,合成亲友的语音或影像发起紧急求助通话,诱骗转账。

- 定制化勒索:利用深度伪造技术生成针对特定个体的不雅视频或虚假证据,进而实施敲诈。

1.3 社会信任体系的瓦解

当图像、音频、视频这些传统意义上的“客观证据”都变得不可靠时,社会整体的信任基础便开始动摇。每一次AI伪造事件的发生,都是对公众信任的一次侵蚀。人们不得不投入更多时间与精力去验证信息真伪,导致沟通效率下降、决策成本上升。这种深层次的信任流失,是AI滥用带来的最持久且最难修复的影响。

二、技术拆解:“以假乱真”的实现路径

深度伪造内容之所以能大规模泛滥,并非依赖单一技术突破,而是模型架构、计算能力与工具链协同发展的结果。理解其内在机制,是有效识别与防范的前提。

2.1 核心引擎:从GAN到扩散模型的演进

早期流行的“换脸”技术多基于生成对抗网络(Generative Adversarial Networks, GANs)。

GANs的工作原理:系统包含两个核心组件——生成器(Generator)与判别器(Discriminator)。生成器负责创造虚假内容,力求逼真;判别器则负责判断内容是否真实。两者在反复博弈中不断优化,最终使生成内容达到以假乱真的程度。诸如DeepFake之类的工具正是建立在此基础上。

然而,GANs在训练稳定性与生成多样性方面存在局限。近年来,扩散模型(Diffusion Models)逐渐取代GANs成为主流,其生成质量与鲁棒性显著提升。

扩散模型的工作机制可通俗理解为“先加噪,再去噪”:

- 前向过程(加噪):从一张清晰的真实图像出发,逐步添加高斯噪声,直至图像完全退化为随机噪声。

二、反向降噪与多模态生成:构建虚假内容的核心机制

反向过程(降噪):训练一个神经网络,使其学会从完全的噪声中逐步“逆向”还原出清晰图像。这一过程并非随机,而是可控的——通过输入文本提示(Prompt),模型能够在每一步降噪过程中将图像朝符合描述的方向引导。目前主流的文生图模型(如 Stable Diffusion、Midjourney)以及文生视频模型(如 Sora)均基于此类架构实现高质量内容生成。

多模态融合:打造连贯的人工世界

现代AI伪造已不再局限于单一感官维度,而是迈向了多模态(Multi-modal)协同生成的新阶段。这类技术能够同时理解并生成文本、图像、音频等多种数据形式,并确保它们之间在语义和时序上的高度一致。

音画同步:当模拟某人的声音时,系统不仅能合成语音,还能驱动数字人模型的口型动作与面部表情,精确匹配原声的情绪起伏、语速节奏和断句位置,实现视听层面的高度统一。

场景与动作生成:只需一段文字描述,AI不仅可生成主体人物,还能自动补全合理的背景环境、光照条件,并设计出自然流畅的肢体动作。由此产生的不再是孤立的“换脸”片段,而是一个逻辑自洽、整体协调的虚拟小剧场,极大提升了伪造内容的真实感和识别难度。

工具链成熟化:自动化推动滥用扩散

尽管底层技术复杂,但其广泛应用得益于高度集成且流程化的工具生态。以下是关键环节及其功能概述:

| 工具链环节 | 技术实现 | 用户体验 |

|---|---|---|

| 前端交互 | WebUI、Discord机器人、手机App | 提供图形化界面,用户仅需输入文本或上传图片,点选参数即可完成操作 |

| 模型调用 | 开源模型(如Stable Diffusion)、API接口 | 封装底层部署细节,用户无需了解模型运行原理 |

| 素材处理 | 自动化人脸识别、音频特征提取 | 上传视频后,系统自动分离人脸区域并提取声纹特征,为后续合成做准备 |

| 后期优化 | AI图像增强、视频补帧、分辨率提升 | 支持一键高清化、流畅化处理,显著提升输出质量 |

这种“傻瓜式”操作设计,结合短视频平台大量传播的“速成教程”和“成功案例”,形成了强烈的示范效应,导致AI伪造技术被迅速普及并广泛滥用。

三、攻防对抗升级:伪造与检测的持续博弈

随着AI检测能力的发展,伪造技术也在不断进化,呈现出典型的“道高一尺,魔高一丈”态势。新型伪造手段更具隐蔽性与对抗性,挑战日益严峻。

3.1 对抗性攻击:欺骗检测模型

AI内容检测器本质上也是一种深度学习模型,依赖于真实与生成内容之间的统计差异进行判断。这为对抗性攻击(Adversarial Attacks)提供了突破口。

攻击原理:攻击者在生成的内容中嵌入一种人眼无法察觉的微小扰动(即“噪声”)。这些扰动经过精心计算,能误导检测模型做出错误分类——例如,让一张99%确定为AI生成的图像被误判为“真实”。

实现方式:通常分为两类:一是白盒攻击,要求掌握目标检测模型的结构信息;二是黑盒攻击,通过反复查询输出结果来推测其决策边界,进而构造有效扰动。

3.2 数字水印的规避与清除

为实现内容溯源,行业正推动数字水印(Digital Watermarking)技术的应用。然而,伪造者已有多种手段应对。

隐性水印的脆弱性:这类水印通常嵌入图像像素或频域信息中,但简单的后期处理操作——如压缩、裁剪、旋转、加滤镜——都可能破坏水印数据,使其失效。

主动去除:更高级的方法是训练专用AI模型,专门用于识别并消除特定类型的水印,同时尽量保持原始内容的视觉质量不受影响。

3.3 “一键去AI痕迹”功能泛滥

部分工具开发者为了满足灰色市场需求,在产品中直接集成了规避检测的功能。例如提供“去除AI标识”或“增强真实感”选项。这些功能背后往往涉及一系列复杂算法:平滑AI常见的纹理异常、添加模拟真实相机的噪点与镜头畸变等,从而有效绕过现有检测机制。

这场持续升级的攻防战表明:单纯依赖技术手段进行检测始终存在滞后性。要建立可靠的防御体系,必须结合技术、规范制定与公众认知教育三方面协同推进。

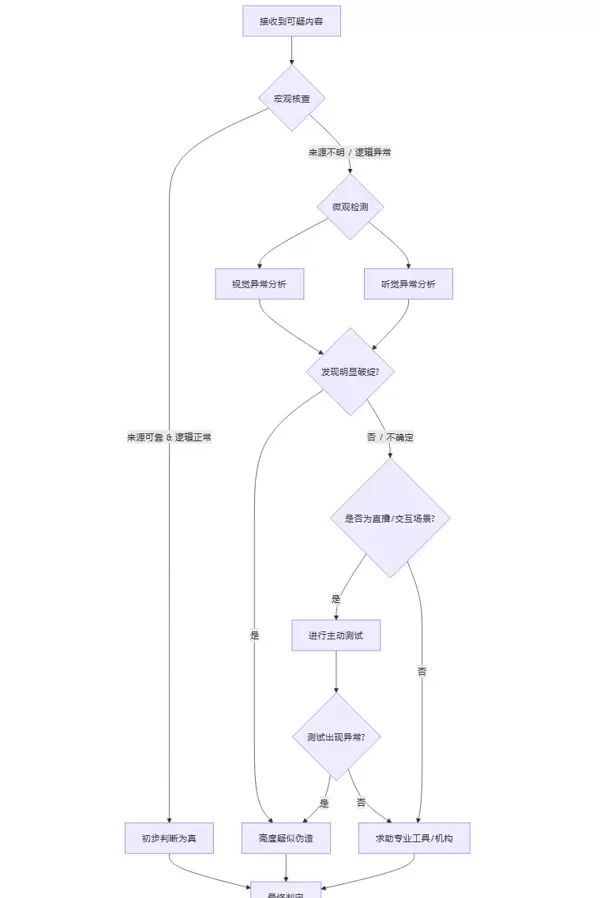

四、专业级辨真策略:系统化识别AI伪造内容

尽管AI生成能力不断增强,但由于算法、算力与训练数据的局限,当前生成内容仍会留下可追溯的痕迹。以下是从宏观到微观的系统化辨别方法。

4.1 宏观层面:逻辑与情境审查

在深入分析技术细节前,应优先进行常识性判断。

信息来源交叉验证:这是最基础也是最关键的步骤。面对来源不明或内容夸张的音视频,切勿轻信或转发。应立即通过多个独立、权威的信息渠道(如主流新闻媒体、官方公告)进行核实。

情境合理性分析:评估视频中人物的言行是否与其身份、性格及所处环境相符?事件发展是否符合社会常识与物理规律?例如,一位一贯严谨的科学家突然发表极端言论,就极可能是伪造内容。

延迟判断原则:对于重大公共事件,初期信息往往混乱矛盾。建议养成延迟下结论的习惯,等待更多证据浮现后再做判断,避免成为虚假信息传播链的一环。

4.2 微观层面:视听异常识别

在确认情境合理的基础上,进一步检查是否存在细微的技术破绽。

在识别AI生成内容时,需从技术细节入手,充分调动视觉与听觉感知能力,细致观察并分析异常表现。

4.2.1 视觉异常(静态与动态)

环境与物理规律:注意背景、光照、阴影及反射是否符合现实逻辑。常见问题包括:背景物体出现不合常理的扭曲或模糊;光源方向与投射阴影不一致;镜面或眼球中的反射影像失真或缺失。

面部特征分析:AI合成的人脸常表现出过度对称性,缺乏真人面部自然的微小偏差;皮肤纹理过于平滑,缺少毛孔、斑点等真实细节;牙齿排列、耳朵形状或眼镜佩戴可能出现结构错乱或畸变。

表情与动作表现:观察眨眼频率是否正常——过快、过慢或长时间不眨均为可疑信号;口型与语音内容是否同步;肢体动作是否存在重复、僵硬或机械化的趋势,缺乏人类自然的行为节奏。

帧间一致性检查:播放视频时留意人物配饰(如耳环、项链)是否在不同画面中闪烁、变形或突然消失;运动过程中身体边缘与背景交界处是否有抖动、虚化或融合异常现象。

4.2.2 听觉异常识别

语音韵律与情感表达:AI合成语音通常语调单一,缺乏真实语流中的起伏变化和情绪波动,整体听起来较为平淡、机械化,缺少自然停顿与重音强调。

背景音环境匹配度:伪造音频往往背景“过于干净”,缺乏应有的环境杂音(如空调声、脚步声),或者背景噪音与对话场景明显不符(例如室内讲话却伴有风声或鸟鸣)。

呼吸与停顿逻辑:长句处理中可能出现违反语言习惯的断句位置,换气点不合理,甚至无意义的延迟或卡顿,暴露出非人类的语言生成机制。

4.3 交互层:主动测试策略(适用于直播或实时通信)

在可互动的场景下,可通过设计特定行为来验证对方真实性。

遮挡测试:这是目前最为直接且有效的物理验证方式。要求对方用手在脸部前方挥动、拿起杯子喝水,或用纸张部分遮挡面部。由于AI换脸依赖持续追踪五官关键点,一旦发生遮挡,系统可能无法正确渲染,导致以下现象:

- 被遮区域周围出现短暂图像错乱、扭曲或闪烁;

- 手指、杯沿等物体边缘与面部皮肤发生不自然融合或边界模糊。

指令响应测试:发出复杂且非预设的动作指令,如快速转头、做鬼脸、用手指触碰鼻子等。多数AI驱动的虚拟形象动作库有限,难以流畅执行突发性、个性化指令。

记忆与逻辑连贯性测试:在对话中提及几分钟前讨论过的具体信息,观察对方能否准确回忆并进行合理回应。许多AI模型不具备长期上下文记忆能力,容易出现前后矛盾或回避问题。

4.4 工具层:专业检测手段辅助判断

当主观判断难以定论时,可借助专业技术工具进行深入分析。

数字指纹分析:各类AI模型在生成内容时会留下独特的底层痕迹(即Artifacts),如特定像素分布模式或频域特征。专业检测工具通过识别这些肉眼不可见的“数字指纹”,判断内容是否由AI生成。

元数据审查:检查图像或视频文件的元数据(Metadata),查看其中是否包含由生成平台自动写入的来源标识信息,用于追溯内容生产路径。

五、治理框架:为失控的技术设定边界

面对日益严重的AI滥用问题,仅靠个体防范远远不足,必须构建涵盖法律法规、标准体系、平台责任与公众认知的多维治理体系。

5.1 法规引领:《标识管理办法》落地实施

我国在AI内容监管领域处于全球前列。自2023年8月15日起施行的《生成式人工智能服务管理暂行办法》,以及更具针对性的《互联网信息服务深度合成管理规定》,为AI内容的身份认定提供了明确法律依据。

显性标识制度:要求服务提供者在AI生成内容的显著位置,以文字、图标等形式明确标注“AI生成”,保障用户知情权,防止误导传播。

隐性标识技术:通过嵌入数字水印或元数据等方式,在内容中加入不可见、难篡改的溯源信息,提升监管可追溯性,确保事后能精准定位责任主体。

5.2 标准统一:规范标识执行流程

法律确立原则,国家标准细化操作。相关强制性标准将明确规定:

- 技术规范:水印嵌入算法、抗攻击能力(鲁棒性)、编码格式等技术参数;

- 统一标识格式:确保跨平台、跨服务商的AI内容标识具备通用性和互操作性,避免标识混乱导致识别困难;

- 检测与验证标准:为第三方机构提供权威、一致的判定依据。

5.3 平台担责:从被动防御到主动防控

短视频、社交平台是AI滥用内容的主要传播渠道,其管理责任尤为关键。

升级审核机制:摒弃单纯依赖关键词过滤的传统模式,投入资源研发并部署先进的深度伪造识别技术,建立“技术识别+人工复核”的双重审核体系。

优化举报与处置流程:设置清晰易用的举报入口,对用户反馈内容及时核查处理;对确认违规账号采取限流、封禁等措施,并建立黑名单共享机制。

调整推荐算法导向:在流量导向之外增加安全与伦理权重,限制低俗、欺诈类AI内容的推荐曝光,遏制有害信息扩散。

5.4 协同执法:打击AI黑产链条

深度伪造背后常存在完整的黑色产业链,涵盖“技术开发—工具售卖—内容定制—诈骗实施”多个环节。

需开展专项打击行动,联合公安、网信、市场监管等部门,依法查处非法软件开发、虚假内容制作与传播、网络诈骗等相关犯罪行为,切断利益链条,形成有效震慑。

生成式AI的技术浪潮势不可阻挡,它既为社会发展带来了前所未有的创新动力,也潜藏着冲击社会信任体系的风险,犹如一把双刃剑。当前我们正处于一个关键的转折点,治理的核心不在于因恐惧而全面禁止,也不应因便利而完全放任,而是在推动技术创新与维护法律伦理之间寻找到精准的平衡。

为此,亟需构建一个涵盖“标准制定—技术检测—效果评价”的闭环治理体系,将AI的发展纳入可监管、可追溯、可追责的运行框架中。这一体系不仅要求制度设计的前瞻性,更依赖多方协同的实际行动。

网信、工信、公安等部门应联合开展专项整治行动,例如推进“清朗·整治AI技术滥用”等专项工作,从源头入手,对利用AI进行诈骗、伪造、传播虚假信息等黑灰产业链实施全链条打击,遏制技术滥用蔓延态势。

同时,必须建立高效的跨部门协同执法机制。打破行政壁垒,实现数据互通与情报共享,提升对跨平台、跨地域违法行为的响应速度和查处能力,形成真正意义上的联动治理格局。

对于技术开发者而言,应始终秉持“技术向善”的理念,将社会责任融入产品设计全过程;各类互联网平台则需强化内容审核义务,落实主体责任,防止自身系统成为违法信息传播的温床;而每一位数字空间的使用者,也应主动提升媒介辨识能力,增强对虚假内容的警惕性与判断力。

营造一个清朗、可信的网络环境,并非单一主体能够独立完成的任务,而是需要政府、企业、技术社群与公众共同参与的系统工程。唯有各方协力,才能确保AI在造福人类的同时,不逾越文明底线。

【省心锐评】

技术本身并无善恶之分,但其应用必须划定清晰边界。当AI逐渐模糊真实与虚构的界限,我们所需要的不是叫停技术进步,而是建立起强有力的法治约束机制和社会认知共识,用规则为技术狂奔系上安全带。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号