一、研究背景与核心挑战

本文深入解析发表于2025年9月12日《科学·进展》(Science Advances)的学术论文《Ultrahigh-precision analog computing using memory-switching geometric ratio of transistors》[1]。该研究由南京大学梁世军、缪峰团队主导,博士生杨董行健、博士后王聪、博士生赵懿晨为共同第一作者,缪峰教授、梁世军教授及王聪博士后为共同通讯作者。该团队长期聚焦于新型材料与存算一体等前沿计算架构的研究探索。

在人工智能硬件加速快速发展的背景下,模拟计算因其天然具备的并行处理能力与高能效潜力,成为极具前景的技术路径之一。通过可编程模拟器件直接对信号进行运算,尤其适用于神经网络中关键的向量-矩阵乘法(VMM),展现出显著优势。然而,尽管理论性能优越,低精度问题始终是制约其走向实用化的核心障碍。

传统模拟计算方案的精度受限,根源在于其依赖器件的本征物理参数——如忆阻器的电阻值或晶体管的电导——作为计算基础。这些参数在多次编程与读写过程中易发生漂移和波动,导致结果不一致;同时对外界环境变化极为敏感。温度、磁场等因素会改变载流子迁移率、阈值电压等关键特性,引入难以预测的误差,造成系统输出严重失稳。为应对这一问题,研究人员常采用复杂的补偿机制提升精度,例如多次采样平均或顺序累加代替并行操作等“混合精度”策略。虽然此类方法可在一定程度上校正偏差,却牺牲了模拟计算最本质的优势:不仅削弱了并行性与速度,还大幅增加了控制电路的复杂度与功耗,使高效性大打折扣。

针对上述瓶颈,梁世军、缪峰团队提出一种颠覆性的解决思路:将计算的物理基础从易变的“器件参数”转移至稳定的“器件几何结构”。由于晶体管的几何尺寸在制造完成后即固定不变,不受后续操作或外部干扰影响,因而具备极高的稳定性。该方案创新性地利用晶体管沟道宽度的比例关系作为计算权重编码的核心机制,借助这种内在稳定性构建高精度模拟计算体系,从根本上摆脱对不稳定参数的依赖。

本研究的主要创新点与成果总结如下:

- 以几何比率实现权重编码:摒弃传统依赖电阻或电导的方式,转而采用晶体管的几何尺寸比来表示计算权重,极大提升了系统的稳定性和复现性。

- 构建大规模并行存内计算架构:设计了一种高效的模拟存内计算(AIMC)结构,利用本地存储控制晶体管组合,在电流域中完成高速VMM运算。

- 实现超高硬件精度:在芯片层面达成0.101%均方根误差的计算精度,达到当前国际报道中模拟计算芯片的最高水平。

- 具备极端环境鲁棒性:在-78.5℃至180℃的宽温范围以及强磁场条件下仍能保持高精度运行,验证了技术的高度可靠性。

二、解决方案详解

(1)基于几何比率的高精度模拟计算架构

为突破传统模拟计算精度低、抗干扰能力差的局限,研究团队提出一种全新的精密模拟计算范式——以晶体管的几何尺寸比例为核心物理基础,取代传统依赖易变参数的方法。

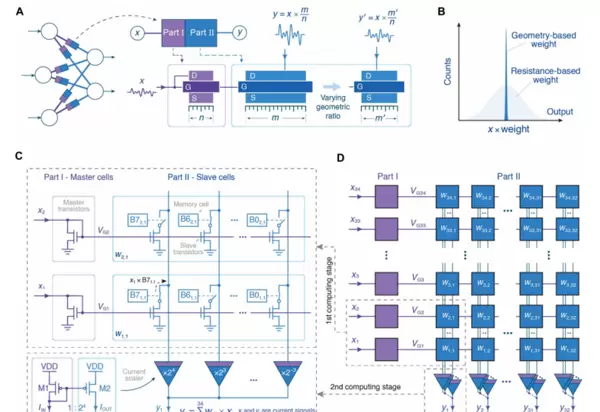

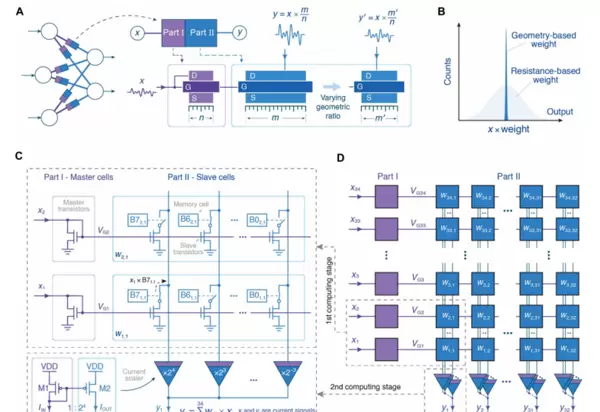

其核心原理如图1A所示:计算过程由两个晶体管沟道宽度之比(m/n)精确决定。由于几何结构具有制造后不可变的特性,该方式确保了计算的高度可重复与精确输出。概念对比见图1B,清晰展示了新旧方法在稳定性上的差异。

所设计的两级放大式模拟存内计算(AIMC)单元如图1C所示。第一级电路依据本地存储的二进制权重Bi,动态选择并配置不同的晶体管组合,从而调节有效几何比率;第二级则采用固定尺寸晶体管提供2i×3倍增益,进一步增强信号分辨率。通过集成8个存储位(memory bits),系统实现了从0到255共256级的8位精度可编程权重输出。

图1D展示了实际芯片的整体架构,包含一个34×32规模的计算单元阵列。该架构支持在电流域内执行完全并行的VMM操作,并兼容SRAM、RRAM等多种主流非易失性存储技术,具备良好的扩展性与工艺适应性。

(2)高精度向量-矩阵乘法(VMM)实现

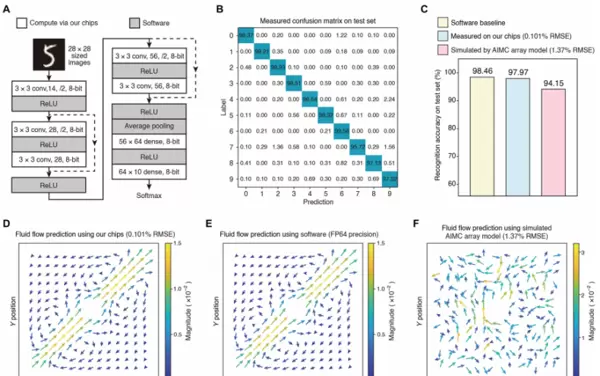

为验证该几何基架构在真实运算场景下的表现,研究团队搭建了一套完整的测试平台,集成了微控制器(MCU)、数模转换器(DAC)和模数转换器(ADC),能够并行输入向量数据并实时采集输出结果。

在此过程中,面对制造工艺带来的晶体管失配问题,研究引入一项关键技术——“权重重映射(Weight Remapping)”。如图2C所示,由于几何尺寸误差属于静态且稳定的偏差,可通过预先标定芯片特性,将目标权重矩阵

精准映射为实际写入芯片的几何配置W。该方法有效补偿了工艺波动,使得整个系统能够在模拟域中实现接近理想的线性响应特性。

实验结果表明,该架构不仅能维持超高的计算保真度,还能在无需复杂外围纠错的情况下稳定运行,充分体现了其在高精度模拟计算中的巨大潜力。

三、实验性能验证

从方法层面来看,本研究在“芯片-系统”全链路中进行了系统性的实验验证。芯片基于180 nm标准CMOS工艺流片,并通过线焊方式封装至专用PCB板上,与外部DAC、V–I转换模块、I–V转换电路及ADC共同构成完整的向量-矩阵乘法(VMM)精度测试平台。整个系统由MCU统一调度,实现输入向量的并行加载与输出结果的同步采集。

为确保不同技术方案之间的误差数据具备可比性,研究人员将模拟芯片输出的电流信号转换为电压形式,与理想值进行差值计算,并以输出动态范围进行归一化处理后得出均方根误差(RMSE)。因此,文中所报告的0.101%等误差指标具有明确的横向比较意义。

(3)基于芯片的应用展示

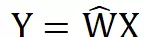

得益于极高的计算精度,该模拟存算一体芯片展现出在复杂任务中实际应用的巨大潜力。研究团队首先将其应用于人工智能领域的经典场景——MNIST手写数字识别任务。如图3A所示,实验搭建了一个包含卷积层和全连接层的神经网络模型,所有矩阵乘法运算均由该模拟芯片完成。测试结果显示,芯片在标准测试集上实现了97.97%的识别准确率。

这一结果与基于64位浮点精度的纯软件基准(98.46%)相比,性能损失极小(<0.5%),几乎实现无损推理。作为对照,若采用典型误差为1.37%的传统模拟存算仿真模型(代表当前主流技术水平),识别准确率则显著下降至94.15%。该对比充分证明了该芯片在神经网络推理中具备媲美数字系统的高精度计算能力。

除了AI推理任务,研究还进一步拓展至对数值精度要求极为严苛的科学计算领域。研究人员利用该芯片求解描述流体动力学行为的纳维-斯托克斯(Navier-Stokes)方程,模拟流体绕中心支柱的流动过程。在迭代类科学计算中,微小误差极易随计算步数累积并导致结果发散。

如图3D至3F所示的结果对比极具说服力:由该芯片计算得到的流体速度场(图3D)与64位浮点软件生成的“真值”(图3E)高度一致,流线清晰且物理特征完整;而采用1.37%误差的传统模拟阵列模型所得结果(图3F)则出现大量非物理伪影和错误流向。该成果打破了模拟计算难以胜任高精度仿真的传统认知,凸显出基于几何比编码的模拟架构在偏微分方程求解等科学计算任务中的广阔前景。

图2 并行模拟VMM测试系统及权重重映射技术

依托上述测试平台,研究人员对芯片开展了大规模随机向量-矩阵乘法(VMM)测试。实验采用64×32符号权重矩阵,在连续执行1500次并行VMM操作、累计获取48,000个点积数据后,测量结果表现出极佳的一致性。如图2D和2E所示,实测输出与理想输出的散点图近似一条极细直线,体现出优异的线性特性;误差分布直方图呈现以零为中心的完美高斯形态。经归一化处理后,其均方根误差(RMSE)低至0.101%。

这一精度在模拟计算领域具有里程碑意义。如图2F所示的对比数据显示,该工作不仅达到了目前已报道方案中的最低误差水平,而且随着矩阵规模扩大,其相对于其他模拟技术(如RRAM或传统Flash基方案)的精度优势更加突出。

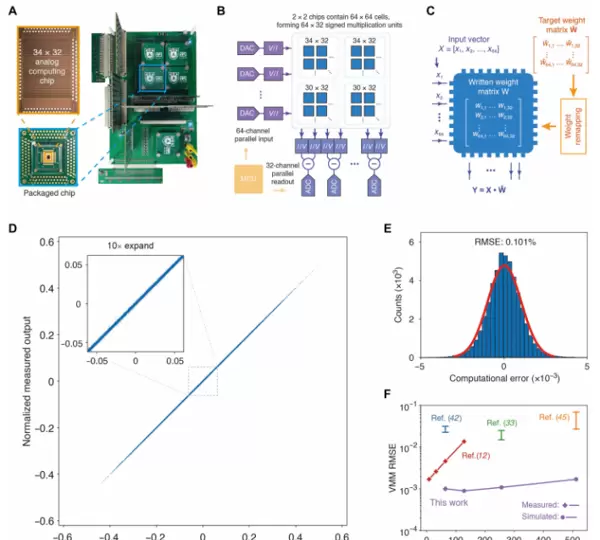

极端环境下的精度验证

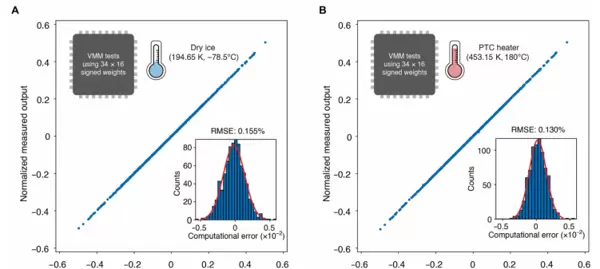

为进一步验证“几何比编码权重”策略在复杂环境中的稳定性,研究人员设计了极端温度与强磁场条件下的运算测试。实验流程如下:先在室温下通过权重重映射完成一次性标定,将一组随机权重矩阵写入芯片;随后在不重新校准的前提下,将同一VMM任务分别置于低温与高温环境中重复执行。

测试结果表明,在-78.5℃低温条件下,芯片的VMM误差仅为0.155%;而在180℃高温环境下,RMSE也仅达0.130%,运算结果与室温状态几乎一致,展现出卓越的热稳定性。

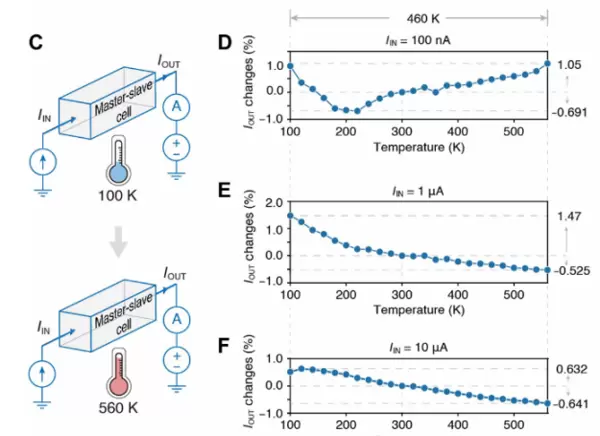

图4 高低温下 VMM 输出与理想值对比

为深入分析温度对单元级电路的影响,研究人员在100–560 K宽温区内测试了单个主从计算单元的表现。在三种典型输入电流(100 nA、1 μA、10 μA)下,输出电流相对于300 K基准的偏差始终控制在1.47%以内。这说明尽管载流子迁移率、阈值电压等电学参数随温度变化显著,但由器件几何尺寸决定的权重比例保持稳定,从而保障了整体计算精度不受环境干扰。

图5 不同温度下单元输出漂移

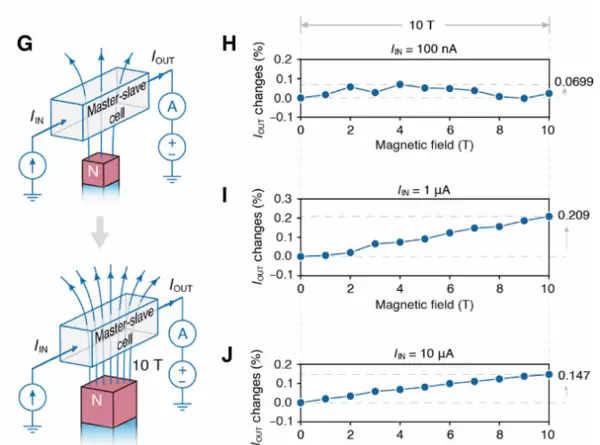

除温度外,磁场干扰也是衡量器件鲁棒性的重要指标。研究团队在0–10 T的强磁场范围内对该计算单元进行了测试。通常情况下,强磁场会改变载流子运动轨迹,影响常规模拟器件的传输性能。然而,在该基于几何比的架构中,输出电流在100 nA、1 μA、10 μA三种输入条件下的波动均小于0.21%。

这意味着即使处于实验室级别的超强磁场环境中,这种以几何结构为核心的模拟计算方式仍能维持接近室温、零磁场时的精确输出表现。

图6 不同磁场强度下输出变化

图3 基于高精度AIMC芯片的AI任务与科学计算应用展示

在阵列规模的验证方面,作者不仅完成了34×32的实际测试,还进一步基于工艺PDK在Cadence平台构建了后仿真模型。通过该模型,将阵列行数扩展至128、256乃至512等更大规模,并充分考虑了位线电阻等非理想因素的影响。仿真结果显示,随着阵列规模的增大,VMM运算的误差依然能够保持在极低水平,展现出良好的可扩展性。

为评估芯片在复杂环境下的稳定性,研究团队搭建了专用测试平台,包括低温与高温探针台以及超导磁体系统,用于开展温度和磁场相关的实验。借助精确的温控机制和磁场调控能力,研究人员在多种工况下重复执行相同的VMM运算及单元级测量操作。实验结果证实了“室温下完成一次重映射即可适用于全环境”的可行性,显著提升了应用灵活性。

综合来看,这一系列系统性的实验设计与方法论支持了一个重要结论:基于CMOS工艺、利用晶体管几何比实现存储切换的模拟存算一体芯片,不仅在室温条件下实现了当前报道中最高的模拟VMM精度,更在极端温度与强磁场环境下仍能维持接近数字计算级别的稳定性和可靠性,展现出优异的环境适应能力。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号