机器学习的基本概念

本质:通过有限的观测样本,挖掘出具有普遍性的规律,并运用这些规律对未知数据进行有效预测。

定位:作为人工智能领域的重要分支,机器学习已成为推动AI技术进步的核心力量之一。

传统方法与“浅层学习”模式

核心任务:聚焦于构建一个有效的预测模型。

基本前提:必须先将原始数据转化为可计算的特征形式。这些特征通常由人工设计或通过特定转换方式生成,表现形式可以是数值型、符号型等。

“浅层学习”的主要特点:

- 模型本身不具备自动提取特征的能力。

- 特征的有效性极大程度依赖于人为经验或复杂的特征变换手段。

应对多样化数据类型的难题

现实世界中的数据类型丰富多样(如图像、文本、音频),其结构差异显著,导致特征构造的方法也各不相同。

举例说明:

- 图像数据:天然适合表示为连续向量,例如以像素值构成矩阵。

- 文本数据:由离散的字符或词汇组成,原始编码缺乏语义信息,因此寻找有意义的特征表达成为关键挑战。

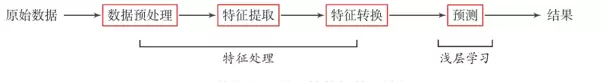

传统机器学习的标准处理流程

为了应对上述复杂性,传统机器学习通常采用分阶段、模块化的处理流程:

1. 数据预处理

目的:完成数据清洗和初步整理,形成结构清晰、质量可靠的输入集。

常见操作:填补缺失值、剔除重复项、执行数值归一化等。

2. 特征提取

目的:从原始输入中人工筛选或构造出有助于任务判断的关键特征。

示例:在图像识别中提取边缘轮廓或SIFT特征;在文本分类中移除停用词并进行词干提取。

3. 特征转换

目的:进一步优化已提取的特征,提升其表达能力与计算效率。

常用方法:

- 降维:使用PCA、LDA等技术减少冗余与噪声,提高泛化性能。

- 升维:在某些场景下扩展特征空间以增强区分度。

实现路径包括:特征抽取(生成新特征组合)与特征选择(保留最具代表性的原始特征)。

4. 模型学习(预测建模)

目的:训练一个能够映射输入到输出的预测函数,这是理论研究的重点所在。

实际观察表明:不同预测算法之间的性能差距往往较小,而最终效果更取决于前三个阶段——尤其是特征处理的质量。

核心结论:特征工程决定成败

由于特征构建过程高度依赖人工干预和专业领域知识,且直接影响模型表现,许多实际问题最终演变为如何做好特征工程。

开发一个传统机器学习系统的绝大部分工作量(甚至超过80%)都集中在数据预处理、特征提取与特征转换环节。

总结要点

传统机器学习遵循的是“特征工程 + 预测模型”的架构范式。系统性能的瓶颈通常不在最后的算法选择上,而在于前端繁琐、耗时且需要专家经验支撑的手工特征处理流程。

正是这一根本局限,催生了深度学习的发展——其最大优势在于能直接从原始数据中自动学习多层次特征,从而突破传统方法的桎梏,实现重大技术突破。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号