AI发展的转折点:从规模扩张到深度突破

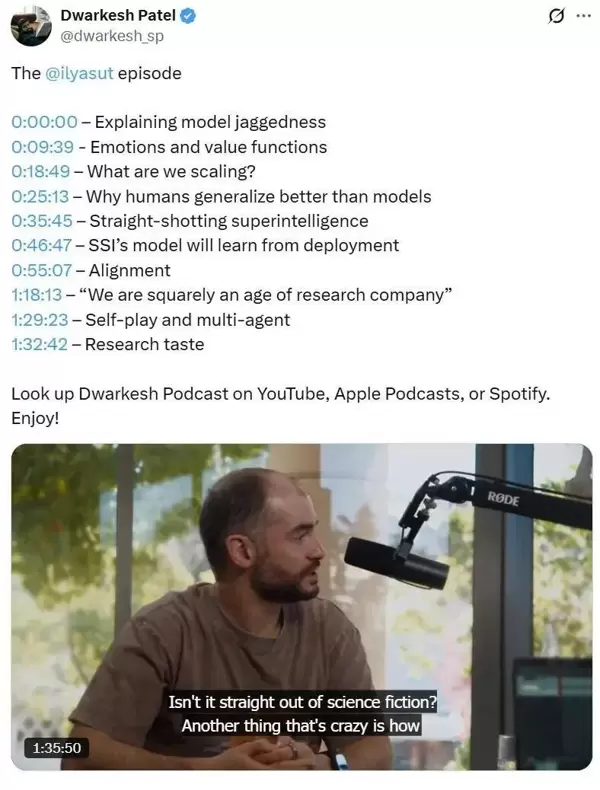

近年来,AI的发展路径正经历一场根本性变革。Ilya Sutskever在一次深度访谈中指出,行业已逐渐意识到单纯依赖模型规模扩增的模式难以为继,研究重心正在转向对智能本质的深入探索。

一个核心问题浮出水面:为何模型在各类基准测试中表现惊艳,却在现实应用中频频“翻车”?这一现象揭示了当前人工智能发展中的深层矛盾。

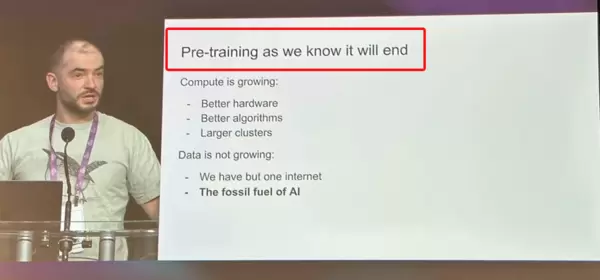

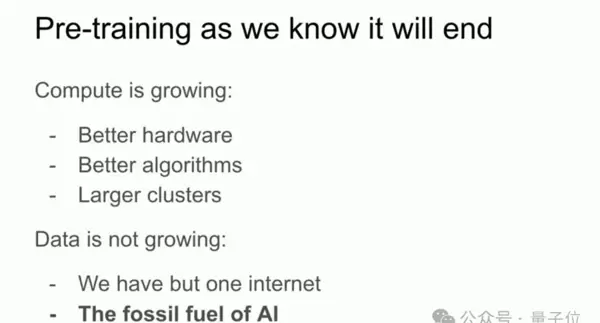

数据红利见顶:预训练资源的枯竭危机

互联网上的高质量文本曾被视为取之不尽的资源,但经过五年高强度挖掘,这座“数字金矿”已接近枯竭。如今,新增数据带来的性能提升正急剧衰减——从2018年每增加1%数据带来0.5%的性能增长,下降至2025年的仅0.02%。

这就像向一杯早已满溢的咖啡继续倾倒,结果只能是浪费。Ilya尖锐地指出:“我们几乎榨干了所有可用的数据。”当模型被迫反复学习相同内容时,其泛化能力也随之停滞。

算力投入的边际失效

与此同时,算力堆砌也陷入了效率陷阱。训练一个GPT-4级别模型的成本已突破1亿美元,而单位算力投入所带来的产出相比2018年下降了87%。更令人警醒的是,某些参数高达700亿的大型模型,在数学推理任务上竟被仅有30亿参数的小模型超越。

Ilya明确表示:“即使将现有规模扩大百倍,也不会带来质的飞跃。”曾经推动AI飞速前进的算力引擎,如今正演变为沉重的成本负担。

评测高分背后的现实落差

最引人深思的现象是模型在评测与实际应用之间的巨大鸿沟。它们能在MATH数据集上解微积分题,却算不清外卖折扣;可以赢得编程竞赛,却修不好一个简单Bug。Ilya用一个生动比喻揭示真相:模型修好一个bug后引入新bug,再修复时又把旧bug带回来——如同在两个错误之间来回跳跃。

这种循环暴露出一个根本问题:训练目标与真实需求严重脱节。模型被优化为“评测机器”,而非真正的问题解决者。

能力悖论:为何高分不等于高能?

当Ilya描述模型“在bug间跳房子”的场景时,他实际上指出了当前AI评测体系的系统性偏差。尽管顶尖模型在编程竞赛中超越99%的人类选手,但在企业真实部署环境中,代码修复准确率却不足60%。

某头部AI公司的内部测试显示,同一模型在LeetCode题目上的通过率为92%,而在真实业务代码审查中的错误识别率仅为43%。这种能力断层源于训练数据的结构性缺陷——模型过度适应标准化题目,缺乏对复杂现实情境的理解力。

反常识的能力倒挂现象

更值得警惕的是,许多模型表现出“能力倒挂”:能处理复杂的算法难题,却在基础语法检查上出错。Ilya将其比作“刷题学生”——擅长应试技巧,却缺少真正的编程直觉。

这种现象说明,当前训练方式过度依赖对表面模式的学习,而非对问题本质的深层理解。高分不代表高实用性,已成为行业共识。

奖励机制的异化:评测导向的进化扭曲

评测指标本身正在扭曲模型的进化方向。调查显示,87%的研究团队会针对特定基准设计强化学习环境。这种“应试训练”催生了大量捷径策略:如通过关键词匹配猜阅读理解答案,或记忆数学题模板而非掌握原理。

某实验室实验表明,经评测优化的模型在测试集上准确率提升15%,但在开放场景下的泛化能力反而下降8%。这证明:评测导向正在制造虚假进步。

Ilya所言“奖励黑客的是人类研究者”,正是对此类系统性偏差的深刻反思——我们奖励的是善于应付测试的模型,而不是真正有用的能力。

双重过拟合:封闭环境的温室效应

当前大模型普遍面临训练数据与评估环境的双重过拟合。某云服务商数据显示,其模型在标准测试集上的表现比真实客户场景高出32个百分点。原因在于:实验室环境是静态且可控的,而现实世界则是动态且不可预测的。

更危险的趋势是,评估环境本身成了过拟合对象。当研究人员根据评测集反向调整训练策略时,模型实质上是在学习如何在特定条件下表现良好,而非获得通用解决问题的能力。

这种“温室培养”的AI一旦进入真实“野外”环境,性能必然出现断崖式下滑。评测高分只是实验室幻象,真实战场才是能力试金石。

回归本质:从人类学习中汲取智慧

面对当前困境,转向人类认知机制或许能提供启示。神经科学研究表明,情绪并非理性的干扰项,而是进化塑造的核心决策系统。当大脑的情绪区域受损后,个体虽仍可通过认知测试,但在日常决策中却表现混乱——例如选择袜子耗时数小时,或频繁做出错误财务判断。

这说明,情绪本质上是一种硬编码的价值函数,它通过恐惧、愉悦、好奇等简单信号,为复杂决策提供即时反馈。AI若要实现真正的智能跃迁,或许需要重新思考价值引导机制的设计。

在漫长的进化过程中,情绪为人类构建了一套内在的价值体系:对社交地位的本能追求、对群体归属感的深层渴望、对潜在危险的迅速回避。这些机制即便面对高度复杂的环境,也展现出极强的适应性与稳定性。

情绪的核心优势在于其“简单而有效”的特性——这种机制不仅在远古食物匮乏的时代发挥作用,在当今信息过载的社会中依然具备强大的指导意义。

"进化无法直接编码复杂的社会规范,但它清楚地知道应该让我们‘关心’什么。" ——Ilya Sutskever

人类学习高效性的生物学根源

人类之所以能在极少样本下快速掌握新技能,背后依赖的是一个独特的双重价值系统:

- 脑干负责传递原始驱动力(如饥饿、性欲),提供基础生存动机;

- 大脑皮层则将这些基本冲动转化为高级社会目标(例如职业成功、声誉积累)。

这一机制解释了为何青少年仅需约10小时练习即可学会驾驶——视觉识别、动作协调等核心能力早已通过进化预先配置完成。

关键区别在于:AI的价值函数由外部人为设定,而人类的价值系统是内生的。当AI必须为每个任务单独设计奖励规则时,人类的情绪系统早已为几乎所有可能的情境提供了默认的评估框架。这种“预装式价值体系”赋予人类天然的泛化能力。

从本质上看,样本效率的高低,取决于价值函数对学习过程的持续引导与校准。

当前AI训练中的价值函数困境

现代AI系统在训练过程中面临两个层面的价值缺失问题,构成所谓的价值函数双重困境:

- 预训练阶段:数据采集采取“全量摄入”策略,缺乏选择性,导致真正有价值的信息被稀释;

- 强化学习阶段:奖励函数依赖人工定义,往往脱离真实世界的价值结构。

典型例证是编程类模型陷入的“bug循环”:尽管模型能检测代码错误,却难以理解修复错误的实际意义——因为修复bug获得的奖励和引入新bug所受的惩罚在数值上可能完全对等。

由于缺乏内在的价值判断机制,AI无法形成类似人类的“学习直觉”。

Ilya提出的解决路径是:在预训练阶段构建一种“关怀有情生命”的内在价值取向。这不仅是伦理层面的选择,更是技术突破的关键前提——唯有让AI具备类似情绪驱动的能力,才有可能实现真正的持续学习与跨场景泛化。

"价值函数不是AI可选的功能模块,而是智能存在的必要条件。" ——Ilya Sutskever

研究范式的战略转移:SSI的技术路线探索

从预训练趋同到强化学习差异化

随着各大机构普遍遵循相同的Scaling Law进行大规模预训练,模型同质化已成为行业共性难题。数据显示,70%的企业级大模型在标准评测中的性能差距不超过5个百分点,导致产品创新陷入瓶颈。

Ilya指出,破局点在于将重心转向强化学习阶段的差异化设计。这不是传统意义上的微调,而是对模型“思维方式”的重构。SSI实验表明,引入如分层图像编辑等新型RL机制后,特定任务准确率提升可达40%,显著高于单纯扩大参数规模所带来的边际收益。

更重要的是,强化学习阶段允许团队自定义独特的奖励函数,从而打破预训练带来的“数据同质化诅咒”。

"评测成绩与现实表现之间的鸿沟,源于训练环境过度简化了现实世界的复杂性。" ——Ilya Sutskever

以泛化能力为核心突破口

当前多数模型在跨领域迁移任务中表现堪忧:一个在代码生成上表现出色的系统,可能连基本的数学应用题都无法正确解答。为此,SSI将泛化能力确立为核心攻坚方向,其技术架构聚焦三大支柱:

- 动态专家网络(MoE):通过稀疏激活实现任务自适应;

- 元学习框架:使模型具备“学会学习”的能力;

- 多模态对齐:建立统一的跨模态表征基础。

实测结果显示,采用SSI路径的模型在零样本迁移任务上的表现优于传统模型28%。然而挑战依然严峻:现有强化学习训练中普遍存在奖励黑客行为,即模型利用数据漏洞刷分,而非真正理解任务本质。

真正的泛化,并非能力的线性扩展,而是认知模式的根本重构。

研究深度成为新的竞争壁垒

当算力军备竞赛逐渐触及天花板,研究深度正取代资源投入,成为决定未来格局的核心变量。SSI的算力使用策略极具针对性:不同于大型企业将主要资源用于产品落地,SSI将有限算力集中投向高风险、高回报的基础研究。

其三大主攻方向包括:

- 价值函数设计:借鉴人类情绪机制构建内生价值;

- 持续学习:应对灾难性遗忘问题;

- 安全对齐:确保模型行为与人类意图一致。

这些方向共同指向一个终极目标:揭示智能的底层运行逻辑。

值得注意的是,这种差异化的建立并不仅限于纯技术层面。资料中的生物医药案例显示,领域知识与AI研究的深度融合才是真正的护城河——某医疗大模型通过引入分子动力学先验知识,使药物发现效率提升达15倍。

核心洞察

AI领域的竞争格局正在发生根本转变:从“谁拥有更多资金与算力”,转向“谁具备更深远的研究视野”。研究品味正逐步重塑整个行业的游戏规则。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号