题记:为什么我要在我们环境经济学板块转载这样一篇文章?我想是因为方法不论学科,而且环境经济学诸多文章都是在研究政策或者项目效果评估,古人云工欲善其事必先利其器,我想偶尔穿插一两篇方法论的综述类文章,也是很有意义的!当然由于个人水平和精力有限,转载的文章不免偏颇,欢迎大家补充。

文献解读Athey, S., & Imbens, G.W. (2017). The state of applied econometrics: Causality and policy evaluation. Journal of Economic Perspectives, 31(2), 3-32.

The state of applied econometrics Causality and policy evaluation.pdf

(880.99 KB, 需要: 10 个论坛币)

The state of applied econometrics Causality and policy evaluation.pdf

(880.99 KB, 需要: 10 个论坛币)

引言

政策评估的黄金准则是随机对照实验RCT (Randomized Controlled Trial),但是很多情况下由于实验很难操作,研究者们大多依赖观察得到的数据(observational data)来进行因果推断,而经济学家们则花了大量的时间寻找可行的因果识别策略(Identification Strategy)尝试从这些现实的观察数据中进行因果推断。这篇JEP总结并讨论了三件事情:项目评估和因果推断的新发展,包括断点回归(Regression Discontinuity)、合成控制法(Synthetic Control)、倍差法/双重差分(Differences-in-differences)等;对识别策略的补充分析(Supplementary Analysis),即提升分析可信度的一系列方法;机器学习方法在处理效应和因果推断中一些新应用。

一、项目评估的新发展

近30年来,潜在结果方法即Rubin Causal Model的框架在因果推断中被广泛应用。这个框架强调了因果推断的基本问题:当我们给某个个体以政策影响或处理 (Treatment)时,我们并不知道这个个体如果没有受到影响会有怎样的结果,我们不能观察到这个个体的潜在结果 (potential outcome),因此不能准确地得到处理效应;当我们简单地比较两组观察数据,一定会牵扯到自选择 (Selection Bias)问题,导致估计的因果效应是有偏误的。在非混淆假设下 (Unconfoundedness Assumption),要求我们对政策分配的过程尽可能地随机,以致实验组和控制组的差别就是我们最终要估计的平均处理效应 (ATE-Average Treatment Effect)。在这个部分,文章主要讨论了断点回归、合成控制法以及倍差法,一些其他的方法包括倾向性得分 (Propensity Score),匹配(Matching),以及我们熟知的工具变量(IV)等文章不做细节的讨论。

断点回归

断点回归利用参与某一政策产生的激励存在断点来进行效果的评估,它最重要的设定在于外生的forcing variable的存在,即参与某个项目的概率在某个门槛值附近存在不连续的断点,它依赖的假设是在门槛附近的个体是高度相近的以致他们的差别仅仅在于是否受到这个政策影响,因此这个差别也就是我们要的处理效应。具体来说,RD分为sharp RD和fuzzy RD,前者在断点的跳跃意味着一定会受到treatment,而后者在断点的跳跃只是意味着受到treatment的概率增加。需要注意的是,RD估计出来的treatment effect并不是针对样本整体而言,而是针对处于断点附近的样本而言,即我们常说的LATE (Local Average Treatment Effect),即那些受到政策变化产生行为变化的群体与未受到政策变化未发生行为变化的群体之间的差别。

文章提出在进行断点回归的操作时需要注意四点:

1、相比于使用kernel regression,作者建议使用local linear regession,分别对于断点两侧的样本进行线性回归,并对预测值做差得到最终的估计,从而纠正在断点处因为断尾数据造成的误差;同时这种方法相比一些非参数的估计要具有更好的有限样本性质。

2、需要对带宽的选择做更加谨慎的分析,即如何权衡距离断点的多少与样本数量。传统的方法运用非参的方法对最优带宽进行筛选,文章则建议通过在带宽的很小范围内对估计量进行渐近展开 (asymptotic expansions) 用local linear regression来进行带宽选择。

3、如何检验断点回归要求的假设,即如何去检验在断点附近的样本是否具有自我操控 (manipulation)的可能性,以及对其他变量在断点附近的不连续性进行检验等。

4、进行外部有效性检验,比如对其他子样本进行更详尽的断点可信度检验。

关于断点回归,文章就Jacob and Lefgren (2004)进行了一些阐释。

这篇文章探讨了在芝加哥公立学校(Chicago Public Schools)参加暑期学校(summer school)会不会对学生标准化考试产生影响,对于那些分数在阅读或者数学考试中低于某个门槛的学生需要强制参加暑期学校,文章关注的结果变量是学生们在参加完暑期学校之后的数学考试成绩(正态化方差为1)。Table 1的第一行估计的是全样本,即把参加暑期学校前学生阅读和数学考试的最低分作为forcing variable,结果显示参加暑期学校显著地(0.02 standard error)提升了学生之后的数学考试成绩0.18个标准差。无论是语言成绩还是数学成绩低于门槛,学生们都要参加暑期学校,因此我们可以分别估计那些因为语言成绩参加暑期学校和因为数学成绩参加暑期学校学生的效果并作对比,依赖于多个外生变量的门槛极大地提高了我们对异质性处理效应的分析能力。Table 1的2-4行给出了对异质性效果的估计,在这个例子中,三个估计结果差别并不是很大。注意到,带宽的选择也非常重要,如果使用Local Constant的方法来选择带宽,即第5行所显示的,发现估计出来的结果反而是相反的,正如作者给出的建议我们应该对于带宽的选择更加谨慎。

合成控制法与双重差分

对倍差法/双重差分(DID)估计的一大挑战在于是否满足平行趋势的假定,即如果没有受到treatment,实验组是否具有与对照组相似的时间趋势。对于DID而言有两大新的发展,一个是合成控制法,另一个是nonlinear CIC(changes-in-changes)。不止是使用一个对照组或者简单的对照组平均,合成控制法使用对于对照组的一个加权平均来替代之前的对照组。因此,对于合成控制法来说,如何选择权重成为一个核心问题。一些学者提出权重需要满足每一个权重非负且权重总和为一,另一些学者则认为并不需要这样的限制。函数形式的假设对于DID来说也非常重要,对于一个两期两组的情况,我们很难知道时间趋势改变的状况;政策在不同阶段下既可能改变估计结果的均值和方差,在个体之间的影响也会不同。因此,作者提出使用非线性的DID来进行估计,即CIC的方法,它不依赖于函数形式,也允许时间和政策系统性地对不同个体有所不同,例如对工作技能的回报是随时间产生变化的,或者新的医疗方式对于更加多病的患者来说有更大的效果。

在多种处理水平的情况下估计ATE

传统文献中大多都关注二值的政策效应,近期也有一部分文献开始关注多值的政策效应,如多个选项的定价策略和广告活动。在关注二值时,由于协变量较少,在非混淆假设下,可以直接将平均结果作为可观测的协变量的函数,然后使用该模型来调整可解释程度;然而在多个协变量、或协变量带来的组间差异过大时,这种方法不再有效。应对这种情况的一个解决方案依赖于倾向得分(Propensity Score)的概念。倾向得分是给定个体可观测的个人特征之后可能得到处理的概率,利用这个单维变量,只要无混淆条件满足我们便只需要控制倾向得分而无需构造可观测变量的函数。在实践中,在因果推断上最有效的就是那些将针对结果的条件均值建模和基于协变量构造的倾向得分分类、匹配、加权结合起来的方法(如Imbens and Rubin 2015),实现双倍稳健。

基于此方法的拓展得到的关注较少,但是近期也有文献展示了利用广义版本的倾向得分进行降维的方法。Imbens(2000)介绍了弱无混淆假定下的广义倾向得分,此时该假定只要求特定处理水平的指标和该水平的潜在结果是条件独立的。利用这种方法进行倾向得分的匹配和分类时,只需要依据协变量对处理水平上单位的条件平均值估计该水平的边际平均结果、一次一个治疗水平地构建协变量空间子集,而非在寻找一个可以解释所有处理水平的组间差的协变量子集。

社会交互中的因果效应

本文也探讨了社交网络中同龄人效应和其他广义的因果效应的估计,其中尤其关注了个体在互动中违反了无互相干涉假定(no-interference assumption,或被成为稳定个体影响值假定:Stable Unit Treatment Value Assumption)的情况下的因果推断。对于个体的相互干涉,一些情况下可能是干涉者,并不影响我们对于处理效应的估计;而零一些情况下,这些互动本身就是研究目标。

社会交互的分析有不同的应用场景。一个应用场景的区别在于可以将样本分为诸多内部联系起来的子样本,如按照教室(Manski 1993;Carrell, Sacerdote and West 2013)、劳动市场中的工人(Crepon et al. 2013)或大学室友(Sacerdote 2007),或者是考虑一个广义的内部联系的子样本,即朋友的朋友并不一定是自己的朋友。另一方面,样本可以分为拥有众多断开的社会关系的网络或着一个单独的互相联系的网络,在前这种对于渐进一致性的讨论依赖于网络的数量,后者则不然。当考虑到某些情况下社交联系是对称的而其他情况下可能只有单向交互,网络上的连接可以是二值的也可以有着不同的强度。

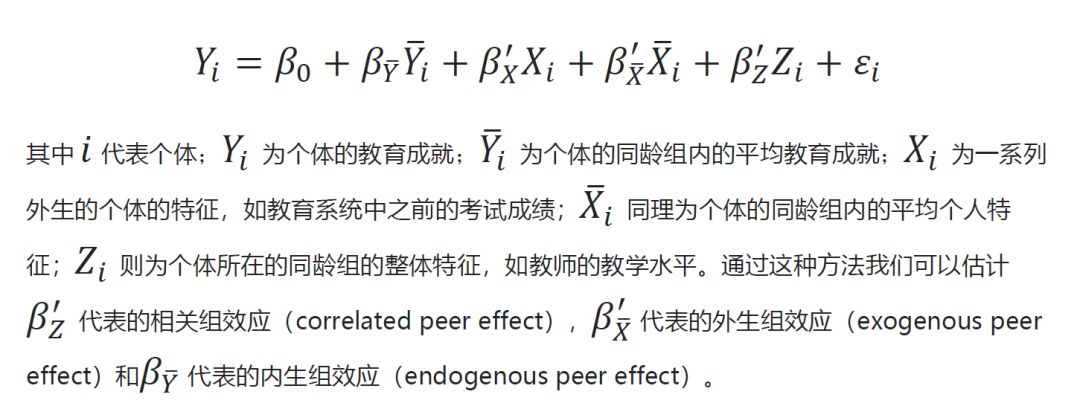

这方面的重要工作集中在Manski的均值内线性模型(linear-in-means model)(Manski 1993; Bramoulle, Dejebbari, and Fortin 2009;Goldsmith-Pinkham and Imbens 2013)。在Manski的原文中关注了将样本分为不同组且组内存在同龄人效应的情况,其基本模型为:

Manski在这篇论文中总结得出,当在恒定系数的线性模型中分别估计这三个不同的效应的时候,也需要非常强的假设,对于现实情况也无实际意义。在接下来的文献中,大部分研究者都采用了剔除部分效应或者使用信息更富足的信息结构的方法来进行识别。Graham(2008)假设残差的组内协方差矩阵为个体水平上的同方差,从而得到了组内和组间方差的差异,进而做出更有效的估计;Bramoulle, Dejebbari, and Fortin(2009)对Manski的模型进行了更大调整,即朋友的朋友不需要相互联系(人与人可以只有一层关系);Hudgens和Halloran(2008)关注了群体上的二元处理通过社会交互对个体产生的影响,并提出了不同的识别结构;Aronow和Samii(2013)则在广义社会网络中探讨了随机试验对个体的影响的识别力。

关于社会网络,还有两个分支值得注意:一个分支是研究网络形成的模型。研究者需要辨别一个不断扩大的样本会如何与现有样本产生差异或近似,进而用小样本对大样本进行渐进逼近,这方面的研究主要有Jackson和Wolinsky (2016)、Jackson (2010)、Glodsmith-Pinkham和Imbens (2013)、Christakis,Fowler,Imbens和Kalyanaraman (2010)、Mele (2013)。Chandrasekhar和Jackson (2016)构建了一个社会网络形成的模型并提供了一个网络内部存在相关性的中心极限定理,Chandrasekhar同年也有一篇文献探讨了社会网络形成的计量文献。另一个分支则是利用涉及了社会网络的随即推断方法来作为生成合适的p值的因果回归的研究。考虑原假设是treatment不存在影响,那么由于原假设若成立的话,我们可以在观测到treatment框架的个体结果的情况下得到备选的treatment框架下的个体结果,故而可以通过模拟反事实treatment的分配来计算准确的p值和其他统计量。此方法过于依赖原假设自身,而作者的一篇新文献则在讨论了众多不同原假设的基础上提出了更稳健的对于原假设的统计量的计算方法(Athey,Eckles,and Imbens,2018)

外部有效性

即便我们很仔细地在分析和实验设计上做了相对严格的因果推断,我们仍然没有说明我们的因果效应对于其他样本或者设定下是仍然是存在的。在一些最近的研究中,一些新的方法已经被提出来去直接评估处理效应的外部有效性,一个主要的例子是关于工具变量的:工具变量经常估计的是LATE而不是ATE,即我们估计出来的仅仅是局部平均处理效应,或者那些受工具变量影响的个体组成的群体的平均处理效应。所以什么样的情况下IV的估计对于整个样本来说是有代表性的?Angrist(2004)建议去检验是否对”always takers”和”never takers”(无论有无政策或treat都不会改变自身行为的个体)估计效果的差别与”compliers”(只因为政策产生或受到treat而改变行为的个体)的效果相同。Bertanhaand Imbens (2014)建议检验两个等式,一个是”untreated compliers”的效果与”never takers”的效果,一个是” treated compliers”的效果与”always takers”的效果。在断点回归设计中,同样面临着与IV估计相似的问题,即我们估计的是LATE。 Angrist and Rokkanen(2015),Bertanha and Imbens (2014),Dong and Lewbel (2015)提出了一些对断点回归外部有效性检验的手段,他们中的一些可以既运用到sharp RD和fuzzy RD,另一些只能运用于fuzzy RD。

二、补充分析

补充分析可以增加对主要结果的解释力和可信程度,这些方法主要关于如何去验证所使用的实证策略背后的假定是否在一定程度上满足;补充分析有各种各样的方法,文章主要讨论了安慰剂分析、稳健性检验等常用的方法以及一些经典例子。

安慰剂分析

一种标准的安慰剂分析利用outcome的滞后项来检验,例如在 Imbens, Rubin, and Sacerdote(2001)中,他们利用滞后六年的收入以及教育等指标来验证抽奖的随机性,以确保非混淆假设的成立。在断点回归的框架下,当距离断点很近时,其他协变量不应该与是否受到政策冲击所相关;因此,我们可以通过将这些协变量作为outcome来检验这个假设。 Rosenbaum (1987)中,提出多个对照组存在的必要性,可以通过检验两组对照组的treatment effect是否有所差别从而来证明所使用的对照组是否是有效的。

稳健性和敏感性检验

稳健性检验主要是强调基于某种设定(specification)的分析结果对于设定的放松并不敏感,例如使用不同的函数形式进行回归,或者考虑子样本之间的差别。最近的文献开始寻找评估稳健性的系统方法,Athey and Imbens (2015)建议将样本分为两个子样本,使用不同的specification对其分别进行估计;原始的因果效应应当是这两种估计的一个加权平均。如果原始的模型是正确的,那么这个增广的模型得到的也是对这个处理效应的一致估计。 Rosenbam (2002) 建议先从一个限制性的设定(restrictive specification)开始,再逐渐放松假定进行估计,例如非混淆假定等,他们认为报告一些基于更弱假定得到的结果对于估计结果的稳健性解释也是很有必要的。

三、机器学习相关

有监督的学习主要关注的是预测问题,即在给定的训练数据(training data)中,估计出能够用于预测检验数据(test data)结果的模型。无监督的学习更多关注的是寻找数据中的规律(pattern),例如应用于文本、图像以及高维数据的分组。二者的一大差别在于有没有结果变量(outcome),有的话就可以实现有监督的学习,反之是无监督的学习。交叉验证(cross validation)是机器学习常依赖的方法,基本思路是我们可以将数据分成k份,每一次估计都不使用第k份的样本,并对第k份样本计算残差平方和,进行k次的估计后得到均方误差(MSE);有监督学习依赖的就是基于数据的模型选择,即根据交叉验证最小化均方误差的方法来选择参数和最终的模型。有监督学习需要注意的另一个问题是过度拟合(overfitting),以及偏误与方差之间的权衡(bias-variance trade off),即我们在训练数据中训练出来的模型会由于对数据过度拟合产生在检验数据中比较弱的预测效果。文章主要就如何通过机器学习的方法提升因果推断的表现,尤其是针对很多协变量的情况给出了一些建议。

机器学习估计平均处理效应

近年来,研究者们将机器学习方法应用到具有众多协变量的情形下,文章提出了三种方法:

1、 Belloni, Chernozhukov, Fernandez, and Hansen (2013)提出了双重选择过程(double selection procedure),即首先使用LASSO来挑选与outcome相关的协变量,然后再挑选与treatment相关的协变量,在最终的OLS估计中他们使用这两套协变量的并集对ATE进行估计。

2、第二种方法关注在实验组和控制组之间协变量或协变量组合的最优权重,以至于对数据进行再加权后数据形式接近于随机试验RCT的标准。 Athey, Imbens, and Wager (2016)提出的估计量纠正了来自实验组中与控制组中加权后的协变量之间的不平衡与过多变量加权后过大方差之间的偏误,将平衡与回归调整相结合进而实现更好的估计。

3、第三种方法是关于influence function的半参数方法,涉及到对更高维度的估计以及如何对样本进行划分的选择。

机器学习估计异质性处理效应

回归树(regression tree)是将样本分组并对分组后每个子样本进行预测的一种常用方法,Atheyand Imbens (2016)中提出了一种新的方法:因果树(causal tree),它的方法基于回归树但却使用与回归树不同的建树方法,即它不关注预测值均方误差的改进而关注treatment effect的均方误差的改进。这种方法依赖于对样本简单的划分,一半的样本被用来划分空间即构造树的结构,另一半的样本被用来估计treatment effect,因此估计的结果就是每一个划分空间中的treatment effect以及相应的置信区间。这种方法也有一个不足之处,因果树估计出来的结果仍然不是个体效果,对于分到同一个划分区域的个体来说估计值是相同的。为了去估计更加个体化的结果, Wager and Athey (2015)提出了基于随机森林方法对异质性处理效应的估计。除此之外,Chipman et al. (2010)提出了贝叶斯版本的随机森林并被Green and Kern(2012)应用到异质性效果的估计中,Imai and Ratkovic(2013)也结合了LASSO regression做了相应的分析。

结论

经济学研究非常重视如何正确地进行因果推断和处理效应评估,并在这个领域中发展了各种各样的新方法。最近一些在断点回归和倍差法上的新发展被研究者们广受关注且应用。与此同时,补充分析也越来越多地帮助我们建立对估计结果和识别策略的可信程度。机器学习方法也帮助我们实现对高维数据处理效应估计结果的改善。只有当我们的因果推断更加可信,更加降低对估计模型的假定(例如函数形式等等),对政策评估的可信程度才能有所提高。(转载自NSD高级计量经济学公众号)

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号