0. 参考

论文:https://arxiv.org/pdf/2511.07238

1. 论文总结

本文介绍了一种创新的 OOD 分割方法,通过融合视觉和语言模型(Vision-Language Model, VLM)来提升对未知对象的检测和分割效果。该方法依赖于以下三个核心组件:

- 文本引导的 OOD 分割(Text-Driven OOD Segmentation):结合 CLIP 的视觉和文本编码器与 Mask2Former 的像素解码器和 Transformer 解码器,利用文本嵌入作为查询,指导模型识别和分割 OOD 对象。

- 基于距离的 OOD 提示(Distance-Based OOD Prompts):通过 WordNet 生成与已知类别在语义距离上不同的 OOD 查询,增强模型对未知类别的识别能力。

- OOD 语义增强(OOD Semantic Augmentation):通过自注意力机制调整 OOD 区域的语义特征,提高模型对未知异常的泛化能力。

借助这些组件,该方法在多个公开的 OOD 分割数据集(如 Fishyscapes、Segment-Me-If-You-Can 和 Road Anomaly)上实现了最先进的性能,大幅提升了像素级和目标级评估指标。

2. 解决的问题

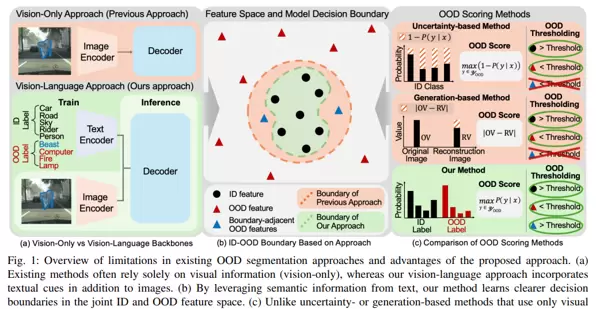

- OOD 对象的检测和分割:现有分割模型在处理未见过的 OOD 对象时,常将其错误分类为已知类别,增加了碰撞风险。

- 视觉信息的局限性:传统 OOD 分割方法主要依赖视觉信息,难以有效应对复杂场景中的 OOD 对象。

- 语义信息的利用不足:尽管视觉语言模型(VLM)在图像-文本对上进行了预训练,但在直接应用于 OOD 分割任务时,仍存在语义信息利用不充分的问题。

3. 属于的研究范畴

- 语义分割(Semantic Segmentation):研究如何在像素级别上对环境元素(如道路、行人、车辆)进行分类。

- 视觉语言模型(Vision-Language Models):利用图像-文本对预训练的模型,结合视觉和语言信息进行分割。

- OOD 检测(Out-of-Distribution Detection):研究如何检测和分割训练时未见过的类别。

4. 达到的效果

- 性能提升:在多个 OOD 分割数据集上,该方法在像素级和目标级评估指标上均达到了最先进的性能。例如,在 Fishyscapes 数据集上,AuPRC(Area under the Precision-Recall Curve)平均提高了 3.87%,FPR95(False Positive Rate at a true positive rate of 95%)有所降低。

- 鲁棒性增强:通过结合文本引导的 OOD 分割、基于距离的 OOD 提示和 OOD 语义增强,该方法在复杂驾驶环境中表现优异,能够有效处理未知对象。

5. 重要的细节

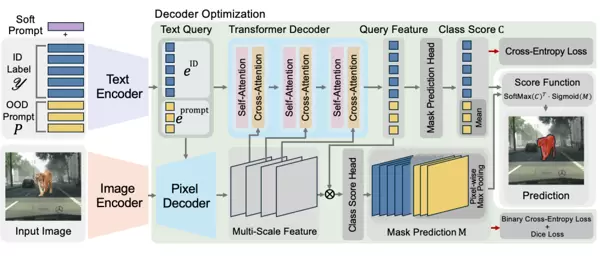

- 文本引导的 OOD 分割:将 CLIP 的视觉和文本编码器与 Mask2Former 的像素解码器和 Transformer 解码器相结合。使用文本嵌入作为查询,指导 Transformer 解码器在掩码级别上隔离异常对象。通过视觉正则化和视觉语言正则化策略,保持预训练的视觉语言对齐,同时适应新数据。

- 基于距离的 OOD 提示:使用 WordNet 生成与已知类别在语义距离上不同的 OOD 查询。将 OOD 查询分为多个组,根据它们与已知类别的语义距离进行学习,增强模型对未知类别的识别能力。

- OOD 语义增强:通过自注意力机制调整 OOD 区域的语义特征,提高模型对未知异常的泛化能力。在模型的不同层中应用语义增强,平衡像素级和目标级的 OOD 分割性能。

通过这些机制,该方法显著提高了 OOD 分割的鲁棒性和泛化能力,为自动驾驶系统中的安全和可靠性提供了有力支持。

6. 怎么做的?

论文《Leveraging Text-Driven Semantic Variation for Robust OOD Segmentation》提出了一种基于文本引导的语义变化来增强自动驾驶场景中鲁棒的 Out-of-Distribution (OOD) 分割的新方法。该方法通过融合视觉和语言模型(Vision-Language Model, VLM)来提升对未知对象的检测和分割效果。以下是该方法的具体实现细节:

- 文本引导的 OOD 分割(Text-Driven OOD Segmentation):

- 架构设计:该方法将 CLIP 的视觉编码器和文本编码器与 Mask2Former 的像素解码器和 Transformer 解码器相结合。这种结合使模型能够同时处理文本和视觉信息,从而更稳健地识别 OOD 对象。

- 文本嵌入作为查询:使用文本嵌入作为查询,指导 Transformer 解码器在掩码级别上隔离异常对象。通过视觉正则化和视觉语言正则化策略,保持预训练的视觉语言对齐,同时适应新数据。

利用文本嵌入作为查询,引导 Transformer 解码器在掩码层级上区分异常对象。此方法通过减少对预训练嵌入空间的影响,系统地提升模型检测、定位和分割 OOD 实例的能力。

正则化策略

为了维持预训练的视觉语言对齐,同时适应新数据,该方法采用视觉正则化和视觉语言正则化策略。这些策略保证了模型在训练期间能够保持丰富语言知识,从而更准确地区分 OOD 对象。

2. 基于距离的 OOD 提示(Distance-Based OOD Prompts)

生成 OOD 标签

使用 WordNet 生成与已知类别在语义距离上有所区别的 OOD 标签。通过计算每个已知类别与候选词汇间的语义距离,挑选出语义上差异较大的词汇作为 OOD 标签。

学习 OOD 提示

将 OOD 标签分成多组,依据它们与已知类别的语义距离进行学习。通过交叉熵损失函数,模型学会提高与同一类别相似性的同时,降低与不同类别的相似性。

3. OOD 语义增强(OOD Semantic Augmentation)

语义增强机制

通过自注意力机制调节 OOD 区域的语义特性,增强模型对未知异常的泛化能力。具体而言,该方法在模型的不同层次中实施语义增强,平衡像素级和目标级的 OOD 分割表现。

噪声注入

通过向 CLS token 的全局信息中添加噪声,调整 OOD 对象的语义特性。这种方式使模型能更有效地泛化至更广范围的 OOD 对象。

4. 实验验证

数据集

在多个公开的 OOD 分割数据集上进行了实验,包括 Fishyscapes、Segment-Me-If-You-Can 和 Road Anomaly。

性能指标

使用像素级和目标级评估指标,如 AuPRC(Precision-Recall 曲线下面积)、FPR95(真阳性率为 95% 时的假阳性率)、IoU(交并比)、AuIoU(IoU 曲线下面积)和 Mean F1 Score。

结果

该方法在所有评估指标上均达到了最先进水平,明显优于现有方法。例如,在 Fishyscapes 数据集上,AuPRC 平均提升了 3.87%,FPR95 有所下降。

5. 总结

通过整合文本驱动的 OOD 分割、基于距离的 OOD 提示和 OOD 语义增强,该方法有效增强了 OOD 分割的稳健性和泛化能力。这些机制使模型能够更高效地应对复杂驾驶环境中的未知对象,从而大幅提升了自动驾驶系统的安全性和可靠性。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号