你常用的主要编程语言是什么?

我常用的主要编程语言是 Python 和 Go,两者在运维开发领域中互相补充,涵盖了从脚本自动化到高性能服务开发的各种需求,也是该领域的主流选择。

从应用场景来看,Python 是我日常运维自动化的关键工具。其丰富的第三方库生态系统(如 Paramiko 用于远程操作、Requests 处理 HTTP 请求、Fabric 实现批量部署、Pandas 处理运维数据统计、Ansible 模块开发支持)使运维脚本开发效率非常高。例如,在编写服务器批量巡检脚本时,可以通过 Paramiko 批量连接目标主机,执行命令收集 CPU、内存、磁盘使用率等指标,再用 Pandas 整理成报表输出,大约 100 行代码即可完成传统运维中需要数小时的手动操作。此外,Python 对运维工具的兼容性非常强,无论是云平台 API(阿里云 SDK、AWS Boto3)、监控系统(Prometheus Client)还是配置管理工具(SaltStack 自定义模块),都有成熟的库支持,能够迅速集成现有的运维体系。

Go 语言则主要用于开发高性能的运维组件,比如日志收集代理、服务发现工具、轻量级网关等。Go 的静态类型特点避免了 Python 等动态语言的运行时错误,编译型语言的性质使其部署时无需依赖解释器,可以直接生成二进制文件,跨平台运行更加便捷。同时,Go 原生支持的 goroutine 和 channel 使得并发编程变得简单,适用于处理高并发场景(如每秒万级的日志收集、多节点并行健康检查)。例如,在开发日志收集代理时,可以为每个日志文件启动独立的采集协程,通过 channel 汇总数据,再批量发送到 Elasticsearch,相比 Python 的多线程方案,内存占用更低、并发处理能力更强,且不会遇到 GIL(全局解释器锁)导致的性能瓶颈。此外,Go 的标准库功能强大,net/http 包可以快速构建 HTTP 服务(如运维接口网关),encoding/json 处理配置文件和数据序列化非常高效,适合开发需要长期稳定运行的后台服务。

在技术选择上,我会根据具体场景灵活切换:对于简单的自动化脚本、数据处理、工具适配,优先使用 Python;对于需要高性能、高并发、独立部署的运维组件,则选择 Go。两者的协作不仅确保了快速迭代(Python),还能兼顾核心组件的稳定性和性能(Go)。

面试加分点:能结合具体的运维场景说明语言选择的逻辑,而不是单纯列举语言特性;提到对语言生态系统的深入使用(如 Python 自定义 Ansible 模块、Go 开发 Prometheus Exporter);说明两种语言的互补性,展示技术选择的合理性。

记忆法:场景-特性对应记忆法——将语言特性与运维场景关联,例如“Python 库丰富→脚本自动化”“Go 并发能力强→高性能组件”,通过场景联想法记住核心优势,避免孤立记忆特性;关键词提炼记忆法——Python 记“高效、生态全面、适配广泛”,Go 记“高性能、并发容易、部署简便”,快速把握核心差异。

Go 语言的 goroutine(协程)你了解吗?

我对 goroutine 有深刻的理解,它是 Go 语言实现并发的核心机制,也是 Go 与其他语言区别的关键特性之一,其设计目的是提供轻量级、高效的并发执行单元,使开发者能够轻松编写高并发程序。

首先,goroutine 的实质是用户态的轻量级线程,由 Go 运行时(runtime)而不是操作系统内核调度,这是它与操作系统线程(OS Thread)的主要区别。从资源占用的角度看,一个 goroutine 的初始栈大小仅为 2KB(可动态扩展至 GB 级别),而操作系统线程的栈大小通常为 1-8MB,因此一台机器上可以同时运行数十万个甚至上百万个 goroutine,而操作系统线程的数量通常只能达到数千个,这使得 Go 能够高效处理高并发场景(如高并发 Web 服务、大量任务处理)。

其次,goroutine 的调度机制基于 Go 运行时的 M:N 调度模式——将 M 个 goroutine 分配给 N 个操作系统线程运行。这里,M 表示活跃的 goroutine 数量,N 表示操作系统线程数量(通常等于 CPU 核心数,可通过 GOMAXPROCS 环境变量设置)。在调度过程中,runtime 利用“工作窃取”策略(Work-Stealing)均衡各线程的工作负荷:如果一个线程(M)上的所有 goroutine 都被阻塞(如等待 I/O、休眠、通道操作),该线程将从其他忙碌的线程那里“窃取”goroutine 来执行,防止 CPU 资源浪费。此外,自 Go 1.14+ 版本开始,goroutine 支持“协作式抢占”,当一个 goroutine 运行时间过长(超过 10ms),runtime 会自动触发抢占,暂停该 goroutine 并切换至其他 goroutine,解决了早期版本中“长时间任务占用线程”的问题。

goroutine 的创建方法极其简单,只需在函数调用前加上

gofunc task() {

fmt.Println("goroutine 执行任务")

}

func main() {

go task() // 创建并启动一个 goroutine

time.Sleep(100 * time.Millisecond) // 等待 goroutine 执行完成

}func task(id int, wg *sync.WaitGroup) {

defer wg.Done() // 任务完成后通知 WaitGroup

fmt.Printf("goroutine %d 执行完成\n", id)

}

func main() {

var wg sync.WaitGroup

for i := 0; i < 5; i++ {

wg.Add(1) // 增加等待的 goroutine 数量

go task(i, &wg)

}

wg.Wait() // 等待所有 goroutine 完成

fmt.Println("所有任务执行完毕")

}make(chan int)make(chan int, 5)func producer(ch chan<- int) {

for i := 0; i < 5; i++ {

ch <- i // 向通道发送数据

}

close(ch) // 关闭通道

}

func consumer(ch <-chan int) {

for num := range ch { // 从通道接收数据,直到通道关闭

fmt.Printf("收到数据:%d\n", num)

}

}

func main() {

ch := make(chan int, 2)

go producer(ch)

go consumer(ch)

time.Sleep(100 * time.Millisecond)

}面试加分点:能够详细解释 M:N 调度模式和工作窃取算法;结合实际情况讨论 goroutine 泄漏的原因及其解决办法;比较 goroutine 与操作系统线程、Python 线程/协程的不同之处;熟练运用 channel、sync 包等工具实现 goroutine 的同步通信。

记忆法:层次记忆法——从“实质(用户态轻量级线程)→ 主要特性(低资源消耗、M:N 调度、协作式抢占)→ 使用方法(go 关键字、同步工具、通道通信)→ 注意事项(泄漏、平滑退出)”分层整理,逻辑清晰且不易遗漏;关键词联想记忆法——用“轻、快、多”概括 goroutine 的优点(轻量级、调度迅速、高并发能力),用“M:N、工作窃取”关联调度机制,用“通道通信、WaitGroup 同步”关联应用场景。

Python 语法考察:元组和列表的区别及性能对比;Python 的浅拷贝和深拷贝有何不同?

一、元组(tuple)和列表(list)的区别及性能对比

元组和列表是 Python 中最常用的两种序列类型,主要区别在于可变性、应用场景、语法特点,性能差异也由此而来。

| 对比维度 | 元组(tuple) | 列表(list) |

|---|---|---|

| 可变性 | 不可变(immutable):创建后无法修改、增加或删除元素,仅支持查询 | 可变(mutable):支持增删改查(如 append、extend、pop、remove 等方法) |

| 语法表示 | 用圆括号

|

用方括号

|

| 内置方法 | 方法较少,主要支持查询操作(如 count() 计算元素出现次数、index() 查找元素索引),没有修改方法 | 方法较多,涵盖增删改查各类操作(如 append() 在末尾添加、insert() 插入、sort() 排序、reverse() 反转) |

| 元素类型 | 可以包含多种类型元素(如 (1, "a", True)),支持嵌套(如 (1, [2, 3], (4,5))) | 同样支持多种类型元素和嵌套(如 [1, "a", (2,3)]) |

| 哈希性 | 当所有元素均为不可变类型时,元组可哈希(可用作字典的 key、集合的元素) | 由于列表可变,不支持哈希 |

无论元素是否可变,列表均不可哈希(不能作为字典 key 或集合元素)

使用场景

存储固定不变的数据(如配置项、坐标、函数返回多值);需要哈希特性的场景(如字典 key);作为函数参数确保数据不被更改

存储动态变化的数据(如任务列表、用户输入集合);需要频繁增删改的场景(如数据处理中的临时集合)

2. 性能对比

元组的性能总体优于列表,主要原因是其不可变性带来的底层优化:

创建速度

:元组创建更快。因为列表是可变的,Python 需为其预留更多内存空间以应对后续修改;而元组不可变,内存分配更紧凑,无需额外预留空间。通过

timeit测试可明显看出差异:

import timeit

# 列表创建时间

list_time = timeit.timeit('[1, 2, 3, 4, 5]', number=1000000)

# 元组创建时间

tuple_time = timeit.timeit('(1, 2, 3, 4, 5)', number=1000000)

print(f"列表创建时间:{list_time:.4f}s") # 约 0.05s

print(f"元组创建时间:{tuple_time:.4f}s") # 约 0.01s访问速度

:元组访问元素更快。由于元组内存布局固定,元素地址可通过偏移量直接计算,访问时无需额外的边界检查和动态调整;而列表的可变特性导致内存布局可能变化,访问时需更多底层操作。测试代码:

import timeit

list_obj = [1, 2, 3, 4, 5]

tuple_obj = (1, 2, 3, 4, 5)

list_access = timeit.timeit('list_obj[3]', globals=globals(), number=10000000)

tuple_access = timeit.timeit('tuple_obj[3]', globals=globals(), number=10000000)

print(f"列表访问时间:{list_access:.4f}s") # 约 0.12s

print(f"元组访问时间:{tuple_access:.4f}s") # 约 0.10s内存占用

:元组内存占用更小。同样存储相同元素,元组的内存消耗低于列表。例如:

import sys

print(sys.getsizeof([1, 2, 3])) # 列表占用 64 字节

print(sys.getsizeof((1, 2, 3))) # 元组占用 48 字节需要注意的是,性能差异在数据量较小时不明显,只有当数据量较大或操作频繁时(如百万级元素的创建、循环访问),差异才会显著。实际开发中,应优先根据“是否需要修改数据”选择类型,而非单纯追求性能。

二、Python 的浅拷贝(Shallow Copy)和深拷贝(Deep Copy)的区别

浅拷贝和深拷贝是 Python 中用于复制对象的两种机制,核心区别在于是否复制对象的嵌套结构(即是否递归复制子对象),适用场景和内存开销也因此不同。

1. 核心概念与区别

浅拷贝:仅复制对象本身(如列表、字典等容器),但不复制对象内部的嵌套子对象,而是引用原对象的子对象。也就是说,浅拷贝后的对象与原对象是独立的,但它们的子对象共享同一内存地址,修改其中一个的子对象会影响另一个。

深拷贝:不仅复制对象本身,还会递归复制对象内部的所有嵌套子对象,形成一个完全独立的新对象。新对象与原对象及其子对象均无内存共享,修改任何一方都不会影响另一方。

2. 实现方式

| 拷贝类型 | 常用实现方式 | 适用对象 |

|---|---|---|

| 浅拷贝 | 1. 切片操作:(列表);2. 构造函数: 、 ;3. 模块的 函数: |

列表、字典、元组(元组不可变,浅拷贝仅返回自身引用)等容器对象 |

| 深拷贝 | 仅模块的 函数: |

包含嵌套结构的容器对象(如列表套列表、字典套字典) |

3. 代码示例与效果验证

(1)浅拷贝示例

import copy

# 原对象包含嵌套列表(子对象)

old_list = [1, 2, [3, 4]]

# 浅拷贝

new_list = copy.copy(old_list)

# 修改新对象的非嵌套元素(不会影响原对象)

new_list[0] = 100

print(old_list) # 输出 [1, 2, [3, 4]](原对象无变化)

print(new_list) # 输出 [100, 2, [3, 4]]

# 修改新对象的嵌套子对象(会影响原对象,因为子对象共享)

new_list[2][0] = 300

print(old_list) # 输出 [1, 2, [300, 4]](原对象的子对象被修改)

print(new_list) # 输出 [100, 2, [300, 4]](2)深拷贝示例

import copy

old_list = [1, 2, [3, 4]]

# 深拷贝

new_list = copy.deepcopy(old_list)

# 修改新对象的非嵌套元素(无影响)

new_list[0] = 100

print(old_list) # 输出 [1, 2, [3, 4]]

print(new_list) # 输出 [100, 2, [3, 4]]

# 修改新对象的嵌套子对象(无影响,因为子对象已被递归复制)

new_list[2][0] = 300

print(old_list) # 输出 [1, 2, [3, 4]](原对象无变化)

print(new_list) # 输出 [100, 2, [300, 4]]4. 特殊情况说明

对于不可变对象(如元组、字符串、整数),无论浅拷贝还是深拷贝,都不会创建新对象,仅返回原对象的引用。因为不可变对象无法修改,复制没有实际意义,Python 会进行优化以节省内存。例如:

import copy

old_tuple = (1, 2, 3)

shallow_copy = copy.copy(old_tuple)

deep_copy = copy.deepcopy(old_tuple)

print(old_tuple is shallow_copy) # 输出 True(同一对象)

print(old_tuple is deep_copy) # 输出 True(同一对象)对于无嵌套结构的可变对象(如仅包含整数、字符串的列表),浅拷贝和深拷贝的效果一致,都会创建新的容器对象,但由于没有子对象,不存在共享问题。例如:

import copy

old_list = [1, 2, 3]

shallow_copy = copy.copy(old_list)

deep_copy = copy.deepcopy(old_list)

shallow_copy[0] = 100

print(old_list) # 输出 [1, 2, 3]

print(shallow_copy) # 输出 [100, 2, 3]

deep_copy[0] = 200

print(old_list) # 输出 [1, 2, 3]

print(deep_copy) # 输出 [200, 2, 3]5. 适用场景与注意事项

浅拷贝:适用于无嵌套结构的可变对象,或不需要修改嵌套子对象的场景。优点是速度快、内存开销小;缺点是可能因共享子对象导致意外修改。

深拷贝:适用于包含嵌套结构且需要完全独立的对象,或需要修改子对象而不影响原对象的场景。优点是隔离性强,不会产生副作用;缺点是速度慢、内存开销大(需递归复制所有子对象),且对于包含循环引用的对象(如

a = [1]; a.append(a)),深拷贝会无限递归,需通过

copy.deepcopy的

memo参数手动处理。

面试加分点

:能结合底层原理解释性能差异(如元组不可变带来的内存优化);举例说明浅拷贝/深拷贝的实际应用场景(如配置文件复制、数据处理中的数据隔离);指出特殊情况(如不可变对象的拷贝、循环引用的深拷贝处理);通过代码示例直观验证区别,体现实操能力。

记忆法

对比记忆法——将元组/列表、浅拷贝/深拷贝分别制作对比表格,聚焦核心差异点(如“元组不可变、列表可变”“浅拷贝不复制子对象、深拷贝复制子对象”),通过对比强化记忆;场景联想记忆法——用“配置文件(固定数据→元组)”“任务列表(动态修改→列表)”联想类型选择,用“简单数据复制(无嵌套→浅拷贝)”“复杂数据隔离(有嵌套→深拷贝)”联想拷贝方式,让记忆更贴合实际使用。

docker-compose 是 Docker 官方推出的一款多容器应用编排工具,旨在“简化多容器协同管理”。其主要目的是解决单容器运行无法满足复杂应用需求(例如,一个 Web 应用可能需要依赖数据库、缓存、消息队列等多种服务)的问题,使开发者和运维人员能够通过一个统一的配置文件来定义、启动、停止、管理整个应用的所有容器,从而减少手动执行大量命令的麻烦。

docker run其设计理念可以总结为“配置即代码”和“声明式编排”:

- 配置集中化:通过单一的 YAML 配置文件(默认

),集中定义应用所需的所有服务(容器)、网络、数据卷、环境变量、依赖关系等。配置文件采用声明式,只需描述“应用应具备哪些特性”(如服务镜像、端口映射、依赖的服务),无需编写复杂的脚本来说明“如何启动应用”,这样简化了多容器管理的难度。docker-compose.yml - 服务协同自动化:自动处理容器间的依赖顺序(如首先启动数据库服务,然后启动依赖数据库的 Web 服务)、网络连接(默认创建独立的桥接网络,使得所有服务可以在同一网络内通过服务名称访问)、数据卷挂载等细节。用户只需执行

一条命令,即可根据配置自动拉取镜像、创建网络和数据卷、启动所有服务,无需手动协调各容器的启动顺序和网络设置。docker-compose up - 环境一致性:配置文件可以纳入版本控制系统(如 Git),确保开发、测试、生产环境使用相同的配置,防止因环境配置差异引起的“运行不一致”问题。同时支持通过

文件注入环境变量,实现不同环境(如开发、测试)的配置分离,无需更改核心.env

文件。docker-compose.yml - 生命周期统一管理:提供一套全面的命令行工具,支持对整个应用的所有服务进行统一的生命周期管理,比如启动(

)、停止(up

)、重启(down

)、查看日志(restart

)、进入容器(logs

)等操作,无需逐一操作单个容器,提高运维效率。exec

docker-compose 的核心模块

docker-compose 的体系结构围绕“配置解析-服务调度-生命周期管理”构建,核心模块大致分为以下几个部分,各模块协作完成多容器的编排与管理:

| 核心模块 | 功能说明 | 关键细节 |

|---|---|---|

| 配置解析模块 | 负责读取和解析 |

支持 YAML 语法规则,兼容 Docker 官方的容器配置参数(如 |

| 服务管理模块 | 核心业务模块,负责服务的创建、启动、停止、重启、删除等生命周期操作,以及容器间依赖顺序的协调 | 处理服务依赖:通过 |

| 网络管理模块 | 负责创建和管理应用专用的网络,实现容器间的网络隔离与通讯 | 默认创建名为 |

| 数据卷管理模块 | 负责创建和管理数据卷(Volume),实现容器数据的持久化存储,以及容器与主机、容器间的数据共享 | 支持三种数据挂载方式:主机目录挂载( |

| 日志与监控模块 | 负责收集所有服务容器的日志,提供统一的日志查看接口,同时监控容器的运行状态(CPU、内存、网络等) | 支持通过 |

| 命令行交互模块 | 提供命令行接口(CLI),接收用户输入的命令(如 |

支持丰富的命令参数:如 |

三、docker-compose 是否支持横向扩展?

docker-compose 具备一定的横向扩展能力,不过它并非专为大型生产环境的弹性扩展而设计,其扩展功能主要适用于开发、测试环境或是小型生产环境的简易扩展。

具体而言,横向扩展是通过

docker-compose up --scale 服务名=实例数命令来实现的,即为特定服务生成多个容器实例。比如,现有

web服务关联着 1 个容器实例,执行

docker-compose up -d --scale web=3之后,将生成 3 个

web服务的容器实例,所有实例共享同一网络和数据卷(若需独立数据则需特别设置)。

然而,这种方式有显著的限制,这使得它不适用于大型生产环境:

- 缺少负载均衡功能:docker-compose 只能创建多个容器实例,但不会自动提供负载均衡。多个

web8081:808082:80--scaledocker-compose.yml因此,docker-compose 的横向扩展仅适合以下情况:开发环境中模拟多实例部署、测试环境中进行并发压力测试、小型生产环境中临时增加实例以应对短暂的流量高峰(需配合手动配置负载均衡)。对于大规模、高可用、需要弹性伸缩的生产环境,则应选择 Kubernetes(K8s)等更为先进的容器编排平台。

面试加分项:能够结合实际应用场景阐述 docker-compose 的设计优点(如开发环境的快速搭建、多环境配置隔离);深入解析关键模块之间的协作机制(如配置解析后如何驱动服务启动);清晰区分 docker-compose 与 K8s 在扩展能力上的差异,展现技术选型的能力;提供具体的扩展命令和配置示例(如

--scale的用法、负载均衡的搭配策略)。

记忆技巧:模块-功能对应记忆法——将每个核心模块与其主要功能相联系(如“配置解析模块→读取 YAML 配置”、“网络管理模块→创建桥接网络”),通过“模块名称+功能”的组合加强记忆;场景联想记忆法——用“开发环境构建微服务(需要多容器协同→docker-compose 配置集中化)”、“测试环境扩展并发(需要多实例→--scale 命令)”联想设计思路和扩展能力,使记忆更加贴近实际应用场景。

请介绍 Mesos 的相关概念、核心功能及适用场景?

一、Mesos 的核心概念

Mesos 是一个开源的分布式资源调度平台,起源于加州大学伯克利分校的 AMPLab,其核心定位是“数据中心的操作系统”,负责抽象和调度集群内所有节点的计算资源(如 CPU、内存、磁盘、网络等),向上层应用(如容器、大数据框架、分布式服务)提供统一的资源管理和调度能力。要理解其核心概念,需从“架构组件”和“核心抽象”两个角度入手:

| 概念类型 | 具体概念 | 详细说明 |

|---|---|---|

| 架构核心组件 | Mesos Master | 集群的控制中心,负责全局资源调度、节点管理、任务编排和高可用保障。默认支持主从复制(通过 ZooKeeper 实现领导选举和状态同步),防止单点故障;包括调度器(Allocator)、框架注册器、状态管理器等核心模块。 |

| Mesos Slave(Agent) | 集群的工作单元,部署在每台服务器上,负责向 Master 报告节点资源状态(如剩余 CPU、内存等),接受 Master 分配的任务,启动和管理任务执行实例(如容器、进程);包含执行器(Executor)、资源隔离模块(如 cgroups)、容器运行环境(支持 Docker、Mesos 内置容器)等。 | |

| Framework(框架) | 运行在 Mesos 之上的应用层软件,是 Mesos 调度的目标,需要实现 Mesos 规定的调度器(Scheduler)和执行器(Executor)接口。框架分为两种:一种是持续运行的服务框架(如 Marathon 用于部署容器化服务、Kafka 集群),另一种是短期运行的批处理框架(如 Spark、Hadoop MapReduce 用于大数据处理)。 | |

| ZooKeeper | 为 Mesos 提供高可用支持,负责 Master 节点的领导选举(当 Active Master 出现故障时,从 Standby Master 中选出新的 Active Master)、集群节点信息存储(如 Slave 节点列表、Framework 注册信息)、状态同步(确保 Master 集群数据一致性)。 | |

| 核心抽象 | Resource(资源) |

集群中可调度的计算资源,以“资源提案”的形式存在,包含 CPU(以核为单位)、内存(以 MB/GB 为单位)、磁盘(以 GB 为单位)、网络带宽(以 Mbps 为单位)等。主节点会依据从节点的资源使用状况,生成资源提案并发送给框架。

任务(Task)

框架提交给 Mesos 执行的最小工作单元,是资源调度的具体体现。一个任务对应一个运行在从节点上的实例(如一个 Docker 容器、一个 Spark 计算任务),包含任务名称、所需资源、执行命令、运行环境等信息。

执行器(Executor)

运行在从节点上的进程,负责启动和管理任务的生命周期(如创建进程、容器,监控任务运行状态,收集日志和指标)。Mesos 提供默认执行器(用于运行非容器化任务),框架也可自定义执行器(如 Marathon 自定义执行器用于管理 Docker 容器)。

资源提案(Offer)

主节点向框架发送的资源提议,包含当前从节点的空闲资源信息(如 2 核 CPU、4GB 内存)、节点 ID、端口范围等。框架的调度器接收资源提案后,可根据自身任务需求选择接受或拒绝:接受则提交任务到该节点,拒绝则资源提案会被回收并重新分发给其他框架。

二、Mesos 的核心功能

Mesos 的核心价值在于“统一资源调度”和“跨框架协作”,其核心功能围绕这一价值展开,具体包括:

集群资源抽象与统一调度:

这是 Mesos 最关键的功能。Mesos 会将集群中所有从节点的 CPU、内存、磁盘等资源抽象为统一的“资源池”,打破单节点的资源障碍,实现资源的全局调度。调度器采用“双层调度”模式:第一层是 Mesos 主节点的资源分配器,负责将资源以提案的形式分发给框架;第二层是框架自身的调度器,负责根据业务需求(如任务优先级、数据本地化)选择合适的资源提案并提交任务。这种模式既确保了资源的全局优化分配,又赋予了框架灵活的调度自主权。支持多种资源分配策略,如默认的 DRF(Dominant Resource Fairness,主导资源公平)策略,确保不同框架按比例公平共享资源;也支持自定义分配策略(如基于优先级、队列的调度),适配不同业务场景。

多框架协作与资源隔离:

Mesos 支持同时运行多个不同类型的框架(如 Marathon 部署服务、Spark 运行计算任务、Hadoop 处理数据),框架间通过资源提案机制实现资源的动态共享,避免资源浪费。例如,白天 Spark 框架的计算任务较少,空闲资源可自动分配给 Marathon 部署的 Web 服务;夜间 Web 服务流量减少,资源又可回收给 Spark 执行批量计算。同时,Mesos 基于 Linux Cgroups、Namespaces 等技术实现严格的资源隔离,确保不同框架的任务不会相互抢占资源(如一个框架的任务不会耗尽节点的 CPU 导致其他框架的任务卡顿),支持对 CPU、内存、磁盘 I/O、网络带宽等资源进行精细限制。

高可用与故障自愈:

Mesos 集群通过主节点主从复制(配合 ZooKeeper)实现高可用,默认支持多个备用主节点,当活动主节点故障时,ZooKeeper 会迅速选举新的活动主节点,整个过程对框架和任务透明,不会导致集群中断。从节点故障时,主节点会检测到节点离线,自动将该节点上的任务标记为失败,并重新调度这些任务到其他健康的从节点;框架也可通过执行器监控任务状态,当任务异常退出时,自动重启或重新提交任务,实现故障自愈。

容器化支持与多运行时兼容:

Mesos 原生支持容器化部署,兼容 Docker、Mesos 原生容器(UCR,Universal Container Runtime)等多种容器运行时,可直接调度和管理 Docker 容器。通过与 Marathon 等框架配合,可实现容器的自动化部署、扩容、滚动更新、回滚等功能,满足微服务的部署需求。同时,Mesos 不仅支持容器化任务,还支持非容器化任务(如直接运行进程、虚拟机),兼容传统应用和新型云原生应用,降低迁移成本。

可扩展性与定制化

Mesos 采用了模块化架构设计,关键模块(如调度器、资源分配器、执行器)支持插件化扩展,开发人员可以依据业务需求定制模块(如定制资源分配策略、定制 Executor 以适应特定任务)。Mesos 的 API 设计开放,支持多种编程语言(Java、Python、Go 等)开发框架或集成现有系统,同时提供了丰富的监控指标(如资源使用率、Task 执行状态、框架运行状况),能够与 Prometheus、Grafana 等监控工具集成,实现集群状态的可视化监控。

三、Mesos 的适用场景

Mesos 适合作为“混合负载集群”的资源调度核心,特别适用于需要统一管理多种类型工作负载、优化集群资源利用效率的场景,具体包括:

- 大数据平台统一资源调度:这是 Mesos 最典型的应用场景。在大数据集群中,通常同时运行多种计算框架(Spark、Hadoop MapReduce、Flink 等)和存储框架(HDFS、HBase 等),传统模式下各框架独立占用资源,造成资源利用效率低下(如 Spark 任务空闲时,Hadoop 资源无法复用)。Mesos 可将这些框架整合到同一集群,通过统一资源池实现资源动态共享,提升集群资源利用效率(通常可从 30%-40% 提升至 70%-80%),同时简化集群的运维管理(无需为不同框架单独部署集群)。

- 混合云/多环境应用部署:适用于需要同时运行传统应用(非容器化)和云原生应用(容器化)的场景。Mesos 兼容多种运行时,可统一管理物理机、虚拟机、容器中的应用,实现“一套集群,多种负载”,减少跨环境部署的复杂度。例如,企业可在 Mesos 集群中同时部署传统的 Java Web 应用(运行在虚拟机中)、容器化的微服务(通过 Marathon 部署)、大数据计算任务(Spark 框架),避免维护多个独立集群的成本。

- 大规模微服务编排(早期场景):在 Kubernetes 成为主流之前,Mesos 配合 Marathon 是微服务编排的重要方案之一,支持微服务的自动化部署、扩容、滚动更新、健康检查等功能。尽管目前 Kubernetes 已成为微服务编排的首选,但在一些现有的 Mesos 集群中,仍有大量微服务运行,特别适合对资源利用效率要求极高、需要与大数据框架协同的微服务场景。

- 批处理与服务型负载混合部署:适用于需要同时运行长期服务(如 Web 服务、数据库、缓存)和短期批处理任务(如数据ETL、报表生成、模型训练)的场景。Mesos 可动态调配资源,当批处理任务需要资源时,从空闲的服务型负载中临时分配资源;批处理任务完成后,资源自动回收,确保服务型负载的稳定性,同时提高资源利用效率。例如,电商平台可在白天通过 Mesos 为 Web 服务、支付服务分配充足资源,夜间流量低谷时,调度资源运行数据统计和报表生成任务。

需要注意的是,Mesos 的劣势在于架构较为复杂,运维成本较高,且在微服务编排场景中,其生态系统完善度和社区活跃度已不及 Kubernetes。因此,当前新搭建的集群若以微服务为核心,更建议选择 Kubernetes;但如果是现有的大数据集群、混合负载集群,或需要与大数据框架深入协同,Mesos 仍然是合适的选择。

面试加分点

能清晰解释 Mesos 的“两级调度”模式原理,体现对核心架构的理解;对比 Mesos 与 Kubernetes 的区别(如 Mesos 侧重资源调度,K8s 侧重应用编排),体现技术选型判断力;结合具体场景(如大数据集群资源优化)说明 Mesos 的价值,而非仅仅列举功能;提及 Mesos 的生态系统组件(如 Marathon、Chronos),体现实际使用经验。

记忆法

概念-功能-场景串联记忆法——将核心概念(如 Master、Slave、Framework)与核心功能(如统一调度、资源隔离)关联,再将功能与适用场景(如大数据平台、混合负载)串联,形成“概念→功能→场景”的逻辑链,避免孤立记忆;关键词提炼记忆法——用“统一调度、多框架协同、高可用、兼容多运行时”概括核心功能,用“大数据集群、混合负载、批处理+服务混合”概括适用场景,迅速抓住核心要点。

你对微服务的理解是什么?

我对微服务的理解是:微服务是一种架构设计风格,核心是将一个复杂的单体应用拆分为多个小型、独立部署、松耦合的服务,每个服务专注于单一的业务领域(如用户服务、订单服务、支付服务),通过轻量级的通信协议(如 HTTP/REST、gRPC)协同工作,共同完成整个应用的业务功能。其核心目标是解决单体应用在规模扩大后出现的“开发效率低、部署风险高、技术栈锁定、扩展性差”等问题,实现“敏捷开发、独立部署、弹性伸缩、技术异构”。

微服务并非“越小越好”,而是以“业务边界”为拆分依据,其核心特性可从以下几个方面展开:

- 单一职责与业务边界明确

每个微服务仅专注于一个具体的业务领域(如订单服务仅处理订单的创建、查询、修改、取消等操作,不涉及用户管理或支付流程),遵循“高内聚、低耦合”的设计原则。业务边界通常通过“领域驱动设计(DDD)”中的“限界上下文”来界定,确保服务内部逻辑紧密相连,服务之间的依赖最小化。例如,电商平台中,“用户管理”“订单处理”“商品库存”“支付结算”分别作为独立的微服务,每个服务的接口和数据模型仅围绕其自身的业务设计,不暴露内部实现细节。

独立部署与生命周期自治:每个微服务都是一个独立的部署单元,拥有自己的代码库、构建流程、部署管道,可以独立于其他服务进行开发、测试、部署和升级。例如,订单服务需要修复一个 Bug 或添加新功能时,开发团队可以单独修改代码、进行单元测试和集成测试,然后部署到生产环境,无需同步其他服务(如用户服务、商品服务)的部署,降低了部署风险和上线成本。同时,服务的生命周期由所属团队自主管理,团队可以根据业务需求选择合适的部署策略(如滚动更新、蓝绿部署、金丝雀发布),实现快速迭代。

松耦合与轻量级通信:微服务之间通过标准化的接口(如 REST API、gRPC 接口)进行通信,接口定义明确且稳定,服务内部的实现细节(如编程语言、数据库选型、框架)对其他服务透明,实现“接口耦合、实现解耦”。通信协议通常选择轻量级、跨平台的协议:REST API 基于 HTTP/HTTPS,简单易用、兼容性强,适合跨语言、跨系统的通信;gRPC 基于 HTTP/2 和 Protocol Buffers,性能更高、支持双向流式通信,适合服务间高频次、大数据量的交互。例如,订单服务创建订单后,通过调用支付服务的 REST API 发起支付请求,支付服务处理完成后返回结果,订单服务无需关注支付服务的内部实现(如使用哪种支付渠道、如何处理支付回调)。

数据去中心化与独立存储:每个微服务拥有自己独立的数据库(或数据存储),不与其他服务共享数据库,实现“数据自治”。这种设计避免了单体应用中“共享数据库”导致的耦合(如多个模块修改同一数据表结构时的冲突),同时使服务能够根据自身业务特点选择合适的数据库类型(如关系型数据库 MySQL 用于用户服务、非关系型数据库 MongoDB 用于商品评论服务、缓存 Redis 用于购物车服务)。例如,用户服务使用 MySQL 存储用户基本信息和权限数据,订单服务使用 MySQL 存储订单数据,商品服务使用 MongoDB 存储商品详情(如富文本描述、图片链接),各服务通过接口交互数据,而不是直接操作对方的数据库。

弹性伸缩与高可用:微服务的独立部署特性使其支持精细的弹性伸缩——可以根据单个服务的负载情况(如 CPU 使用率、请求量)动态调整实例数量,无需对整个应用进行扩展。例如,电商平台的订单服务在促销活动期间流量激增,可以单独为订单服务增加实例数,而用户服务、商品服务流量平稳则保持原有实例数,提高资源利用率。同时,微服务架构通过“故障隔离”实现高可用:单个服务的故障(如订单服务实例崩溃)不会影响其他服务的正常运行(如用户仍可浏览商品、加入购物车),通过服务注册与发现、熔断、降级、限流等机制,可以快速恢复故障服务,减少故障对整体应用的影响。

技术异构与团队自治:微服务架构允许不同的服务选择不同的技术栈(编程语言、框架、数据库),只要遵循统一的接口标准即可。例如,用户服务使用 Java + Spring Boot 开发,订单服务使用 Go + Gin 开发,支付服务使用 Python + FastAPI 开发,团队可以根据业务需求、技术积累、性能要求选择最适宜的技术栈,避免单体应用中“技术栈锁定”的问题。同时,技术异构通常与“团队自治”配套:每个服务由一个独立的小团队(如 2-5 人)负责,团队对服务的全生命周期(开发、测试、运维、优化)负责,遵循“康威定律”(组织架构决定系统架构),提高团队协作效率和响应速度。

微服务架构并非万能,也存在明显的挑战:一是分布式系统的复杂性,服务间通信需要处理网络延迟、超时、重试、数据一致性等问题;二是运维成本增加,需要管理大量独立部署的服务、数据库、监控指标;三是接口版本管理难度大,服务迭代过程中需确保接口的向后兼容;四是数据一致性保障复杂,跨服务的业务流程(如“创建订单→扣减库存→发起支付”)需要通过分布式事务(如 Saga 模式、TCC 模式)或最终一致性方案解决。

因此,微服务架构更适合规模较大、业务复杂、团队分散、需要快速迭代的应用(如电商平台、金融科技系统、大型 SaaS 产品);对于小型应用、业务逻辑简单、团队规模小的场景,单体应用可能更简洁高效,无需盲目追求微服务。

面试加分点

能结合 DDD 等设计策略解释微服务划分准则,展示架构设计技能;公正评估微服务的优点与难题,避免片面强调好处;提及微服务相关技术组件(如注册中心、配置中心、网关、监控系统),反映实践经验;结合具体业务情境(如电商订单流程)阐述微服务的协作逻辑,使理解更加直观。

记忆法

核心特点简记法——采用“单一职责、独立部署、松散耦合、数据自主、灵活扩展、技术多样”六个关键词概述微服务的关键属性,每个关键词代表一个核心设计理念,有助于快速记忆;场景对比记忆法——通过“单体应用的问题(开发效率低、部署复杂、扩展性差)”与“微服务的优势(迭代迅速、部署灵活、扩展性强)”对比,加深对微服务价值的理解,同时记住适用范围的界限。

Spring Cloud 体系包含哪些主要组件?各组件的主要功能是什么?

Spring Cloud 是基于 Spring Boot 的微服务开发工具包,提供了一整套微服务架构解决方案,覆盖服务注册发现、配置管理、负载均衡、熔断降级、API 网关、分布式事务等核心领域,其核心组件围绕“微服务协调”和“分布式问题解决”构建,各个组件协同工作,

Linux 中你常使用的命令有哪些?请举例说明其应用场景?

Linux 命令是运维开发的基础,日常使用围绕“系统监控、文件操作、进程管理、网络故障排除、日志分析”五大核心场景,以下是经常使用的命令及其具体应用场景,每个命令都结合实际运维需求说明,避免简单列举语法:

一、系统监控类命令

此类命令用于实时了解服务器资源状况,是诊断性能问题、确保系统稳定的必要工具。

top

:动态显示系统 CPU、内存、进程负载,默认每 3 秒更新一次。使用场景:当服务器响应迟缓时,快速识别高负载进程。例如,通过

top发现

java进程 CPU 占用率达到 100%,可以按

P键按 CPU 排序,确定是否由程序死循环引起;按

M键按内存排序,检查是否存在进程内存泄露(如某个进程的 RES 内存不断增长)。结合参数

top -p 进程ID可以专注于单个进程监控,适合追踪特定应用的资源消耗。

free

:查看系统内存使用情况,重点在于可用内存(available)和缓存占用。使用场景:判断服务器是否内存不足。例如,

free -h以易于阅读的格式显示,如果 available 内存只剩下几十 MB,而缓存(buff/cache)占用过高,可以通过

sync && echo 3 > /proc/sys/vm/drop_caches释放缓存(仅暂时有效);如果释放后仍然内存紧张,需要考虑扩展内存或优化内存泄露的应用。

df/du

:df 查看磁盘分区使用率,du 统计目录/文件占用的磁盘空间。使用场景:解决磁盘满报警。例如,

df -h发现

/var分区使用率达到 95%,通过

du -sh /var/*逐层检查,定位到

/var/log目录占用 20GB,再通过

ls -lh /var/log | sort -rh找到最大的日志文件(如

messages),结合日志轮转设置或手动清除(

> 文件名清空)释放空间。

iostat

:监控磁盘 IO 性能,包括 IO 使用率(%util)、读写速度(tps、kB_read/s、kB_wrtn/s)。使用场景:当数据库服务器读写缓慢时,检查磁盘 IO 瓶颈。例如,

iostat -x 1 5(每秒输出一次,共 5 次),如果 %util 接近 100% 且 await(IO 响应时间)超过 20ms,表明磁盘 IO 已饱和,需要优化 SQL 语句减少磁盘读写,或升级磁盘(如将机械硬盘更换为 SSD)。

二、文件操作类命令

文件操作是日常运维中最常见的活动,重点在于“高效查找、批量处理、权限管理”。

find

:根据名称、大小、时间、权限等条件查找文件,支持批量操作。使用场景:定位特定文件或清除过期文件。例如,

find /data -name "*.log" -mtime +7 -delete查找

/data目录下 7 天前的日志文件并删除(日志清理脚本常用);

find /etc -perm 600 -type f查找

/etc目录下权限为 600 的文件,检查因权限配置不当引起的服务访问问题;

find /var -size +100M查找大于 100MB 的文件,快速定位大文件占用磁盘的情况。

grep

:文本内容搜索工具,支持正则表达式,是日志分析的核心命令。使用场景:排查应用错误、筛选关键日志。例如,

grep -n "NullPointerException" app.log查找应用日志中 NullPointerException 错误的行号,快速定位代码问题;

grep -E "ERROR|WARN" app.log筛选日志中的错误和警告信息;

grep -A 5 -B 3 "timeout" nginx.log显示包含“timeout”的行及其前后 3 行和 5 行内容,分析超时的上下文。

cp/mv/rsync

:文件复制、移动与同步。使用场景:数据备份、文件迁移。例如,

cp -r /data/backup /mnt/usb递归复制备份目录到 U 盘;

mv /tmp/test.log /var/log/将临时日志移动到正式日志目录;

rsync -avz /data/ user@192.168.1.100:/remote/data/增量同步本地数据到远程服务器,适用于跨节点的数据备份(比 scp 更高效,支持断点续传)。

chmod/chown

:更改文件权限与所有权。应用场景:解决服务启动权限不足、文件访问权限错误。例如,

chmod +x start.shchown -R mysql:mysql /var/lib/mysqlchmod 755 /usr/local/bin/*三、进程管理类命令

用于管理应用程序进程,涵盖启动、停止、查看状态、故障排查。

ps

:查看进程快照,结合选项可获得详细的进程信息。应用场景:确认进程是否运行、获取进程ID。例如,

ps -ef | grep javaps aux | grep nginxps -p 1234 -o %cpu,%mem,cmdkill/killall/pkill

:终止进程。应用场景:关闭故障进程、重启服务。例如,

kill -15 1234kill -9 1234killall nginxpkill -f "java -jar app.jar"systemctl

:系统服务管理指令(CentOS 7+),用于启动、停止、重启、设定开机自启动。应用场景:管理如Nginx、MySQL、Redis等系统服务。例如,

systemctl start nginxsystemctl enable mysqlsystemctl status redissystemctl restart docker四、网络排查类命令

用于诊断网络连通性、端口占用、流量异常等问题。

ping

:测试主机连通性,基于ICMP协议。应用场景:检查服务器间是否可达。例如,

ping 192.168.1.100 -c 4netstat/ss

:查看网络连接、端口占用状况。ss是netstat的替代工具,速度更快。应用场景:检查端口是否被占用、确认服务监听地址。例如,

ss -tuln | grep 8080netstat -anp | grep ESTABLISHEDss -stelnet/curl

:测试端口连通性、发送HTTP请求。应用场景:验证服务端口是否对外开放、测试接口可用性。例如,

telnet 192.168.1.100 3306curl -I http://www.baidu.comcurl -X POST -d "username=test" http://127.0.0.1:8080/logintcpdump

:网络抓包工具,用于分析网络数据包。应用场景:排查复杂的网络问题(如接口超时、数据传输异常)。例如,

tcpdump -i eth0 host 192.168.1.100 and port 8080 -w /tmp/tcpdump.pcaptcpdump -n icmp面试加分点

:结合具体运维场景说明命令的组合使用(如

find + xargs + grepgrep --colorrsync --exclude记忆法

:场景-命令关联记忆法——将命令与关键场景绑定(如“磁盘满→df+du”“日志分析→grep+tail”“端口占用→ss+netstat”),通过场景联想到相应的命令,避免孤立记忆;关键词提炼记忆法——每个命令提炼1-2个核心功能关键词(如find=“查找+批量操作”、top=“实时监控+进程排序”、grep=“文本搜索+正则”),迅速掌握命令的核心用途。

分析内存问题的 Linux 命令是什么?如何 dump 整个线程?怎样导出堆栈信息?

一、分析内存问题的 Linux 命令

Linux 中分析内存问题的命令围绕“系统级内存监控、进程级内存分析、内存泄漏定位”展开,需结合场景组合使用,才能全面排查内存瓶颈、泄漏等问题:

free:基础内存查询命令,主要用于评估系统总体内存使用状况。通过

free -havailablesync && echo 3 > /proc/sys/vm/drop_cachestop:动态监控进程内存占用,定位高内存进程。默认按 CPU 排序,按

MPRESVIRTtop -p 进程IDps:查看进程内存快照,获取更详细的内存指标。常用命令

ps aux%MEMVSZRSSps aux --sort=-%mem | head -10ps -p 进程ID -o rss,vsize,%mem,cmdvmstat:监控系统虚拟内存、进程、IO 等状态,排查内存交换(swap)问题。重点关注

sisovmstat 1 5pmap:查看进程的内存映射,分析进程内存的具体分配情况。命令

pmap -x 进程IDpmap -x 进程IDpmap -x 进程ID | grep -i javanmon:可视化系统监控工具(需安装),支持实时展示 CPU、内存、磁盘、网络等指标,界面交互友好。使用场景:全面监控系统状态,快速定位内存与其他资源的关联问题。例如,通过 nmon 的内存页面(按

mc二、如何 dump 整个线程?

线程 dump 是获取进程中所有线程状态的主要方法,用于排查线程阻塞、死锁、线程泄漏等问题,不同语言的应用(Java、Go、C++)有不同的实现方式,以下是最常用的场景:

1. Java 应用线程 dump(最常用)

Java 应用依赖 JDK 自带的工具,无需额外安装,核心工具为

jpsjstack步骤 1:获取 Java 进程 ID。通过

jpsjps1234 AppMainjpsps aux | grep java步骤 2:执行线程 dump。使用

jstack 进程IDjstack 1234 > thread_dump_$(date +%Y%m%d%H%M%S).txt关键说明:

jstackjstack -l 进程IDjstack -F 进程IDjstack -m 进程ID混合模式输出(包含 Java 线程和 native 线程的栈详情,适合解决由 native 方法引发的问题)。

使用情境:当 Java 应用反应迟缓、卡顿或出现死锁时,可以通过线程 dump 来分析线程状况。例如,线程 dump 显示许多

WAITING (on object monitor)jstack -l2. 通用进程线程 dump(适用所有进程,如 Go、C++、Python)

针对非 Java 应用,可以利用

pspstack方法 1:运用

ps

ps -L -p 进程IDps -eLf | grep 进程IDps -L -p 进程ID > thread_list.txt方法 2:采用

pstackgdb

pstack 进程IDpstack 5678 > process_thread_dump.txt

pstack注意事项:

pstackpy-spy三、如何导出堆栈信息?

堆栈信息涵盖“进程堆栈”(进程的函数调用栈)和“Java 应用的 JVM 堆堆栈”(堆内存中对象的分布),前者用于调查线程阻塞、死锁,后者用于检查内存泄漏、堆内存溢出:

1. 导出进程堆栈信息(适用于所有进程)

方法 1:

pstackpstack 进程ID > stack_dump.txtpstack方法 2:

gdbgdb -p 进程IDthread apply all btbtdetach

gdb方法 3:Java 应用专属

jstackjstack2. 导出 Java 应用的 JVM 堆堆栈信息(诊断内存泄漏)

Java 应用的堆堆栈信息需借助 JDK 工具导出,主要工具有

jmapjhat步骤 1:导出堆内存快照(heap dump)。使用

jmap -dump:format=b,file=heap_dump.hprof 进程IDjmap -dump:format=b,file=app_heap_20240520.hprof 1234关键参数:

jmap -dump:live,format=b,file=live_heap_dump.hprof 进程ID步骤 2:分析堆快照。本地分析可用

jhatjhat -port 8080 heap_dump.hprofhttp://localhost:8080应用场景:当 Java 应用频繁 OOM、堆内存持续增加时,通过堆快照分析。例如,在 MAT 工具中发现

HashMap3. Python 应用堆栈导出(补充场景)

Python 应用可以通过

py-spytraceback方法 1:

py-spypy-spy record -o python_stack.svg -p 进程IDpy-spy dump -p 进程ID方法 2:在代码中集成

tracebacktraceback.print_exc()面试加分项 :区分“线程 dump”和“堆 dump”的不同作用(线程 dump 解决线程问题,堆 dump 诊断内存泄漏);结合 Java 应用的实际案例(如死锁排查、内存泄漏定位)阐述工具的应用;提及生产环境的注意事项(如

jmap导出堆快照可能会对性能产生影响,建议避开业务高峰期;

pstack对进程的影响通常是短暂的);熟练运用多种工具组合(例如

top确定高内存消耗的进程 →

jstack检查线程状态 →

jmap导出堆快照 → 使用 MAT 进行分析)。

记忆技巧

:分类记忆方法——将指令按照“系统内存监控(free/top/vmstat)”“进程内存分析(ps/pmap)”“线程 dump(jstack/pstack)”“堆 dump(jmap/jhat)”进行归类,每个类别下关联主要工具及其功能,逻辑清晰;情景-工具-步骤联结记忆法——“Java 内存泄漏 → 利用 jmap 导出堆快照 → 通过 MAT 分析”“进程线程阻塞 → 使用 pstack/jstack dump 线程 → 查看锁定信息”,通过具体情境将工具和操作步骤联系起来,防止遗漏关键环节。

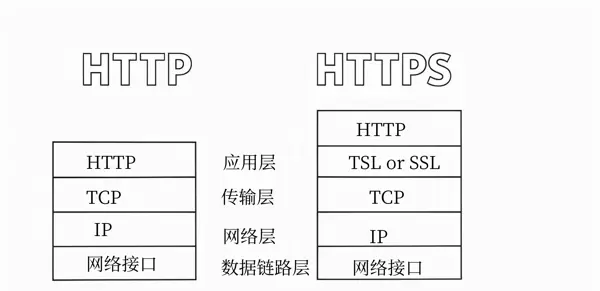

HTTP 和 HTTPS 的主要区别是什么?

HTTP(超文本传输协议)和 HTTPS(超文本传输安全协议)的主要差异集中在

安全性、传输机制、端口及性能

方面,HTTPS 实质上是基于 TLS/SSL 协议加密的 HTTP 协议版本,主要目的是解决 HTTP 传输过程中的数据泄露、篡改、身份冒充等问题。

一、主要区别对比

| 对比维度 | HTTP | HTTPS |

|---|---|---|

| 安全性 | 明文传输,缺乏加密和身份验证机制 | 基于 TLS/SSL 加密传输,提供数据加密、身份验证和数据完整性检查 |

| 传输层协议 | 直接运行在 TCP 协议之上,数据未经加密直接传输 | HTTP 协议 + TLS/SSL 协议,数据先经过 TLS/SSL 加密再通过 TCP 传输 |

| 端口 | 默认使用 80 端口 | 默认使用 443 端口 |

| 数据传输流程 | 客户端发送 HTTP 请求 → 服务器直接返回 HTTP 响应,整个过程数据未加密 | 客户端与服务器首先完成 TLS/SSL 握手(协商加密算法、交换密钥)→ 加密传输 HTTP 数据 → 会话结束时关闭 TLS 连接 |

| 证书要求 | 无需任何证书 | 服务器需要配置 CA 颁发的数字证书(例如 Let's Encrypt、阿里云 SSL 证书),用于身份验证 |

| 性能开销 | 没有加密/解密开销,传输效率较高 | 增加了 TLS 握手时间(大约 1-3 个 RTT)和数据加解密开销,性能略低于 HTTP |

| 数据完整性 | 没有校验机制,数据可能被篡改(例如中间人攻击替换内容) | 通过 MAC(消息认证码)校验数据,篡改后会被检测到 |

| 身份验证 | 无法验证服务器/客户端身份,容易遭受钓鱼攻击 | 服务器通过数字证书验证身份,客户端可以选择验证服务器证书(避免访问假冒站点) |

| 浏览器支持 | 没有安全提示,直接访问 | 地址栏显示锁形图标(表示安全),如果未配置有效证书,会提示“不安全”并阻止访问 |

二、关键差异详细说明

安全性主要差异

:HTTP 最显著的问题在于明文传输,数据在客户端与服务器之间传输时(例如通过路由器、互联网服务提供商网络),任何人均可监听、窃取数据(例如用户名密码、支付信息),甚至篡改数据内容(例如替换网页广告、嵌入恶意代码)。而 HTTPS 通过 TLS/SSL 协议解决了这些问题:

数据加密:使用对称加密(例如 AES)加密传输数据,对称加密密钥通过非对称加密(例如 RSA、ECC)在 TLS 握手阶段安全交换,确保只有客户端和服务器能够解密数据。

身份验证:服务器的数字证书由权威 CA(证书颁发机构)签署,客户端通过验证证书的有效性(例如证书是否过期、签名是否合法、域名是否匹配),确认服务器身份,避免连接到钓鱼网站。

数据完整性:通过 HMAC(哈希消息认证码)对传输的数据进行校验,客户端和服务器会比较数据的哈希值,如果数据被篡改,哈希值不匹配,传输将被终止。

TLS 握手的核心作用

:HTTPS 相较于 HTTP 增加了 TLS 握手环节,这是实现安全传输的基础。握手过程主要完成三项任务:一是协商加密套件(例如 TLS_ECDHE_RSA_WITH_AES_256_GCM_SHA384,包含密钥交换算法、对称加密算法、哈希算法);二是交换会话密钥(客户端生成预主密钥,用服务器公钥加密后发送,双方基于预主密钥生成对称加密密钥);三是验证服务器证书(客户端验证证书合法性,确保服务器身份真实)。握手成功后,后续所有 HTTP 数据都将使用协商好的对称密钥加密传输,既保证了安全性又提高了传输效率。

证书的作用与分类

:HTTPS 要求服务器配置数字证书,证书是身份验证的关键。证书分为三类:域名验证型(DV 证书,仅验证域名所有权,申请简便且免费,例如 Let's Encrypt)、组织验证型(OV 证书,验证域名和企业身份,适用于企业官网)、扩展验证型(EV 证书,最高级别的验证,浏览器地址栏会显示企业名称,适用于金融、电子商务等敏感领域)。如果服务器使用自签名证书(未经 CA 签署),客户端无法验证其身份,浏览器会提示“不安全”并阻止访问(可以手动忽略,但存在安全风险)。

性能差异的实际影响

HTTPS 因 TLS 握手和加密解密会产生一定效能消耗。TLS 握手阶段会增加 1-3 个 RTT(往返时间),在网络延迟较高的情况(如移动端),首次连接速度会比 HTTP 缓慢;数据传输阶段,CPU 需要消耗资源进行加密解密,在高并发情况下服务器负载会略高于 HTTP。但随着 TLS 1.3 协议的普及(优化握手过程,仅需 1 个 RTT)、硬件加密(如 CPU 支持 AES-NI 指令集)和 CDN 加速的应用,HTTPS 与 HTTP 的性能差距已显著缩小,且安全性带来的价值远超性能损耗。目前主流网站(如百度、淘宝、微信)均已全面启用 HTTPS,HTTP 逐渐被弃用。

三、应用场景差异

HTTP 仅适合非敏感数据传输场景,如静态资源展示(如纯文本新闻、公开图片)、内部测试环境(无外部网络访问),但目前浏览器和搜索引擎对 HTTP 支持逐渐收紧,甚至会降低 HTTP 网站的搜索排名。

HTTPS 适合所有需要保障数据安全的场景,如用户登录/注册(账号密码传输)、电商支付(银行卡信息、支付金额)、企业办公系统(内部数据)、API 接口(第三方服务调用,防止接口数据被篡改)等,是目前互联网数据传输的标准方案。

面试加分点

:能深入讲解 TLS 握手过程和加密机制(对称加密+非对称加密的结合);说明 TLS 1.2 与 TLS 1.3 的区别(如 TLS 1.3 简化握手、移除不安全加密套件);提及 HTTPS 优化策略(如启用 HTTP/2、OCSP stapling、会话复用);结合实际配置(如 Nginx 配置 HTTPS 证书、Let's Encrypt 免费证书申请)体现实践能力。

记忆法

:核心关键词对比记忆法——用“明文 vs 加密”“80 端口 vs 443 端口”“无证书 vs 需 CA 证书”“不安全 vs 安全”四个核心对比点提炼差异,快速抓住本质;流程联想记忆法——HTTP 流程“请求→响应”(简单直接),HTTPS 流程“握手→加密传输→关闭”(增加了安全校验环节),通过流程差异强化记忆。

TCP 为什么需要三次握手?其核心目的是什么?

TCP(传输控制协议)的三次握手是建立可靠 TCP 连接的关键流程,其设计初衷是

解决“双向通信的初始化”和“网络延迟/丢包导致的连接混乱”问题

,确保客户端和服务器双方都清楚“对方已准备好接收数据”,并同步初始序列号(ISN),为后续可靠传输打下基础。

一、三次握手的具体流程

TCP 三次握手基于客户端和服务器的状态变化(客户端:CLOSED→SYN_SENT→ESTABLISHED;服务器:CLOSED→LISTEN→SYN_RCVD→ESTABLISHED),具体步骤如下:

第一次握手(客户端→服务器,SYN 报文):客户端主动发起连接,向服务器发送 SYN(同步)报文,报文中包含客户端的初始序列号 ISN(c)(如 ISN=100),同时将 TCP 头中的 SYN 标志位设为 1。发送后,客户端进入 SYN_SENT 状态,等待服务器响应。

第二次握手(服务器→客户端,SYN+ACK 报文):服务器处于 LISTEN(监听)状态,收到客户端的 SYN 报文后,确认客户端有连接请求。服务器会发送 SYN+ACK 报文,其中包含服务器的初始序列号 ISN(s)(如 ISN=200),同时将 SYN 标志位设为 1;ACK 标志位设为 1,确认号字段设为 ISN(c)+1(如 101),表示已收到客户端的 SYN 报文并准备好接收后续数据。发送后,服务器进入 SYN_RCVD 状态。

第三次握手(客户端→服务器,ACK 报文):客户端收到服务器的 SYN+ACK 报文后,确认服务器已准备好连接。客户端会发送 ACK 报文,将 ACK 标志位设为 1,确认号字段设为 ISN(s)+1(如 201),表示已收到服务器的 SYN 报文。发送后,客户端进入 ESTABLISHED 状态;服务器收到 ACK 报文后,也进入 ESTABLISHED 状态,此时 TCP 连接建立完成,双方可开始传输数据。

二、需要三次握手的核心原因

同步双方的起始序列号(ISN),确保稳定传输:TCP 是一种稳定传输协议,通过序列号和确认号确保数据的有序传输、重传和去重。每个 TCP 数据包都包含序列号(指明当前数据的起始位置),接收端通过确认号(表示期望接收的下一个字节的序列号)通知发送端“已接收到哪些数据”。三次握手的主要目标之一是让客户端和服务器互相告知自己的 ISN,使双方能根据对方的 ISN 计算后续的序列号和确认号。例如,客户端得知服务器的 ISN=200,后续接收服务器数据时,会通过确认号 201、202 等反馈接收状态;服务器同样,基于客户端的 ISN=100 来处理接收确认。如果只有两次握手,服务器在发送 SYN+ACK 后即进入连接状态,但客户端可能未接收到该数据包(比如网络丢包),这时服务器可能会误认为连接已建立并发送数据,造成数据丢失;而三次握手要求客户端必须发送最后的 ACK 数据包,服务器接收到后才能确认连接建立,避免了这种情况。

解决“延迟的旧连接请求”引发的连接混乱:网络中可能存在延迟的旧连接请求数据包(例如客户端先前发起的连接请求因网络拥堵而延迟到达服务器)。如果采用两次握手,服务器接收到旧请求后会直接建立连接并发送数据,但客户端可能已不再需要该连接(如已超时重新发起新连接),导致服务器资源浪费(如占用端口、内存)。三次握手通过“客户端最终确认”机制解决了该问题:当旧请求的 SYN 数据包到达服务器后,服务器发送 SYN+ACK 数据包,但客户端会发现该数据包对应的是已失效的连接(客户端当前状态不是 SYN_SENT 或已建立新连接),不会发送第三次 ACK 数据包,服务器等待 ACK 超时后会释放该半连接,避免资源浪费。

确保双向通信的可达性:TCP 连接是双向的(全双工),需要确保客户端能向服务器发送数据,且服务器能向客户端发送数据。三次握手的每一步都在验证单向通信的可达性:第一步握手验证“客户端→服务器”的下行链路可用(服务器接收到 SYN);第二步握手验证“服务器→客户端”的上行链路可用(客户端接收到 SYN+ACK);第三步握手验证“客户端→服务器”的下行链路再次可用(服务器接收到 ACK)。通过三次交互,双方确认双向链路均能正常传输数据,避免因单向链路故障导致连接建立后无法通信。

三、为什么不能是两次握手或四次握手?

两次握手的问题:如上所述,两次握手无法确保客户端接收到服务器的 SYN+ACK 数据包,可能导致服务器建立无效连接并浪费资源;同时无法彻底解决延迟旧连接的问题,存在连接混乱的风险。此外,两次握手只能让服务器了解客户端的 ISN,但客户端无法确认服务器是否已接收到自己的 ISN,后续数据传输的序列号同步会出现问题。

四次握手的冗余:三次握手已能完成“同步 ISN+验证双向链路+解决延迟旧连接”的核心目标,第四次握手不会增加额外的可靠性,反而会增加网络传输开销(多一次数据包交互)和连接建立时间(多一个 RTT),不符合 TCP 高效连接的设计原则。

面试加分点

能结合 TCP 状态机(CLOSED、LISTEN、SYN_SENT、SYN_RCVD、ESTABLISHED)说明三次握手的状态变迁;解释 ISN 的作用(避免序列号重叠导致数据去重错误);提及三次握手的超时处理(如客户端未接收到 SYN+ACK 会重传 SYN 数据包,服务器未接收到 ACK 会超时释放半连接);对比 UDP 无连接特性,突出 TCP 三次握手对稳定传输的意义。

记忆法

核心目标-流程关联记忆法——将三次握手的核心目标(同步 ISN、验证双向链路、解决旧连接)与三次流程绑定:第一次握手“客户端发 ISN→服务器知客户端 ISN”;第二次握手“服务器发 ISN+确认客户端 ISN→客户端知服务器 ISN”;第三次握手“客户端确认服务器 ISN→服务器确认双向可达”,通过“同步-确认-最终确认”的逻辑链记忆流程;关键词提炼记忆法——用“同步 ISN、双向可达、防旧连接”三个关键词概括三次握手的核心目的,快速抓住设计本质。

TCP 和 UDP 的区别及各自的适用场景是什么?

TCP(传输控制协议)和 UDP(用户数据报协议)是 TCP/IP 协议栈中最核心的两个传输层协议,主要区别在于

| 对比维度 | TCP | UDP |

|---|---|---|

| 连接特性 | 面向连接,需通过三次握手建立连接,四次挥手关闭连接 | 无连接,发送数据前无需建立连接,直接发送数据报 |

| 可靠性 | 可靠传输,通过序列号、确认号、重传机制、流量控制、拥塞控制确保数据不丢失、不重复、按序到达 | 不可靠传输,不保证数据送达、不保证送达顺序、不处理重复数据,仅提供尽力交付 |

| 数据传输单位 | 字节流(Byte Stream),无数据报边界,发送方可连续发送字节,接收方按顺序接收并重组 | 数据报(Datagram),每个数据报独立,发送方发送数据报,接收方按原样接收 |

数据报(Datagram),每个数据报是一个独立的传输单元,包含完整的源/目的地址和数据,接收方独立处理每个数据报。

拥塞控制

支持拥塞控制(如慢启动、拥塞避免、快速重传、快速恢复),网络拥堵时会减少发送速率,防止网络崩溃

无拥塞控制,发送方按照自身速率发送数据,不考虑网络状况,可能导致网络拥堵加剧

流量控制

支持流量控制(滑动窗口机制),接收方依据自身缓冲区大小调节发送方的发送速率,防止接收方缓冲区溢出

无流量控制,发送方不关心接收方能否处理,可能导致接收方缓冲区溢出而丢失数据

头部开销

头部较大(20-60 字节),包含序列号、确认号、窗口大小、校验和等多字段

头部极小(8 字节),仅含源端口、目的端口、长度、校验和四个字段,开销低

传输效率

由于连接建立/关闭、重传、流量控制等机制,传输延迟较高,效率较低

无额外机制开销,传输延迟低(仅含数据报封装和校验),实时性强

适用数据量

适合传输大量数据(如文件、数据流),可通过字节流连续传输并重组

适合传输少量数据(如单次请求/响应、短消息),每个数据报独立完整

错误处理

校验和检查数据,发现错误则丢弃并触发重传(通过确认号检测丢失)

校验和检查数据,发现错误直接丢弃,不重传、不通知发送方

端口使用

支持端口复用,但需通过连接标识(源 IP、源端口、目的 IP、目的端口)区分不同连接

支持端口复用,通过数据报的源/目的端口标识接收进程

二、关键差异细节展开

连接特性与可靠性差异

TCP 的“面向连接”是其可靠性的基石,三次握手确保双方准备就绪,四次挥手确保数据完全传输。可靠传输的核心机制包括:

序列号与确认号:每个字节都有唯一的序列号,接收方通过确认号告知发送方“已收到至某个序列号的所有数据”,未收到确认的字节会被重传。

滑动窗口:流量控制的核心,接收方通过窗口大小字段告知发送方“当前可接收的字节数”,发送方仅发送窗口内的字节,避免接收方缓冲区溢出。

重传机制:发送方设置超时计时器,未收到确认则重传数据;收到重复确认(如 3 次重复 ACK)会触发快速重传,无需等待超时。

拥塞控制:当网络丢包(判断为拥堵)时,TCP 会降低发送速率,避免大量数据涌入拥堵网络导致更严重的丢包,保障网络整体稳定性。

而 UDP 是“无连接”的,发送方无需与接收方协商,直接将数据封装成数据报发送到网络中。UDP 仅通过校验和验证数据完整性,错误则丢弃,不重传、不反馈,也不保证数据按发送顺序到达(如网络延迟导致后发的数据报先到达)。这种设计让 UDP 无需额外机制开销,传输延迟远低于 TCP。

数据传输单位差异

TCP 的“字节流”特性意味着发送方和接收方之间是连续的字节通道,没有明确的“数据包”边界。例如,发送方分三次发送“Hello”“World”“!”,接收方可能一次接收“HelloWorld!”,或分两次接收“HelloW”“orld!”,需接收方自行处理数据边界(如约定分隔符、固定长度)。而 UDP 的“数据报”是独立的,发送方发送一个数据报,接收方就会收到一个完整的数据报,不会与其他数据报合并。例如,发送方发送三个 UDP 数据报,接收方会按顺序(或乱序)收到三个独立的数据报,每个数据报包含完整的内容,无需处理边界问题。

头部开销与传输效率差异

TCP 头部最小 20 字节(固定字段),若包含选项字段(如 MSS、窗口缩放)则可达 60 字节;而 UDP 头部仅 8 字节,仅包含必要的端口和校验信息。头部开销的差异直接影响传输效率:在相同带宽下,UDP 能传输更多有效数据,且无需连接建立/关闭、重传等耗时操作,延迟更低(通常比 TCP 低 10-100ms),实时性更强。但 UDP 无拥塞控制,当发送速率超过网络承载能力时,会导致大量数据报丢失,而 TCP 会通过拥塞控制动态调整速率,确保数据最终送达。

三、各自的适用场景

- TCP 的适用场景

TCP 适合对

可靠性要求高、数据传输量大、可接受一定延迟

的场景,核心是确保数据完整、有序送达:

文件传输:如 FTP(文件传输协议)、SFTP、HTTP/HTTPS 下载文件,需要确保文件无损坏、无缺失(如安装包、文档、视频文件),TCP 的字节流和重传机制能避免文件传输过程中出现错误。

远程登录/控制:如 SSH、Telnet,需要确保输入命令和返回结果的顺序一致,避免命令执行混乱,TCP 的有序传输特性满足该需求。

数据通信类应用:如电子邮件(SMTP、POP3、IMAP)、数据库连接(MySQL、PostgreSQL 的 TCP 连接)、即时通讯的消息可靠送达(如微信文字消息,需确保不丢失),这些场景对数据可靠性要求高于实时性。

网页浏览:HTTP/HTTPS 基于 TCP 传输,网页的 HTML、CSS、JavaScript 等资源需要完整加载,否则会导致网页显示异常,TCP 的可靠性保障了网页资源的正常传输。

2. UDP 的适用场景

UDP 适用于对实时性要求高、可接受少量数据丢失、数据传输量小的场景,核心在于追求低延迟和高效传输:

- 实时音视频通信:如 VoIP(网络电话)、视频会议(Zoom、腾讯会议)、直播(弹幕、实时画面),这些场景对延迟非常敏感(延迟超过 100ms 会导致卡顿、回声),少量数据丢失(如个别帧丢失)不会显著影响整体体验,而 TCP 的重传机制会导致延迟累积,反而降低体验。

- 实时游戏:如王者荣耀、英雄联盟等在线游戏,游戏中的操作指令(如移动、攻击)需要迅速传输,延迟直接影响游戏体验,少量指令丢失可以通过游戏逻辑补偿(如预测玩家位置),UDP 的低延迟特性是最佳选择。

- 物联网通信:如传感器数据上报(温度、湿度、设备状态),传感器通常周期性发送少量数据,对实时性要求高(需及时反馈设备状态),且网络环境可能不稳定,UDP 的低开销和快速传输适合该场景。

- 广播/多播通信:UDP 天然支持广播(同一网段内所有设备接收)和多播(特定组设备接收),如局域网内的设备发现(如打印机共享、智能家居设备配对)、流媒体多播(如 IPTV 多播传输),而 TCP 仅支持点对点通信,不支持广播/多播。

- 简单请求/响应:如 DNS 解析(域名→IP 地址),客户端发送一个简短的 DNS 请求数据报,服务器返回一个 DNS 响应数据报,数据量小、无需可靠传输,UDP 的低延迟使 DNS 解析更快(若解析失败可重试)。

面试加分点

能够结合具体协议或应用说明场景选择(如 DNS 使用 UDP、HTTP 使用 TCP);深入讲解 TCP 可靠传输的核心机制(如滑动窗口、拥塞控制);分析 UDP 应用如何弥补可靠性不足(如应用层实现重传、校验、顺序控制,如 RTP 协议用于音视频传输时的序号和时间戳机制);对比两者在高并发场景下的表现(如 UDP 支持更多并发连接,因为没有连接状态开销)。

记忆法

核心特性-场景对应记忆法——将 TCP 的核心特性(可靠、面向连接、字节流、高开销)与场景绑定(文件传输、网页浏览、数据库连接),将 UDP 的核心特性(不可靠、无连接、数据报、低开销、实时性)与场景绑定(音视频、游戏、DNS、物联网),通过特性联想场景;关键词对比记忆法——用“可靠 vs 实时”“连接 vs 无连接”“字节流 vs 数据报”“高开销 vs 低开销”四个核心对比词提炼差异,快速区分两者本质。

操作系统中同步和异步的区别是什么?什么场景下使用同步,什么场景下使用异步?

同步和异步是操作系统中描述任务执行顺序与结果通知机制的核心概念,主要区别集中在任务执行依赖关系、结果获取方式、资源利用率三个维度,其设计目标分别为“执行可靠性”和“效率优化”,需根据业务场景的核心需求选择。

一、同步和异步的核心区别

| 对比维度 | 同步 | 异步 |

|---|---|---|

| 任务执行关系 | 多个任务存在依赖关系,必须按顺序执行:前一个任务完成后,后一个任务才能开始 | 多个任务相互独立,无需等待其他任务完成,可并发执行:发起任务后无需阻塞,继续执行后续操作 |

| 结果获取方式 | 发起任务后,调用方必须阻塞等待,直到任务完成并返回结果,才能继续执行后续逻辑 | 发起任务后,调用方无需阻塞,可立即执行其他操作;任务完成后,通过回调函数、信号、消息队列等方式通知调用方结果 |

| 资源利用率 | 任务等待期间(如 IO 操作、网络请求),调用方(如线程)处于阻塞状态,无法处理其他任务,资源利用率低 | 任务等待期间,调用方可处理其他任务,无需闲置,资源利用率高(尤其适合 IO 密集型场景) |

| 执行复杂度 | 逻辑简单,流程线性,无需额外处理结果通知,调试和维护成本低 | 逻辑复杂,需设计结果通知机制(如回调、状态管理),可能出现回调嵌套、并发安全问题,调试难度高 |

| 响应延迟 | 总延迟为所有任务执行时间之和(含等待时间),延迟较高 | 总延迟为“最长任务执行时间”(并发执行),延迟较低,实时性强 |

| 并发能力 | 依赖多线程/多进程实现并发,线程切换开销大,并发上限低 | 可基于单线程事件循环(如 epoll、kqueue)实现高并发,无线程切换开销,并发上限高 |

| 适用场景 | 任务间有依赖、需确保执行顺序、对结果实时性要求高且允许阻塞的场景 | 任务间无依赖、IO 等待时间长、追求高并发和高资源利用率的场景 |

二、关键差异细节展开

执行流程与阻塞机制差异:同步的核心在于“等待-执行”的线性流程。例如,用户调用本地函数读取文件(

read(file)异步的核心在于“发起-通知”的非阻塞流程。例如,通过异步 IO 接口(

aio_read(file, callback))读取文件,调用后立即返回,线程可以继续执行其他任务(比如处理其他文件读取、响应网络请求);当文件读取完成后,操作系统会通过回调函数将结果返回给线程,线程再处理这个结果。这种机制的核心在于“任务执行与结果获取分离”,将等待时间转变为处理其他任务的时间,提高资源使用率。

并发实现原理的区别:

同步场景下的并发依赖于多线程/多进程。例如,Web 服务器处理 1000 个同步 HTTP 请求时,需要创建 1000 个线程,每个线程处理一个请求(阻塞等待 IO 完成)。然而,线程创建和切换的成本很高(内存占用、CPU 调度),当并发数量达到数万级别时,系统资源会被耗尽,导致性能崩溃。

异步场景下的并发基于“事件驱动”和“非阻塞 IO”。例如,Nginx 服务器采用单线程事件循环模型,通过 epoll 监听所有 IO 事件(如网络连接、文件读取),当某个事件准备就绪(如数据到达)时,才触发相应的处理逻辑。在这种模型下,单个线程可以处理数万甚至数十万的并发请求,没有线程切换成本,资源使用率非常高。

错误处理与流程控制的区别:

同步的错误处理简单直接,可以通过 try-catch 机制在任务执行过程中捕获错误,例如:

# 同步读取文件,错误直接捕获

try:

with open("data.txt", "r") as f:

data = f.read() # 阻塞等待读取完成

print("读取成功:", data)

except FileNotFoundError as e:

print("错误:", e)异步的错误处理需要结合通知机制,例如回调函数中需要包含错误处理逻辑,可能会出现“回调地狱”(多层嵌套回调),增加代码复杂度:

# 异步读取文件(基于 Python asyncio)

import asyncio

async def read_file():

try:

async with aiofiles.open("data.txt", "r") as f:

data = await f.read() # 非阻塞,挂起当前协程,处理其他任务

print("读取成功:", data)

except FileNotFoundError as e:

print("错误:", e)

asyncio.run(read_file())为了解决回调地狱问题,现代编程语言提供了 Promise、async/await 等语法糖,简化异步代码的流程控制,使异步代码的编写方式接近同步代码。

三、适用场景

1. 同步的适用场景

- 任务之间存在强依赖关系,需要确保执行顺序。例如,银行转账流程:“减少用户 A 的余额”→“增加用户 B 的余额”→“记录转账日志”,这三个步骤必须按顺序执行,如果前一步失败则后续步骤不能执行,若使用异步可能导致数据不一致(如 A 的余额被扣但 B 的余额未增加)。

- 对结果实时性要求高,且等待时间短。例如,本地函数调用(如数学计算、数据格式化)、数据库查询(简单查询,响应时间 <10ms),同步执行的阻塞时间可以忽略,而且流程简单,无需额外设计通知机制。

- 简单的业务逻辑,不需要高并发。例如,小型工具类程序(如文件转换工具、数据统计脚本),用户交互少、请求量低,同步执行可以降低开发和维护成本。

- 必须确保操作的原子性。例如,分布式锁的获取与释放、数据库事务操作,同步执行可以避免并发冲突,确保操作的原子性和一致性。

2. 异步的适用场景

- IO 密集型场景(等待时间长)。例如,网络请求(如调用第三方 API、HTTP 接口)、文件读写(大文件、网络文件)、数据库慢查询(响应时间 >100ms),异步执行可以在等待 IO 完成时处理其他任务,提高吞吐量。例如,爬虫程序异步发起 1000 个网络请求,无需等待前一个请求返回即可发起下一个,总耗时远低于同步执行。

- 高并发场景。例如,高流量 Web 服务器(如电商秒杀、直播平台)、即时通讯系统(如微信消息推送),需要处理数万级别的并发请求,异步非阻塞模型可以在有限资源下支持更高的并发,避免线程耗尽。

- 实时性要求高但允许少量延迟的场景。例如,消息队列(如 Kafka、RabbitMQ)的生产者/消费者模型,生产者发送消息后无需等待消费者处理,可以立即发送下一条消息;消费者异步处理消息,确保消息快速投递和处理。

- 后台任务处理。例如,邮件发送、短信推送、数据备份、日志分析等非实时任务,发起后无需用户等待结果,通过异步方式在后台执行,提高用户体验(如用户注册后立即返回成功,邮件发送在后台异步完成)。

面试加分点

能够结合具体技术栈说明同步/异步实现(如 Python 中的同步函数 vs asyncio、Java 中的同步方法 vs CompletableFuture);分析同步/异步的性能瓶颈(如同步的线程成本、异步的回调复杂度);提及异步的优化方案(如事件循环、协程、异步框架);结合实际项目场景(如高并发 API 设计、IO 密集型任务优化)说明选择逻辑。

记忆法

核心需求-场景对应记忆法——同步对应“可靠性优先”(顺序执行、数据一致、逻辑简单),异步对应“效率优先”(高并发、IO 密集、资源高效),通过核心需求联想到适用场景;关键词提炼记忆法——同步记“阻塞、顺序、依赖、简单”,异步记“非阻塞、并发、独立、高效”,快速抓住核心差异。

什么是 FULL GC?为什么会出现 FULL GC 问题?导致内存满的常见原因有哪些?

一、什么是 FULL GC?

FULL GC(Full Garbage Collection,完全垃圾回收)是 JVM(Java 虚拟机)中针对 老年代(Old Generation)

以及整个堆内存(包括年轻代、老年代、永久代/元空间)的垃圾回收过程,部分垃圾回收器(如 G1、ZGC)也将“全局标记-清理”类的回收称为 FULL GC。其主要特点是:回收范围涵盖整个堆内存,回收过程中会暂停所有应用程序线程(即 STW,Stop The World),暂停时间通常远超 Minor GC(仅回收年轻代的垃圾回收),对应用性能影响明显(如导致接口响应延迟、系统卡顿)。

需明确区分 FULL GC 与 Minor GC 的主要差异:Minor GC 仅回收年轻代(Eden 区、Survivor 区),回收目标主要是“短暂存在”的短生命周期对象,回收速度较快(通常毫秒级),STW 影响较小;而 FULL GC 回收老年代(存储长生命周期对象)和永久代/元空间(存储类元信息、常量池等),回收对象体积较大、存活时间较长,回收流程较为复杂(如标记-清除-压缩),STW 时间较长(可能达秒级),是性能优化的关键关注点。

不同垃圾回收器的 FULL GC 实现有细微差别:

- 串行垃圾回收器(Serial GC):FULL GC 采用“标记-清除-压缩”算法,单线程执行,STW 时间最长。

- 并行垃圾回收器(Parallel GC):FULL GC 采用多线程标记-清除-压缩,STW 时间比 Serial GC 短,但仍会阻塞应用线程。

- G1 垃圾回收器:默认无显式 FULL GC,若老年代空间不足或出现分配失败,会触发“Full GC Fallback”(退化到串行 FULL GC),STW 时间较长;G1 的“全局并发标记”并非 FULL GC,而是增量回收老年代。

- ZGC/Shenandoah:几乎无 FULL GC,通过并发回收机制实现全堆回收,STW 时间控制在毫秒级以下,适用于低延迟场景。

二、为何会出现 FULL GC 问题?

FULL GC 问题的根本在于“老年代内存不足”或“触发 FULL GC 的特定条件被满足”,导致 JVM 必须启动全局垃圾回收以释放内存。常见的触发原因可以分为以下几类:

- 老年代内存不足(最常见原因):

- 长生命周期对象过多:应用中创建大量长生命周期对象(如静态集合、缓存对象、单例对象),这些对象不会被 Minor GC 回收,持续进入老年代,最终导致老年代内存占满,触发 FULL GC。例如,缓存系统未设置过期时间,缓存对象持续累积;单例对象中持有大量数据(如用户会话缓存),未及时清理无效会话。

- 年轻代对象晋升过快:年轻代对象经过多次 Minor GC 后仍存活,会被晋升到老年代(默认晋升年龄为 15)。若应用中创建大量中等生命周期对象(如批量处理任务时的临时对象),这些对象在年轻代存活时间超过晋升年龄,频繁晋升到老年代,导致老年代快速占满。例如,批量导入 100 万条数据时,每条数据的对象在处理完成后未及时释放,经过几次 Minor GC 后晋升到老年代。

- 大对象直接进入老年代:JVM 规定,超过“大对象阈值”(可通过

配置,默认无明确值,HotSpot 中通常为年轻代 Eden 区的 1/2)的对象会直接分配到老年代。若应用频繁创建大对象(如大数组、大字符串、大集合),老年代会快速被占满,触发 FULL GC。例如,读取 100MB 的文件内容到内存中,生成大字符串对象,直接进入老年代。-XX:PretenureSizeThreshold

- 永久代/元空间不足(JDK 8 及以上为元空间):

- 永久代(JDK 7 及以下)存储类元信息、常量池、方法区数据,若应用频繁加载类(如动态代理、反射生成类、热部署),且未及时卸载无用类,会导致永久代内存占满,触发 FULL GC(永久代的垃圾回收仅在 FULL GC 时进行)。

- 元空间(JDK 8 及以上)默认使用本地内存,但若配置了元空间大小限制(

),且类加载过多导致元空间达到限制,会触发 FULL GC 以清理无用类元信息。例如,Spring Boot 应用使用大量动态代理(如 AOP)生成类,或频繁部署应用(热部署)未卸载旧类,导致元空间溢出。-XX:MaxMetaspaceSize

- 显式调用 System.gc()(不推荐):

- 应用代码中直接调用

会建议 JVM 执行 FULL GC(虽然 JVM 可忽略该建议,但多数情况下会触发)。这种方式会强制中断应用线程,导致 STW 延迟,是典型的代码坏味道。例如,部分开发者误以为调用System.gc()

能优化内存使用,在代码中频繁调用,导致 FULL GC 频繁触发。System.gc()

- 应用代码中直接调用

- CMS 垃圾回收器的并发模式失败(Concurrent Mode Failure):

CMS(Concurrent Mark Sweep)垃圾回收器是一种并发回收老年代的工具,其回收流程包括“初步标记-并行标记-再次标记-并行清除”四个阶段,其中只有初步标记和再次标记会造成 STW。如果 CMS 在并行清除阶段,老年代内存迅速被填满(比如应用不断生成对象并迁移到老年代,速度超出 CMS 的回收速率),会导致“并行模式失败”,此时 JVM 将启动 FULL GC(退化为串行标记-清除-压缩),STW 时间显著延长。

G1 垃圾回收器的晋升失败(Promotion Failure):

G1 回收器在 Minor GC 期间,如果年轻代对象需要晋升至老年代,但老年代缺乏足够的连续空间来容纳这些对象,将会引发晋升失败,并触发 FULL GC。例如,当老年代内存碎片较多时,尽管有足够的空闲空间,但由于缺乏连续的空间来容纳较大的晋升对象,从而导致晋升失败。

三、导致内存满的常见原因

内存满(OOM,Out of Memory)是一个比 FULL GC 更加严重的问题,其实质在于“堆内存/非堆内存被完全占据,JVM 无法分配新的内存”。常见原因可以分为堆内存溢出和非堆内存溢出两种类型:

堆内存溢出(java.lang.OutOfMemoryError: Java heap space):

内存泄露(主要因素):对象创建后,虽然不再被程序使用,但依然被引用链持有(例如静态集合未清空、缓存缺少过期策略、监听器未注销、线程池的核心线程持有对象引用),这使得垃圾回收器无法回收这些对象,长期占用内存,最终导致堆内存满。例如:

// 静态集合导致内存泄漏

public class StaticCache {

private static List<Object> cache = new ArrayList<>();

// 只添加对象,未提供清理方法

public static void add(Object obj) {

cache.add(obj);

}

}该代码片段中,

cache为静态集合,加入的对象会被永久引用,即便不再使用也无法被回收,随着时间推移累积造成堆内存溢出。

堆内存设定过低:如果应用程序所需的内存超出了 JVM 堆内存的最大限制(

-Xmx设置),例如,应用需要 8GB 堆内存,但

Xmx只设定了 4GB,就会出现内存不足的情况。

大量大对象一次性创建:当应用程序一次性创建了大量对象(如批量处理大规模数据时,将所有数据一次性加载到内存中),超出了堆内存的承载范围。例如,将 1000 万条数据库记录全部加载到内存中处理,假设每条记录占用 1KB 内存,则总共需要 10GB 堆内存,如果

Xmx仅 8GB,就会导致堆内存溢出。

非堆内存溢出:

元空间溢出(java.lang.OutOfMemoryError: Metaspace):从 JDK 8 开始,元空间用来存储类的元信息。如果应用程序频繁加载类(如动态代理、反射、热更新)且不卸载,或者元空间大小限制过低(

-XX:MaxMetaspaceSize设置太小),可能会导致元空间溢出。例如,使用 CGLIB 动态生成大量的代理类,同时不释放 Class 对象,最终导致元空间占满。

栈内存溢出(java.lang.StackOverflowError):栈内存主要用于存储线程调用栈的信息(包括方法参数、局部变量、返回地址)。如果线程调用栈过深(如递归调用无结束条件)或栈内存配置过低(

-Xss设置太小),则可能导致栈内存溢出。例如,无终止条件的递归调用:

public void recursiveCall() {

recursiveCall(); // 无终止条件的递归

}每次调用都会在栈上新增一个栈帧,最终导致栈内存满,抛出 StackOverflowError。

直接内存溢出(java.lang.OutOfMemoryError: Direct buffer memory):直接内存位于 JVM 之外(不受堆内存限制),通过

ByteBuffer.allocateDirect()分配。如果分配了大量的直接内存而未释放,或者直接内存大小限制过低(

-XX:MaxDirectMemorySize设置太小),就可能引发直接内存溢出。例如,在 NIO 应用中频繁分配直接内存用于网络 I/O 或文件 I/O,且未调用

clear()释放内存,最终导致直接内存占满。

面试加分点:

能够区分 FULL GC 和 Minor GC、G1 全局并行标记的区别;结合垃圾回收器的特点(如 CMS 并行模式失败、G1 晋升失败)分析 FULL GC 的触发原因;提供内存问题的诊断工具(如 jmap、jhat、MAT、Arthas)及其使用流程;结合实际案例(如静态集合内存泄露、大对象分配导致 OOM)阐述解决方案;提及 JVM 调优参数(如

-Xmx、

-XX:PretenureSizeThreshold、

-XX:MaxMetaspaceSize)的设置逻辑。

记忆法:

层次记忆法——按照“FULL GC 定义→触发原因→内存满原因”进行分层整理,每一层按照“核心因素+具体情境”展开,确保逻辑连贯;关键词联想法——记住 FULL GC 的触发原因:“老年代满、元空间满、显式调用、CMS 失败、G1 晋升失败”;记住内存满的原因:“内存泄露、配置过小、大对象多、类加载过多、递归过深”,利用关键词快速回忆具体情境。

在你的项目中是否遇到过高并发场景?如果遇到了,你是如何确定问题所在并进行处理的?(面试官提示:仅修改业务代码可能不够,可以考虑使用 Django 自带的缓存等方案)

在项目中,我多次面对高并发场景,其中最难忘的是某电商网站的“限时秒杀”活动——活动期间单接口峰值 QPS 超过 5000,初期出现了接口响应延迟超过 3 秒、部分请求超时、数据库连接池耗尽的问题。以下是我完整的定位思路、处理方案及优化效果,核心在于“问题定位→分层优化→监控兜底”,不仅修改了业务代码,还结合缓存、架构调整等多方面策略解决了高并发瓶颈。

一、高并发问题定位

高并发问题的核心在于“识别性能瓶颈”,需要从“应用层→缓存层→数据库层→基础设施层”逐步排查,结合监控工具和日志分析:

初步现象与监控数据采集

- 现象:秒杀活动启动后,用户反馈“点击抢购无响应”“订单提交超时”,后台日志频繁出现

(数据库连接池耗尽)和DatabaseError: connection pool exhausted

(接口超时)。TimeoutError - 监控工具:使用 Prometheus+Grafana 监控接口 QPS、响应时间、错误率;使用 Django Debug Toolbar 本地复现并分析请求链路耗时;使用

、top

、iostat

监控服务器 CPU、内存、磁盘 IO、网络连接状态;使用数据库慢查询日志(slow query log)记录执行时间超过 1 秒的 SQL。netstat

瓶颈点定位结果

- 应用层:Django 视图函数中存在大量重复数据库查询(如每次请求都查询商品库存、活动状态),且未做缓存;秒杀逻辑未加并发控制,导致大量无效请求涌入数据库。

- 缓存层:初期未使用缓存,所有请求直接穿透到数据库,数据库压力剧增。

- 数据库层:商品库存查询

和库存扣减SELECT stock FROM goods WHERE id=?

SQL 执行频繁,且库存扣减未加行锁,导致并发更新冲突(多个请求同时扣减库存,出现超卖风险);数据库连接池配置过小(默认 20 个连接),高并发下连接耗尽。UPDATE goods SET stock=stock-1 WHERE id=? AND stock>0 - 基础设施层:服务器带宽不足(100M 带宽),活动启动后大量静态资源(商品图片、活动页面)请求导致带宽占满,间接影响接口响应。

二、分层优化方案

针对定位到的瓶颈点,我们采用了“缓存优先+并发控制+数据库优化+基础设施升级”的多层优化方案,重点利用 Django 自带缓存框架和第三方工具提升性能:

应用层优化:并发控制与请求过滤

- 实现请求限流:使用 Django 第三方库

对秒杀接口进行限流,限制单个用户每秒最多发起 2 次请求,防止恶意刷请求。配置示例:django-ratelimitfrom ratelimit.decorators import ratelimit @ratelimit(key='user', rate='2/s', method='POST') @ratelimit(key='ip', rate='10/s', method='POST') # 同时按 IP 限流 def seckill_view(request): # 秒杀逻辑 pass - 前置请求过滤:在 Django 中间件中过滤无效请求(如活动未开始、商品已售罄),直接返回结果,避免无效请求进入后续流程。示例:

class SeckillFilterMiddleware: def __init__(self, get_response): self.get_response = get_response def __call__(self, request): # 过滤非秒杀接口请求 if request.path != '/api/seckill/': return self.get_response(request) # 检查活动状态 seckill_active = cache.get('seckill_active') if not seckill_active: return JsonResponse({'code': 400, 'msg': '活动未开始'}) # 检查商品库存(缓存中查询,避免数据库查询) goods_id = request.POST.get('goods_id') stock = cache.get(f'goods_stock_{goods_id}') if stock is None or stock <= 0: return JsonResponse({'code': 400, 'msg': '商品已售罄'}) return self.get_response(request) - 优化秒杀业务逻辑:移除重复数据库查询,将活动状态、商品信息、库存等热点数据缓存;使用“先扣减缓存库存,再异步同步数据库”的模式,减少数据库同步操作。

缓存层优化:Django 缓存框架+Redis 集群

- 配置 Django 缓存:使用 Redis 作为缓存后端(比 Django 默认的内存缓存更适合分布式场景),在

中配置:settings.pyCACHES = { 'default': { 'BACKEND': 'django_redis.cache.RedisCache', 'LOCATION': 'redis://redis-cluster:6379/1', 'OPTIONS': { 'CLIENT_CLASS': 'django_redis.client.DefaultClient', 'CONNECTION_POOL_KWARGS': {'max_connections': 1000}, # 缓存连接池 'PASSWORD': 'redis-password', } } } - 热点数据缓存:将商品库存、活动状态、商品详情等热点数据缓存到 Redis,缓存过期时间设置为 5 分钟(活动期间可缩短至 1 分钟,确保数据一致性)。示例:

# 缓存商品库存 def get_goods_stock(goods_id): cache_key = f'goods_stock_{goods_id}' stock = cache.get(cache_key) if stock is None: # 缓存穿透:查询数据库并写入缓存 goods = Goods.objects.get(id=goods_id) stock = goods.stock cache.set(cache_key, stock, 60) # 缓存 60 秒 return stock - 缓存防穿透与雪崩:为不存在的商品 ID 缓存空值(防止恶意请求穿透到数据库);缓存过期时间添加随机值(如 60±5 秒),防止大量缓存同时过期导致缓存雪崩;使用 Redis 集群(主从+哨兵)确保缓存高可用,防止缓存单点故障。

数据库层优化:锁机制+SQL 优化+连接池调整

- 库存扣减并发控制:使用数据库行锁确保库存扣减的原子性,防止超卖。修改库存扣减 SQL 为:

该 SQL 利用# 行锁:仅锁定当前商品的行,不影响其他商品 updated_rows = Goods.objects.filter(id=goods_id, stock__gt=0).update(stock=F('stock')-1) if updated_rows == 0: # 库存不足,返回失败 return JsonResponse({'code': 400, 'msg': '库存不足'})

条件和stock__gt=0

表达式实现原子更新,防止并发更新冲突;同时使用行锁而非表锁,减少锁竞争。F() - SQL 优化:为商品表的

字段(主键,默认索引)和id

字段添加索引(stock

),提高查询和更新效率;避免 SELECT *,只查询需要的字段(如仅查询CREATE INDEX idx_goods_stock ON goods(stock)

字段,而非整个商品信息)。stock - 数据库连接池调整:修改 Django 数据库连接池配置,增加最大连接数(

设为 300 秒,CONN_MAX_AGE

设为 200),确保高并发下有足够的数据库连接;使用数据库读写分离(主库写入库存,从库查询商品信息),分担主库压力。MAX_CONNECTIONS

基础设施层优化:静态资源 CDN+服务器扩容

- 静态资源 CDN 加速:将商品图片、活动页面 CSS/JS 等静态资源上传到阿里云 CDN,通过 CDN 分发静态资源,减轻源服务器带宽压力;配置 CDN 缓存策略(静态资源缓存 1 天),减少回源请求。

服务器扩展与负载均衡:将应用服务器由 2 台扩展到 4 台,通过 Nginx 负载均衡分配请求(采用循环策略);配置 Nginx 限速(

limit_req_zone异步处理:非关键流程异步化 :将订单创建后的非关键流程(例如发送短信通知、记录日志、发放积分)异步化,使用 Django Celery 作为任务队列,Redis 作为消息中间件。示例:

# 定义异步任务(tasks.py)

@shared_task

def send_seck边界测试是在软件测试中针对 “输入 / 输出数据的边缘值、业务逻辑的边缘条件、系统资源的极限状态” 进行的测试,主要目的是找出 “边缘值附近的异常行为”——因为软件在边缘条件下更容易出现逻辑缺陷、数据溢出、权限超越等问题。我在电商订单系统、用户管理模块、支付接口测试中多次实施边界测试,以下结合具体场景说明测试思路、方法和实际案例。

一、边界测试的主要测试场景(按类别划分)

边界测试的场景可以归结为 “数据边界、逻辑边界、资源边界、权限边界” 四大类,每个场景都围绕 “边缘值 ±1”“是否触发阈值”“是否突破限制” 设计测试用例:

- 数据边界测试(最常使用,关注输入 / 输出数据的边缘值)

数据边界主要涉及数值型、字符串型、日期型、集合型数据的取值范围、长度限制等,测试用例设计遵循 “最小值、最小值 - 1、最大值、最大值 + 1、默认值、空值、特殊值” 的原则。

示例场景 1: 电商订单金额输入(业务规则:订单金额≥0.01 元,≤100000 元,支持两位小数)

测试用例:

- 最小值:0.01 元 → 预期:提交成功,生成订单。

- 最小值 - 1:0.00 元 → 预期:提示 “订单金额不能小于 0.01 元”,提交失败。

- 最大值:100000.00 元 → 预期:提交成功,生成订单(若超出风控限额需额外校验,此处仅测试金额本身的边界)。

- 最大值 + 1:100000.01 元 → 预期:提示 “订单金额不能超过 100000 元”,提交失败。

- 特殊小数:0.009 元(三位小数)→ 预期:自动保留两位小数(0.01 元)或提示 “仅支持两位小数”。

- 非数值型:输入 “abc”“123.456.78”→ 预期:提示 “请输入合法金额”,提交失败。

测试方法: 手动输入 + 自动化脚本批量注入边缘值,结合接口测试工具(Postman、JMeter)发送请求,验证响应结果。

示例场景 2: 用户注册手机号长度(业务规则:中国大陆手机号,11 位数字)

测试用例:

- 10 位数字:1380013800 → 预期:提示 “手机号格式错误”。

- 11 位数字:13800138000 → 预期:格式校验通过。

- 12 位数字:138001380000 → 预期:提示 “手机号格式错误”。

- 空值:不输入手机号 → 预期:提示 “手机号为必填项”。

- 特殊字符:1380013800a、138-0013-8000 → 预期:提示 “手机号格式错误”。

测试方法: 前端表单输入测试 + 接口直接传参测试(绕过前端校验,验证后端接口是否同样做了边界限制,避免前端校验被绕过导致的漏洞)。

- 逻辑边界测试(关注业务规则的边缘条件)

逻辑边界是指业务流程中触发规则切换、状态变更的边缘条件,例如 “数量达标触发折扣”“时间节点切换活动状态”“次数限制触发封禁” 等。

示例场景: 限时秒杀活动(业务规则:活动时间为 2024-06-01 10:00:00 至 2024-06-01 10:30:00;每人限购 5 件;库存≤0 时活动自动结束)

测试用例:

- 时间边界 - 活动开始前:2024-06-01 09:59:59 → 预期:提示 “活动未开始”,无法下单。

- 时间边界 - 活动开始瞬间:2024-06-01 10:00:00 → 预期:可正常下单。

- 时间边界 - 活动结束前:2024-06-01 10:29:59 → 预期:可正常下单(若库存充足)。

- 时间边界 - 活动结束后:2024-06-01 10:30:00 → 预期:提示 “活动已结束”,无法下单。

- 限购数量边界:第 5 件下单 → 预期:下单成功;第 6 件下单 → 预期:提示 “每人限购 5 件”。

- 库存边界:库存剩余 1 件时下单 1 件 → 预期:下单成功,库存变为 0;库存为 0 时下单 → 预期:提示 “商品已售罄”。

测试方法: 通过修改本地时间、接口传参篡改时间戳(验证后端时间校验)、批量下单脚本模拟限购数量、手动调整数据库库存模拟库存边界,验证业务逻辑是否符合预期。

- 资源边界测试(关注系统资源的极限状态)

资源边界指的是系统硬件、软件资源的最大承受限度,比如 “并发连接数上限”“文件上传大小限制”“数据库查询结果集上限” 等,测试的目标在于检验系统在资源极限情况下的稳定性和容错性。

示例场景:文件上传接口(业务规则:允许上传图片格式,单个文件大小≤5MB,单次最多上传 3 个文件)

测试用例:

- 单个文件大小边界:5MB → 预期:上传成功;5.1MB → 预期:提示 “文件大小不能超出 5MB”。

- 单次上传数量边界:3 个文件(每个 2MB)→ 预期:上传成功;4 个文件 → 预期:提示 “单次最多上传 3 个文件”。

- 极端文件:0KB 空文件 → 预期:提示 “文件不能为空”;格式正确但内容异常(如图片文件更改为.jpg 的文本文件)→ 预期:提示 “文件格式不合法” 或 “文件损坏”。

测试方法:采用 JMeter 创建大文件上传请求、Python 脚本批量生成文件模拟数量边界、更改文件后缀和内容模拟异常文件,检查系统是否会崩溃、是否提供了合理的错误提示。

4. 权限边界测试(集中于用户权限的边缘范围)

权限边界是指不同用户角色的操作权限边缘值,比如 “普通用户能否访问管理员接口”“低等级用户能否修改高等级数据”“权限过期后能否继续操作” 等。

示例场景:后台订单管理系统(业务规则:超级管理员可以查看所有订单,普通管理员只能查看本门店订单,普通员工只能查看自己创建的订单)

测试用例:

- 普通管理员访问超级管理员接口:调用 “查询所有门店订单” 接口 → 预期:返回 403 权限不足,或者只返回本门店订单。

- 普通员工修改其他员工创建的订单:调用 “修改订单状态” 接口,传递其他员工创建的订单 ID → 预期:返回 403 权限不足。

- 权限过期边界:用户权限有效期至 2024-06-01,2024-06-02 登录后操作 → 预期:提示 “权限已过期,请重新申请”,无法执行操作。

测试方法:使用不同角色的 Token 调用接口(验证后端权限验证)、篡改接口参数中的订单 ID / 门店 ID(验证数据级别的权限)、调整数据库中用户权限过期时间(验证时间边缘值)。

二、边界测试的关键方法与工具

用例设计方法

- 等价类划分法 + 边界值分析法:首先将输入数据划分为有效的等价类(符合业务规则)和无效的等价类(不符合业务规则),然后在每个等价类的边界设计测试用例(如有效等价类的最小值、最大值,无效等价类的边缘值),既减少了用例数量又覆盖了核心边界。

- 场景法:梳理完整的业务流程,识别流程中的边界节点(如时间点、状态变更节点),设计场景化的测试用例(如秒杀活动的 “开始前 - 开始时 - 结束时 - 结束后” 完整场景)。

测试工具

- 接口测试:Postman(手动构建边界值请求)、JMeter(批量生成边界值请求、并发测试)、Python requests 库(编写自动化脚本注入边界值)。

- 前端测试:浏览器开发者工具(篡改表单输入、修改时间戳)、Selenium(模拟前端输入边界值)。

- 数据库辅助:手动修改数据库中的边缘数据(如库存、权限过期时间),验证系统对数据边界的处理。

注意事项

- 需要同时验证前端和后端的边界限制:前端可能有表单验证,但后端必须重复验证(防止前端验证被绕过,如通过接口直接传参)。

- 边界测试需结合异常处理测试:不仅验证边界值是否被拒绝,还需验证拒绝后的错误提示是否明确、系统是否不会崩溃(如大文件上传时是否出现 OOM)。

- 资源边界测试应在测试环境中进行:避免在生产环境中触发系统资源极限,导致服务不可用。

面试加分点

能够区分不同类型的边界场景(数据、逻辑、资源、权限),并结合实际业务设计测试用例;提到 “前端 + 后端双重验证” 的测试思路(防止漏洞);结合自动化工具阐述高效的测试方法;说明边界测试中发现的实际问题(如 “曾通过最大值 + 1 测试发现订单金额溢出漏洞,导致超限额订单提交成功”),体现实践价值。

记忆法

分类 - 场景 - 用例关联记忆法 —— 先按 “数据、逻辑、资源、权限” 分类,每类对应 1-2 个核心业务场景,每个场景围绕 “边缘值 ±1、是否触发规则、是否突破限制” 设计用例,形成 “分类→场景→用例” 的逻辑链条;关键词提炼记忆法 —— 每个场景提炼核心关键词(如数据边界记 “范围、长度、格式”,逻辑边界记 “时间、数量、状态”),快速联想到测试的重点。

Kubernetes(K8s)包含哪些核心组件?各组件的主要功能是什么?

Kubernetes(K8s)是基于容器的分布式集群管理平台,核心组件按照 “控制平面(Control Plane)” 和 “节点(Node)” 两层架构划分,控制平面负责集群的全局决策与管理,节点负责容器的实际运行与资源提供,组件之间通过 API Server 实现通信,共同实现 “容器编排、资源调度、服务发现、故障自愈” 等核心能力。

一、核心组件分类与功能详解

1. 控制平面组件(集群大脑,通常部署在主节点 Master)

控制平面组件负责集群的管理、调度、决策,即使部分组件故障,也能通过高可用部署(如多 Master 节点)保障集群稳定。核心组件包括 API Server、etcd、Scheduler、Controller Manager、Cloud Controller Manager。

API Server(应用程序接口服务器)

核心功能:K8s 集群的“统一入口”,所有组件(如 Scheduler、Controller Manager、kubelet)和外部工具(如 kubectl)都通过 API Server 与集群互动(接收请求、验证请求、执行操作);提供 RESTful API 接口,支持 JSON/YAML 格式的资源操作(如创建 Pod、Service);实现认证(Authentication)、授权(Authorization)、准入控制(Admission Control),确保请求的合法性。

关键特性:无状态设计,支持横向扩展(多实例部署);所有集群状态都通过 API Server 写入 etcd,自身不存储数据,仅作为“中介代理”。

作用场景:kubectl 命令执行(如

kubectl create podetcd(分布式键值数据库)

核心功能:K8s 集群的“数据中枢”,存储集群的所有状态信息(如 Pod 配置、Service 定义、节点信息、权限规则);提供强一致性、高可用的键值存储(基于 Raft 协议),确保集群数据不丢失、不冲突。

关键特性:默认仅存储集群核心数据(不存储容器日志、业务数据);支持数据备份与恢复;通常部署 3 个或 5 个节点(奇数节点,满足 Raft 协议的高可用要求)。

作用场景:API Server 写入资源配置后,etcd 持久化存储;组件(如 Scheduler)通过 API Server 查询 etcd 中的资源状态,执行调度决策。

Scheduler(调度器)

核心功能:负责“Pod 调度”,即根据 Pod 的资源需求(如 CPU、内存)、节点的资源剩余情况、调度策略(如亲和性、反亲和性、污点与容忍度),为新创建的 Pod 选择最合适的 Node 节点。

调度流程:① 监听 API Server,发现未分配节点的 Pod(Pending 状态);② 过滤节点(如节点资源是否满足 Pod 需求、节点是否有污点导致 Pod 无法调度);③ 打分节点(如节点资源利用率、Pod 与节点的亲和性得分);④ 选择得分最高的节点,通过 API Server 将 Pod 绑定到该节点。

关键特性:支持自定义调度策略(如基于 GPU、存储类型的调度);仅负责“调度决策”,不负责 Pod 的创建与运行(由 kubelet 执行)。

作用场景:创建无指定节点的 Pod 时,Scheduler 自动分配节点;基于业务需求配置亲和性(如将数据库 Pod 与缓存 Pod 调度到同一节点,减少网络延迟)。

Controller Manager(控制器管理器)

核心功能:运行集群中的各类控制器(Controller),负责“维护集群状态”,确保实际状态与期望状态一致(如 Pod 故障后自动重启、副本集保持指定数量的 Pod 运行)。

核心控制器包括:

- 副本集控制器(ReplicaSet Controller):监控 ReplicaSet,确保 Pod 副本数等于期望数(如副本数为 3,某 Pod 故障则自动创建新 Pod)。

- 节点控制器(Node Controller):监控节点状态,若节点故障(如失联),将该节点上的 Pod 调度到其他健康节点。

- 端点控制器(Endpoint Controller):维护 Service 与 Pod 的关联关系(Endpoint 对象),实现 Service 的负载均衡。

- 命名空间控制器(Namespace Controller):监控命名空间的创建与删除,清理命名空间下的资源。

关键特性:多控制器并行运行,每个控制器独立监控一类资源;通过 API Server 查询实际状态,对比期望状态,执行调和操作(Reconciliation)。

作用场景:Pod 意外终止后自动重启、扩容 ReplicaSet 时自动创建新 Pod、节点下线后迁移 Pod。

Cloud Controller Manager(云控制器管理器)

核心功能:对接云服务提供商(如阿里云、AWS、腾讯云)的 API,将 K8s 集群与云服务集成,实现“云资源的自动化管理”(如自动创建云服务器、负载均衡器、存储卷)。

核心控制器包括:

节点控制器(Cloud Node Controller):在云环境里生成 / 撤销节点(例如自动扩展 ECS 实例)。

负载均衡控制器(Service Controller):为 K8s 的 Service 自动设置云服务提供商的负载均衡器(比如阿里云 SLB)。

存储卷控制器(Volume Controller):为 PersistentVolume 自动配置云存储(例如阿里云 OSS、EBS)。

关键特性:仅在云端部署,物理机 / 私有集群可以省去;分离 K8s 核心代码与云服务商特定逻辑,便于拓展。

作用场景:在阿里云 EKS 中建立 Service(Type=LoadBalancer)时,自动创建 SLB 并链接节点。

2. 节点组件(工作节点,部署在所有 Worker 节点)

节点组件负责在每个工作节点上执行容器、监管容器生命周期、与控制平面交流,主要组件包含 kubelet、kube-proxy、容器运行时(Container Runtime)。

kubelet(节点代理)

核心功能:每个 Node 节点必备的组件,负责 “监管节点上的 Pod 与容器”,确保 Pod 按设定运行(如启动容器、监测容器状态、报告节点与 Pod 状态)。

核心职责:

- 接收 API Server 的 Pod 设置(通过监听器或定时查询),调用容器运行时创建容器。

- 监控 Pod 与容器的状态(如 CPU / 内存使用情况、容器是否正常运行),通过 liveness probe(存活探测)和 readiness probe(就绪探测)评估 Pod 健康状况,如果容器出错则重启(依据 Pod 重启策略)。

- 向 API Server 报告节点状态(如资源剩余量、节点健康状况)和 Pod 状态(如 Running、Pending、Failed),供控制平面组件参考。

- 管理 Pod 的存储卷(如挂载 PersistentVolume、ConfigMap、Secret 至容器)。

关键特性:仅监管 API Server 分配给该节点的 Pod,不涉及其他节点的 Pod;严格遵循 Pod Spec 执行任务,不擅自更改配置。

作用场景:创建 Pod 后,kubelet 在节点上启动容器;Pod 的存活探测发现容器无响应时,kubelet 重启容器;节点资源不足时,kubelet 上报状态,帮助 Scheduler 避免将新 Pod 调度至该节点。

kube-proxy(网络代理)

核心功能:每个 Node 节点必备的组件,负责 “实现 K8s 的 Service 网络功能”,涵盖 Service 的负载均衡、Pod 之间的网络通信、外部流量转至 Pod。

核心工作模式:

- 用户空间模式(UserSpace):kube-proxy 在用户空间监听 Service 端口,接收请求后转发至后端 Pod,性能较低(已淘汰)。

- iptables 模式(iptables):kube-proxy 通过配置节点的 iptables 规则,将 Service 的 IP:Port 映射至后端 Pod 的 IP:Port,请求直接由内核转发,性能较高(默认模式)。

- IPVS 模式(IPVS):基于 Linux IPVS 内核模块实现,支持更多的负载均衡算法(如轮询、加权轮询、最少连接),性能优于 iptables,适用于高并发场景。

关键职责:监控 API Server 的 Service 与 Endpoint 变更,动态更新 iptables/IPVS 规则;实现 Pod 访问 Service 时的负载均衡(将请求分配到不同的 Pod);实现外部流量访问 Service(如 NodePort、LoadBalancer 类型的 Service)。

作用场景:Pod 通过 Service 名称访问其他 Pod 时,kube-proxy 将请求转发至后端健康的 Pod;外部客户端通过 NodePort 访问 Service 时,kube-proxy 将节点端口的请求转发至 Pod。

容器运行时(Container Runtime)

核心功能:K8s 的 “容器运行基础”,负责容器的创建、启动、停止、删除等生命周期管理,需遵守 CRI(容器运行时接口)标准。

常用运行时:

- Docker:最广泛使用的容器运行时(早期 K8s 默认),但 K8s 1.24 + 版本已不再直接支持 Docker,需通过 cri-dockerd 适配。

- containerd:Docker 的核心部分,轻便且专注于容器运行时,支持 CRI,是当前 K8s 推荐的运行时。

- CRI-O:专为 K8s 设计的容器运行时,全面兼容 CRI,没有额外功能,轻量化。

- rkt:CoreOS 开发的容器运行时,强调安全性,支持 ACI 镜像格式。

关键特性:负责容器镜像的获取(从镜像库下载镜像)、容器网络设置(为容器分配 IP 地址)、容器存储连接(将数据卷挂载至容器);通过 CRI 与 kubelet 通讯,接受 kubelet 的容器操作指令。

作用场景:kubelet 创建 Pod 时,调用容器运行时下载镜像并启动容器;容器停止时,容器运行时清除容器资源(例如网络、存储)。

二、组件间核心互动流程(以创建 Pod 为例)

用户通过 kubectl 执行

kubectl create -f pod.yamlAPI Server 校验请求的有效性(例如用户权限、Pod 配置格式),将 Pod 配置记录到 etcd。

Scheduler 监听 API Server,识别未分配节点的 Pod,执行调度策略,挑选合适的 Node 节点,通过 API Server 更新 Pod 的节点绑定详情(录入 etcd)。

目标 Node 节点的 kubelet 监听 API Server,发现分配给自己的 Pod,调用容器运行时(例如 containerd)下载镜像、创建容器。

容器运行时完成容器创建与启动后,kubelet 向 API Server 上报 Pod 状态(运行中),API Server 更新 etcd 中的 Pod 状态。

若 Pod 配置了 Service,kube-proxy 监听 API Server 的 Endpoint 变更,更新 iptables 规则,实现 Service 对 Pod 的负载均衡。

面试加分点 :能明确区分控制平面与节点组件的责任界限;深入解释核心组件的互动流程(如创建 Pod 的完整路径);提到 CRI、etcd 高可用部署、kube-proxy 不同工作模式等细节;结合实际场景描述组件功能(如 “高并发环境下选用 IPVS 模式的 kube-proxy”);阐述云环境与物理机环境中组件的区别(如是否包含 Cloud Controller Manager)。

记忆法 :分层 - 职责 - 互动记忆法 —— 先按 “控制平面(决策)+ 节点(执行)” 分层,每层组件按 “主要职责 + 关键功能” 记忆,再通过 “创建 Pod” 的互动流程串联所有组件,理解组件间的依赖关系;关键词提炼记忆法 —— 控制平面组件记 “API Server(入口)、etcd(存储)、Scheduler(调度)、Controller Manager(控制)、Cloud Controller Manager(云对接)”,节点组件记 “kubelet(节点管理)、kube-proxy(网络)、容器运行时(容器运行)”,快速掌握核心组件及其定位。

Kubernetes(K8s)的 kubectl 常用命令有哪些?请举例说明其使用场景?

kubectl 是 Kubernetes 集群的命令行工具,主要用于与集群 API Server 交互,实现资源的创建、查询、更新、删除(CRUD)、故障诊断、集群管理等操作。日常使用围绕 “资源操作、集群监控、故障诊断、配置管理” 四大核心场景,以下是高频命令及其具体应用场景,结合实际运维需求说明用法,避免单纯列举语法。

一、资源操作类命令(最常用,管理 Pod、Service、Deployment 等资源)

资源操作遵循 “

kubectl [命令] [资源类型] [资源名称] [选项]createapplygetdescribedeletekubectl create/apply

:创建 / 更新资源,

apply场景 1:通过 YAML 文件创建 Deployment(部署应用)。命令:

kubectl apply -f nginx-deploy.yamlapplycreate -fcreate场景 2:快速创建临时 Pod(测试用途)。命令:

kubectl run nginx-test --image=nginx:1.21 --port=80create podrun场景 3:创建 Service(暴露 Deployment)。命令:

kubectl expose deploy nginx-deploy --type=NodePort --port=80 --target-port=80type=NodePort节点IP:节点端口kubectl get

:查询资源状态,支持多种输出格式(默认、wide、json、yaml)。

情景 1:检查所有 Pod 的基础详情(名称、状况、节点、重启次数)。命令:

kubectl get pods(简写:

kubectl get po)

情景 2:检查 Pod 的详尽详情(包括 Pod IP、节点 IP)。命令:

kubectl get pods -o wide情景 3:检查特定命名空间的 Deployment(例如生产环境命名空间 prod)。命令:

kubectl get deploy -n prod情景 4:检查所有资源的状况(迅速审核集群资源)。命令:

kubectl get all(涵盖 Pod、Deployment、Service、ReplicaSet 等)

情景 5:以 JSON 格式导出 Pod 详情(供脚本解析)。命令:

kubectl get pod nginx-pod -o jsonkubectl describe:检查资源的详尽描述详情(包括事件、设置、相关资源),用于故障诊断。

情景 1:Pod 启动失败(状态为 Pending/CrashLoopBackOff),探究原因。命令:

kubectl describe pod nginx-pod说明:输出中的 “Events” 部分将揭示关键信息,比如 “镜像拉取失败(ImagePullBackOff)”“节点资源短缺(Insufficient CPU)”“权限受限(PermissionDenied)”,这是确定 Pod 启动问题的关键命令。

情景 2:检查 Deployment 的详尽设置与事件(如扩展、滚动更新记录)。命令:

kubectl describe deploy nginx-deploy说明:可以查看 Deployment 的副本数量、Pod 模板、滚动更新策略,以及是否有 Pod 创建失败、扩展失败等事件。

kubectl delete:移除资源,支持通过名称、YAML 文件、标签移除。

情景 1:移除特定 Pod。命令:

kubectl delete pod nginx-pod情景 2:通过 YAML 文件移除资源(与创建时的文件相同)。命令:

kubectl delete -f nginx-deploy.yaml情景 3:移除所有带有标签

app=nginx的 Pod(批量移除)。命令:

kubectl delete pods -l app=nginx(

-l指定标签选择器)

情景 4:移除整个命名空间(适合测试环境,谨慎操作)。命令:

kubectl delete namespace test(将移除命名空间下的所有资源)

第二部分、集群监控与管理类命令(检查集群状态、节点详情、日志)

这些命令用于监控集群健康状况、节点资源、应用日志,核心包含

logs、

top、

get nodes、

cluster-info。

kubectl logs:检查 Pod 内容器的日志,用于排查应用运行时的错误。

情景 1:检查特定 Pod 的日志(默认检查第一个容器)。命令:

kubectl logs nginx-pod情景 2:检查 Pod 内特定容器的日志(当 Pod 包含多个容器时)。命令:

kubectl logs nginx-pod -c nginx-container(

-c指定容器名称)

情景 3:实时检查日志(类似于

tail -f)。命令:

kubectl logs nginx-pod -f情景 4:检查日志的最后 100 行,并持续追踪。命令:

kubectl logs nginx-pod --tail=100 -f情景 5:检查指定时间段内的日志(排查历史问题)。命令:

kubectl logs nginx-pod --since=1h(检查 1 小时内的日志)

kubectl top:检查节点或 Pod 的 CPU、内存使用率(需部署 metrics-server 组件)。

情景 1:检查所有节点的资源使用率(排查节点负载过高的问题)。命令:

kubectl top nodes说明:输出节点的 CPU 使用率、内存使用率,如果某个节点的 CPU 使用率达到 100%,则需要进一步检查该节点上的 Pod 资源占用情况。

情景 2:检查所有 Pod 的资源使用率(定位高资源占用的 Pod)。命令:

kubectl top pods情景 3:检查特定命名空间的 Pod 资源使用率。命令:

kubectl top pods -n prodkubectl get nodes:检查集群节点的状态与详情。

情景 1:检查所有节点的基础状态(是否 Ready)。命令:

kubectl get nodes情景 2:检查节点的详尽详情(例如 CPU、内存总量、内核版本、容器运行时)。命令:

kubectl describe node node-1说明:用于排查节点不可用(NotReady)的原因,如 “节点磁盘已满”“容器运行时故障”“网络不通” 等,Events 部分会显示节点的状态变化事件。

kubectl cluster-info:检查集群核心组件的访问地址(验证集群是否正常运作)。

情景:集群部署后,验证 API Server、etcd、kube-dns 等组件是否可用。命令:

kubectl cluster-info说明:如果输出 “Kubernetes control plane is running at https://xxx”“CoreDNS is running at https://xxx/api/v1/namespaces/kube-system/services/kube-dns:dns/proxy”,则表示集群核心组件运行正常。

第三部分、故障排查与调试类命令(进入容器、执行命令、端口转发)

这类指令用于直接操控 Pod 内的容器,解决应用运行期间的问题,主要包括

execcpport-forwarddebugkubectl exec:进入 Pod 的容器,或在容器内运行命令(类似于

docker exec情景 1:进入 nginx-pod 的容器,交互式执行命令。命令:

kubectl exec -it nginx-pod -- /bin/bash-itlspscurl情景 2:在容器内运行单一命令(无需进入容器)。命令:

kubectl exec nginx-pod -- curl -I http://localhost:80kubectl cp:在本地机器与 Pod 的容器间复制文件。

情景 1:将本地的配置文件复制到 Pod 的容器中。命令:

kubectl cp local-config.conf nginx-pod:/etc/nginx/conf.d/情景 2:将 Pod 容器中的日志文件复制到本地(用于离线分析)。命令:

kubectl cp nginx-pod:/var/log/nginx/access.log ./local-access.logkubectl port-forward:将本地端口转发到 Pod 的端口(实现本地访问 Pod)。

情景:从本地开发环境访问集群中未公开 Service 的 Pod(比如数据库 Pod)。命令:

kubectl port-forward pod/mysql-pod 3306:3306localhost:3306kubectl debug:创建用于调试的 Pod 副本,或在现有 Pod 中添加调试容器(K8s 1.18 + 版本支持)。

情景:Pod 启动失败(比如缺少依赖工具),创建调试副本。命令:

kubectl debug nginx-pod -it --image=busybox --share-processes四、配置管理类指令(管理 ConfigMap、Secret、Namespace)这类指令用于管理集群的配置资源,主要涵盖

create configmapcreate secretcreate namespacekubectl create configmap:创建配置映射(存储非敏感配置,如应用配置文件、环境变量)。

情景:通过本地配置文件创建 ConfigMap,并挂载到 Pod 中。命令:

kubectl create configmap nginx-config --from-file=./nginx.confkubectl create secret:创建密钥(存储敏感信息,如密码、API 密钥,数据会被 base64 编码)。

情景:创建数据库密码的 Secret,供 Pod 使用。命令:

kubectl create secret generic mysql-secret --from-literal=password=123456generic--from-literalkubectl create namespace:创建命名空间(用于资源隔离,如开发、测试、生产环境分离)。

情景:创建生产环境命名空间 prod。命令:

kubectl create namespace prod-n prod面试加分点:能够区分

createapplydescribelogsexec--namespace-l-okubectl configkubectl rollout记忆技巧:情景 - 指令 - 用法关联记忆法 —— 将指令与关键情景联系起来(如 “创建资源→apply/create”“排查 Pod 故障→describe+logs+exec”“查看资源→get”“删除资源→delete”),通过情景联想到相应的指令及其选项;关键词缩写记忆法 —— 资源类型缩写(po=Pod、deploy=Deployment、svc=Service、cm=ConfigMap、sec=Secret),指令缩写(k=kubectl,需配置别名)

alias k=kubectlRedisClusterclient-gokubernetes-clientcurl -LO https://github.com/operator-framework/operator-sdk/releases/download/v1.32.0/operator-sdk_linux_amd64 && chmod +x operator-sdk_linux_amd64 && mv operator-sdk_linux_amd64 /usr/local/bin/operator-sdkkind create clusterminikube startkubectl config use-context kind-kindCRD 是 K8s 中 “自定义资源的元数据定义”,类似于为自定义资源(如

RedisCluster核心步骤:

- 定义资源标识:Group(例如

)、Version(例如cache.example.com

)、Kind(例如v1

),资源名称(复数形式,例如RedisCluster

)。redisclusters - 设计 Spec 字段(用户可配置的预期状态):比如副本数量、Redis 版本、内存容量、主从架构(主节点数量、从节点数量)、备份策略(备份频率、备份保存天数)。示例 Spec 结构:

type RedisClusterSpec struct { Replicas int32 `json:"replicas"` // 总副本数 Version string `json:"version"` // Redis版本 Memory string `json:"memory"` // 单节点内存大小(如"2Gi") MasterCount int32 `json:"masterCount"` // 主节点数 BackupPolicy BackupPolicy `json:"backupPolicy"` // 备份策略 } type BackupPolicy struct { Schedule string `json:"schedule"` // 备份周期(如"0 3 * * *") RetentionDays int32 `json:"retentionDays"` // 备份保留天数 } - 设计 Status 字段(Controller 维护的现状):比如当前副本数量、运行状态(运行中/更新中/失败)、主节点列表、从节点列表、最近备份时间。示例 Status 结构:

type RedisClusterStatus struct { ReadyReplicas int32 `json:"readyReplicas"` // 就绪副本数 Phase string `json:"phase"` // 运行状态 Masters []string `json:"masters"` // 主节点Pod名称列表 Slaves []string `json:"slaves"` // 从节点Pod名称列表 LastBackupTime metav1.Time `json:"lastBackupTime"` // 最新备份时间 } - 生成 CRD YAML 文件:通过 Operator SDK/Kubebuilder 自动生成,例如

,会自动生成 CRD 的 Go 结构体和 YAML 文件(位于operator-sdk create api --group cache --version v1 --kind RedisCluster --resource --controller

目录)。config/crd/bases/

3. Controller 开发(核心逻辑:调谐循环 Reconciliation)

Controller 是 Operator 的 “核心”,关键是 “调谐循环(Reconciliation Loop)”—— 持续监控自定义资源(如

RedisCluster核心职责与开发步骤:

- 监控资源变化:通过 Informer 机制监控

资源、相关的 Pod、Service、ConfigMap 等资源的创建 / 更新 / 删除事件,触发 Reconcile 函数。RedisCluster - 数据查询:在 Reconcile 函数中,通过 client-go 查询

的 Spec(预期状态)和当前相关资源的现状(如 Pod 是否存在、运行状态)。RedisCluster - 调谐操作(核心逻辑):

- 创建 ConfigMap/Secret:生成 Redis 配置文件(例如

),存储至 ConfigMap;生成密码等敏感信息,存储至 Secret。redis.conf - 创建 StatefulSet:基于 Spec 创建 StatefulSet(用于管理有状态的应用,如 Redis 主从集群),配置 Pod 模板(镜像、资源限制、挂载 ConfigMap/Secret、持久化存储)。

- 创建 Service:创建 Headless Service(用于 Redis 节点间的通讯)和 ClusterIP Service(用于外部访问)。

- 状态更新:当 Pod 就绪、主从复制完成后,更新

的 Status 字段(如 ReadyReplicas、Masters、Phase)。RedisCluster - 备份执行:依据 BackupPolicy 的 Schedule,通过 CronJob 定期执行备份脚本,备份 Redis 数据至存储卷,并更新 LastBackupTime。

- 故障自愈:若某 Pod 出现故障,StatefulSet 自动重启;若主节点出现故障,执行主从切换(将从节点提升为新的主节点),更新 Status 中的 Masters 列表。

- 创建 ConfigMap/Secret:生成 Redis 配置文件(例如

- 错误处理:Reconcile 函数执行失败时(如 Pod 创建失败),返回错误信息,Controller 会自动重试(默认重试间隔递增);若为不可恢复错误(如资源配额不足),更新 Status 的 Phase 为 Failed,并记录事件。

关键代码逻辑示例(Reconcile 函数核心流程):

func (r *RedisClusterReconciler) Reconcile(ctx context.Context, req ctrl.Request) (ctrl.Result, error) {

log := log.FromContext(ctx)

// 1. 查询当前RedisCluster资源

redisCluster := &cachev1.RedisCluster{}

if err := r.Get(ctx, req.NamespacedName, redisCluster); err != nil {

return ctrl.Result{}, client.IgnoreNotFound(err)

}

// 2. 检查并创建ConfigMap和Secret

if err := r.ensureConfigMap(ctx, redisCluster); err != nil {

return ctrl.Result{}, err

}

if err := r.ensureSecret(ctx, redisCluster); err != nil {

return ctrl.Result{}, err

}

// 3. 检查并创建StatefulSet

statefulSet, err := r.ensureStatefulSet(ctx, redisCluster)

if err != nil {

return ctrl.Result{}, err

}

// 4. 检查并创建Service

if err := r.ensureServices(ctx, redisCluster); err != nil {

return ctrl.Result{}, err

}

// 5. 更新RedisCluster的Status

if err := r.updateStatus(ctx, redisCluster, statefulSet); err != nil {

return ctrl.Result{}, err

}

// 6. 检查并创建备份CronJob

if err := r.ensureBackupCronJob(ctx, redisCluster); err != nil {

return ctrl.Result{}, err

}

return ctrl.Result{}, nil

}4. 测试验证(本地测试 + 集群测试)

测试的核心在于 “验证 Controller 是否能准确响应资源变化,实现预期状态与现状一致”,分为本地测试和集群测试:

本地测试:

- 启动本地 K8s 集群(kind/minikube),部署 CRD:

。kubectl apply -f config/crd/bases/cache.example.com_redisclusters.yaml - 启动 Controller 本地调试:通过 delve 或 IDE(如 Goland)启动 Controller,连接本地集群,监控资源变化。

- 创建自定义资源实例:编写

,执行redis-cluster-sample.yaml

,观察 Controller 是否自动创建 StatefulSet、Service、ConfigMap 等资源。kubectl apply -f redis-cluster-sample.yaml - 验证生命周期操作:

- 扩容:修改

的 Replicas 字段,执行redis-cluster-sample.yaml

,观察 StatefulSet 是否扩容。kubectl apply

- 扩容:修改

备份:检查 CronJob 是否依据时间表执行,是否生成了备份文件。

故障恢复:移除某个 Pod,观察 StatefulSet 是否重启 Pod,Controller 是否更新状态。

集群测试:

构建 Controller 镜像:

docker build -t redis-operator:v1.0 .,推送至镜像库(如 Docker Hub、私有仓库)。

生成部署文件:利用 Operator SDK 生成 Deployment YAML(

config/manager/manager.yaml),调整镜像路径为已构建的镜像。

部署 Operator 至集群:

kubectl apply -f config/manager/manager.yaml,建立 ClusterRole、ClusterRoleBinding(赋予 Operator 操作资源的权限)。

重复本地测试的验证步骤,保证在集群环境下的功能正确无误。

5. 部署运维与监控

部署优化:

权限管理:借助 RBAC(基于角色的访问控制)严格限定 Operator 的权限,仅提供必要的资源操作权限(如创建 Pod、StatefulSet、Service 的权限),防止过度授权。

高可用部署:Operator 本身以 Deployment 形式部署,设置副本数量为 2(避免单点故障),通过 Pod 反亲和性确保副本分布在不同的节点上。

资源限制:为 Operator Pod 设定 CPU 和内存限额(如

resources: requests: {cpu: "100m", memory: "256Mi"}, limits: {cpu: "500m", memory: "512Mi"}),防止资源耗尽。

监控与日志:

指标暴露:经由 Prometheus Operator 暴露自定义指标(如

redis_cluster_ready_replicas、

redis_cluster_backup_count),配置 Grafana 面板实现监控可视化。

日志收集:将 Operator 的日志输出到标准输出流,通过 ELK、Loki 等日志系统收集,配置日志警告(如 Controller 错误次数过多)。

事件监控:K8s 事件(如

RedisCluster状态变化、备份失败)通过 kube-eventer 收集,配置报警通知(如电子邮件、钉钉)。

升级与维护:

CRD 升级:通过

kubectl apply -f更新 CRD YAML(需确保向前兼容),支持 CRD 的版本迁移(如 v1→v1beta1)。

Operator 升级:通过 Deployment 滚动更新镜像,确保升级过程不干扰正在运行的自定义资源。

三、其他扩展方式的主要开发思路(简要描述)

API Server 聚合(AA):

开发思路:建立自定义 API Server,实现自定义 API 接口;通过 APIService 资源将自定义 API 注册到原生 API Server,用户可通过

kubectl或原生 API 客户端访问自定义 API。

关键步骤:开发自定义 API Server(实现 RESTful 接口)、配置 API 服务发现、部署认证授权组件(与原生 API Server 共享认证机制)。

适用场景:需扩展复杂的 API 逻辑,如自定义资源统计、权限验证、多集群资源管理。

CSI 插件开发:

开发思路:遵循 CSI 标准,实现 Controller Service(控制层面,如创建 PV、快照)和 Node Service(节点层面,如挂载存储卷);通过 Sidecar 容器(如 csi-provisioner、csi-node-driver-registrar)与 K8s 集成。

关键步骤:实现 CSI 接口(

CreateVolume、

DeleteVolume、

NodePublishVolume等)、构建 CSI 插件镜像、部署 CSI 控制器和节点插件。

适用场景:对接企业私有存储(如分布式存储、SAN 存储),实现 K8s 与存储系统的无缝集成。

自定义 Scheduler 开发:

开发思路:基于 K8s 调度框架(Scheduler Framework),实现自定义调度插件(如 Filter、Score 插件);配置 K8s 使用自定义 Scheduler(通过 Pod 的

schedulerName字段指定)。

关键步骤:开发调度插件(实现 Filter(节点筛选)、Score(节点评分)逻辑)、编译自定义 Scheduler、部署 Scheduler 并配置与 API Server 的通信。

适用场景:需自定义调度策略,如基于 GPU 类型、存储性能、节点地理位置的调度。

面试加分项:

能够区分各种扩展方式的应用场景,结合实际业务需求选择合适的解决方案;深入阐述 CRD+Controller 的核心逻辑(协调循环、Informer 机制);提及开发过程中的关键注意事项(如向前兼容、权限管理、高可用部署);结合 Operator SDK/Kubebuilder 等工具说明提高开发效率的方法;分享实际开发案例(如“开发 Redis Operator 实现集群自动管理”),体现实战经验。

流程 - 场景 - 技术关联记忆法 —— 首先掌握二次开发的基本流程(场景选择→环境预备→核心开发→测试部署→运维监控),然后将每个步骤与具体的扩展方法(例如 CRD+Controller)的主要环节相连,通过实例场景(例如 Redis Operator)加深理解;关键词提取记忆法 —— 重点扩展方法记作 “CRD+Controller/Operator、AA、CSI/CNI/CRI、自定义调度器”,每种方法提取关键术语(例如 Operator=“CRD+Controller + 生命周期自动化”),以便迅速确定应用场景。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号