AI大模型到底是什么?

在当前的科技洪流中,“人工智能”、“大型模型”这类术语频繁出现在我们的视线中,从对话机器人、智能撰稿助手到图像生成工具,它们似乎正以前所未有的速率影响着我们的生活方式和工作模式。而推动这一切变化的重要力量之一,正是“AI大模型”。那么,这个听起来既强大又带有些许神秘色彩的“大模型”,究竟指什么呢?

一、 核心定义:规模与能力的飞跃

简而言之,AI大模型(Large AI Model)指的是参数数量极为庞大(通常在数十亿、数百亿乃至万亿级别)的深度学习模型。它是通过大量数据训练而成的复杂人工智能体系。这里的“大”,主要体现在模型的参数数量和所需训练的数据量上。

参数数量 ($n_{\theta}$) 巨大:模型参数可以视为模型在训练过程中学到的“知识”或“规则”的量化体现。一个模型拥有的参数越多,理论上它能储存和表达的知识就越丰富、越复杂。传统的小型模型可能只有数千、数百万个参数,而现代的大模型则轻易达到十亿 ($10^9$)、百亿 ($10^{10}$) 乃至万亿 ($10^{12}$) 级别。例如:$$ n_{\theta} \gg 10^9 $$ 这样的巨大参数量使模型具有捕捉数据中极细小和复杂模式的能力。

训练数据量 ($D_{\text{train}}$) 庞大:为了训练如此庞大的模型,使其获取有效知识,需向其提供大量的数据。这些数据通常来自互联网文本、书籍、代码、图像、音频等多种形式的信息。数据集的规模常达千亿 ($10^{11}$) 乃至万亿 ($10^{12}$) token(文本的基本单元,如单词或子词)级别。$$ |D_{\text{train}}| \approx 10^{11} \sim 10^{12} \text{ tokens} $$ 如此庞大的数据量是模型学习语言规律、世界知识、推理能力的基础。

二、 技术基石:Transformer 架构

AI大模型的兴起,特别是在自然语言处理领域的突破,很大程度上得益于Transformer架构的提出及其广泛运用。Transformer 是一种基于自注意机制的深度学习模型架构,它彻底革新了序列建模(如语言建模、机器翻译)的方法。

自注意机制:这是 Transformer 的核心所在。它允许模型在处理序列(如一句话)时,计算序列中每个元素(如一个词)与其他所有元素的相关性权重 ($\alpha_{ij}$)。这使模型能够直接捕捉长距离的依赖关系,不论元素在序列中的距离有多远。$$ \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V $$ 其中 $Q$ (Query), $K$ (Key), $V$ (Value) 均由输入序列经线性转换得到的矩阵构成。这一机制使模型能够“关注”输入中最为相关的信息。

并行计算的优势:相较于以往的循环神经网络,Transformer 的自注意机制天生适合并行计算,这极大提升了模型在 GPU 等硬件上的训练效率,使训练超大规模模型成为可能。

编码器-解码器结构:最初的 Transformer 由编码器和解码器堆叠而成。编码器负责解析输入序列,解码器则负责生成输出序列。随后发展出了仅使用解码器(如 GPT 系列)或仅使用编码器(如 BERT)的变体,它们均基于 Transformer 的核心组件。

三、 训练过程:从数据到智能

训练一个 AI 大模型是一个极其复杂且资源消耗巨大的过程,主要包括以下几个关键步骤:

数据收集与预处理:从互联网等途径收集海量、多源、多模态的原始数据。然后进行清洗、过滤(剔除低质量、有害内容)、去重、格式化等操作,构建适配模型训练的语料库。

模型架构设计:基于 Transformer 或其变体,设定模型的层数、隐藏层尺寸、注意力头数等超参数。例如,一个典型的 GPT 类模型架构可表述为:$$ \text{Model} = \text{Stack}(\text{Transformer Decoder Blocks}) $$ 每个 Decoder Block 包含多头自注意层和前馈神经网络层。

预训练:这是最核心、最耗计算资源的环节。模型在大量无标签数据上进行训练,学习通用的语言表征、世界知识和基础推理能力。常见的预训练任务包括:

语言建模:预测下一个词 ($P(w_t | w_{<t})$)。例如:$$ P(\text{“world”} | \text{“Hello”}) $$

掩码语言建模:随机遮蔽输入中的某些词,让模型预测被遮蔽的词 ($P(w_{\text{masked}} | w_{\text{context}})$)。

在预训练形成的通用模型基础上,采用特定领域或任务的带标签数据进行深入训练。这有助于模型适应具体的下游任务,如文本分类、问答、摘要生成等。微调的主要目标是优化特定任务的损失函数,比如分类任务的交叉熵损失:$$ \mathcal{L}_{\text{CE}} = -\sum_{i} y_i \log(p_i) $$ 其中 $y_i$ 表示实际标签,$p_i$ 代表模型预测的概率。

对齐与改进:

为了确保模型更加安全、有用且符合人类的价值观,会运用基于人类反馈的强化学习等方法进行调整。模型会产生多个响应,人们标记出偏好,模型学习生成更贴合偏好的回应。

提示工程:

在模型应用阶段,用户通过精心构造的提示来指导模型完成特定任务。提示的质量直接影响模型输出的结果。

四、 超越预期的能力展现

当模型的规模和训练数据量达到某个临界点后,大型模型会展示出一些在小型模型中不易观察到的、令人惊讶的能力。这些能力并非设计之初就明确编入程序,而是在大规模训练过程中自然形成。主要包含:

- 上下文学习:模型仅需通过提示中的少量实例(无需修改模型参数),即可理解和执行新任务。例如,向模型展示几个翻译例子,它就能翻译新的句子。

- 指令遵循:模型能够理解并执行复杂的自然语言指令。

- 逐步推理:对于需要多步骤推理的问题(如数学题、逻辑谜题),模型可以展示出“思考链条”,逐步推导出答案。

- 代码生成与理解:大型模型在编程任务中表现出色,能生成、解析、调试代码。

- 知识检索与整合:模型能利用其训练期间学到的大量知识回答问题,并在一定程度上实现跨领域的知识整合。

- 创造性内容生成:生成连贯、创新、符合特定风格要求的文本、诗歌、剧本、音乐,甚至是图像和视频。

这些涌现的能力极大地拓展了大型模型的应用范围,远远超出了最初的语言建模领域。

五、 典型代表及其应用场景

当前最具有标志性的 AI 大型模型主要包括:

- GPT 系列:由 OpenAI 开发,基于纯解码器 Transformer 结构。最新的 GPT-4 是一个多功能模型(支持文本和图像处理),以其卓越的语言生成、推理和泛化能力闻名。应用场景:智能对话助理、内容创作、代码生成、教育辅导、搜索引擎增强等。

- BERT 系列:由 Google 开发,基于编码器 Transformer 结构。更擅长语言理解任务。应用场景:搜索引擎理解查询意图、文本情感分析、命名实体识别、智能客服中的语义匹配等。

- Claude 系列:由 Anthropic 开发,注重安全性、可靠性和长上下文处理能力。应用场景:长文档总结与分析、法律文件处理、安全敏感的对话交流。

- Gemini 系列:由 Google DeepMind 开发,原生多模态大型模型。应用场景:图像理解与生成、多模态搜索、视频内容分析、科学发现辅助。

- LLaMA 系列:由 Meta 发布的开源大型语言模型系列,促进了开源社区的发展。应用场景:学术研究、企业私有化部署、定制化模型开发基础。

- 多模态模型:如 DALL·E、Stable Diffusion(图像生成),Sora(视频生成),通常基于扩散模型或结合 Transformer 结构。应用场景:艺术创作、广告设计、影视制作、游戏开发。

这些大型模型的应用场景已经广泛渗透到各个行业:

- 内容创作:撰写文章、报告、营销文案、诗歌、剧本;生成图像、音乐、视频。

- 编程与开发:生成代码、解释代码、调试程序、自动生成文档。

- 客户服务:智能客服机器人,提供 24/7 服务,解答常见问题。

- 教育与研究:个性化辅导、答疑解惑、辅助文献综述、生成教学资料。

- 办公效率:总结文档、撰写邮件、润色文字、制作演示文稿。

- 搜索引擎:提供更智能、更直接的回答(如 Bing Chat, Perplexity)。

- 创意设计:辅助进行 UI/UX 设计、游戏场景设计、建筑构思。

- 科学研究:分析科学文献、提出假设、辅助实验设计、处理科学数据。

- 法律与金融:分析法律文件、合同审查;生成金融报告、市场分析。

六、 挑战与争议:并非无所不能的工具

尽管 AI 大型模型展示了强大的能力,但也面临许多挑战和争议:

- 计算资源与成本 ($C_{\text{train}}$) 高昂:训练一个大型模型需要成千上万块高端 GPU,消耗大量电力。这导致训练成本非常高,只有少数大型公司能够承担。$$ C_{\text{train}} \propto n_{\theta} \times |D_{\text{train}}| \times \text{FLOPs} $$

- 数据依赖与偏见:模型的所有知识均来自训练数据。如果数据存在偏见(如性别、种族歧视)、错误或过时信息,模型会学习并放大这些偏见,产生有害或不公的输出。

- “幻想”问题:模型有时会自信地生成完全错误或虚构的信息。这是因为模型本质上是在预测下一个最可能的 token,而不是检索真实知识。

- 安全与滥用风险:

模型可能被用来生成虚假信息(假新闻)、钓鱼邮件、恶意代码,或模仿他人实施诈骗。如何有效遏制滥用是主要挑战。

可解释性差:

大型模型内部构造异常复杂,其决策过程如同一个“黑箱”,难以阐明其为何做出特定的输出或决策。

知识更新滞后:

模型的知识在训练结束时即已定型(除非再次训练或调整)。对于迅速变化的世界(例如突发新闻、最新的科研成果),模型的知识可能迅速过时。

环境成本:

庞大的计算能力消耗意味着大量的碳排放,引发了对环境可持续性的关注。

伦理与社会影响:

大规模自动化可能影响就业市场;信息泡沫可能加剧;对真实性的定义面临挑战;知识产权归属问题变得模糊。

七、 未来展望:通向何处?

AI 大模型的发展正处于起步阶段,未来的发展趋势可能包括:

更大规模?

追求更大参数量和数据量的模型可能会继续,但边际收益可能会减少。更聪明、更高效地利用现有规模可能更为重要。

多模态融合:

文本、图像、音频、视频、3D、传感器数据的深度整合是必然趋势,旨在构建能够真正理解物理世界的通用智能体。

提升效率:

研究更高效的模型结构、训练算法(如专家混合)、压缩技术(模型蒸馏、量化),以降低训练和推理的成本。

增强可靠性:

重点解决想象问题、提高事实准确性、加强推理和规划能力。结合检索增强生成等技术,使模型能够访问和引用实时、准确的外部知识库。

改进对齐与控制:

发展更有效的手段确保模型行为与人类价值观、道德标准和安全要求高度一致。

专业化与个性化:

在通用大模型的基础上,开发针对特定行业(医疗、金融、法律)或特定用户需求(个人知识库、偏好)的定制化模型或插件系统。

开源与生态:

开源模型和工具将继续发展,降低技术门槛,推动创新生态系统。

人机协作:

大模型不会完全替代人类,而是作为强有力的协作工具,提升人类的创造力和生产力。如何设计最优化的人机协作模式是关键。

如何学习AI大模型?

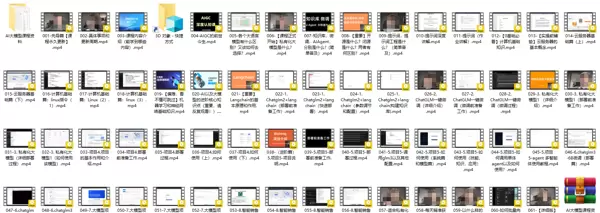

作为一名乐于助人的互联网老手,我决定将宝贵的AI知识分享给各位。至于能学到多少则取决于你的学习毅力和能力。我已经将重要的AI大模型资料,包括AI大模型入门学习思维导图、精选AI大模型学习书籍手册、视频教程、实战学习等录播视频免费提供。

这份完整版的大模型 AI 学习资料已经上传至CSDN,免费获取【确保100%免费】

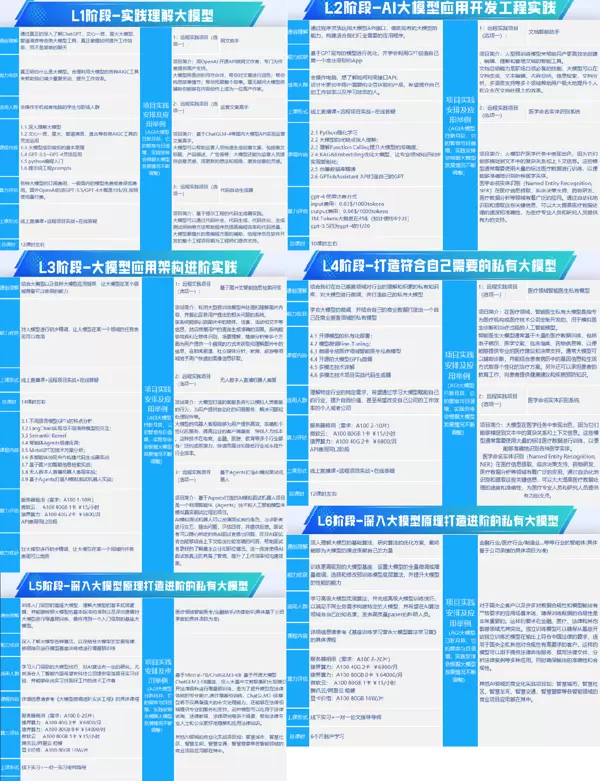

一、全套AGI大模型学习路径

AI大模型时代的学习旅程:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告集合

这套包含640份报告的集合,涵盖了AI大模型的理论探讨、技术实现、行业应用等多个方面。无论您是研究人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告集合都将为您提供宝贵的信息和启发。

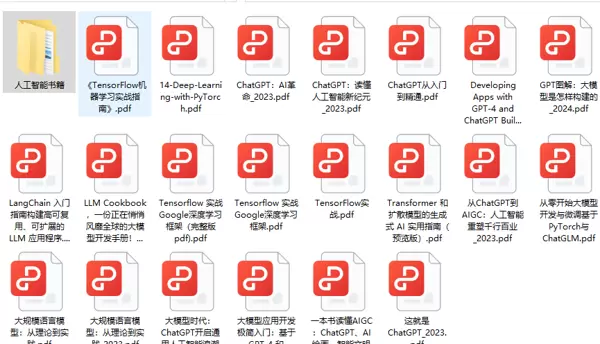

AI大模型经典PDF资料

随着人工智能技术的快速发展,AI大模型已成为当前科技领域的热点之一。这些大型预训练模型,如GPT-3、BERT、XLNet等,凭借其强大的语言理解和生成能力,正在改变我们对人工智能的理解。以下是几份非常优秀的学习资源。

AI大模型商业化实施方案

作为普通人,进入大模型时代需要不断学习和实践,不断提升自己的技能和认知水平,同时也要具备责任感和伦理意识,为人工智能的健康发展贡献自己的力量。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号