数据对接技术全景解析

在自动化数据分析产品中,数据对接扮演着连接业务系统与人工智能模型的重要角色。根据《中国数字经济发展报告(2023)》,超过41%的企业在数据对接与整合过程中花费的时间超出预期,这直接影响了后续的分析与决策过程。目前,主要的数据对接方法包括数据库直接连接、API接口调用以及文件同步等,每种方法都有其独特的技术实现和应用场景。

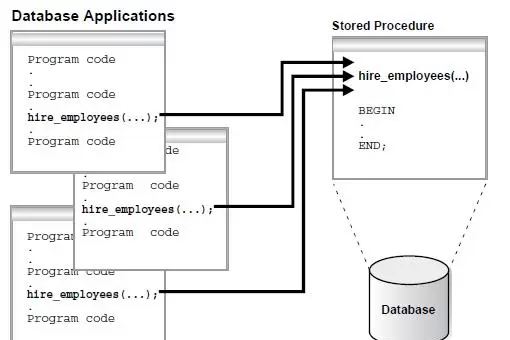

1、数据库直连技术详解

数据库直连是最常见的企业数据接入方式之一,它利用JDBC、ODBC等标准化协议直接与主流数据库建立连接。该技术能够支持超过20种数据库的直接连接,包括MySQL、Oracle、SQL Server、PostgreSQL等。以下是数据库直连的技术架构示例:

// JDBC连接示例

String url = "jdbc:mysql://localhost:3306/sales_data?useSSL=false";

String user = "data_analyst";

String password = "EncryptedPassword123!";

Connection conn = DriverManager.getConnection(url, user, password);

Statement stmt = conn.createStatement();

ResultSet rs = stmt.executeQuery("SELECT * FROM monthly_sales WHERE region='华东'");技术优势

- 查询性能优秀,特别适合实时报表的生成。例如,某制造业企业的查询响应时间不超过100毫秒。

- 实现简便,不需要额外的数据中转步骤,整个实施周期可以缩短到1-2周。

- 支持增量同步,通过CDC(Change Data Capture)技术捕捉数据变化,如MySQL的binlog同步功能。

安全挑战

直接连接数据库存在一定的安全风险,例如,某电商平台因为测试环境中数据库账户信息泄露,导致300万条用户数据被盗。为解决这一问题,可以采取以下措施:

- 在应用程序层面加密存储数据库凭证,避免硬编码。

- 设置IP白名单,确保只有AI分析服务器能够访问数据库。

- 利用数据库代理(如ProxySQL)实现更精细的权限管理。

2、API接口调用最佳实践

API接口调用已经成为SaaS服务和云计算应用集成的标准途径,支持RESTful和SOAP等多种协议。采用API-first的设计理念,其关键技术实现包括以下几个方面:

接口设计规范

// 销售数据API响应示例

{

"code": 200,

"message": "success",

"data": {

"total_sales": 1568900.50,

"order_count": 3245,

"region_distribution": [

{"region": "华北", "amount": 456200.80},

{"region": "华东", "amount": 621500.30},

{"region": "华南", "amount": 491200.40}

],

"update_time": "2025-11-18T08:30:15Z"

}

}认证与限流机制

- 使用OAuth 2.0结合JWT令牌进行身份验证,令牌的有效期设定为2小时。

- 实施分层限流策略:普通用户每小时100次请求,企业用户每小时1000次请求。

- 对于敏感接口,如涉及财务数据的API,需要进行二次验证,即IP地址、令牌及验证码三重校验。

实时性优化

例如,一家互联网金融公司通过API调用第三方信用评估数据,采取以下优化措施后,响应时间从3秒降低到了200毫秒:

- 合并多个接口请求,减少网络往返次数。

- 使用本地缓存(如Redis,TTL=5分钟)来存储频繁访问的数据。

- 采用HTTP/2的多路复用技术提高数据传输效率。

3、文件同步与批处理方案

文件同步适用于大批量数据交换的场景,通常通过FTP、SFTP或OSS等协议完成数据传输。在技术实现上,需要注意以下几个关键点:

同步策略选择

- 全量同步:适用于数据量较小(<100MB)且更新频率较低的场景,如月度财务报表。

- 增量同步:可以通过文件命名规则(如data_20251118.csv)或文件哈希值比较来实现。

- 定时任务:使用Airflow进行调度,下面是一个配置示例:

# Airflow DAG配置示例

default_args = {

'owner': 'data_team',

'depends_on_past': False,

'start_date': datetime(2025, 1, 1),

'email_on_failure': True,

'email': ['data@company.com']

}

dag = DAG('sales_data_sync', default_args=default_args, schedule_interval='0 1 * * *')

sync_task = BashOperator(

task_id='sftp_sync',任务配置与错误处理机制

在Airflow中配置了一个数据同步任务,该任务负责从远程服务器下载销售数据CSV文件到本地指定目录。具体命令如下:

bash_command='sftp -i /keys/sftp_key data_user@192.168.1.100:/data/sales_*.csv /local/data/', dag=dag

随后,定义了一个Python操作任务用于处理这些数据:

process_task = PythonOperator(task_id='data_process', python_callable=process_sales_data, dag=dag)

为了确保数据同步和处理的连续性,设置了同步任务完成后触发数据处理任务的流程:sync_task >> process_task

错误处理机制

- 文件校验:通过计算MD5哈希值来验证文件的完整性。

- 重试策略:当任务失败时,采用指数退避策略进行重试,重试间隔依次为1分钟、3分钟、5分钟。

- 异常告警:若同步任务在10分钟内未能成功完成,则会触发企业微信或钉钉告警通知。

流式数据接入技术

针对物联网设备数据及日志数据等高频次实时数据,推荐使用流式数据接入技术。一种常见的架构是结合Kafka和Flink,例如一个智能工厂项目中,利用此技术实现了设备传感器数据的即时分析:

// Flink流处理示例

val sensorData = env.addSource(new FlinkKafkaConsumer[String]("sensor_topic", new SimpleStringSchema(), properties))

.map(json => {

val obj = new JSONObject(json)

(obj.getString("device_id"), obj.getDouble("temperature"), obj.getLong("timestamp"))

})

.keyBy(_._1)

.window(TumblingProcessingTimeWindows.of(Time.seconds(10)))

.reduce((a, b) => (a._1, (a._2 + b._2)/2, b._3))

sensorData.addSink(new RedisSink(redisConfig))

技术优势

- 高实时性:数据处理延迟通常控制在几秒之内。

- 高度可扩展:能够支持大规模集群部署,节点数量可达数千。

- 完善的容错机制:通过Checkpoint技术实现状态恢复,确保系统的稳定运行。

数据安全保障体系构建

数据安全是人工智能自动化分析中的关键挑战之一,涉及数据传输、存储和访问等多个环节的安全防护。根据IBM发布的《2024年数据泄露成本报告》,企业因数据泄露而面临的平均成本已高达488万美元,而建立完善的数据安全体系则能显著降低这一风险,减少超过60%的数据泄露可能性。

全链路数据加密方案

为确保数据在传输和存储过程中的安全性,建议采取以下措施:

传输加密

- 强制实施TLS 1.3协议,同时禁止使用SSLv3等不安全的协议版本。

- API接口间通信实行双向认证,要求客户端提交有效证书。

- 对于身份证号等敏感信息,在传输前采用AES-256算法单独加密。

存储加密

- 数据库层面启用透明数据加密功能,例如利用SQL Server提供的TDE特性。

- 文件存储时,特别是涉及敏感资料时,应使用如VeraCrypt这样的工具进行加密。

- 密钥管理方面,推荐使用阿里云KMS或AWS KMS等服务,实现密钥的自动轮换。

动态数据脱敏技术

数据脱敏技术是保护敏感信息的重要手段,特别适用于开发测试环境和数据分析场合。腾讯云智能运营分析助手提供了多级别的脱敏策略,包括但不限于:

- 身份证号:110101******1234

- 手机号:1385678****3456

- 银行卡号:6222****3456

- 地址:北京市海淀区**街道

技术实现上,通过SQL重写技术实现在查询时对敏感字段进行动态脱敏:

-- 动态脱敏策略定义

CREATE MASKING POLICY phone_mask ON customer.phone USING ('*-*-' || SUBSTRING(phone, 8, 4)) FOR ROLES analyst;

-- 查询时自动脱敏

SELECT name, phone FROM customer WHERE region='北京';

-- 结果:张三,*-***-5678

据某银行的实际应用案例,动态数据脱敏技术有效降低了开发测试环境中90%的数据泄露风险,并且符合《个人信息保护法》的相关规定。

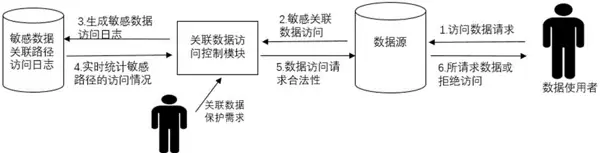

精细化访问控制

基于零信任原则的访问控制体系是确保数据安全的核心,其核心理念是“永不信任,始终验证”。常用的权限管理模型结合了RBAC(基于角色的访问控制)和ABAC(基于属性的访问控制):

RBAC权限设计

- 角色定义:包括数据分析师、业务观察员、系统管理员等不同角色。

- 权限矩阵:明确各角色可访问的数据范围及其操作权限。

- 委派机制:支持权限的临时转移,如允许经理在外出期间将数据查看权限临时授予助理。

ABAC动态控制

- 结合用户属性和环境属性进行动态授权决策。

- 例如,只有当用户的部门与所请求数据的部门相匹配时,且用户不是管理员身份的情况下,才允许访问;非工作时间不允许下载操作。

# ABAC权限判断逻辑

def is_allowed(user, data, action):

# 用户部门与数据部门匹配

if user.department != data.department and not user.is_admin:

return False

# 工作时间限制

if not is_work_time() and action == 'download':

return False返回 False

# IP地址限制

if not is_office_ip(user.ip) and action == 'modify':

return False

return True

三、行业标准与合规实践

1、ISO 27001信息安全管理体系

ISO 27001 是国际上公认的信息安全标准,它为 AI 数据分析产品提供了全面的安全管理框架。该标准的核心要求包括:

关键控制点

- 资产管理:定义数据的分类和等级,例如公开信息、内部信息、机密信息。

- 访问控制:实施最小权限原则,并定期审查权限。

- 密码管理:强制执行复杂的密码策略,并使用多因素认证。

- 物理安全:控制数据中心的访问,并安装监控系统。

- 通信安全:确保数据传输加密和网络分段。

- 事件管理:建立安全事件响应流程和灾难恢复计划。

认证实施步骤

- 差距分析:评估当前安全体系与 ISO 27001 标准之间的差距。

- 体系设计:制定信息安全政策、目标和控制措施。

- 实施运行:执行安全控制措施,并进行员工安全培训。

- 内部审核:验证安全管理体系的有效性。

- 认证审核:通过第三方机构的认证。

2、数据安全法合规要点

《数据安全法》对 AI 数据分析产品提出了明确的合规要求,企业应重点关注以下几个方面:

- 数据分类分级:识别核心数据、重要数据和普通数据,并对重要数据实施特别保护。

- 数据安全责任制:设置数据安全负责人,明确各部门的安全职责。

- 风险评估:定期进行数据安全风险评估,形成评估报告并采取整改措施。

- 数据出境管理:重要数据出境前需通过安全评估,并选择合规的出境途径。

某互联网企业因未能履行数据安全义务而被罚款 500 万元,这一案例为企业敲响了警钟。建议企业建立数据合规自查清单,并每季度进行合规检查。

四、技术选型与实施建议

1、数据对接技术选型指南

选择合适的数据对接技术需要综合考虑数据特性、业务需求和资源限制。以下是一个决策参考框架:

| 因素 | 数据库直连 | API 调用 | 文件同步 | 流式接入 |

|---|---|---|---|---|

| 数据量 | 中-大 | 小-中 | 大 | 极大 |

| 实时性 | 高 | 中-高 | 低 | 最高 |

| 复杂度 | 低 | 中 | 低 | 高 |

| 成本 | 低 | 中 | 低 | 高 |

| 适用场景 | 业务报表 | SaaS 集成 | 批量数据 | IoT/日志 |

选型建议

- 实时分析场景:优先选择数据库直连或流式接入。

- 多云集成场景:采用 API 调用加数据中台架构。

- 成本敏感场景:使用文件同步加定时任务模式。

2、安全体系建设路线图

企业数据安全体系建设应分阶段实施,建议的路线图如下:

第一阶段(0-3 个月)

- 完成数据分类分级。

- 实施基础加密(传输加密、存储加密)。

- 建立基本访问控制。

第二阶段(3-6 个月)

- 部署动态数据脱敏。

- 实施细粒度权限管控。

- 建立安全审计系统。

第三阶段(6-12 个月)

- 建设零信任架构。

- 引入 AI 安全检测。

- 通过 ISO 27001 认证。

长期优化

- 安全自动化响应。

- 持续风险评估。

- 安全意识培训。

五、总结与展望

AI 自动化数据分析产品的数据对接与安全保障是一项系统工程,需要技术、流程和管理的协同配合。随着《数据安全法》等法规的实施和技术的发展,未来将出现以下趋势:

- 标准化协议普及:如模型上下文协议(MCP)等标准化接口将简化多源数据集成,Anthropic 的 MCP 协议已实现数据源的即插即用。

- 隐私计算技术成熟:联邦学习、安全多方计算等技术将在不共享原始数据的情况下实现协同分析,某医疗联盟案例通过隐私计算实现了多医院数据联合建模。

- AI 驱动的安全防护:AI 技术将更广泛地应用于异常检测、入侵防御等场景,某金融机构采用 AI 安全模型使攻击检测率提升至 99.2%。

- 合规自动化:合规检查、风险评估等流程将实现自动化,降低合规成本,提高响应速度。

对于企业而言,建议从实际业务需求出发,选择合适的数据对接方案,同时构建多层次的安全体系,在确保数据安全的前提下充分发挥 AI 分析的价值。如有需要,可以搜索“易分析 AI 生成 PPT 软件”。通过技术创新和最佳实践,实现数据“可用不可见,可控可计量”,为业务决策提供安全可靠的数据支持。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号