文章目录

前言

从日常生活中使用手机进行人脸识别支付,到自动驾驶汽车对复杂路况的实时分析,再到医生利用AI技术辅助诊断医学影像,以及设计师通过简单的文本指令生成创意图像,这些应用场景虽然各不相同,但都依赖于一项共同的核心技术:视觉大模型。

继自然语言大模型引领了人工智能的一场革命之后,视觉大模型也以惊人的速度改变了计算机视觉领域。作为人工智能感知世界的“眼睛”,视觉大模型克服了传统视觉算法“一任务一模型”的限制,通过大规模的数据训练和先进的架构设计,实现了从图像识别到场景理解、从被动感知到主动决策的跨越。这不仅使得机器具备了接近人类的视觉认知能力,而且成为了连接现实世界与数字世界的重要桥梁,推动各行各业的智能化进程。

本文将从定义、研究现状、技术分支和产业应用等多个角度,全面解析视觉大模型的技术核心和发展脉络。

一、视觉大模型的核心定义

视觉大模型(Visual Large Model)是一种基于基础模型(Foundational Models)理念构建的人工智能系统。其核心定义是:通过自监督或半监督学习的方式,在大量视觉数据(如图像、视频)及多模态数据(如文本-图像、音频-视频等)上进行训练,拥有大规模参数规模和强大的泛化能力,能够灵活应对多种下游视觉任务的通用模型。

这一定义包含了三个关键特点,与传统的计算机视觉模型有所不同:

- 通用泛化性:无需针对特定任务重新训练,通过提示工程或少量微调即可适应目标检测、语义分割、图像生成等多种任务,支持零样本/少样本学习。

- 大规模基础:训练数据量通常达到数千万至数十亿级别,模型参数规模从亿级到千亿级不等,通过数据和参数的双重规模效应实现能力的显著提升。

- 多模态融合:超越单一视觉模态的限制,通常集成文本、音频等信息,实现跨模态语义对齐与交互,例如文本生成图像、图像描述生成等。

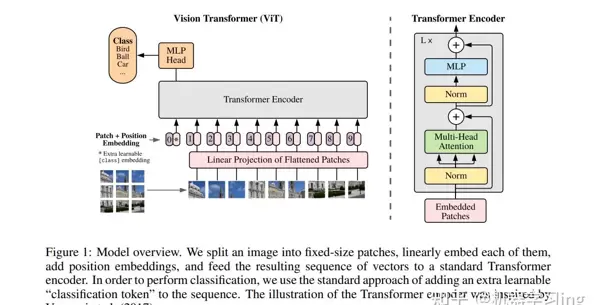

技术根源可以追溯到Transformer架构在视觉领域的应用(如ViT模型),该架构通过将图像转换为序列数据进行处理,解决了传统CNN模型在处理长距离依赖关系方面的不足,为大规模视觉模型的发展奠定了基础。

二、视觉大模型的研究现状

视觉大模型的研究已经从早期的单模态建模,发展到了多模态融合、细粒度感知与决策推理并重的新阶段。关键进展主要集中在以下几个方面:

1. 基础架构与训练范式的成熟化

Transformer主导架构:ViT(Vision Transformer)的提出标志着视觉大模型新时代的开始,随后出现了Swin Transformer、MAE(Masked Autoencoder)等改进架构,这些架构在保持模型性能的同时提高了计算效率。例如,智源团队的EVA模型通过结合CLIP的语义学习和MIM的几何结构学习,仅用十亿参数就达到了领先的视觉表现。

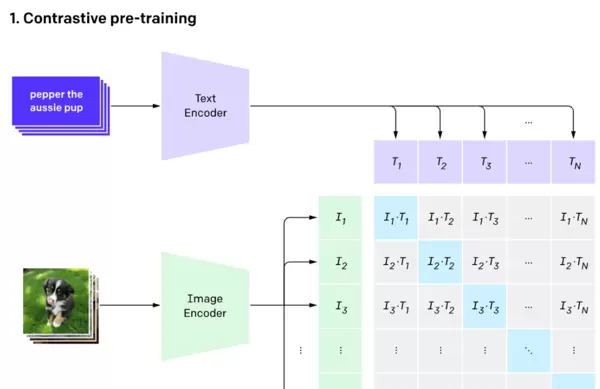

训练目标多元化:对比学习(如CLIP的图像-文本对比损失)解决了多模态对齐问题,生成式学习(如扩散模型、掩码语言建模)增强了内容生成能力,而强化学习(如RLHF、GRPO)则通过人类反馈或验证奖励提高了模型决策的可靠性。

数据利用高效化:从依赖人工标注数据转向大规模弱监督/无监督数据,通过网络爬取的图像-文本对(如CLIP使用的WebImageText)、伪标签数据(如GLIP、SA-1B)构建训练集,降低了数据标注的成本。

图 1:模型整体架构。我们将图像分割成固定大小的补丁块(fixed-size patches),对每个补丁块进行线性嵌入(linearly embed),加入位置嵌入(position embeddings),然后将得到的向量序列输入标准的Transformer编码器。为了实现分类功能,我们在序列中额外添加了一个可学习的“分类令牌”(classification token)。Transformer编码器的设计灵感来源于Irwan Vaswani等人2017年的研究[1]。

2. 关键模型与技术突破

近年来,一系列具有里程碑意义的视觉大模型相继推出,不断推动技术边界的扩展:

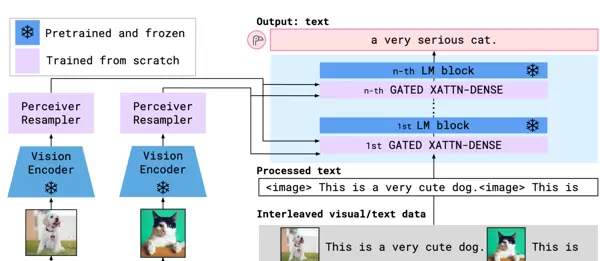

- 多模态对齐模型:OpenAI的CLIP首次实现了文本与图像的深度语义对齐,使得模型可以通过自然语言提示完成零样本分类;Google的Flamingo通过Perceiver Resampler连接视觉与语言模型,增强了跨模态推理能力。

- 视觉提示模型:这类模型通过特定的提示来引导模型执行特定任务,提高了模型的灵活性和适用性。

三、视觉大模型的研究方向分支

视觉大模型的研究方向多样,主要包括以下几个分类:

- 基于提示方式的分类:根据模型如何接收和处理提示信息,分为不同类别。

- 基于架构设计的分类:根据模型的基本架构和设计原则进行分类。

- 基于核心能力的分类:根据模型在特定任务中的表现能力进行分类。

- 基于训练目标的分类:根据模型的训练目标和优化方法进行分类。

四、视觉大模型的产业应用现状

视觉大模型已经在多个行业中得到了广泛应用,包括但不限于:

- 智慧城市与公共安全:用于监控和分析城市环境,提高公共安全水平。

- 工业与能源领域:应用于设备维护预测、生产过程监控等,提高工业生产的效率和安全性。

- 医疗健康领域:辅助医生进行疾病诊断、治疗方案制定等,提升医疗服务的质量和效率。

- 消费电子与内容创作:在图像处理、视频编辑等方面提供创新解决方案,丰富用户体验。

五、总结与展望

视觉大模型作为人工智能领域的一项重要技术,正在深刻改变我们对计算机视觉的理解和应用。未来,随着技术的进一步发展,视觉大模型将在更多领域发挥更大的作用,推动社会的智能化进程。

Meta推出的SAM(Segment Anything Model)引领了“分割一切”的潮流,该模型能够通过点、框等视觉线索实现通用目标分割,无需针对特定任务进行训练,已被广泛应用在医学影像、遥感等多个领域。

细粒度感知模型

北京大学研发的Pink模型通过坐标框文本化及适配器微调等技术创新,实现了图像中特定物体的细粒度指代分析,在GQA数据集上的表现优于同类方法5.2%。而LocLLM模型则进一步将多模态大模型的应用范围扩展到人体姿态感知,其跨数据集泛化能力比传统方法高出11.0%。

强化学习融合模型

Gemini 2.5利用强化学习优化了视觉-文本推理流程,VLM-R1则采用GRPO算法增强了零样本情况下的鲁棒性,使得模型的决策更加符合人类的偏好和实际应用场景的需求。

性能与效率的持续改进

当前的视觉大模型在各类基准测试中表现出色。例如,在多模态评估基准MMBench上,Pink模型凭借仅有6.7M的可微调参数量和477K的指令微调数据,成绩超过了第二名5.6%。在目标检测、语义分割等传统任务上,通过预训练加微调的方法,模型性能已经远远超过传统的专门算法。此外,借助LoRA(低秩适配)、知识蒸馏等技术,模型微调的成本大大降低,现在甚至可以在消费级别的GPU上完成训练。

视觉大模型的研究方向分支

随着技术的进步,视觉大模型的研究已经形成了多个明确的分支,包括架构设计、能力扩展和落地优化等方面:

- 基于提示方式的分类

- 文本提示模型(Textually Prompted Models):这些模型通过自然语言指令来驱动任务的完成,核心在于视觉-文本语义的对齐,典型代表有CLIP、BLIP、InstructBLIP等,支持零样本分类、图像描述、跨模态检索等任务。

- 视觉提示模型(Visually Prompted Models):这类模型以视觉信号(如点、框、掩码)作为输入提示,实现目标的精确定位与分割,主要代表有SAM、SegGPT、Grounding-DINO,在开放世界的检测和像素级分割任务中表现出色。

- 多模态提示模型(Heterogeneous Modalities-based Models):这些模型融合了文本、视觉、音频等多种提示信号,以实现对复杂场景的理解,如ImageBind、Valley、Gemini等,支持跨模态内容的生成与交互。

- 基于架构设计的分类

- 双编码器架构:这种架构分别处理视觉和文本模态,通过对比损失来优化模态间的对齐,如CLIP、ALBEF,其优点在于训练效率高且跨模态检索性能优越。

- 融合架构:通过引入额外的融合编码器来学习跨模态表示,如FLAVA、BLIP-2,特别擅长复杂的语义理解和推理任务。

- 编码器-解码器架构:结合了视觉编码器和语言解码器,适用于生成式任务,如Flamingo、KOSMOS,可以实现图像字幕的生成和多模态对话。

- 自适应LLM架构:以大规模语言模型为核心,通过视觉编码器将图像转换成与LLM兼容的格式,如GPT-4V、Qwen-VL,具有强大的逻辑推理和多任务处理能力。

- 基于核心能力的分类

- 细粒度感知:专注于图像局部特征和复杂关系的理解,例如Pink模型的指代分析、LocLLM的人体关键点定位,突破了传统模型仅限于“图像级别”理解的局限。

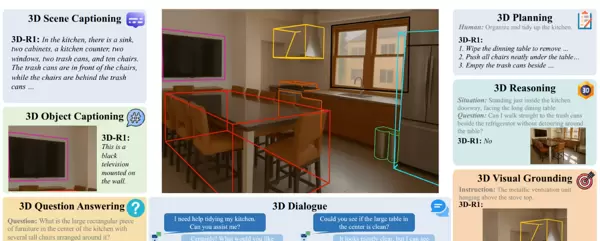

- 3D与视频理解:从二维图像扩展到三维场景重建和视频的时间序列分析,如PointE的3D生成、VideoMAE的视频预训练,支持自动驾驶、虚拟现实等应用场景。

- 视觉-语言-行动(VLA):整合感知、推理和执行能力,如李飞飞团队的语言指令机器人、VLA智能体,推动了具身智能的发展。

- 模型轻量化与边缘部署:通过压缩、蒸馏、量化等技术适应边缘设备,如大小模型协同架构、联邦学习部署,解决了对云端的依赖和隐私问题。

- 基于训练目标的分类

- 对比式学习:通过最大化正样本对的相似度和最小化负样本对的相似度来学习表示,例如CLIP的ITC损失、FILIP Loss。

- 生成式学习:通过生成目标来优化模型,如掩码语言建模(MLM)、字幕生成损失(Cap Loss)、扩散模型的生成损失。

- 强化学习:根据反馈信号优化策略,如RLHF(人类反馈强化学习)、GRPO(群体相对策略优化)、RLVR(可验证奖励强化学习),提高模型决策的可靠性。

视觉大模型的产业应用现状

视觉大模型已经从实验室走向实际应用,在多个行业中实现了规模化应用,展示出了从“技术工具”向“产业操作系统”转变的趋势:

- 智慧城市与公共安全

- 城市治理:大华星汉大模型2.0能够精确识别出店经营、流动摊贩等20类城市事件,平均准确率比传统模型提高了10%以上,应用场景从街道园区扩展到了水域河岸、建筑工地。

- 交通管理:通过对90多种交通场景信息的解析,实现了对道路抛洒物、违规行驶等事件的自动检测与分级预警,抛洒物检测准确率提升了50%,并支持危险等级的智能判断。

- 周界安防:利用SAM的动态分割技术,可以自动分类场景并识别异常行为(如翻越护栏、破坏设施),显著缩短了设备部署时间,降低了运维成本。

- 工业与能源领域

- 工业质检:通过视觉大模型,可以实现对产品缺陷的快速、准确检测,提高生产效率和产品质量,减少人工检查的误差。

工业应用场景

在煤矿和制造业环境中,传送带上的20多种异常情况(例如锚杆、异物、水煤等)能够实现实时识别,同时矿料的质量分析(如煤块尺寸、装载量)也实现了自动化,整体准确率提高了10%以上,无需人工设定规则参数。

设备的维护工作通过分析运行视频及历史数据来预测故障,比如提前警告轴承磨损、检测管道泄漏等问题,从而减少意外停机的风险。

利用高分辨率的遥感图像进行语义分割和多时段变化检测,这项技术被广泛应用于城市规划、灾害监控和作物产量估计,支持智能地球的构建。

医疗健康领域

借助大型视觉模型,病灶分割和检测技术已经成功应用于CT、MRI、X射线等多种医学影像分析中,能够精确描绘肿瘤边界,进行早期病灶筛查,提高诊断的速度和精度。

结合医学知识图谱和视觉模型,系统能够自动生成影像报告,评估疾病的阶段,帮助医生制定治疗计划。

边缘计算的小型模型可以实时处理手术视频,提取关键区域,减少数据传输延迟,支持远程手术指导。

消费电子与内容创作

智能手机、相机等设备集成了先进的视觉模型,提供了包括人像美化、场景识别、即时翻译在内的多种功能,显著提升了用户使用体验。

文本到图像的生成技术(例如Stable Diffusion)、图像编辑工具和视频编辑助手,极大地增强了设计师和创作者的工作效率。

数字人物、智能音箱等产品通过整合视觉与语言技术,实现了更加自然的用户互动方式,比如通过手势控制设备或进行图像内容的询问。

总结与展望

视觉大模型的问世,标志着计算机视觉技术从特定任务转向了通用智能的重大转变。通过大量数据的训练和先进的体系结构设计,这些模型不仅克服了不同模式间的障碍,还扩展了任务的范围,不仅在技术层面上提高了感知、理解和生成的能力,还在行业层面上成为了推动数字化转型的关键驱动力。

尽管如此,视觉大模型的发展仍然面临着诸多挑战,包括数据隐私和安全问题(如训练数据泄露、模型中毒)、算法偏差和公平性问题、高昂的计算成本、缺乏透明度,以及边缘部署的效率问题。这些问题需要学术界和产业界共同努力,通过技术创新(例如差异隐私、模型压缩)、政策制定(例如伦理审查机制)和标准化(例如数据管理准则)来促进行业的健康发展。

展望未来,视觉大模型将展现出三个主要的发展趋势:多模态的深入融合,即从简单的视觉-文本配对发展到视觉、语言、音频和传感器数据的全面融合,提供更全面的场景理解和交互能力;专业化和轻量化的并行发展,一方面针对特定行业开发专业模型(如医疗、工业领域的定制模型),另一方面通过技术改进实现边缘设备的高效部署,满足实时性和隐私保护的需求;具身智能和自我进化,视觉大模型将与机器人技术和强化学习紧密结合,形成具有感知-决策-执行闭环的智能实体,应用于自动驾驶、服务机器人和工业自动化等领域,从“理解世界”迈向“改变世界”。从实验室的技术突破到行业的大规模应用,视觉大模型正在以前所未有的速度改变着我们的生活方式和工作方式。随着技术的不断进步和生态系统日益完善,可以预见,在不久的将来,视觉大模型将像电力和水资源一样,渗透到社会生产和生活的每一个角落,成为推动新型生产力发展的核心力量。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号