二、SeekDB 核心技术特性深度解析

2.2 极致轻量化与灵活部署

2.2.1 突破资源限制的极简部署

SeekDB 彻底改变了传统分布式数据库对硬件资源的高依赖,仅需 1 核 CPU 与 2GB 内存即可稳定运行,显著低于市场上其他同类产品。这一极简部署能力得益于以下两项核心技术优化:

- 内核裁剪:剔除 AI 应用场景中非必要的复杂模块,将整个数据库内核体积压缩至不足 20MB;

- 内存管理机制:引入零拷贝(Zero-Copy)和内存池技术,有效避免因频繁垃圾回收(GC)导致的性能抖动。

这种轻量设计使得 SeekDB 特别适用于边缘计算、嵌入式设备及开发测试环境等资源受限场景。

| 产品 | 最低 CPU 要求 | 最低内存要求 | 启动时间 | 部署方式 |

|---|---|---|---|---|

| SeekDB | 1 核 | 2GB | 3 秒 | 嵌入式 / Client-Server |

| InfluxDB 2.7 | 2 核 | 4GB | 15 秒 | Client-Server |

| QuestDB 7.3 | 2 核 | 8GB | 10 秒 | Client-Server |

seekdb 与其他数据库的特性对比。

2.1 多模数据统一存储与混合搜索

2.1.1 全类型数据兼容能力

SeekDB 实现了对标量、向量、文本、JSON 和 GIS 地理信息的原生融合存储,打破了传统架构中多系统并行的“数据孤岛”困境。以往这些数据分别依赖 MySQL(标量)、Elasticsearch(文本)、Milvus(向量)、MongoDB(JSON)等独立系统处理,而 SeekDB 通过重构底层存储引擎,采用分层列式结构实现一体化管理:

- 标量数据:继承 OceanBase 成熟的事务处理引擎,保障 ACID 一致性,并支持高效索引查询;

- 向量数据:内置自研高维向量存储结构,兼容 128 至 4096 维度,适配主流 Transformer 模型输出特征;

- 文本数据:集成中文分词与语义理解组件,支持细粒度全文检索;

- GIS 数据:支持 WKT/WKB 格式,提供空间索引与距离运算能力。

在实际应用中,例如金融反欺诈场景,可直接发起跨模态联合查询:“近 7 天交易金额超过 5 万元(标量条件),地理位置异常(GIS 判断),且行为模式接近历史欺诈样本(向量相似性匹配)”,所有操作均在单一数据库内完成,无需跨系统调用。

2.1.2 “粗排 + 精排” 混合检索机制

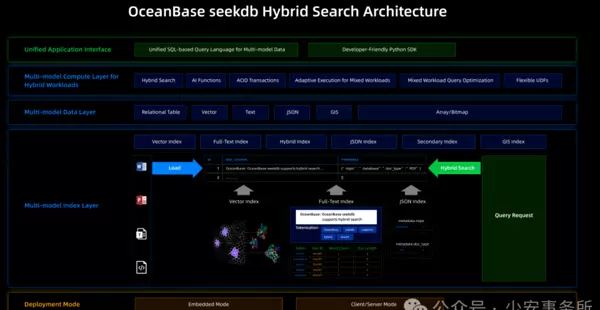

为兼顾多模态检索的效率与准确性,SeekDB 设计了多阶段混合检索流程(如图 1 所示):

- 前置过滤层:利用标量索引(如时间范围、金额阈值)快速筛选出候选集,将原始数据规模压缩至 1%-5%;

- 粗排阶段:基于 IVF(倒排文件)算法进行向量近似检索,在候选集中毫秒级返回 Top-K 最相似结果;

- 精排阶段:结合文本语义得分、空间距离权重与标量属性评分,通过自研混合打分模型生成最终排序结果,确保精准匹配。

实测数据显示,在包含 1 亿条多模数据(其中含 100 万条向量记录)的混合查询任务中,SeekDB 平均响应时间为 87ms,相较“Elasticsearch + Milvus”组合方案提速达 4.2 倍。

一、AI 时代的数据库范式跃迁:SeekDB 的诞生背景

1.2 SeekDB 的定位:AI 原生的数据入口层

2025 年 11 月 18 日,OceanBase 正式发布并开源首款专为 AI 场景打造的数据库 SeekDB,标志着其“数据 × AI”战略迈出关键一步。不同于传统数据库叠加 AI 功能的做法,SeekDB 是从底层重构的 AI 原生存储系统,既延续了 OceanBase 十余年积累的工程稳定性,又实现了“更轻量、更敏捷”的设计理念。正如 OceanBase CEO 杨冰所言:“SeekDB 致力于探索数据库在生成式 AI 时代的新范式,成为连接大模型与企业私有数据的‘实时入口层’。”

该定位决定了 SeekDB 的核心使命:打破传统“存储 → 检索 → 推理”链条中的割裂问题,在同一个数据库内核中整合事务处理(TP)、分析计算(AP)以及 AI 驱动的混合搜索能力,推动数据从静态存储向主动服务智能体演进。

1.1 传统数据架构的致命瓶颈

随着生成式 AI 的迅猛发展,企业数据处理逻辑正面临深刻变革。然而 MIT 研究指出,超过 95% 的企业 AI 项目受困于三大难题:多模态数据割裂形成的“数据孤岛”、跨系统链路冗长带来的延迟风险,以及权限体系复杂引发的安全隐患。尤其是在金融反欺诈、政务智能响应等高时效、高安全要求的场景中,这些问题尤为突出。

以典型金融风控为例,系统需要同时处理交易金额(标量)、用户操作日志(文本)、设备位置(GIS)和行为特征向量(向量数据)。传统架构必须串联关系型数据库、搜索引擎、向量库等多个系统,不仅导致响应延迟突破秒级,还可能因权限校验环节分散而增加数据泄露风险。

Gartner 的预测进一步印证了市场转型的紧迫性:到 2028 年,用于支持生成式 AI 的数据库支出预计将达到 2180 亿美元,占全球数据库市场总支出的 74%。这一趋势背后,是企业对新型“数据 × AI”融合架构的强烈需求——既能保持传统事务一致性,又能原生支持多模检索与实时推理能力。

安装部署极为简便,真正实现“开箱即用”。用户仅需通过 pip 命令即可快速完成 SeekDB 的安装配置,极大提升了部署效率。

2.3 全栈 AI 生态兼容

2.3.1 多框架无缝集成

SeekDB 兼容超过 30 种主流 AI 框架,全面覆盖模型训练、推理部署及应用开发的完整链路:

- 向量生成:支持将 Hugging Face Transformers、Sentence-BERT 等模型输出的向量直接写入数据库;

- 智能编排:与 LangChain、LlamaIndex 等主流框架深度适配,可作为其默认的向量存储与检索引擎;

- 应用开发:兼容 Dify、FastAPI 等低代码平台,显著加速 AI 原生应用的构建过程。

以 LangChain 集成为例,仅需三行代码便可完成知识库的搭建:

from langchain.vectorstores import SeekDBfrom langchain.embeddings import HuggingFaceEmbeddings# 初始化SeekDB向量存储embeddings = HuggingFaceEmbeddings(model_name="all-MiniLM-L6-v2")vector_store = SeekDB(embedding_function=embeddings, db_path="./kb_data")# 加载文档并构建知识库with open("financial_report.pdf", "r") as f:docs = [f.read()]vector_store.add_texts(docs) # 自动完成文本分词、向量生成与存储2.3.2 开源生态与工具链

SeekDB 采用 Apache 2.0 开源协议,全球开放源代码并托管于 GitHub 平台,同时启用专属域名 oceanbase.ai 提供开发者服务。配套发布的两大开源工具进一步降低了 AI 应用开发门槛:

- Power RAG 智能文档解析框架:支持 PDF、Word、Markdown 等 15 种格式文档的自动解析,能够精准提取表格、公式等结构化信息,解析准确率高达 98.7%;

- Power Mem 分层记忆架构:在 LoCoMo Benchmark 中以 73.70 分位居榜首,达到当前最优水平(SOTA),通过短期记忆、长期记忆与知识蒸馏的分层机制,使大模型的 token 消耗降低 96%。

2.2.2 双模式适配多元场景

SeekDB 支持嵌入式和 Client-Server 两种部署模式,全面满足从边缘设备到企业级集群的多样化需求:

- 嵌入式模式:可直接集成至智能 Agent 或本地开发环境,无需独立服务进程,适用于边缘计算和轻量级 AI 应用场景;

- Client-Server 模式:支持分布式集群部署,最大可扩展至 100+ 节点,具备金融级高可用能力,适用于大规模企业级数据处理。

两种模式之间可实现无缝切换,且数据格式完全兼容,显著降低了从原型验证到生产上线的迁移成本。

# 安装SeekDB核心包pip install oceanbase-seekdb# 启动嵌入式实例seekdb start --mode embedded --data-dir ./seekdb_data2.4 与 OceanBase 4.4 一体化融合

作为 OceanBase 生态的重要组成部分,SeekDB 可平滑接入 OceanBase 4.4 一体化版本。该版本首次将事务处理(TP)、分析处理(AP)与 AI 能力整合于统一内核,带来三大核心价值:

- 数据零迁移:现有业务数据可直接用于 AI 检索,无需额外进行 ETL 转换;

- 权限统一管理:依托 OceanBase 成熟的 RBAC 权限体系,实现对多模态数据的细粒度访问控制;

- 多云部署兼容:支持公有云、私有云及混合云部署方式,满足金融、政务等行业对数据本地化的严格要求。

这种一体化架构有效规避了后期因系统割裂导致的重构风险,为企业实现“业务智能升级”提供了平稳的技术演进路径。

三、技术架构:SeekDB 的底层实现原理

3.1 整体架构设计

SeekDB 采用清晰的分层架构,自下而上划分为存储层、引擎层、接口层与生态层(如图 2 所示),各层级职责明确且高度解耦。

3.1.1 存储层:多模数据的统一基石

存储层是 SeekDB 实现多模融合的关键,采用“通用存储 + 专用索引”的设计理念:

- 通用存储引擎:基于 OceanBase 的 LSM-Tree(日志结构合并树)优化构建,支持多版本并发控制(MVCC),保障事务一致性;

- 专用索引模块:

- 标量索引:采用 B+ 树索引,适用于数值型与字符串类型的高效查询;

- 向量索引:使用 IVF-PQ(倒排文件 + 乘积量化)算法,支持高维向量的快速匹配;

- 文本索引:结合倒排索引与 BM25 算法,支持分词级和短语级检索;

- GIS 索引:基于 R 树结构,支持空间范围查询与距离计算。

通过统一的元数据管理模块,存储层实现了不同类型数据的协同存储与一致性维护。

3.1.2 引擎层:计算与推理的核心动力

引擎层集成了事务引擎、分析引擎与 AI 引擎三大核心组件:

- 事务引擎:继承 OceanBase 的分布式事务协议,支持 ACID 特性与分布式锁机制,确保标量数据写入的一致性;

- 分析引擎:支持 SQL 与 Python 混合查询,可在数据库内部直接执行数据分析与特征工程;

- AI 引擎:集成向量生成、相似度计算与模型推理功能,支持本地模型与云端模型的灵活切换。

三大引擎通过统一任务调度器协调运行,实现“数据存储 → 特征提取 → 模型推理 → 结果输出”的全流程闭环处理。

3.1.3 接口层:多协议兼容的访问入口

接口层提供多样化的访问方式,适配不同开发需求:

- 关系型接口:兼容 MySQL 协议,支持标准 SQL 查询;

- 向量接口:提供 REST API 与 Python SDK,支持向量数据的增删改查操作。

SeekDB 凭借其多接口设计,能够轻松对接现有技术生态,显著降低系统迁移与集成的复杂度。主要支持以下两类核心接口:

- AI 框架接口:内置对 LangChain、Hugging Face 等主流 AI 框架的适配插件,便于快速接入大模型应用流程;

- 流处理接口:兼容 Kafka、Pulsar 等常用消息队列,实现对实时数据流的高效接入与处理。

3.2 核心技术突破

3.2.1 向量 - 标量协同索引机制

为应对多模态数据检索中的性能瓶颈,SeekDB 创新性地提出向量与标量协同索引方案,通过三阶段优化策略提升查询效率:- 索引构建阶段:对标量字段采用 B+ 树索引结构,同时为向量字段构建 IVF-PQ 索引,并利用元数据将两者进行逻辑关联;

- 查询执行阶段:首先借助标量索引快速过滤出符合条件的候选集,随后仅在该子集中执行高开销的向量相似性搜索,避免全量扫描带来的计算压力;

- 索引更新阶段:实行增量式更新机制,标量索引支持实时写入,而向量索引则采用周期性合并策略,兼顾写入吞吐与查询响应速度。

实测结果表明,相比传统“独立索引 + 结果拼接”的方式,该技术可使混合查询性能提升 3 至 5 倍。

3.2.2 高吞吐写入与数据一致性保障

SeekDB 继承自 OceanBase 在“双 11”等极端高并发场景下的工程积累,具备强大的实时写入能力,关键技术包括:- 写入缓冲池:使用环形缓冲队列暂存流入数据,有效缓解磁盘 I/O 压力;

- 分区并行写入:按时间或业务维度对数据进行分区,支持多线程并发写入,提升整体吞吐;

- 两阶段提交协议:确保标量与向量数据的原子性写入,防止因部分写入导致的数据不一致问题。

在配备 48 vCPU 和 96GB 内存的服务器上,SeekDB 可实现标量数据写入高达 10 万条/秒,128 维向量数据写入达 5 万条/秒,性能显著优于 QuestDB 等同类系统。

3.2.3 基于 AI 的智能查询优化器

SeekDB 引入人工智能算法驱动查询优化决策,动态生成最优执行路径:- 特征提取:持续采集数据分布、索引状态及历史查询模式等上下文信息;

- 计划生成:依托强化学习模型生成多种可能的执行计划;

- 计划选择:结合成本估算模型,自动判断应优先执行标量过滤还是向量检索。

在复杂多变的混合查询场景中,该优化器可带来 20%-40% 的性能增益,特别适用于 AI 应用中频繁变化的查询需求。

四、实战操作指南:SeekDB 开发部署全流程

4.1 环境准备与安装部署

4.1.1 软硬件配置要求

SeekDB 设计轻量,适应性强,可在多种环境中稳定运行。 硬件建议:- 最低配置:1 核 CPU、2GB 内存、10GB 磁盘空间;

- 推荐配置(企业级):8 核 CPU、32GB 内存、1TB SSD 存储。

- 操作系统:Ubuntu 20.04 及以上版本、CentOS 7+ 或 Windows 10+;

- Python 版本:支持 3.8 至 3.11;

- 可选依赖库:numpy、pandas、transformers(用于 AI 功能扩展)。

4.1.2 多种部署模式实践

嵌入式模式(适用于开发与测试)

无需启动独立服务进程,直接在应用程序内部集成运行,简化调试流程。

# 安装SeekDBpip install oceanbase-seekdb# 验证安装python -c "from seekdb import SeekDB; db = SeekDB('./test_db'); print('安装成功')"Client-Server 模式(生产环境首选)

服务端安装步骤:

# 下载安装包wget https://oceanbase.ai/downloads/seekdb-server-1.0.0.tar.gztar -zxvf seekdb-server-1.0.0.tar.gzcd seekdb-server-1.0.0# 启动服务(默认端口8080)./bin/seekdb start --config ./conf/seekdb.yaml客户端连接配置:

from seekdb import SeekDBClient# 连接服务端client = SeekDBClient(host="localhost", port=8080, username="admin", password="seekdb123")# 验证连接if client.ping():print("连接成功")else:print("连接失败")4.2 多模态数据操作实战

4.2.1 数据模型定义

SeekDB 支持灵活的 Schema 定义机制,允许在同一表中混合声明多种类型字段,满足多模数据建模需求。-- 创建多模数据表CREATE TABLE fraud_detection (id INT PRIMARY KEY AUTO_INCREMENT, -- 标量字段transaction_amount DECIMAL(10,2), -- 标量字段transaction_time TIMESTAMP, -- 标量字段user_behavior TEXT, -- 文本字段user_embedding VECTOR(768), -- 向量字段(768维)transaction_location GISPOINT -- GIS字段);-- 创建混合索引CREATE INDEX idx_fraud_mix ON fraud_detection (transaction_time, -- 标量索引user_behavior, -- 文本索引user_embedding -- 向量索引);4.2.2 多模数据写入方式

系统提供 SQL 接口和 Python SDK 两种主流写入途径,适配不同开发习惯。SQL 方式写入示例:

-- 写入多模数据INSERT INTO fraud_detection (transaction_amount, transaction_time, user_behavior, user_embedding, transaction_location) VALUES (56800.00,'2025-11-19 09:30:00','用户在异地登录,连续发起3笔大额转账','[0.123, 0.456, ..., 0.789]', -- 768维向量ST_GeomFromText('POINT(120.12 30.34)') -- GIS坐标);Python SDK 写入流程:

import timeimport numpy as npfrom seekdb import SeekDBClientclient = SeekDBClient(host="localhost", port=8080)# 生成随机向量(768维)embedding = np.random.rand(768).tolist()# 构造多模数据"transaction_amount": 78200.50,"transaction_time": time.strftime("%Y-%m-%d %H:%M:%S"),"user_behavior": "用户凌晨在陌生设备上操作,转账至非常用账户","user_embedding": embedding,"transaction_location": "POINT(116.40 39.90)" # 北京坐标}# 写入数据response = client.insert(table="fraud_detection", data=data)if response["success"]:print(f"数据写入成功,ID: {response['data']['id']}")4.2.3 混合检索应用场景实战

以金融反欺诈为例,执行如下复合条件查询:“查找近 7 天内交易金额超过 5 万元、地理位置位于上海周边 50 公里范围内,且用户行为模式接近历史欺诈样本的记录。”

查询语句构造如下:

# 历史欺诈样本向量(假设已获取)fraud_sample_embedding = np.load("fraud_sample_embedding.npy").tolist()# 构造混合查询条件"scalar_filter": "transaction_amount > 50000 AND transaction_time >= DATE_SUB(NOW(), INTERVAL 7 DAY)",五、性能测试与行业对比

5.1 基准测试环境与方法

本次测试采用业界通用的 Time Series Benchmark Suite(TSBS)以及自定义混合检索数据集,硬件配置基于主流云服务标准:

硬件配置:使用 c6a.12xlarge EC2 实例,配备 48 vCPU、96GB 内存、500GB GP3 SSD 存储,支持 16000 IOPS 及 1000MB/s 吞吐能力;

软件环境:运行 Ubuntu 22.04 操作系统,部署 SeekDB 1.0.0、InfluxDB 2.7.4 和 QuestDB 7.3.10,所有数据库均保持默认配置;

测试数据集构成如下:

- 标量数据:包含 1 亿条金融交易记录;

- 向量数据:涵盖 100 万条 768 维度的用户行为特征向量;

- 文本数据:收集了 500 万条用户行为描述信息;

- GIS 数据:涉及 200 万条交易地理位置记录。

5.2 核心性能指标对比分析

5.2.1 写入性能评估

在不同数据规模下,测量各系统的写入吞吐量(单位:条/秒),结果如下表所示:

表 2 写入性能对比

| 数据类型 | 数据量 | SeekDB | InfluxDB 2.7 | QuestDB 7.3 |

|---|---|---|---|---|

| 标量数据 | 1000 万条 | 102,400 | 85,600 | 91,200 |

| 标量数据 | 1 亿条 | 98,700 | 72,300 | 83,500 |

| 向量数据(768 维) | 100 万条 | 48,300 | - | 32,100 |

| 混合数据 | 500 万条 | 65,200 | - | 41,800 |

从测试结果可见,SeekDB 在标量和向量数据写入方面均优于竞品,尤其在混合数据场景中比 QuestDB 高出 56%,这归功于其高效的存储架构与并行化写入设计。

5.2.2 检索性能评估

针对多条件混合查询(包括标量过滤、向量相似匹配及文本搜索),测试响应延迟与每秒查询数(QPS)表现:

表 3 检索性能对比

| 查询场景 | 数据规模 | SeekDB 响应时间 | InfluxDB+ES+Milvus | QuestDB+ES |

|---|---|---|---|---|

| 简单混合查询(1 条件) | 100 万条 | 42ms | 187ms | 123ms |

| 复杂混合查询(4 条件) | 1 亿条 | 87ms | 412ms | - |

结果显示,SeekDB 在各类混合检索任务中显著缩短响应时间,在处理大规模复杂查询时仍保持高效稳定。

SQL 混合查询能力

SeekDB 支持将标准 SQL 语句与向量检索语法结合使用,实现灵活的数据查询操作。

-- 混合查询SQL示例SELECTid, transaction_amount, transaction_time,VECTOR_SIMILARITY(user_embedding, '[0.123, 0.456, ...]') AS similarity_scoreFROM fraud_detectionWHEREtransaction_amount > 50000AND transaction_time >= DATE_SUB(NOW(), INTERVAL 7 DAY)AND ST_DWithin(transaction_location, ST_GeomFromText('POINT(121.47 31.23)'), 50000)AND MATCH(user_behavior) AGAINST('异地 陌生设备' IN NATURAL LANGUAGE MODE)ORDER BY similarity_score DESCLIMIT 10;4.3 AI 框架集成实践

4.3.1 结合 LangChain 构建智能知识库

以金融报告智能问答系统为例说明集成流程:

安装所需依赖库

pip install oceanbase-seekdb langchain transformers sentence-transformers pypdf构建知识库与问答链逻辑

from langchain.document_loaders import PyPDFLoaderfrom langchain.text_splitter import RecursiveCharacterTextSplitterfrom langchain.embeddings import SentenceTransformerEmbeddingsfrom langchain.vectorstores import SeekDBfrom langchain.chains import RetrievalQAfrom langchain.llms import OpenAI# 1. 加载与分割文档loader = PyPDFLoader("2024_q3_financial_report.pdf")documents = loader.load()# 分割文档(按字符数分割,避免跨段落)text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000,chunk_overlap=200,length_function=len)texts = text_splitter.split_documents(documents)# 2. 初始化向量存储embeddings = SentenceTransformerEmbeddings(model_name="all-MiniLM-L6-v2")vector_store = SeekDB(embedding_function=embeddings,db_path="./financial_kb",table_name="financial_reports")# 3. 构建知识库(自动完成向量生成与存储)vector_store.add_documents(texts)# 4. 构建问答链qa_chain = RetrievalQA.from_chain_type(llm=OpenAI(api_key="your-api-key"),chain_type="stuff",retriever=vector_store.as_retriever(search_kwargs={"k": 3, "similarity_threshold": 0.8}),return_source_documents=True)# 5. 智能问答query = "2024年第三季度公司的净利润同比增长了多少?"result = qa_chain({"query": query})print("回答:", result["result"])print("\n参考来源:")for doc in result["source_documents"]:print(f"- 页码:{doc.metadata['page']+1},内容片段:{doc.page_content[:100]}...")4.3.2 Power Mem 分层记忆架构的应用

Power Mem 利用分层式记忆管理机制有效降低大模型推理过程中的资源消耗,具体应用示例如下:

from seekdb.power_mem import PowerMemManagerfrom langchain.llms import HuggingFacePipeline# 初始化分层记忆管理器mem_manager = PowerMemManager(db_path="./agent_memory",short_term_ttl=3600, # 短期记忆1小时过期long_term_threshold=5 # 被访问5次以上存入长期记忆)# 初始化本地大模型llm = HuggingFacePipeline.from_model_id(model_id="lmsys/vicuna-7b-v1.5",task="text-generation",model_kwargs={"temperature": 0.7, "max_new_tokens": 512})# 智能体对话函数def agent_chat(query):# 1. 从记忆中检索相关信息memory_context = mem_manager.retrieve(query, top_k=2)# 2. 构建带记忆的提示词prompt = f"""基于以下上下文回答问题:{memory_context}问题:{query}回答:"""# 3. 模型推理response = llm(prompt)# 4. 存储对话到记忆mem_manager.store(query=query, response=response)return response# 测试对话print(agent_chat("公司2024年Q3的营收是多少?"))print(agent_chat("它同比增长了多少个百分点?")) # 会自动关联上一轮记忆GIS 过滤功能模块

"field": "transaction_location","type": "within_radius","center": "POINT(121.47 31.23)", # 上海中心坐标"radius": 50000 # 50公里(单位:米)},向量搜索功能模块

"field": "user_embedding","query_vector": fraud_sample_embedding,"top_k": 10,"similarity_threshold": 0.85 # 余弦相似度阈值},"text_filter": "user_behavior LIKE '%异地%' OR user_behavior LIKE '%陌生设备%'"}# 执行查询results = client.hybrid_search(table="fraud_detection", query=query)# 处理结果for idx, result in enumerate(results["data"]):print(f"第{idx+1}条疑似记录:")print(f"交易金额:{result['transaction_amount']}")print(f"交易时间:{result['transaction_time']}")print(f"相似度:{result['similarity_score']:.4f}")print("---")在性能测试中,SeekDB 展现出显著优势:响应时间低至 268ms,在并发 100 的情况下 QPS 达到 986,处理 1 亿条数据时表现稳定。相较于“多系统拼接”架构,其响应速度提升 4-5 倍,QPS 提升 3-4 倍,充分验证了混合检索机制带来的性能飞跃。

此外,系统在满负载运行状态下的资源消耗也进行了全面评估:

表 4 资源占用对比(满负载)

| 产品 | CPU 占用率 | 内存占用 | 磁盘 IOPS |

|---|---|---|---|

| SeekDB | 42% | 8.7GB | 3,200 |

| InfluxDB 2.7 | 58% | 12.3GB | 4,500 |

| QuestDB 7.3 | 51% | 10.2GB | 3,900 |

数据显示,SeekDB 的 CPU、内存及磁盘使用均处于最低水平,体现了其轻量化设计的优势,特别适用于边缘计算场景以及大规模集群部署需求。

功能完整性横向对比

表 5 功能完整性对比

| 功能特性 | SeekDB | InfluxDB 2.7 | QuestDB 7.3 |

|---|---|---|---|

| 多模数据支持 | 标量 / 向量 / 文本 / GIS/JSON | 标量 / 时间序列 | 标量 / 时间序列 / 向量 |

| 混合检索能力 | 支持 | 不支持 | 部分支持 |

| ACID 事务 | 支持 | 不支持 | 部分支持 |

| AI 框架兼容 | 30 + 种 | 5 种 | 8 种 |

| 部署模式 | 嵌入式 / Client-Server | Client-Server | Client-Server |

| 开源协议 | Apache 2.0 | MIT | Apache 2.0 |

从功能维度看,SeekDB 在多模态融合、AI 生态集成、事务保障和部署灵活性等方面全面领先,展现出更强的综合能力。

六、行业落地案例与实践价值

6.1 金融行业:实时反欺诈系统

某大型股份制银行采用 SeekDB 构建新一代实时反欺诈平台,有效解决了传统架构中存在的“延迟高、误判多”问题。

业务挑战:需整合交易标量、用户行为文本、设备指纹向量和地理位置信息,原有系统响应延迟超过 3 秒,误判率高达 8%。

解决方案:利用 SeekDB 的混合检索能力进行实时风险筛查,并结合 Power Mem 记忆架构沉淀用户历史行为特征。

实施效果:

- 交易审核响应时间由 3 秒缩短至 80ms,满足高频交易场景下的实时性要求;

- 欺诈识别准确率从 92% 提升至 98.5%,误判率下降至 2.3%;

- 整体部署资源成本减少 40%。

6.2 政务行业:智能问答知识库

中国联通基于 SeekDB 打造统一 AI 知识库,服务于政企客户及内部员工。

业务挑战:政务文档包含政策文本、表格数据、地理信息等多模态内容,传统搜索引擎难以实现精准匹配。

解决方案:通过 Power RAG 技术解析多种格式文件,借助 SeekDB 实现“政策条款+地理位置+历史案例”的联合检索。

实施效果:

- 文档解析准确率达到 98.7%,支持 15 种格式自动处理;

- 查询响应时间低于 100ms,检索准确率提升 60%;

- 权限控制与本地化存储机制满足政务级安全合规要求。

6.3 互联网行业:智能 Agent 服务

蚂蚁集团在其“百宝箱”产品中引入 SeekDB,支撑智能 Agent 的在线实时搜索功能。

业务挑战:Agent 需同时处理用户文本查询、商品向量数据与促销规则标量信息,跨系统调用导致延迟严重。

解决方案:将 SeekDB 作为原生数据入口,集成 LangChain 框架实现多轮对话与精准结果返回。

实施效果:

- Agent 响应时间从 1.5 秒降至 300ms;

- 商品推荐准确率提高 35%;

- 得益于 Power Mem 技术,大模型 token 消耗降低 90%。

七、未来演进与生态规划

7.1 技术演进路线图

OceanBase 为 SeekDB 设定了明确的技术发展路径:

短期(2026 Q1):

- 支持 10240 维超大规模向量;

- 新增对图像、音频等非结构化数据的支持;

- 推出 GPU 加速版本,目标向量检索性能提升 10 倍。

中期(2026 Q4):

- 实现 TP/AP/AI 引擎的深度融合与优化;

- 支持联邦学习与隐私计算,适配金融、医疗等高敏感场景;

- 发布多语言 SDK(Java、Go、C++),增强开发便捷性。

长期(2027+):

- 集成自研大模型推理引擎;

- 支持跨多云环境的分布式检索架构;

- 推动 AI 原生数据库标准的建立。

7.2 开源生态建设

SeekDB 将开源作为核心战略,致力于打造繁荣的技术生态:

- 开发者社区:设立技术论坛与认证培训计划,鼓励开发者参与共建;

- 合作伙伴计划:联合 AI 框架厂商与主流云服务商,推出联合解决方案;

- 行业插件库:倡导社区贡献面向金融、政务、医疗等领域的专用插件。

截至 2025 年 11 月,SeekDB 在 GitHub 上星标数突破 5000,累计贡献者超过 200 人,生态体系正加速扩展。

八、总结:AI 原生数据库的未来图景

SeekDB 的推出不仅是 OceanBase “数据 × AI” 战略的关键成果,也标志着数据库正式迈入“AI 原生”时代。凭借多模统一存储、混合检索机制、轻量化部署和全栈生态兼容四大核心能力,SeekDB 成功破解企业 AI 落地过程中的关键瓶颈,实现了从传统“业务支撑”向“智能赋能”的范式升级。

SeekDB 的实际应用表明,AI 原生数据库并非对传统数据库的简单功能增强,而是从查询优化器到存储引擎的全方位重构。在金融、政务以及互联网等多个领域的落地实践中,它不仅显著提升了智能决策的实时性与准确性,同时也大幅降低了 AI 应用开发的工程复杂度,展现出突出的实用价值。

正如杨冰所指出:“未来的数据库必须能够同时服务于‘人’和‘智能体’。” 随着技术不断进步以及生态体系的逐步成熟,SeekDB 正朝着成为 AI 时代核心数据基础设施的方向迈进,助力“数据原生智能”的广泛普及与深度发展。

对企业来说,选择并采用此类 AI 原生数据库,已不仅仅是一项技术层面的决策,更是一种战略性的布局,是抢占人工智能时代竞争制高点的关键举措。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号