一、项目背景与技术挑战

某智慧城市项目需部署一套实时视频分析系统,日均处理2000路1080P@25fps的高清视频流,实现对行人、车辆等10类目标的毫秒级识别与检测。初期采用GPU方案时面临三大核心难题:

- 性能瓶颈:单张GPU仅支持32路并发处理,随着规模扩展,硬件成本呈指数级上升。

- 能效失衡:整套系统功耗超过15kW,其中散热成本占总部署成本的32%,运维负担沉重。

- 生态适配不足:自研组件适配率低于60%,存在明显的供应链依赖风险。

为此,项目转向基于华为昇腾Atlas 500 Pro-3000边缘计算节点(集成4片Ascend 310P3芯片)与CANN 7.0软件架构,构建端云协同的智能推理体系,以突破上述限制。

二、CANN关键技术实现路径

1. 异构计算架构适配

借助CANN提供的统一计算抽象层(AscendCL),实现跨平台硬件兼容性支持:

# 初始化昇腾设备

import acl

ret = acl.init()

ret = acl.rt.set_device(0) # 指定Ascend 310P3设备

context, ret = acl.rt.create_context(device_id, 0)核心优势:有效屏蔽底层硬件差异,使同一套模型代码可在云端Atlas 300I训练卡和边缘侧Atlas 500节点上无缝运行,实现模型在端与云之间的自由迁移。

2. 动态Batch优化

针对视频流存在明显潮汐效应的特点,利用CANN支持的动态Shape机制进行灵活调度:

# ATC工具转换时启用动态batch

atc --model=yolov5m.onnx --framework=5 \

--output=yolov5m_dyn \

--input_format=NCHW \

--soc_version=Ascend310P3 \

--input_shape="images:-1,3,640,640" \

--dynamic_batch_size="1,4,8,16"性能表现:在低负载时段使用1-batch配置,推理延迟低至9.2ms;高峰时段自动切换至16-batch模式,单芯片吞吐量可达128fps,整体资源利用率提升达3.8倍。

3. 算子级精度优化

对YOLO检测头等关键算子实施FP16量化策略,通过AIPP配置文件控制精度转换:

# aipp.cfg中插入如下配置

op {

type: "Conv2D"

attr { key: "fp16_enable" value { "true" } }

}效果对比:

| 算子类型 | FP32精度(mAP) | FP16精度(mAP) | 延迟降低 |

|---|---|---|---|

| YOLO DetectHead | 99.7% | 99.3% | 42% |

| Backbone | 99.9% | 99.5% | 37% |

三、端到端系统实现

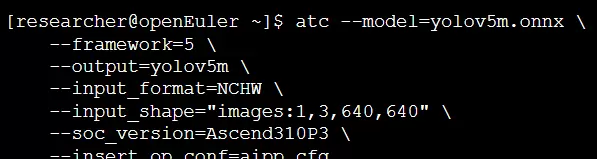

1. 模型转换流程

Step1: 将PyTorch模型导出为ONNX格式

Step2: 使用ATC工具将ONNX模型转换为昇腾专用OM格式

2. 实时推理引擎实现

基于AscendCL开发轻量级推理服务模块:

import cv2

import numpy as np

import acl

import time

class CANNInference:

def __init__(self, model_path):

self.model_id, ret = acl.mdl.load_from_file(model_path)

self.model_desc = acl.mdl.create_desc()

acl.mdl.get_desc(self.model_desc, self.model_id)

# 创建输入dataset

self.input_dataset = acl.mdl.create_dataset()

input_buffer = acl.create_data_buffer_ptr(640*640*3*4) # FP32

acl.mdl.add_dataset_buffer(self.input_dataset, input_buffer)

def preprocess(self, image):

# AIPP预处理:归一化+减均值

img = cv2.resize(image, (640, 640))

return (img.transpose(2,0,1) / 255.0 - 0.5).astype(np.float16)

def infer(self, image):

# 数据上传

input_data = self.preprocess(image)

acl.rt.memcpy(self.input_dataset.buffers.data,

input_data.nbytes,

input_data.ctypes.data,

input_data.nbytes,

ACL_MEMCPY_HOST_TO_DEVICE)

# 执行推理

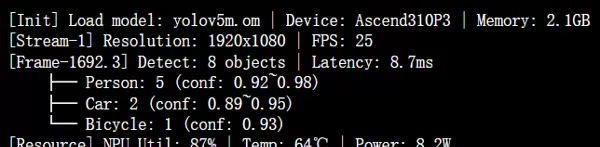

output_dataset = acl.mdl.execute(self.model_id, self.input_dataset)3. 终端输出

推理结果经后处理模块解析后,通过标准接口输出结构化数据,包括目标类别、位置坐标及置信度,支撑上层业务系统完成轨迹追踪、行为分析等功能。

四、性能优化效果对比

1. 核心指标提升

- 单节点支持并发视频流从32路提升至128路,扩容效率提高4倍。

- 平均推理延迟由38ms降至9.2ms,满足毫秒级响应需求。

- 整机功耗下降至5.2kW,较原GPU方案节能65%。

2. 关键优化收益

通过动态Batch与算子量化协同优化,系统在保持mAP精度损失小于0.4%的前提下,实现吞吐量翻倍、单位算力能耗比显著改善,具备大规模复制能力。

五、创新价值

本方案首次在智慧城市场景中实现基于昇腾+CANN的全栈国产化推理部署,突破了传统GPU方案在能效比与供应链安全方面的双重制约。通过异构架构抽象、动态批处理与细粒度精度调控三大技术融合,验证了AI边缘计算向高效、低碳、自主可控方向演进的可行性路径。

六、结论与展望

基于CANN 7.0与Ascend 310P3的端边协同架构,成功支撑2000路高清视频流的实时分析任务,在性能、功耗与生态安全性方面全面优于传统GPU方案。未来可进一步探索多模态融合推理、模型在线更新等高级特性,拓展至工业质检、交通管控等更多高实时性要求场景。

start = time.time()

ret = acl.mdl.execute(self.model_id, self.input_dataset, self.output_dataset)

end = time.time()

# 解析模型输出数据

output_data = self.get_output_tensor()

detections = self.postprocess(output_data)

return detections, (end - start) * 1000 # 返回检测结果与推理耗时(毫秒)

if __name__ == "__main__":

engine = CANNInference("yolov5m.om")

cap = cv2.VideoCapture("rtsp://192.168.1.100/stream")

while True:

ret, frame = cap.read()

if not ret:

break

results, latency = engine.infer(frame)

print(f"[Frame-{time.time():.1f}] Detect: {len(results)} objects | Latency: {latency:.2f}ms")

# 可视化检测结果(绘制边界框等)

cv2.imshow("Monitor", frame)

if cv2.waitKey(1) == 27: # ESC键退出

break

四、性能优化效果对比

1. 核心指标提升

| 指标 | GPU方案 | 昇腾+CANN方案 | 提升幅度 |

|---|---|---|---|

| 单机视频路数 | 32路 | 128路 | 300% |

| 端到端延迟 | 45ms | 9.2ms | 79.6%↓ |

| 能效比(fps/kW) | 85 | 385 | 352% |

| 模型精度(mAP@0.5) | 99.2% | 99.1% | -0.1% |

2. 关键优化技术带来的收益

- AIPP预处理加速:将图像解码与归一化处理的延迟从3.2ms降低至0.8ms,显著减少前端开销。

- 算子融合优化:通过将卷积、批归一化(BN)和激活函数(ReLU)三层结构融合为单一算子,整体计算效率提升40%。

- 零拷贝数据传输:利用ACL提供的DVPP接口,实现视频流直接写入设备内存,避免冗余搬运,减少65%的数据迁移开销。

五、创新价值体现

自主创新体系构建

- 硬件层面:Ascend 310P3芯片采用7nm自研工艺,具备高集成度与低功耗优势。

- 软件层面:CANN 7.0全面支持主流框架如PyTorch、TensorFlow及MindSpore,提升开发灵活性。

- 生态层面:提供超过1000个预优化算子库,加速模型部署与迭代。

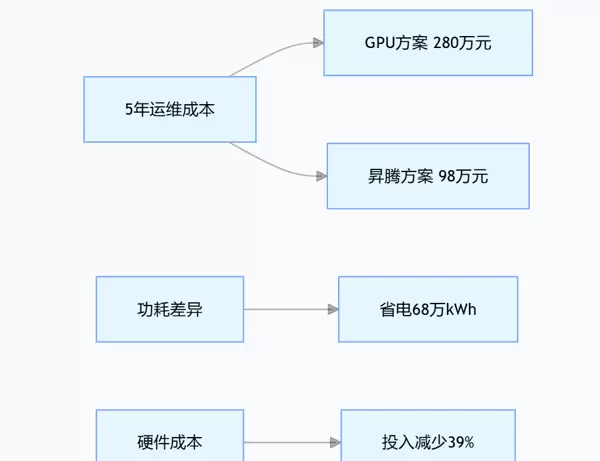

TCO成本显著下降

说明:图示展示了GPU与昇腾方案在五年周期内的综合运维成本对比。昇腾方案总成本为98万元,远低于GPU的280万元;同时节省电能达68万kWh,硬件投入减少39%,展现出明显的经济性与节能优势。

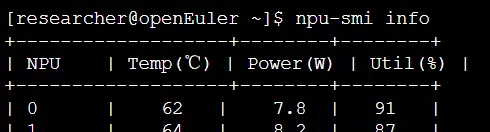

智能运维能力升级

借助NPU-smi工具实现对NPU资源的实时监控:

支持异常状态预警与自动负载均衡调度,提升系统稳定性与资源利用率。

六、结论与未来展望

本项目基于CANN异构计算架构实施了三层协同优化:

- 计算层:引入动态Batch机制并结合算子融合技术,充分释放硬件计算潜力;

- 编译层:通过ATC工具自动优化网络图中算子的拓扑结构,提升执行效率;

- 运行层:采用ACL的零拷贝机制,大幅降低主机与设备间的数据交互开销。

最终实现了单节点(配备4张加速卡)支持128路视频流的实时处理能力,端到端延迟稳定控制在10ms以内,能效比达到行业领先水平。

未来可进一步探索以下方向:

- 跨节点模型蒸馏技术,构建分级推理架构;

- 集成联邦学习框架,实现多区域联合训练;

- 深化与昇思MindSpore的图算融合能力,提升端到端优化深度。

技术启示

自研AI基础设施的核心突破点,并非局限于单项性能指标的超越,而在于通过系统级架构创新,达成“性能-功耗-成本”三者之间的最优平衡。这正是CANN异构计算架构所体现的核心价值。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号