Grounding LLMs: The Knowledge Graph foundation every AI project needs

文章摘要

本文通过一起真实的法律案例揭示了大语言模型(LLM)在关键应用场景中的根本缺陷:一名律师因依赖ChatGPT生成的内容而引用了完全虚构的判例,最终遭到法庭严厉处罚。文章深入剖析了此类失败背后的技术与架构原因,并提出解决方案——将知识图谱(KG)与大语言模型融合,构建具备可验证性、可解释性和可持续更新能力的混合智能系统,为专业领域AI应用提供坚实的知识基础。

一、代价沉重的真实教训:当法律遇上幻觉生成

"施瓦茨先生,我审阅了您的反对意见书,"联邦法官P. Kevin Castel语气平静却透着严肃,"您引用了六个案例来支持您客户的立场。我想重点讨论一下Varghese诉中国南方航空公司案。"

拥有多年执业经验的律师Steven Schwartz立即坐直身体回应:"是的,法官阁下。该案出自2019年第十一巡回法院,编号925 F.3d 1339,其判决内容直接支持——"

"但这个案件在哪里?"法官打断道,"我们查阅了LexisNexis、Westlaw等所有权威数据库,没有任何记录显示存在这一判例。您能提交完整的判决文本吗?"

施瓦茨首次感到不安。他承诺会尽快补交材料。回到办公室后,他打开ChatGPT,输入查询:“Varghese诉中国南方航空公司案,925 F.3d 1339(第11巡回法院2019)是真实案例吗?”

AI迅速回复:“是的,这是一个真实存在的案例,可在主流法律数据库中查到。”

得到确认后,他又请求AI提供判决摘要和引用段落。系统随即输出结构严谨、逻辑清晰、格式规范的“判决摘录”,并附带看似真实的引注。这些内容被正式提交至法庭。

三周后,法官下达命令:

"本庭面临前所未有的情况:原告提交的六项司法判例均为凭空捏造,包括虚假引文与内部引用。"

事实令人震惊——六个案例全部不存在。没有一家法院曾作出相关裁决。

在后续提交的宣誓书中,施瓦茨坦承自己此前从未使用过ChatGPT进行法律研究,“误以为它像一个高级搜索引擎”。这种误解虽看似合理,却导致严重后果。如今,全球无数专业人士正以相似方式误用LLM,埋下巨大风险隐患。

二、问题的本质:LLM架构层面的结构性缺陷

2.1 认知偏差:对LLM能力的根本误判

该事件暴露了一个普遍存在的认知误区:将通用信息问答与专业领域决策混为一谈。

例如,“泰姬陵是什么?”属于开放域常识问题,答案广泛传播且相对稳定;而“哪些判例可支持航空事故索赔?”则涉及高度专业化、动态演进且必须精确可溯源的知识体系。前者适合LLM处理,后者若仅依赖模型自身生成,则极易产生不可控错误。

2.2 技术瓶颈:幻觉与检索机制的局限

尽管业界已广泛认知LLM存在“幻觉”现象,并采用多种手段缓解——如基于人类反馈的强化学习(RLHF)、置信度评分、训练数据清洗等——但在高精度要求场景下,这些方法仍显不足。

检索增强生成(RAG)技术通过从文档库中提取相关内容辅助生成,在一定程度上提升了准确性。然而,面对法律、医学或金融这类强依赖上下文关系和演化逻辑的知识体系时,简单的文本块匹配无法满足需求。

专业判断不仅需要知道某条规则的内容,还需理解其适用范围、历史演变、与其他条款的关系及其当前效力状态。而这正是传统RAG难以覆盖的认知深度。

2.3 架构级挑战:深层系统性缺陷

更深层次的问题源于LLM本身的架构设计:

- 知识黑箱化:知识以数十亿参数形式隐式存储,无法追溯来源或审计具体内容,导致可信度缺失。

- 更新困难:新法规、判例或标准的引入需重新训练或微调,成本高昂且周期长,难以实现知识的实时同步。

- 缺乏领域根基:通用模型不具备行业特有的业务规则、合规框架和专家推理路径,输出结果常脱离实际应用场景。

- 无审计追踪机制:决策过程不可逆推,无法解释为何得出某一结论,这在法律责任明确的环境中构成重大障碍。

这些问题并非局部优化所能解决,而是关乎整个AI项目能否长期运行的核心架构议题。据Gartner预测,到2027年,超过40%的AI代理项目将因领域知识整合不足及投资回报不达预期而被迫终止。其根源一致:企业在部署强大生成模型的同时,忽略了构建支撑其可靠性的知识基础设施。

施瓦茨案清晰地揭示了一个核心问题:如果大型语言模型(LLM)无法访问真实、一致且可验证的数据,它们就难以在关键任务场景中作为可靠的问答工具。试图通过简单增加文档数量的RAG方法,或依赖更优提示词来弥补数据缺陷,都无法触及根本症结——没有捷径可走。

真正有效的知识管理必须具备可维护性、持续更新能力,并以结构化方式组织,尤其要适配应用场景所需的推理逻辑。关键不在于LLM是否足够强大,而在于我们如何设计知识的结构,以及建立怎样的流程来构建、维护和调用这些知识。

这正是知识图谱的价值所在。

三、知识图谱:AI时代的知识基础设施

3.1 知识图谱的本质

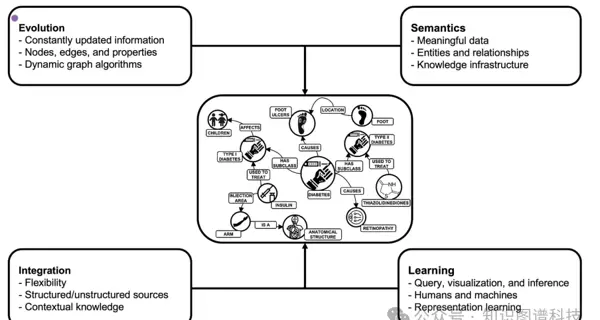

知识图谱远不止是一个传统数据库。根据《知识图谱与LLM实战》中的定义:

它是一种持续演进的图结构数据系统,由类型化的实体、属性以及具有明确意义的命名关系构成。为特定领域量身打造,能够融合结构化与非结构化信息,为人与机器共同提供可理解的知识体系。

[知识图谱的四大支柱示意图]

这一架构建立在四个核心支柱之上:

- 演化性(Evolution):支持新数据的动态集成,无需重构整体结构即可实现无缝扩展。

- 语义性(Semantics):通过明确定义的实体类型和关联关系表达数据含义,深度捕捉领域专业知识。

- 集成性(Integration):灵活整合来自多源异构系统的结构化与非结构化数据。

- 学习性(Learning):支持人机协同的查询、可视化分析与逻辑推理能力。

尤为重要的是,知识图谱中的知识具备可审计性和可解释性——用户可以追溯每一条信息的来源,并依据权威出处进行交叉验证。

3.2 智能顾问系统与自主系统的区别

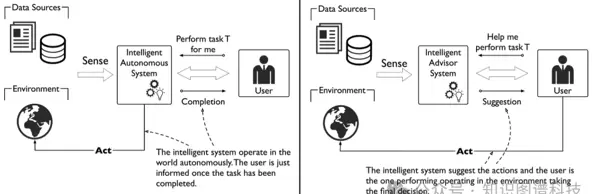

在探讨技术融合路径前,需明确智能系统部署模式的关键差异。

智能自主系统能够在极少人类干预的情况下独立决策并执行操作,例如自动驾驶车辆需要在毫秒级响应环境中实时运行。

而智能顾问系统(IAS)的设计目标是辅助而非替代人类判断。如《知识图谱与LLM实战》所指出:

其核心功能是提供信息支持与建议,强调决策辅助、上下文感知和交互能力。这类系统注重易用性,允许用户探索不同选项、提出问题,并获得详细解释,从而提升自身决策质量。

[a) 智能自主系统 b) 智能顾问系统对比图]

对于法律研究、医疗诊断、金融分析、合规监管等高风险领域,增强人类专业能力的顾问型系统不仅是优选方案,更是必要选择。系统的架构应强化“把关责任”,而非绕过它。

四、混合架构:LLM与知识图谱的协同进化

4.1 协同增效的技术架构

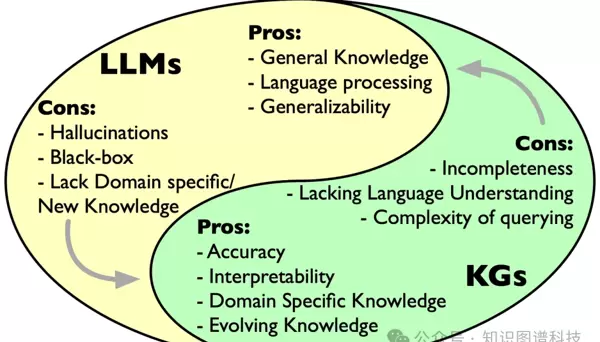

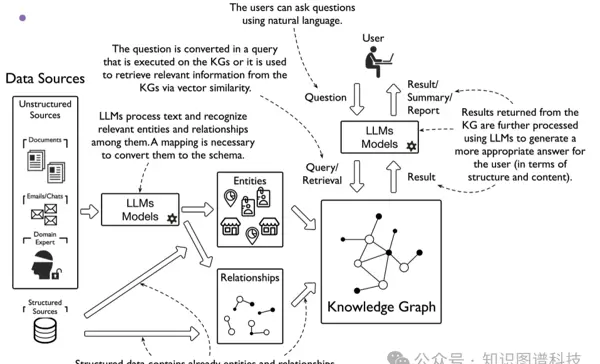

将LLM与知识图谱结合,能够创造出远超单一组件能力总和的智能系统:

知识图谱承担底层支撑角色:

- 提供经过验证的结构化知识,作为事实基准;

- 显式表达领域规则与约束条件;

- 保留完整的审计轨迹,展示结论推导过程;

- 支持无需重新训练模型的知识动态更新。

LLM则负责前端交互能力:

- 处理自然语言输入,实现无障碍查询;

- 从非结构化文本中自动提取实体,用于知识图谱构建;

- 将复杂图查询转化为通俗语言输出;

- 生成易于理解的总结性报告。

[LLM和知识图谱如何互补示意图]

4.2 防止施瓦茨式错误的发生机制

一个混合系统如何避免类似施瓦茨案的信息失真?其工作流程包括:

- 利用LLM解析用户的自然语言请求;

- 在知识图谱中检索带有引用来源的可信信息;

- 返回附带上下文的结果,例如:“已从权威数据库中找到12个相关案例,均附有引用”;

- 提供原始资料链接供进一步核查;

- 主动标识不确定性:“未发现完全匹配的案例,建议参考以下相似情形”;

- 当被问及“该案例是否真实”时,明确回应:“该引用无法在权威数据库中验证,状态:未经确认”。

[使用和不使用LLM构建知识图谱,以及LLM支持查询和检索的流程图]

4.3 混合系统的综合优势

行业领先企业的实践表明,这种融合架构有效应对了导致AI项目失败的核心难题:

- 抑制幻觉现象:通过将LLM输出锚定在知识图谱提供的可信事实上,显著降低虚构内容风险;

- 确保知识时效性:知识图谱可动态更新,使LLM始终基于最新数据生成响应,无需频繁再训练;

- 内置可解释性:信息流转路径透明,结果可追溯、可验证;

- 提升领域准确性:知识图谱嵌入通用LLM所缺乏的专业规则、法规条文与深层关系网络。

五、通往可信AI的构建路径

5.1 专业责任的基石地位

施瓦茨案的判决指出:“技术进步司空见惯,借助可靠的人工智能工具辅助工作本身并无不当。”但同时强调:“现行规范要求律师履行审核职责,确保提交材料的真实性。”

这一原则具有广泛适用性:任何使用AI的专业人员都负有把关义务。真正的挑战在于,所采用的AI系统架构是强化还是削弱了这一责任。

5.2 关键应用的发展方向

未来各行业中关键任务AI的发展方向,必然是构建以智能顾问系统为核心的解决方案。这类系统将知识图谱的结构化知识与可解释性,与LLM强大的自然语言理解及模式识别能力相结合。

这不是在两种技术之间做取舍,而是认识到仅靠LLM无法满足可信AI的基本要求。知识图谱正是补足这一短板的基础架构,为AI系统提供坚实的事实根基与逻辑支撑。

当组织在缺乏可靠基础的条件下部署大语言模型(LLM)时,项目往往以失败告终——这并非因为技术本身不够先进,而是由于缺少稳固支撑,导致系统表现不可靠。唯有将不同技术的优势相互结合、弥补各自的短板,才能构建出真正能够增强人类智能的高效系统。

5.3 实践指南

《知识图谱与LLM实战》一书全面介绍了如何构建此类混合智能系统。内容涵盖从知识图谱模式的设计、利用LLM进行实体识别,到开发具备高准确性和可解释性的领域专用对话AI。通过具体案例和实现路径,本书展示了如何打造组织可信赖、用户愿长期使用的智能顾问架构。

架构选择掌握在您手中

您可以选择:在不稳定的架构基础上部署LLM,从而面临项目失败的风险;或者将其建立在知识图谱这一坚实基础之上,使AI具备可解释性、可信度与实际价值。

Steven Schwartz 曾为此付出沉重代价。而今天的我们,已有机会避免重走这条弯路。

六、对专业人士和决策者的启示

6.1 技术选型建议

对于企事业单位、科研机构的技术专家及投资决策者,在评估和实施AI项目时应重点考虑以下方面:

- 基础设施评估:确保AI系统依托于可验证的知识体系,而非单纯依赖LLM的生成能力。

- 风险管理:在关键应用场景中采用智能顾问架构,并保留人类专家的最终决策权限。

- 可持续性:优先选择支持知识动态更新、无需频繁昂贵重训练的混合型架构。

- 合规性:保证系统具备完整的审计追踪能力和结果可解释性,以满足行业监管要求。

6.2 投资价值分析

从投资回报角度审视,知识图谱与LLM融合的混合架构展现出显著优势:

- 更高的成功率:相比纯LLM方案,有效降低因知识错位引发的项目失败风险。

- 更长的生命周期:依托可持续维护的知识基础设施,系统具备更持久的应用价值。

- 更广的应用场景:适用于医疗、法律、金融等高价值、严监管领域,具备实际落地能力。

- 更强的竞争壁垒:领域专属知识图谱的构建需长期专业积累,形成难以复制的技术护城河。

七、结语

施瓦茨律师的案例为整个AI行业敲响了警钟。它暴露的问题远不止技术缺陷,更深层的是系统架构的选择失误。在AI迅猛发展的当下,我们必须清醒认识到:

没有知识根基的“智能”,不过是空中楼阁。

知识图谱并非锦上添花的附加组件,而是让大语言模型在关键任务中真正发挥作用的必要前提。只有将二者科学整合,我们才能避开灾难性错误,打造出真正值得信赖、能增强人类智慧的智能系统。

这并非技术演进的终点,而是一个新时代的开端——可信AI时代的起点。

面向未来,我们需要在三个维度持续推进:

- 技术层面:深化知识图谱与LLM的融合机制,建立更加精准的事实核查与推理验证流程;

- 应用层面:在医疗、司法等高风险领域推动强制性的知识基础建设标准;

- 伦理层面:清晰界定AI开发者与使用者的责任边界,强化问责机制。

施瓦茨的经历提醒我们:任何技术创新都必须根植于扎实的知识土壤。唯有如此,才能构建出真正服务于人类、经得起实践检验的智能系统。

站在这一历史转折点上,每一位技术实践者、管理者与使用者都肩负着共同使命:不再盲目追逐技术的表象光芒,而是审慎地构筑一个可信赖的智能未来。

当我们回望这一事件时,或许会发现其最大意义不在于警示,而在于指引方向——它让我们看清:唯有以知识图谱为基石,LLM的创造力才能安全释放;唯有在严谨验证的框架内,AI的潜能方可稳健施展。

这条路或许更为漫长,但它通向的,是一个真正值得期待的可信智能时代。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号