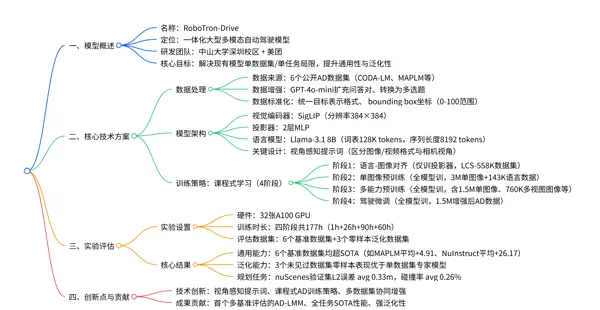

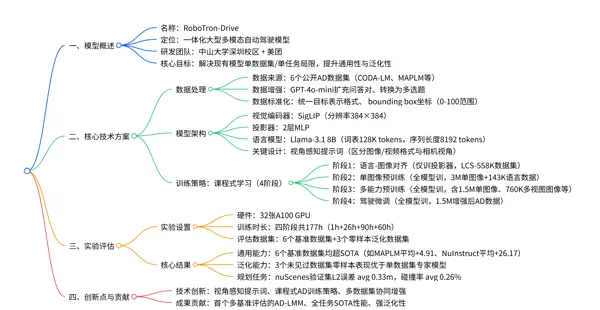

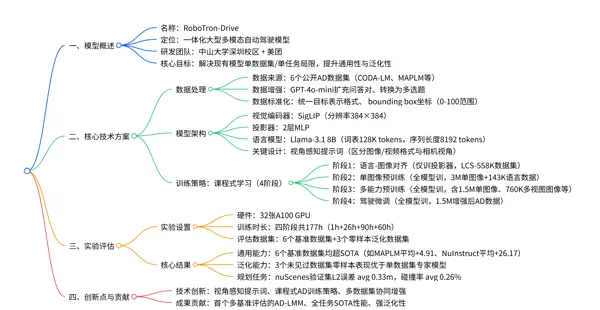

1. 一段话总结

RoboTron-Drive 是由中山大学深圳校区与美团联合研发的一体化大型多模态自动驾驶模型。该模型采用课程式预训练与微调策略,从单图像理解逐步过渡到多视图视频处理,并从图像描述任务进阶至驾驶推理任务,训练难度逐级提升。通过整合 CODA-LM、MAPLM 等6个公开自动驾驶数据集,并进行问答对增强与标准化处理,同时引入视角感知提示词以有效区分不同传感器输入(如相机或 LiDAR 视角),模型在6个基准数据集的13项任务中均达到 SOTA 性能。此外,在 BDD-X、DRAMA 和 DriveBench 三个未参与训练的数据集上展现出优异的零样本泛化能力,能够统一处理图像、多视图视频等多种输入格式,支持感知、预测、规划等全链路自动驾驶任务。

2. 详细总结

一、研究背景与问题

当前自动驾驶领域中的大型多模态模型(LMM)普遍面临两个关键挑战:

- 任务与数据单一性:多数现有模型仅针对特定数据集设计,例如 CODA-LM 专注于单视图图像分析,NuInstruct 则局限于多视图视频;而 MAPLM 主要用于道路感知,LingoQA 倾向于决策规划。这种“专精”模式难以满足真实驾驶场景下多样化与复杂化的任务需求。

- 泛化能力不足:依赖单一数据集训练的模型在面对新环境、新型传感器配置(如不同数量的摄像头或是否配备 LiDAR)时表现不佳,缺乏跨数据集迁移和适应能力,限制了其实际部署潜力。

二、模型核心设计

1. 模型架构

| 组件 | 具体配置 |

|---|---|

| 视觉编码器 | SigLIP,基于 WebLI 预训练,输入分辨率为 384×384,负责将各类视觉输入转化为高维特征表示 |

| 投影器 | 两层 MLP 结构,用于将视觉特征映射至语言模型的词嵌入空间,实现模态对齐 |

| 语言模型 | Llama-3.1 8B,拥有 128K 的大词表,最大支持 8192 tokens 的序列长度,承担最终的任务理解与输出生成 |

关键创新点:设计了视角感知提示词机制,格式为 “1: <image>/<video> ... n: <image>/<video>”,并标注对应视角信息(如 CAM_FRONT 或 LiDAR_TOP),使模型能准确识别和区分来自不同传感器的多视角输入。

2. 数据处理方案

(1)数据来源整合

为构建全面且多样化的训练基础,RoboTron-Drive 融合了三大类数据源:

- 常规多模态数据:包括 LCS-558K、COCO118K、CC3M 等图像-文本对,以及 OneVision 提供的视觉指令微调数据(涵盖单图像、多图像及视频形式);

- 感知导向数据:如 COCO 和 Object365(用于单图像目标检测)、nuScenes(提供带相机视角标注的多视图图像与视频);

- 自动驾驶专项数据:集成6个公开自动驾驶数据集,覆盖多种输入类型与任务范畴,详细信息如下:

| 数据集 | 输入类型 | 核心任务领域 | 样本量(增强后) |

|---|---|---|---|

| CODA-LM | 单视图图像(S.I.) | 极端场景感知 | 184,480 |

| MAPLM | 多视图图像(M.I.) | 道路感知 | 94,970 |

| DriveLM | 多视图图像(M.I.) | 感知 + 推理 | 376,181 |

| LingoQA | 单视图视频(S.V.) | 规划 + 行为推理 | 413,829 |

| OmniDrive | 多视图视频(M.V.) | 3D 感知 + 规划 | 374,329 |

| NuInstruct | 多视图视频(M.V.) | 预测 + 决策 | 71,842 |

(2)数据增强与标准化

- 问答对增强:利用 GPT-4o-mini 对原始模板进行扩展,例如将 CODA-LM 的固定提问方式丰富为多种表达形式,并将部分开放式问题转换为多选题型,显著提升语义多样性与模型鲁棒性;

- 问答对标准化:统一不同数据集中目标物体的表示格式,例如将 DriveLM 的 “<c6, CAM BACK, 1088.3, 497.5>” 与 NuInstruct 的 “<car>[c6, 139, 343, 1511, 900]” 统一转换为标准格式 “<car>[CAM_BACK, x1, y1, x2, y2]”,并将边界框坐标归一化至 0–100 区间(依据原图尺寸计算),确保跨数据集一致性。

3. 训练策略:四阶段课程式学习

采用渐进式训练框架,逐步提升模型能力:

| 训练阶段 | 目标 | 训练数据 | 训练配置 | 时长 |

|---|---|---|---|---|

| 阶段 1:语言 - 图像对齐 | 建立视觉与语言模态间的初步对齐 | LCS-558K | 仅训练投影器,冻结视觉编码器与 LLM,学习率 1e-3,batch size 512 | 1小时 |

| 阶段 2:单图像预训练 | 强化模型对单图像内容的理解能力 | 300万单图像数据(含 BLIP558K、COCO118K 等)+ 14.3万语言数据 | 全模型训练,视觉编码器学习率 2e-6,其余部分 1e-5,batch size 256 | 26小时 |

| 阶段 3:多能力预训练 | 适配多种输入格式并掌握基础感知与推理技能 | 150万单图像 + 76万多视图图像 + 50.1万单视频 + 14.5万多视图视频 | 沿用阶段2配置 | 90小时 |

| 阶段 4:驾驶微调 | 聚焦自动驾驶全流程任务适配 | 约150万条经增强后的6个AD数据集样本 | 同阶段2配置 | 60小时 |

三、实验结果

1. 通用能力评估(6个基准数据集)

RoboTron-Drive 在所有测试数据集的关键指标上均超越了专家模型(即仅在单一数据集上训练的模型)以及零样本基线模型(如 GPT-4o、LLaVA-OV)。其综合性能表现突出,尤其体现在多任务协同处理与复杂语义理解方面。

2. 零样本泛化能力验证

在完全未参与训练的三个外部数据集——BDD-X、DRAMA 和 DriveBench 上,RoboTron-Drive 展现出强大的迁移能力,无需额外微调即可完成高质量推理,证明其具备良好的泛化性,适用于不同传感器配置与未知城市交通环境。

3. 核心贡献与技术创新

- 首个多基准评估的自动驾驶大型多模态模型(AD-LMM):首次系统性地整合多个异构自动驾驶数据集,在统一框架下实现跨任务、跨模态、跨视角的联合建模;

- 全任务 SOTA 性能:在13项细分任务中均取得最优结果,涵盖感知、预测、规划等多个层级;

- 强泛化性:得益于课程式训练与数据标准化策略,模型在未见数据集上仍保持高性能;

- 关键技术突破:

- 视角感知提示词设计,解决多视角输入混淆问题;

- 课程式 AD 训练范式,实现由简到难的能力递进;

- 多数据集协同增强机制,提升数据利用率与模型鲁棒性。

核心贡献

- 提出首个一体化自动驾驶多模态模型 RoboTron-Drive:支持多种输入格式,实现从感知到规划的全流程自动驾驶任务处理;

- 构建首个多基准评估体系:涵盖6个数据集、4种输入类型及13项任务,为自动驾驶大语言模型(AD-LMM)提供标准化评测框架;

- 设计课程式训练策略与视角感知提示机制:结合多数据集协同学习,显著提升模型的通用性与泛化能力。

关键指标对比(在6个已见数据集上的表现)

| 数据集 | 评估指标 | 专家模型平均 | GPT-4o | RoboTron-Drive | 提升幅度(vs 专家模型) |

|---|---|---|---|---|---|

| CODA-LM | 平均得分 | 63.62 | 48.79 | 64.18 | +0.56 |

| MAPLM | 平均得分 | 71.76 | 23.12 | 76.67 | +4.91 |

| NuInstruct | 平均得分(*) | 20.13 | 1.95 | 46.30 | +26.17 |

| LingoQA | Lingo-Judge 得分 | 60.80 | 18.40 | 69.20 | +8.40 |

注:*NuInstruct 平均得分计算方式为 max ((Accuracy+MAP+BLEU-MAE)/4, 0)

泛化能力评估(在3个未见过的数据集上进行零样本测试)

| 数据集 | 评估指标 | 专家模型平均 | RoboTron-Drive | 提升幅度 |

|---|---|---|---|---|

| BDD-X | GPT-Score | 26.48 | 43.10 | +16.62 |

| DRAMA | GPT-Score | 10.52 | 53.32 | +42.80 |

| DriveBench | 平均得分 | 3.39 | 61.06 | +57.67 |

规划任务专项评估(基于 nuScenes 验证集)

| 模型 | L2 误差(avg,单位:m) | 碰撞率(avg,%) |

|---|---|---|

| UniAD | 0.46 | 0.37 |

| VAD-Base | 0.37 | 0.33 |

| RoboTron-Drive | 0.33 | 0.26 |

关键技术突破解析

问题 1:RoboTron-Drive 如何突破“单任务 / 单数据集局限”?

通过以下三项核心技术设计实现:

- 多数据集整合与增强:融合包括 CODA-LM(极端场景理解)、MAPLM(道路环境感知)在内的6个多样化自动驾驶数据集。利用 GPT-4o-mini 自动生成并扩充问答对(如多样化模板生成),并对所有数据统一目标表示和 bounding box 坐标系统一格式,促进跨数据集的知识迁移与协同训练。

- 课程式 AD 训练策略:采用渐进式训练流程,从简单到复杂逐步引入任务难度——初期使用“单图像 + 图像描述”进行基础语义对齐,后期过渡至“多视图视频 + 驾驶推理”任务。第三阶段集中引入大规模多格式数据(含150万张单图像、76万组多视图图像等),使模型具备处理全场景输入的能力。

- 视角感知提示词设计:引入结构化提示格式“序号 + 输入类型 + 视角标注”,例如“1: <image>(前视图)、2: <video>(后右视图)”,帮助模型识别不同传感器来源(相机或 LiDAR)及其空间关系,有效支撑感知、预测与路径规划等多任务联合执行。

问题 2:RoboTron-Drive 的“通用能力”与“泛化能力”如何验证?结果说明了什么?

(1)通用能力验证

- 验证数据集:选取6个公开 AD 基准(CODA-LM、MAPLM、DriveLM、LingoQA、OmniDrive、NuInstruct),覆盖13项典型自动驾驶任务;

- 核心指标:各数据集专用评价标准,如 CODA-LM 使用 GPT-4 打分、MAPLM 综合分类准确率与 BLEU 分数、NuInstruct 则综合 MAE、Accuracy、MAP 和 BLEU;

- 优势体现:在全部数据集中超越现有最优方法(SOTA)。例如,MAPLM 上平均得分为76.67(较专家模型提升+4.91),NuInstruct 达到46.30(相对专家模型+26.17),同时支持单图像与多视图视频等多种输入形式,打破传统“单任务专家模型”的功能边界。

(2)泛化能力验证

- 验证数据集:选择3个训练过程中未接触过的数据集——BDD-X(场景描述生成)、DRAMA(风险点定位)、DriveBench(多任务可靠性测试);

- 核心指标:采用 GPT-Score(用于 BDD-X 和 DRAMA)以及 DriveBench 的多任务平均得分;

- 优势体现:在零样本设置下表现优异,充分展示其对外部新场景的强大适应力。例如,在 DRAMA 中 GPT-Score 达到53.32(相较专家模型仅10.52,提升+42.80);DriveBench 上平均得分高达61.06(远超专家模型的3.39,增幅达+57.67)。

问题 3:RoboTron-Drive 的硬件成本、训练效率与架构选型考量是什么?

(1)硬件成本与训练效率

- 硬件配置:实验共采用32张 A100 GPU 进行训练;

- 总训练时长:累计177小时,分四个阶段完成(阶段1:1小时,阶段2:26小时,阶段3:90小时,阶段4:60小时),属于当前大型多模态模型的常规训练规模;

- 效率优化:通过分阶段课程学习降低早期收敛难度,并结合数据调度策略提高训练稳定性与资源利用率。

(2)架构选择考量

- 视觉编码器采用 SigLIP,因其在细粒度图像理解与零样本迁移方面表现突出,适合复杂驾驶场景建模;

- 语言模型主干选用 Llama-3.1 8B,兼顾推理能力与参数规模,在保持较强语言理解能力的同时控制部署成本;

- 整体架构设计注重模块兼容性与扩展性,便于未来接入更多传感器模态与任务类型。

(2)架构选择考量

语言模型(Llama-3.1 8B) 具备8B参数规模,在“性能与部署成本”之间实现良好平衡;配备128K词表,能够支持对复杂驾驶指令的深入理解;同时支持长达8192 tokens的序列长度,适用于处理长视频帧输入及多轮问答场景,充分满足自动驾驶任务中所需的逻辑推理与规划能力。

视觉编码器(SigLIP)

基于WebLI数据集进行预训练,在图像与文本对齐任务中表现出色;采用384×384的分辨率设计,既保证了对视觉细节的有效捕捉,又兼顾了计算效率,符合自动驾驶环境下对实时视觉感知的需求。

投影器(2层MLP) 采用结构简洁高效的两层MLP架构,可快速将视觉编码器提取的特征映射至Llama-3.1的语言嵌入空间;避免因使用复杂结构带来的训练延迟问题,确保多阶段训练过程的稳定性与流畅性。

训练策略说明 在第一阶段中,仅对投影器进行训练,其余模块保持冻结状态,以稳定学习过程;第三阶段引入对视频特征的2×2空间池化操作,压缩特征维度,降低计算负载,在控制训练成本的同时维持模型的整体性能表现。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号