在大语言模型(LLM)的训练过程中,人们通常将注意力集中在模型结构、数据质量以及训练规模上。然而,有一个常被忽视但至关重要的组件——优化器,实际上扮演着“幕后英雄”的角色。长期以来,AdamW 被广泛视为训练 Transformer 架构的行业标准。但这项来自哈佛与斯坦福大学的最新研究提出:它是否真的无可替代?

论文链接:http://arxiv.org/abs/2511.14721v1

AdamW 的隐忧:训练后期的“过度衰减”问题

尽管 AdamW 表现稳健,研究者发现其在训练后期存在一个关键缺陷——过度衰减(over-decay)。该现象源于其采用的 权重衰减(Weight Decay)机制,即通过引入 L 正则化项对参数施加惩罚,防止模型过拟合。

这种机制在训练初期效果显著,有助于稳定学习过程。然而,当训练进入中后期,部分关键权重已增长至较大值时,L 惩罚会对其施加过强的反向拉力,导致这些重要参数被不必要地压缩,从而抑制了模型潜力的充分释放。

AdamHD 的突破:引入 Huber 正则化的智能衰减策略

为解决这一问题,研究团队提出了 AdamHD,一种可直接替代 AdamW 的新型优化器。其核心创新在于用 Huber 正则化 取代传统的 L 权重衰减,实现更灵活、自适应的参数控制。

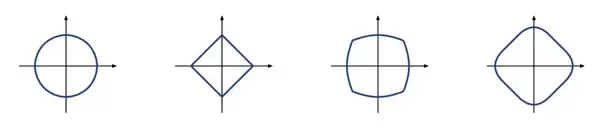

Huber 函数并非新概念,但将其应用于优化器的正则化步骤尚属首次。其设计思想是根据参数大小动态调整衰减方式:

- 当参数绝对值小于阈值 δ 时,采用类似 L 的二次惩罚,保持平滑与稳定性;

- 当参数绝对值超过 δ 时,切换为类似 L 的线性惩罚,施加有界的恒定拉力。

如图所示,红色曲线代表 Huber 正则化,兼具蓝色 L 曲线在原点附近的平滑性与绿色 L 曲线在远端的线性增长特性。

三大优势:有界梯度、尺度不变性与稀疏性促进

这种混合衰减机制带来了多重益处:

- 有界梯度:避免大参数遭受过强惩罚,保护关键权重;

- 尺度不变性:对参数整体缩放不敏感,提升训练鲁棒性;

- 促进稀疏性:线性惩罚倾向于将非关键参数推向零,增强模型稀疏程度。

即插即用设计:零成本替换 AdamW

AdamHD 采用 解耦的 Huber 衰减(Decoupled Huber Decay)架构,延续了 AdamW 将正则化与梯度更新分离的设计理念。研究者推导出其闭式解,使得新增计算开销仅为 O(1),几乎可忽略。

这意味着用户无需修改训练流程,只需在代码中将 AdamW 替换为 AdamHD,即可享受性能提升,如同更换灯泡般简单。

其参数更新公式如下:

θt+1 = θt αt · (mt / (√vt + ε)) αt · λ · clip(θt, δt, +δt)

其中,clip 操作正是 Huber 衰减的核心体现——为参数衰减强度设置上下限 δ,防止过度压缩。

实验验证:全面优于 AdamW

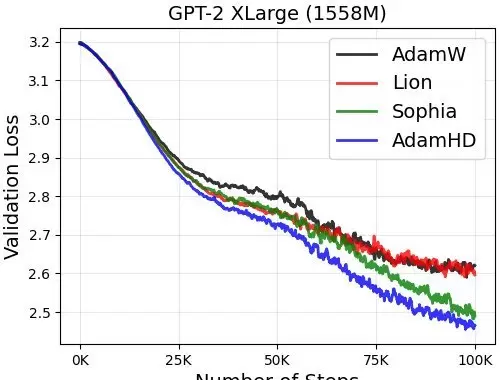

研究团队在 GPT-2 和 GPT-3 等不同规模模型上进行了从零开始的预训练对比实验,结果表明 AdamHD 在多个维度均显著超越 AdamW:

- 收敛速度提升 10–15%:达到相同验证困惑度所需的时间更短,节省计算资源;

- 验证困惑度降低最多达 4 个点:表明模型对文本的预测能力更强;

- 下游任务性能平均提升 2.5%–4.7%:在常识推理、数学解题、知识问答等任务中表现更优;

- 模型更稀疏,显存占用更低:得益于 L 类似效应,可通过幅度剪枝进一步压缩模型。

图2显示,在 GPT-2 1.5B 模型上,AdamHD(蓝色)的验证损失下降速度明显快于 AdamW(橙色),展现出更强的学习效率。

通过一项简洁而巧妙的改进,AdamHD将传统AdamW优化器中的L2权重衰减替换为解耦形式的Huber衰减,有效缓解了大模型在训练后期出现的“过度衰减”现象。

这一改动带来了多重优势:不仅加快了训练收敛速度,还提升了最终模型的性能表现。同时,在几乎不增加计算开销的前提下,显著降低了显存占用。

尤其值得注意的是,该方法能够在不影响整体训练效果的基础上,实现20-30%的存储空间压缩,对模型的部署与推理效率优化具有重要意义。

总体而言,AdamHD以其强理论依据、简易实现方式和突出的实际效果,为优化器设计提供了一个全新的可行方向。对于致力于训练下一代大规模基础模型的研究团队来说,这是一个极具应用价值且值得快速集成尝试的工具。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号