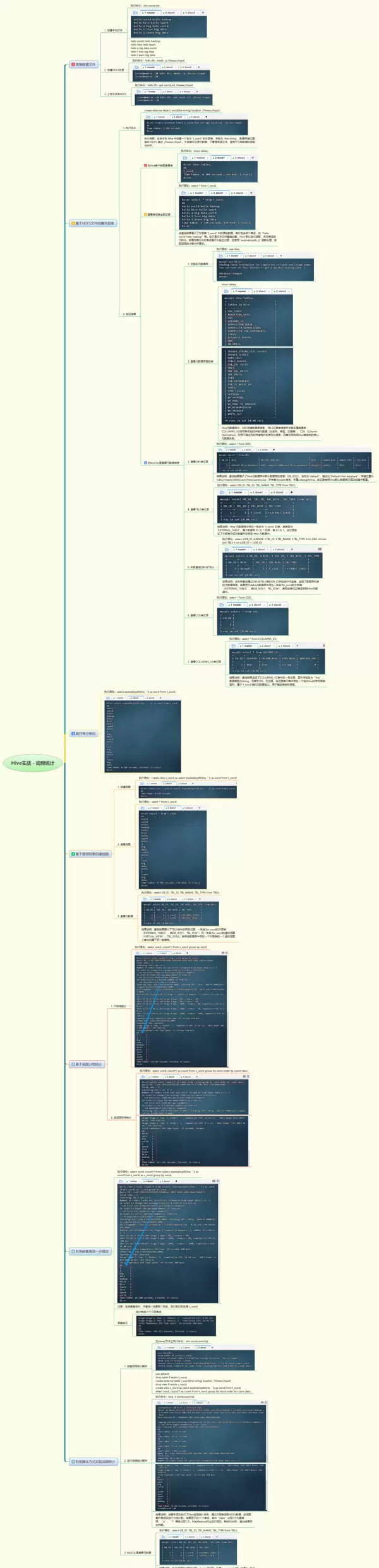

1. 实战概述

本实战项目聚焦于使用Hive实现词频统计,通过构建外部表来读取存储在HDFS上的文本数据。利用内置函数对文本进行单词拆分,并创建视图以封装处理逻辑,进而完成分组计数与结果排序。整个流程涵盖了数据加载、单词展开、视图定义及词频统计等关键环节。

explode(split(...))2. 实战步骤

3. 实战总结

本次Hive词频统计实践成功实现了从原始文本数据到最终词频结果的完整链路。首先通过创建外部表

t_word将HDFS中的文本文件接入Hive环境,随后借助

split和

explode函数,将每一行句子拆解为独立的单词项,形成扁平化的词汇结构。基于此转换逻辑,建立了可复用的视图

v_word从而简化后续分析语句的编写。在此基础上,运用

GROUP BY与

ORDER BY操作完成了词频的聚合统计与降序排列,并验证了嵌套查询以及脚本化批量执行(

.hql)的有效性。

通过对元数据信息的检查发现,由于脚本中采用了“先删除后创建”的表管理方式,导致系统中的TBL_ID持续递增,这反映了Hive元数据管理的动态特性。整体流程充分体现了Hive在处理大规模文本数据时的优势,包括高效的数据批处理能力、逻辑抽象机制(如视图)、自动化脚本支持以及元数据的一致性维护,为日志分析、文本挖掘等典型大数据应用场景提供了可复用的技术范式。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号