【摘要】

语言的流畅性并不能等同于通用智能。本文从认知科学原理、模型底层机制以及技术发展路径三个角度,深入剖析大语言模型在实现通用人工智能(AGI)方面的根本性局限,并探讨未来可能突破的方向。

引言

当前,以大语言模型(Large Language Models, LLMs)为核心的人工智能技术正以前所未有的速度重塑全球科技格局。这些系统展现出的语言生成能力令人惊叹,以至于许多人认为我们已站在通往通用人工智能(AGI)的门槛上。科技巨头为此投入巨额资金,建设超大规模计算中心,推动整个行业围绕一个核心信念运转:

只要将语言能力推向极致,就能涌现出类人甚至超人的通用智能。

然而,作为一名长期身处技术研发一线的实践者,我越来越意识到这种普遍乐观背后潜藏着一种深层的认知偏差——我们将“能说会道”误认为“真正理解”。这种误解不仅影响公众判断,更可能导致整个AI领域走上一条资源密集却难以抵达目标的技术死胡同。

需要明确的是,本文并非否定LLM的价值。它无疑是极具变革性的工具。但我们需要拨开喧嚣的炒作迷雾,回归科学与工程的本质,提出一个关键问题:

一个仅基于词语概率计算的系统,真的能够理解现实世界吗?

接下来,本文将结合神经科学发现、LLM的技术本质以及权威专家观点,系统论证为何“会说话”的AI与真正的通用智能之间,存在本质鸿沟。

一、语言与思维的分离:来自认知科学的坚实证据

要理解这一问题,必须首先正视一个常被忽视的基本事实:在人类大脑中,语言能力与思维能力虽密切相关,却是相对独立的两个系统。将二者混为一谈,是构建AGI过程中一项根本性的逻辑错误。

1.1 语言流畅带来的直觉误导

作为社会性生物,人类在进化过程中高度依赖语言进行协作和知识传递。因此,我们习惯性地将语言表达水平与智力直接挂钩——口齿伶俐者往往被视为聪明。

大语言模型恰好利用了这一心理倾向。通过训练海量文本数据,它们掌握了语言的统计规律,能够输出语法正确、逻辑通顺、甚至富有文采的内容。这种表现极易让人产生“它懂了”的错觉。但实际上,这更像是一种高级拟态行为:模型只是在其庞大的参数空间中,挑选出最符合人类语言习惯的响应序列,而非真正理解其含义。

1.2 大脑功能分区的神经科学证据

现代脑科学研究为我们提供了直接的生理学依据。借助功能性磁共振成像(fMRI)等技术,科学家可以观察人在执行不同任务时的大脑活动模式。结果显示,大脑具有高度模块化的结构。

当个体进行语言处理(如阅读或对话)时,布洛卡区(Broca's area)和韦尼克区(Wernicke's area)等特定区域会被显著激活;而在完成非语言任务时,主导的脑区则完全不同。

| 认知任务类型 | 主要激活的大脑区域 | 与语言中枢的关联 |

|---|---|---|

| 语言处理 | 布洛卡区、韦尼克区、角回 | 核心区域 |

| 数学推理 | 顶内沟、额叶皮层 | 独立于核心语言区 |

| 空间导航 | 海马体、顶叶皮层 | 独立于核心语言区 |

| 音乐感知 | 听觉皮层、小脑 | 独立于核心语言区 |

| 情绪理解 | 杏仁核、前额叶皮层 | 独立于核心语言区 |

上述数据清晰揭示了一个事实:不同的认知功能在大脑中有明确的物理分隔。用于解决数学问题的神经网络,与负责语言组织的回路并不相同。这一生物学基础,从根本上挑战了“仅靠扩展语言模型即可覆盖全部智能”的设想。如果人类自身的智能在硬件层面就是分工运作的,那么指望单一的语言架构模拟所有心智功能,显然缺乏合理性。

1.3 失语症患者的“自然实验”

比实验室研究更具说服力的,是临床医学中的真实案例。失语症患者因脑部损伤(通常位于语言中枢),失去了说话或理解语言的能力。

按照“语言即思维”的假设,这类患者的思维应严重受损。但大量医学观察表明,许多患者即使完全丧失语言功能,仍能保持完整的非语言认知能力:

- 逻辑与数学能力:可解答复杂算题,参与象棋、围棋等策略游戏;

- 因果推理能力:能根据环境变化推断结果,例如见乌云知将下雨;

- 情绪识别能力:可通过表情、语气和动作准确感知他人情绪状态;

- 执行复杂操作:能按非语言指令完成多步骤任务,如组装机械模型。

这些病例构成了一组强有力的“自然实验”,证明了人类的核心思维过程可以在无语言支持下独立运行。语言更像是表达思想的工具,而思维本身才是认知的地基。当前LLM的发展路径,似乎颠倒了这一关系——试图通过优化表达工具来反向生成思维内容,这在逻辑上难以成立。

二、解构大语言模型:概率系统的本质与边界

从技术角度看,大语言模型的本质是一个高度复杂的概率预测系统。它的核心机制并非“理解”,而是“预测下一个词”。无论模型规模如何扩大,其基本工作原理始终未变。

LLM通过对海量文本的学习,建立词语之间的共现关系模型,在给定上下文的前提下,计算最可能出现的后续词汇。这一过程虽然能生成看似连贯的回答,但并不涉及对语义的真实把握,也无法形成对外部世界的内在表征。

更重要的是,由于训练数据完全来源于已有文本,模型的知识局限于人类已经表述过的信息。它无法主动感知世界、进行物理交互或获得第一手经验。这意味着,即便模型再庞大,也始终被困在“二手描述”的信息茧房之中。

此外,LLM缺乏持续学习和动态更新的能力。一旦训练完成,其知识体系即告固化,除非重新训练,否则无法吸收新信息。这与人类不断适应环境、实时调整认知的方式截然不同。

综上所述,大语言模型尽管在语言层面表现出色,但其底层机制决定了它无法跨越从“模式匹配”到“真实理解”的鸿沟。真正的通用智能需要具备自主感知、因果建模、跨模态整合与持续学习的能力,而这些正是当前LLM架构所不具备的根本属性。

要理解大语言模型(LLM)的能力边界,我们需要回归其技术本质。抛开各种夸张的宣传,LLM实际上是一个基于Transformer架构的、规模庞大的自回归概率模型。它的核心功能非常简单:预测下一个词(Token)。这一机制贯穿了它所有的行为与输出。

2.1 预测“下一个词”的机制

设想一个场景:你正在输入“今天天气真不错,我们去公园...”。此时,LLM的任务是从其训练所见的海量文本中,推断接下来最可能出现的词汇。“散步”、“野餐”或“玩耍”这类词语的概率会显著上升,而像“开会”、“写代码”这样的词则几乎不会被考虑。

这个过程依赖于一种叫做“注意力机制”(Attention Mechanism)的技术。该机制分析当前文本序列中各个词语之间的关联强度,并结合模型在训练过程中学到的语言模式,生成一个概率分布。随后,系统通过某种采样策略(例如选择最高概率的词),确定下一个输出的词。此步骤不断重复,逐步构建出完整的句子乃至段落。

这种工作方式决定了LLM的几个根本特征:

- 它是关联性的,而非因果性的:模型仅能识别哪些词语经常共现,但并不理解它们之间是否存在真正的因果联系。例如,它知道“乌云”之后常出现“下雨”,但这并非因为它掌握了气象学原理,而是因为这两个词在训练数据中频繁搭配出现。

- 它是插值性的,而非外推性的:所有输出内容本质上都是对已有知识的重组和内插。尽管它可以生成看似新颖的表达,但无法真正超越训练数据范围,创造出全新的概念体系。

- 它是形式化的,而非语义化的:模型处理的是符号(Token)层面的信息,而不是这些符号背后的真实世界含义。它不“认知”苹果是一种水果,只知道“苹果”一词通常出现在哪些上下文中。

可以将LLM比作一只读遍人类全部书籍的“概率鹦鹉”。它能够极其逼真地模仿人类的语言风格和结构,但在其内部,并未建立起关于现实世界的连贯、可操作的认知模型。

2.2 悬浮于文本之上的智能:缺乏世界模型

这引出了LLM最根本的局限——缺乏“世界模型”(World Model),这也是图灵奖得主Yann LeCun反复强调的问题。

真正的智能体,无论是人类还是未来可能实现的通用人工智能(AGI),都需要在系统内部建立一个关于世界如何运行的动态表征。这种模型包含对物理规律、空间关系、时间顺序、因果逻辑以及他人意图的理解能力。

以人类婴儿的学习过程为例:他们并非通过阅读来掌握知识,而是通过主动与环境互动完成学习。他们会抓握物体感受重量,推倒积木理解因果,观察父母表情揣摩情绪。这一系列体验帮助他们在大脑中构建起一个多模态、具身化且与现实“接地”(Grounding)的世界模型。

相比之下,LLM的学习路径完全不同。它只是被动地“阅读”了关于世界的大量文本描述,却从未亲身经历过任何真实事件。这种学习方式导致其存在一系列结构性缺陷。

2.2.1 因果推理能力的缺失

LLM擅长发现数据中的统计相关性,但在判断因果关系时极易出错。经典的例子是“公鸡打鸣”与“太阳升起”。由于这两个事件在文本中高度共现,模型很容易学会“公鸡打鸣后太阳升起”的句式。然而,它无法理解地球自转才是日出的根本原因,而公鸡的行为是由生物节律驱动的。因此,它可能会荒谬地推论:只要阻止公鸡打鸣,就能延缓日出。这种因果混淆使其在科学、工程或医疗等需要严谨推理的领域面临极高风险。

2.2.2 物理常识的匮乏

对于人类而言,“玻璃杯掉在地上会碎”是无需解释的常识。但LLM之所以能回答这个问题,仅仅是因为它在训练数据中见过太多“玻璃杯 + 掉落 + 碎裂”的组合模式。它并不真正理解重力、材料硬度或脆性等物理属性。

如果提出一个虚构情境,比如“一个由超强合金制成的玻璃杯从高处落在棉花上”,由于缺乏类似案例的支持,模型很可能给出不符合物理规律的回答。它的“推理”完全受限于已有的文本模式,不具备基于第一性原理进行推演的能力。

2.2.3 规划与反思能力薄弱

人类具备心智模拟(Mental Simulation)的能力,可以在行动前预演多种方案的结果,从而优化决策。这一过程依赖于对行为后果的前瞻性建模。

而LLM由于缺少内在的世界模型,其规划能力极为脆弱。它只能依据语言模式生成一条看似合理的步骤链,但一旦环境发生意外变化,便难以像人类那样灵活调整策略。因为它并不理解每个步骤在现实中意味着什么,也无法评估其潜在影响。

2.3 “规模扩展定律”的局限性

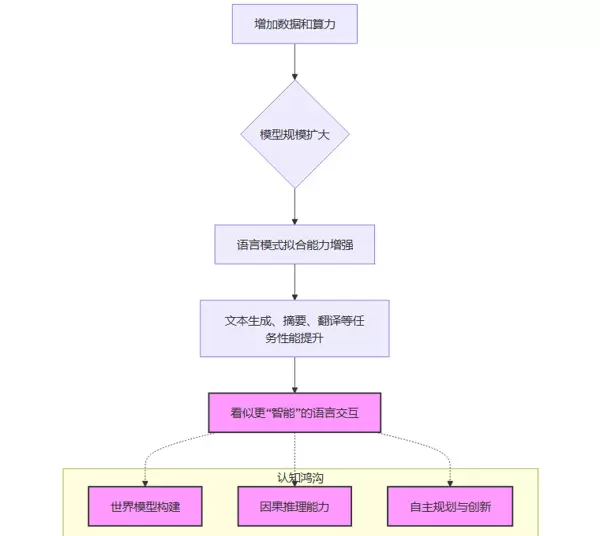

在AI领域曾流行一种信念,即“规模扩展定律”(Scaling Laws):只要持续增加模型参数量、训练数据规模和计算资源,性能就会线性甚至指数级提升,最终涌现出类人智能。

不可否认,在一定范围内,这一规律确实成立。更大的模型通常在语言理解、上下文保持和文本生成方面表现更优。但我们必须清醒认识到:这种进步更多体现在“模仿能力”的深化,而非“理解能力”的跃迁。

换言之,模型可能越来越像人说话,但它并没有变得更像人思考。其智能仍停留在表层模式匹配阶段,未能触及深层认知结构的重构。

当前的技术扩展路径(Scaling)主要聚焦于提升语言层面的能力(C, D, E),这一点在图中表现得十分清晰。然而,从流畅的语言交互(E)迈向真正的认知功能(F, G, H)之间,却存在一条虚线——它象征着一道难以仅靠扩大模型规模跨越的鸿沟。

即便投入再多的GPU资源,也只是让这台“概率鹦鹉”把模仿人类语言的行为做得更逼真一些,却无法赋予它真正的思考能力。随着边际效益逐渐递减,能耗和成本却持续攀升,这种发展模式的可持续性正面临严峻挑战。

2.4 创造力的瓶颈:困于概率分布的系统

通用智能的关键标志之一是创造力——即生成新颖、独特且有价值想法的能力。然而,近期发表于《创意行为杂志》的一项研究从数学角度揭示了大型语言模型(LLM)在创造力上的根本局限。

概率机制的本质矛盾

LLM的核心训练目标是最大化输出文本的概率,也就是使其尽可能符合已有的语言模式。而真正意义上的创造行为——无论是科学突破还是艺术杰作——本质上属于“低概率事件”。它们打破常规,建立前所未有的关联。一个被设计用来顺应统计规律的系统,天然地与创造性思维相冲突。

在平庸与混乱之间寻找平衡

尽管可以通过调节采样参数(如Temperature)来增加输出的随机性,从而获得更具“新意”的内容,但这往往以牺牲意义为代价。结果通常陷入两极:要么是陈词滥调,要么是语义断裂的胡言乱语。研究表明,LLM最终会达到一个临界点,在此之后无法再稳定地产出既新颖又有意义的内容。

合格的模仿者,而非杰出的创作者

该研究指出,LLM最多只能成为一个“称职的写手”:它可以撰写格式规范的邮件或标准结构的营销文案。但若期待它像顶尖作家、艺术家或科学家那样产出开创性作品,则注定落空。其创作成果将始终停留在“平庸”范畴。如果各行各业过度依赖此类工具,最终可能导致内容同质化严重、缺乏灵魂与个性。

实际上,LLM所展现的“创造力”,更准确地说是一种组合式创新——擅长将已有元素重新排列组合。但它缺乏探索式创新的能力,即跳出既有框架去发现全新的概念、规则或可能性。

三、路线之争:AGI的迷航与未来方向

当一种技术路径的根本缺陷日益显现时,继续沿此前行就必须审视背后的驱动力,并探索更具潜力的替代方案。如今,LLM通往通用人工智能(AGI)的道路,正站在这样一个关键的十字路口。

3.1 科学界的清醒声音:LeCun的长期警示

在行业普遍狂热追捧LLM的背景下,一些顶尖科学家保持冷静,其中Yann LeCun的观点尤为突出。作为深度学习领域的奠基人之一,他的批评并非出于悲观,而是源于对智能本质的深刻洞察。

LeCun多次强调,采用自回归方式预测下一个词的LLM在架构上存在根本缺陷。他认为这类模型:

- 缺乏真实理解力:仅学习文本中的统计相关性,实质上是“高维鹦鹉学舌”。

- 不具备规划与推理能力:由于无法在内部模拟世界状态,难以执行多步骤的复杂推理任务,面对需要逻辑推导的问题时常生成看似合理实则荒谬的回答。

- 脱离物理世界交互:智能很大程度来源于环境互动与反馈,而纯文本模型被困于数字符号空间,无法获得“具身智能”(Embodied Intelligence)。

LeCun的看法并非孤立。许多认知科学家和AI研究者也认为,当前业界对LLM的过度推崇,体现了一种典型的“路灯效应”:人们不是在真正困难的地方(例如构建内在世界模型)寻求突破,而是在最容易发光的地方(语言建模)反复打转,因为这里技术成熟、演示效果炫目。

3.2 走出文本牢笼:构建“世界模型”

如果LLM并非通向AGI的正确路径,那什么才是?LeCun等人提出的核心替代方案是:发展基于“世界模型”的智能体。

这一概念虽抽象,但核心思想直观:一个具备世界模型的AI会在内部构建一个可操作、可预测的现实模拟器。它通过多模态感知(视觉、听觉、触觉等)获取环境信息,并利用该模型预判不同行为可能引发的结果。

| 特征维度 | 大语言模型 (LLM) | 世界模型 (World Model) |

|---|---|---|

| 学习来源 | 被动“阅读”海量静态文本 | 主动与动态环境进行交互 |

| 数据模态 | 单一模态(文本) | 多模态(视觉、声音、物理反馈等) |

| 核心能力 | 拟合语言的统计模式 | 预测行为的因果后果 |

| 知识“接地” | 知识悬浮于符号层面 | 知识“接地”于物理现实 |

| 学习目标 | 最小化下一个词的预测误差 | 最小化对世界未来状态的预测误差 |

举例来说,一个搭载世界模型的机器人在学习堆叠积木时,并非通过阅读相关描述来掌握技巧,而是亲自尝试,感受积木的重量、摩擦力与结构稳定性。当它因将大块积木置于小块之上而导致倒塌时,其内部模型便会更新关于重力与平衡的知识。这种基于“试错”与“预测”的学习机制,才是通向真正稳健智能的可行路径。它使AI能够形成常识、制定计划,并灵活应对从未见过的新情境。

3.3 万亿级豪赌的风险:AGI宣传与资源错配

当前围绕LLM展开的大规模投资,本质上是一场以实现AGI为目标的万亿级豪赌。然而,若主流路径本身存在结构性缺陷,则巨额资源可能被导向错误的方向。过度夸大LLM的潜力,不仅误导公众认知,也可能导致科研经费、人才流向高度集中于短期可见成效的领域,而忽视了更具基础性和长远价值的研究方向。

真正的智能进化,或许不在于把鹦鹉训练得更能说人话,而在于教会机器如何像孩子一样,在与世界的不断互动中理解因果、构建模型、学会思考。

在认识到大语言模型(LLM)的局限性以及世界模型所蕴含的巨大潜力之后,一个自然的问题浮现出来:为何整个行业依然将绝大多数资源集中于不断扩展LLM的规模?

这一现象的背后原因错综复杂,既包含商业驱动力,也涉及技术路径依赖。

商业上的成功驱动资本涌入

LLM已经在多个商业场景中展现出显著的应用价值,从内容生成到客户服务,再到代码辅助,创造了真实可感的市场需求。这种可见的回报使得投资者愿意投入巨额资金,进一步推动模型规模的扩张。

工程实现路径清晰

扩大LLM的参数量和训练数据,在工程技术上是一条已被验证且相对明确的道路。尽管计算成本极高,但其方法论成熟、流程标准化,具备较强的可复制性。相比之下,构建具备物理理解能力的世界模型仍处于早期探索阶段,研究不确定性大,短期内难以形成闭环产出。

“通向AGI”的宏大叙事具有吸引力

宣称正在“迈向通用人工智能”为科技公司提供了正当理由,用以支撑庞大的资本开支与能源消耗。这套叙事不仅有助于吸引投资,还能增强人才吸引力,并维持企业在市场中的领先地位。

然而,将实现AGI的全部希望寄托于LLM的规模扩展,实际上隐藏着深远的风险。

资源错配问题日益凸显

数百亿美元被用于采购GPU、建设超大规模数据中心,以训练体量愈发庞大的语言模型。与此同时,那些可能带来根本性突破的研究方向——如世界模型、神经符号系统、具身智能等——却因缺乏短期回报而获得的支持有限。

不可忽视的环境代价

训练和部署这些巨型模型需要消耗巨量电力,导致碳排放持续攀升。如果当前的技术路线本身存在理论天花板,那么如此高昂的生态成本便显得尤为不值。

抑制创新的可能性

当全行业的顶尖人才都聚焦于如何优化一个存在固有缺陷的范式时,探索全新智能架构的动力和空间就会被压缩,最终可能导致长期的技术停滞。

我们正动用最宝贵的资源——资本、人才与能源——去

放大一个已有范式的能力,而非探索新的范式。

倘若这个范式本身就是通往真正智能的一条死胡同,那么投入越多,反而可能离目标越远。

3.4 未来架构猜想:从“纯文本大脑”走向综合认知系统

实现更强人工智能的路径,或许并不在于无限放大单一模型,而在于构建一个模块化、多能力集成的认知系统。在这样的体系中,LLM仍将发挥重要作用,但不再是核心智能的唯一来源。

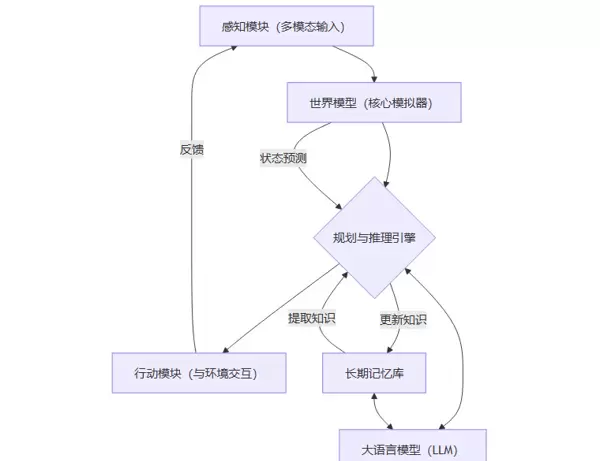

一种更具前景的未来AGI架构设想如下图所示:

该架构的核心构成包括:

- 世界模型(B)作为核心:负责对环境进行建模与模拟,是系统进行因果推理、预测和规划的基础。

- LLM(F)作为接口层:扮演语言子系统的角色,将人类的自然语言指令转化为系统内部可处理的表示形式,并将推理结果重新表达为自然语言输出。它是一个高效的“人机交互通道”,而非智能本体。

- 闭环的学习机制:智能体通过感知模块(A)获取外部信息,经由世界模型(B)和推理引擎(C)做出决策,再通过行动模块(D)影响环境,同时更新记忆(E),形成持续演化的反馈循环。

这种结构有效结合了LLM的语言表达优势与世界模型的现实理解能力,各司其职。它不再要求一个仅靠文本训练的“纯文本大脑”去凭空推断物理规律,而是让智能体在与真实世界的互动中学习成长,同时利用LLM作为与人类沟通的桥梁。

这或许是通往通用人工智能更为现实、科学的方向。

结论

大语言模型无疑是人工智能发展史上的重要里程碑。它前所未有地缓解了机器与人类之间的语言鸿沟,并将在教育、办公、创作等多个领域持续释放生产力价值。我们必须承认并充分利用其工具属性。

但需清醒的是,工具不等于智能本身。将LLM的强大语言能力等同于通用智能,甚至认为只要不断增大规模就能通向AGI,是一种基于表象直觉、缺乏科学依据的误判。

来自认知科学的理论、模型内在机制的分析,以及多位前沿专家的观点一致指出:

一个无法理解世界运行规律、缺乏因果推理能力的概率性文本生成器,无论其语言多么流畅,都无法真正跨越从“模仿”到“思考”的本质鸿沟。

AI的未来发展,必须摆脱对“规模至上”的单一迷信,转向对智能本质更广泛、更深入的探索。我们需要将更多资源投入到能够感知、交互并理解物理环境的“世界模型”研究中,推动语言、视觉、动作一体化的认知架构创新。

承认LLM的能力边界,并非否定AI的进步,而是为了让整个领域回归坚实的科学轨道。唯有当我们不再满足于打造一个越来越擅长复述的“镜子”,转而致力于构建一扇能真实洞察世界的“窗户”时,通往通用人工智能的道路,才有可能真正被照亮。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号