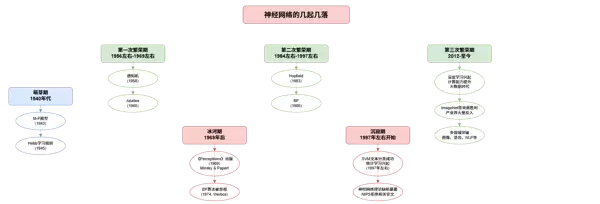

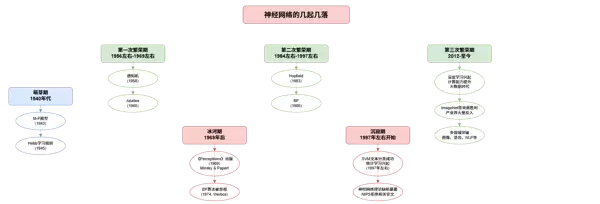

神经网络的发展历程并非一条平坦之路,而是经历了数次高潮与低谷的交替。从早期的理论探索,到遭遇质疑停滞不前,再到如今的全面复兴,这一领域走过了一段曲折而辉煌的道路。

1. 萌芽与初兴(20世纪40年代至60年代末)

在20世纪40年代,神经网络的研究开始萌芽。1943年,McCulloch与Pitts提出了M-P神经元模型,首次以数学方式模拟了生物神经元的工作机制,为后续研究提供了理论基石。

随后,在1945年,Donald Hebb提出了Hebb学习规则,阐述了神经元之间连接强度如何通过经验进行动态调整,这成为神经网络学习机制的重要基础之一。

进入50年代后期,神经网络迎来了第一次发展高峰。1958年,Frank Rosenblatt提出感知机(Perceptron),这是首个具备学习能力的神经网络模型,引发了学术界的广泛关注。

紧接着,1960年,Bernard Widrow和Marcian Hoff开发了Adaline(自适应线性神经元),进一步推动了该领域的技术演进。

这一阶段的主要特征包括:多个关键模型相继问世、研究热度迅速上升、学界对神经网络的未来普遍持乐观态度,整体进入初步繁荣期。

2. 冰河时期(1969年后)

然而,好景不长。1969年,Marvin Minsky(图灵奖得主)与Seymour Papert出版了《Perceptrons》一书,对当时主流的单层神经网络进行了深入分析,并明确指出其无法解决非线性可分问题,同时认为多层网络的训练在实践中难以实现。

这本书的发布带来了深远影响:神经网络研究陷入长期低迷,科研经费被大幅削减,许多研究人员转向其他方向,整个领域几乎停滞。

更令人遗憾的是,1974年Paul Werbos提出的BP算法(反向传播算法),本可用于有效训练多层网络,却因当时学术环境冷淡而未受重视,被埋没多年。

冰河期的整体特点表现为:资金支持锐减、人才流失严重、关键技术进展缓慢,重要成果如BP算法未能及时推广。

3. 复苏与再兴(约1984年至1997年)

转折点出现在1983年,John Hopfield将神经网络应用于旅行商问题(TSP)的求解,展示了其在复杂优化任务中的潜力,重新激发了学界兴趣。

Hopfield的工作被视为神经网络复苏的标志,开启了第二次繁荣期。

此后,由David Rumelhart与James McClelland领导的PDP小组(并行分布式处理小组)发表了里程碑式著作《并行分布式处理:认知微结构的探索》,系统地构建了神经网络的认知科学框架。

尤为关键的是,1986年,Rumelhart等人重新发现并广泛应用了BP算法,成功实现了多层神经网络的有效训练,极大提升了模型的学习能力。

此阶段的特点包括:BP算法广泛应用、多层网络训练成为现实、理论与应用研究大量涌现、神经网络逐步拓展至语音识别、模式分类等多个实际场景。

4. 沉寂与挑战(始于1997年前后)

到了90年代末,随着统计学习理论的兴起,尤其是支持向量机(SVM)在文本分类等任务中取得显著成功,机器学习的研究重心逐渐转移。

SVM凭借坚实的数学基础、良好的泛化能力和在小样本条件下的优异表现,迅速占据主导地位。

相比之下,神经网络的缺陷日益凸显:缺乏严格的理论支撑、训练过程依赖大量经验性技巧、容易发生过拟合、训练稳定性差等问题广受批评。

学术会议如NIPS连续多年拒收神经网络相关论文,反映出该领域再次遭遇冷遇。

这一时期的总体特征是:统计学习方法盛行、神经网络研究边缘化、理论短板被广泛讨论、资源投入与关注度持续下降。

5. 全面崛起:第三次繁荣(2012年至今)

真正的转机发生在2012年。得益于三大因素的共同推动——计算能力的飞跃(GPU与云计算普及)、大数据时代的到来,以及训练算法的持续改进(如无监督逐层预训练),神经网络以“深度学习”的新形态强势回归。

在ImageNet大规模视觉识别挑战赛中,基于深度神经网络的模型取得了突破性成绩,远超传统方法,充分证明了其在图像识别等高难度任务中的强大性能。

产业界也迅速跟进,Google、百度、Facebook等科技巨头纷纷加大投入,深度学习迅速成为人工智能的核心驱动力。

与此同时,各类深度学习框架和工具不断涌现,加速了技术的普及与应用落地。

深度学习近年来在多个领域实现了显著突破,展现出强大的技术潜力和广泛应用前景。其代表性成果主要体现在以下几个方面:

- 图像识别

- 语音识别

- 自然语言处理

- 机器翻译

- 自动驾驶

第三次繁荣期的核心特征

当前神经网络正处于自2012年起开启的第三次发展高峰,这一阶段呈现出以下几个显著特点:

- 计算能力的大幅提升与海量数据资源的积累为模型训练提供了坚实基础

- 理论体系与算法方法取得关键性改进,推动性能持续提升

- 产业界广泛参与并投入大量资源,加速技术落地

- 在多个应用场景中实现突破性成果

- 成为人工智能发展的主流方向之一

发展历程回顾

纵观神经网络的发展轨迹,其演进过程并非一帆风顺,而是经历了多次起伏:

- 萌芽期(1940年代):以M-P模型(1943年)和Hebb学习规则(1945年)为代表的早期理论奠定了研究基础。

- 第一次繁荣期(约1956–1969年):感知机(1958年)和Adaline模型(1960年)相继提出,引发初步热潮。

- 冰河期(1969年后):受《Perceptrons》一书影响,研究陷入低潮;尽管BP算法于1974年被提出,但未引起重视。

- 第二次繁荣期(约1984–1997年):Hopfield网络(1983年)问世,BP算法在1986年被重新发现并广泛应用。

- 沉寂期(约1997–2012年):支持向量机(SVM)在文本分类等任务中表现优异,统计学习理论兴起,神经网络研究再度降温。

- 第三次繁荣期(2012年至今):深度学习崛起,带动新一轮技术革命。

周期性模式观察

从时间维度分析,神经网络的发展呈现出一定的周期规律:

- 第一次繁荣期:约13年

- 冰河期:约15年

- 第二次繁荣期:约13年

- 沉寂期:约15年

- 第三次繁荣期:自2012年开始,至2025年已持续约13年

该模式显示,繁荣与低谷大致交替出现,呈现“13年上升、15年回落”的趋势。这种周期可能反映了技术演进的内在逻辑:

- 新技术出现后经历探索与推广,进入快速发展阶段

- 随着瓶颈显现和技术挑战加剧,热度逐渐下降

- 在低谷期间,理论积累和方法创新悄然进行,为下一轮突破积蓄力量

[此处为图片2]

历史启示

7.1 技术发展的非线性特征

神经网络的发展历程表明,技术进步往往不是直线推进,而是充满波动与反复。影响其走势的关键因素包括:

- 理论突破

- 计算能力水平

- 数据资源丰富度

- 实际应用需求

- 社会认知与接受程度

7.2 理论与实践的互动关系

理论的价值体现在:

- 缺乏理论支撑的技术易遭质疑

- 理论上的突破常引发方法层面的重大飞跃

实践的作用同样不可忽视:

- 实际应用的成功能反哺理论研究

- 充足的计算资源与高质量数据是推动发展的必要条件

7.3 创新与合作的重要性

历史经验提醒我们:

- 即使在研究低谷期,也可能孕育重要发现,不应轻易放弃

- 必须坚持持续的理论探索与方法革新

- 跨学科协作有助于激发新的研究思路与解决方案

现状与未来展望

目前,深度学习仍处于第三次繁荣期,在理论深化与应用拓展方面不断取得新进展,已成为人工智能的核心支柱之一。

值得注意的是,按照以往周期推算,自2012年起至今已历约13年,接近前两次繁荣期的时长。这引发了一个值得思考的问题:神经网络研究是否即将面临新的转折?抑或,凭借不断增强的算力、日益丰富的数据以及持续优化的算法,深度学习将打破原有周期限制,迈入一个更加稳定和可持续的发展阶段?

尽管未来的路径尚不确定,但从当前的技术积累和发展态势来看,深度学习仍具备广阔前景。无论是否延续历史周期律,持续推进理论创新、技术迭代与应用拓展,都将是在未来保持发展动能的关键所在。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号