前言

本章节主要介绍如何利用本地部署的一个轻量级大模型,搭建属于自己的个人知识库,从而体验大模型在知识存储与检索方面的能力。通过这种方式,用户可以在不依赖云端服务的情况下,初步感受大模型的运行逻辑和应用潜力。

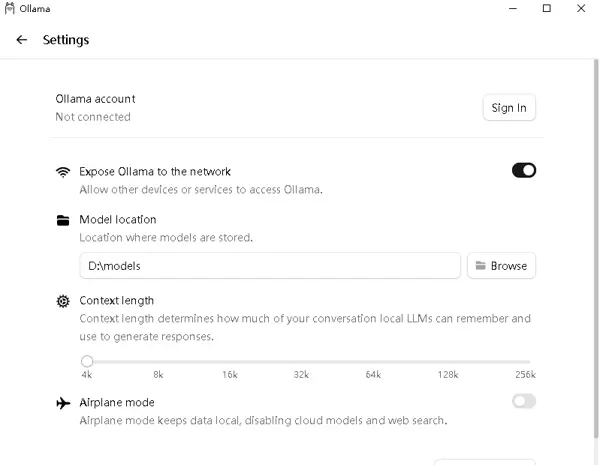

配置Ollama模型目录

在从官网下载并安装Ollama(欧拉玛)这一大模型管理工具后,首要任务是配置模型的存储路径。虽然系统默认会设定一个安装目录,但用户也可以根据需要自定义存放位置,以便更好地管理本地资源。

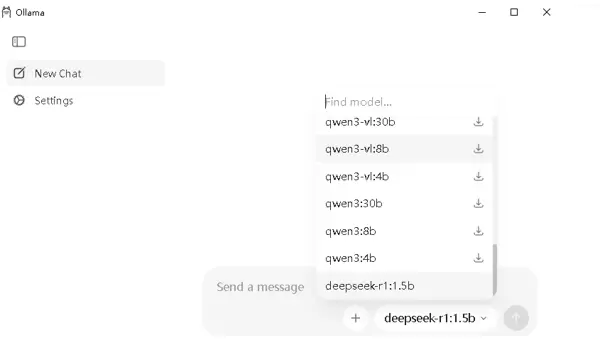

下载大模型

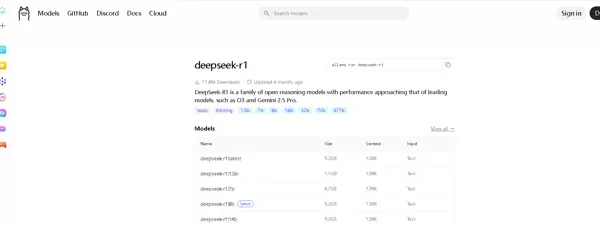

可以通过图形界面直接选择所需模型进行下载,也可以采用命令行方式操作。推荐先访问Ollama官网,在模型库中查找目标模型,并选定合适的版本。

找到对应模型后,复制其提供的安装命令,然后在终端执行该命令即可开始下载与部署过程。

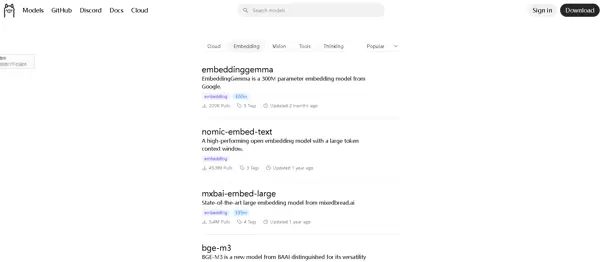

例如搜索“bge-m3”模型,这是一个常用于文本嵌入处理的模型,适用于构建本地知识库,无需额外配置即可使用。

无论是手动输入命令,还是通过下拉菜单选择模型,完成模型下载后,下一步就是着手建立专属的知识库系统。

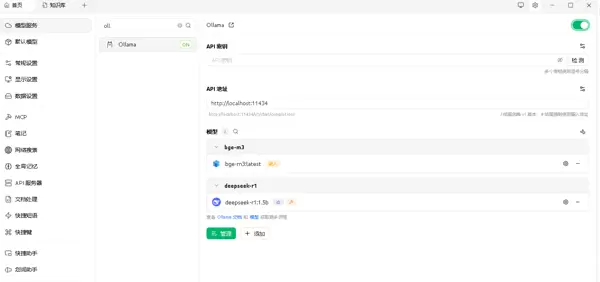

Cherry AI 大模型管理平台

除了Ollama之外,还可以使用Cherry AI这一集成化的大模型管理平台。该平台支持接入多个主流AI平台的模型服务,既可通过API连接远程模型,也能导入并读取本地已配置的大模型文件,实现灵活调度。

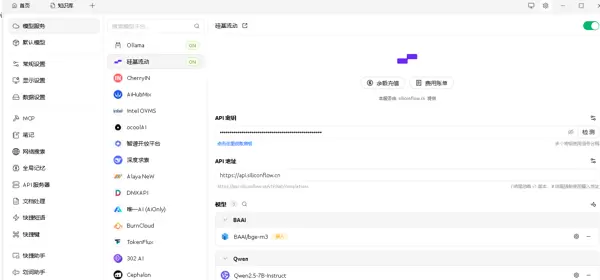

使用API方式接入模型

本次演示选择通过“硅基流动”的API接口来导入模型服务。这种方式使得用户能够借助外部高性能模型进行推理查询,同时保留本地系统的便捷性。当然,其他流行的模型服务如DeepSeek、通义千问、豆包等也同样支持接入。

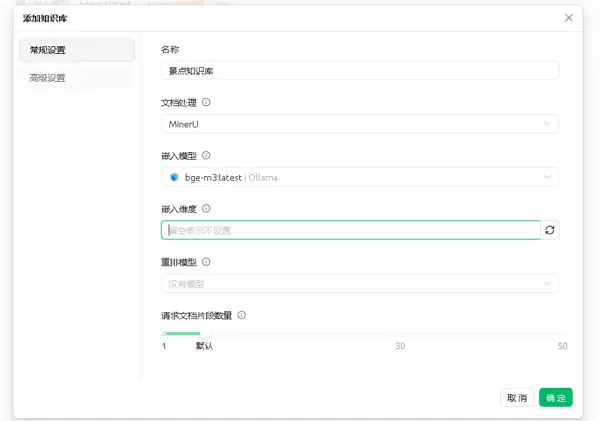

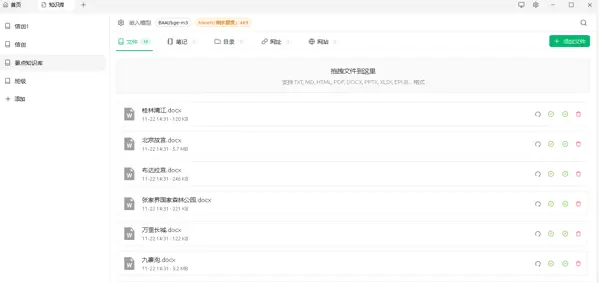

创建知识库

进入平台的知识库管理模块后,可以新建一个知识库项目。以下以旅游景点相关信息为例进行说明。

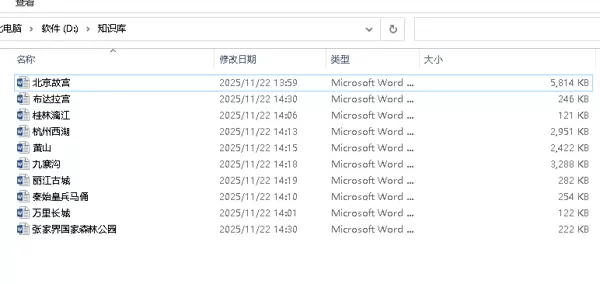

首先选择一个具体的主题方向,比如国内著名景点资料整理。

随后将准备好的文档内容上传至知识库中,支持多种格式文件的批量添加。

完成文档导入后,在后续的问答交互过程中,系统将自动关联该知识库,并优先调用其中的信息进行响应。

使用效果说明

在实际提问时,模型会优先检索知识库中的内容并据此生成回答。由于当前选用的是体积较小的本地模型,因此在回答质量、语言流畅度和逻辑完整性方面存在一定局限性,整体表现不如大型云端模型。

总结

本文重点展示了一种基于本地小模型搭建个人知识库的方法,旨在提供一种轻量化、可实践的大模型体验路径。尽管这类小型模型在能力上远不及大规模商用模型,但其优势在于隐私可控、部署简单,适合用于学习探索或初步测试,也可作为微调训练的基础环境。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号