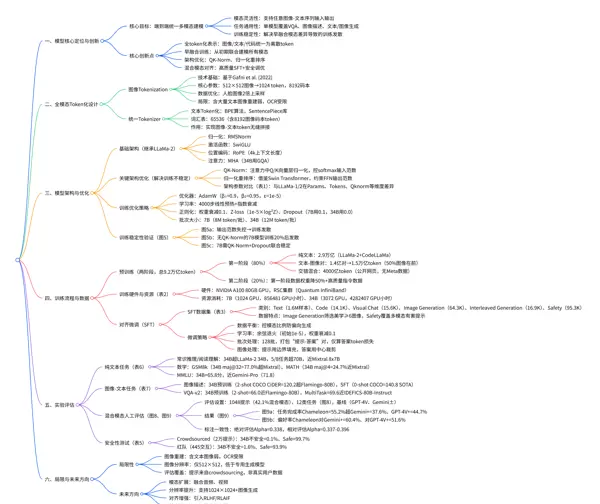

尽管当前主流的多模态基础模型已广泛部署,但其普遍依赖“模态分离处理”范式——即通过各自独立的编码器与解码器分别处理图像和文本信息,并在后期阶段进行融合。这种被称为“晚融合(late-fusion)”的方法存在两个关键缺陷:一是难以实现跨模态信息的深度整合;二是无法灵活生成图像与文本交错排列的复杂多模态文档。

Meta FAIR 团队提出的 Chameleon 模型,突破性地构建了一套基于 token 的早融合(early-fusion)多模态建模体系。该模型家族从架构设计、训练策略到任务对齐全过程均围绕“统一多模态表示”展开,首次实现了在同一框架下同时支持图像理解、文本生成、图像生成以及混合模态内容创作的能力。

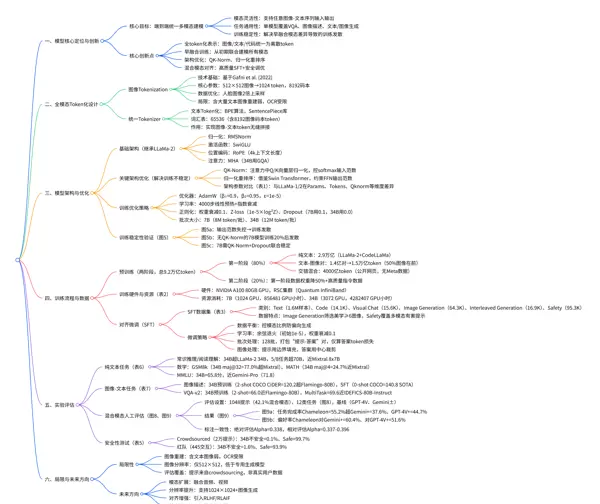

一、研究背景与核心定位

1.1 现有多模态模型的核心局限

论文指出,现有典型多模态模型(如 Flamingo、IDEFICS、LLaVA)面临三大瓶颈:

- 模态割裂建模:依赖独立的视觉编码器(如 ViT)与语言模型(如 LLM),导致模态间语义难以对齐;

- 任务类型受限:仅能执行单一方向的任务(如图文描述或文生图),无法处理“文本→图像→文本”等动态交错序列;

- 评估标准缺失:现有评测基准多聚焦于静态任务(如 VQA 或图像 captioning),缺乏对长序列混合模态输出能力的有效衡量。

1.2 Chameleon 的核心目标

Chameleon 致力于打造一个端到端统一的多模态基础模型,力求在以下三方面取得突破:

- 模态灵活性:支持任意顺序的图像与文本输入/输出组合,涵盖纯文本、纯图像及图文交替序列;

- 任务通用性:在视觉问答、图像描述、文本生成、图像生成等多个任务上均达到领先水平(SOTA);

- 训练稳定性:克服早融合模式下因模态差异引发的训练不稳定问题,成功实现 34B 参数量级模型的稳定训练。

1.3 主要技术创新概览

Chameleon 的创新贯穿整个建模流程,主要包括四个方面:

- 全 token 化表示:将图像、文本、代码等不同形式的数据统一转换为离散 token,由同一 Transformer 架构处理;

- 早融合训练机制:从训练初始阶段即对所有模态联合建模,而非后期拼接;

- 架构与优化改进:引入 QK-Norm 和归一化重排序技术,缓解多模态训练中的范数失衡问题;

- 混合模态对齐策略:借助高质量监督微调(SFT)数据集并结合安全调优,实现语义一致性和风险可控性。

二、模型架构与 token 化设计

Chameleon 的核心技术基础在于“模态统一表示”——通过将不同模态映射至同一 token 空间,再利用改进后的 Transformer 处理混合序列。

2.1 全模态 token 化方案

为实现图像与文本 token 的无缝衔接,论文系统设计了统一的 token 化流程。

2.1.1 图像 token 化(Image Tokenization)

- 技术基础:采用 Gafni 等人(2022)提出的离散化方法,训练专用图像 tokenizer;

- 核心参数:将 512×512 分辨率图像编码为 1024 个离散 token,来自大小为 8192 的码本;

- 数据增强:为提升人脸重建质量,对含有人脸的图像样本进行 2 倍上采样处理;

- 现存限制:对于包含大量文字内容的图像(如截图、海报)重建效果较差,影响 OCR 类任务表现。

2.1.2 统一 tokenizer 设计(Unified Tokenizer)

- 文本处理:基于 BPE(字节对编码)训练新 tokenizer,词汇表规模为 65536,其中嵌入 8192 个图像码本 token;

- 工具实现:使用 SentencePiece 库完成文本与代码序列的 token 化;

- 关键作用:确保图像与文本 token 处于相同语义空间维度,可直接拼接形成混合序列(例如:“文本 token → 图像 token → 文本 token”),供 Transformer 直接处理。

2.2 模型架构设计

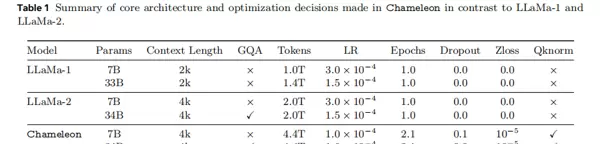

Chameleon 以 LLaMa-2 为基础架构,针对早融合多模态场景进行了三项关键调整。其主要架构参数与 LLaMa-1/2 的对比详见下表:

从上表可见,Chameleon 在多个维度进行了针对性优化:

- 训练数据规模:单模型训练 token 总量达 4.4T,是 LLaMa-2 的 2.2 倍;

- 新增模块:引入 QK-Norm(Qknorm 列)与 Z-loss 正则项(Zloss 列),以增强多模态训练的稳定性;

- Dropout 配置调整:7B 小模型保留 0.1 Dropout 用于训练辅助,而 34B 大模型因采用归一化重排序机制,无需额外 Dropout。

2.2.1 关键架构创新:应对多模态训练不稳定性

多模态联合训练的主要挑战在于不同模态特征分布差异大,容易导致注意力机制中 Query 与 Key 的范数失衡,进而引发梯度爆炸或收敛困难。为此,Chameleon 提出以下解决方案:

模态熵差异引发的范数失衡问题及应对策略

由于图像与文本在语义空间中的分布存在显著差异,多模态训练过程中不同模态倾向于“争夺”更高的输出范数,导致bf16精度下出现数值溢出,即logit drift现象。针对这一挑战,论文提出两项关键技术以增强训练稳定性:

查询-键归一化(QK-Norm)

技术原理:在注意力机制中,对查询向量(Q)和键向量(K)分别施加层归一化处理后再计算注意力得分,从而控制softmax输入的规模。

核心作用:有效抑制因模态间熵值不均(例如图像token的熵普遍高于文本token)所引发的梯度爆炸问题。

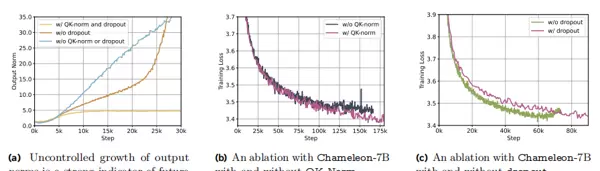

实验验证:如图5b所示,在Chameleon-7B模型上,未使用QK-Norm的版本在完成20%训练进度后即出现损失发散;而启用QK-Norm的模型则保持稳定下降趋势,表明其对训练过程的良好调控能力。

归一化重排序(Norm Reordering)

原始架构(基于LLaMa结构):

h = h + attention(norm(h))output = h + feed_forward(norm(h))改进后架构(借鉴Swin Transformer设计):

output = h + feed_forward(ffn_norm(h))核心作用:通过结构调整限制前馈网络(FFN)输出的范数增长,尤其适配SwiGLU这类具有乘法特性的激活函数——该特性容易引起范数快速放大。

适用场景:对于Chameleon-34B等大规模模型而言,必须结合此策略才能实现稳定训练。此外,得益于该方法的有效性,大模型无需依赖Dropout即可维持训练收敛,如图6c所示。

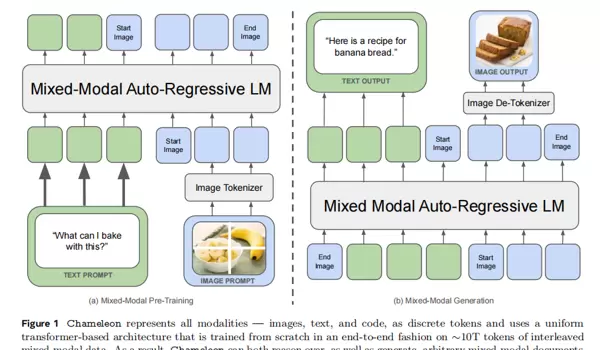

混合模态处理流程解析

论文借助图1清晰呈现了Chameleon模型的混合模态处理机制,整个流程划分为“预训练”与“生成”两个主要阶段:

左图:预训练阶段

图像经由Image Tokenizer编码为蓝色图像token,文本被转换为绿色文本token,二者混合构成统一序列,并输入至自回归语言模型中进行端到端联合训练。

右图:生成阶段

给定文本提示(如“What can I bake with this?”)与图像输入,模型可自动生成交替出现的文本与图像内容。其中图像部分通过Image De-Tokenizer还原为可视图像输出。

关键特点:全程无专用模态模块,仅依靠token类型标识区分图像与文本,实现真正意义上的无缝交错生成(interleaving generation)。

训练流程与数据构建策略

Chameleon的训练体系包含两个阶段:预训练(Pre-Training) 与 对齐微调(Alignment Fine-Tuning),累计训练token总量达9.2万亿,约为LLaMa-2的4.6倍。

3.1 预训练阶段:两阶段混合数据策略

预训练数据涵盖纯文本、图文对以及自然交错的多模态文档,采用分阶段策略平衡数据质量与多样性。

第一阶段(占总训练量80%):建立基础模态表征

- 纯文本数据:共计2.9万亿token,继承自LLaMa-2与CodeLLaMa的训练语料,覆盖广泛通用文本及编程代码领域。

- 图文对数据:收集1.4亿对样本,经处理后转化为约1.5万亿token;所有图像统一调整至512×512分辨率。

- 交错混合数据:来自公开网页资源(排除Meta内部产品数据),总量达4000亿token,包含“文本-图像-文本”等天然交错结构。

- 数据增强策略:在训练图文对时,以50%概率将图像置于文本前(模拟图像描述任务),另50%则反之(模拟文生图指令),以此提升模态对称性与泛化能力。

第二阶段(占比20%):强化任务对齐能力

- 数据权重调整:将第一阶段的数据权重下调50%,并引入高质量的指令微调子集。

- 核心目标:降低低质量数据对模型学习的干扰,增强其对复杂指令的理解与响应能力,为后续监督微调(SFT)奠定良好基础。

3.2 训练优化方案设计

为应对多模态训练中的不稳定性,研究团队构建了一套系统化的优化配置体系:

| 优化组件 | 配置细节 | 作用说明 |

|---|---|---|

| 优化器 | AdamW | 采用自适应学习率机制,适用于大规模参数模型的高效训练 |

| 动量参数 | β=0.9,β=0.95 | 兼顾收敛速度与训练过程的稳定性 |

| 学习率调度 | 4000步线性预热 + 指数衰减 | 避免初期参数剧烈震荡,后期逐步精细收敛 |

| 权重衰减 | 0.1 | 抑制过拟合,提升模型泛化性能 |

| 梯度裁剪 | 阈值设为1.0 | 防止梯度爆炸,保障反向传播稳定性 |

| Z-loss 正则化 | 系数为1e-5 × logZ | 约束softmax中的配分函数Z,缓解logit drift问题 |

| Dropout | 7B模型:0.1;34B模型:0.0 | 小模型辅以Dropout提升鲁棒性;大模型依赖归一化重排序,无需额外Dropout |

| 批次大小 | 7B:每批8M token;34B:每批12M token | 大批次匹配大模型需求,提升训练效率 |

3.2.1 训练稳定性监控:输出范数分析

研究发现,模型最后一层的输出范数增长与训练是否发散高度相关。一旦范数失控上升,后续损失必然出现异常波动。通过引入QK-Norm、Z-loss等机制,Chameleon能够有效抑制此类增长,确保训练持续稳定推进。

图5a:输出范数的急剧上升是训练即将发散的重要预警信号,需在训练中实时监测;

图5b:对比显示,缺乏QK-Norm的Chameleon-7B在20%训练进度后损失骤增,而应用该技术的版本仍保持平稳下降;

图5c:(上下文延续)进一步验证了多种正则化手段对整体训练轨迹的积极影响。

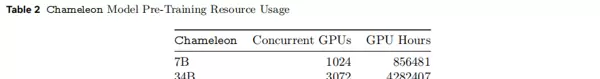

3.3 训练硬件与资源消耗

本研究的预训练工作在 Meta 的 Research Super Cluster(RSC)上完成,所使用的硬件配置及资源消耗情况详见表 2:

硬件规格:采用 NVIDIA A100 80GB GPU 构建计算集群。其中,RSC 集群通过 NVIDIA Quantum InfiniBand 实现高速互联,另一内部集群则使用 Elastic Fabric 技术进行连接。

资源对比分析:34B 参数模型所需的 GPU 小时数是 7B 模型的约 5 倍,表明随着参数规模扩大,训练所需的算力呈现非线性增长趋势。

四、对齐微调(Alignment)

在完成预训练后,研究进一步采用有监督微调(SFT)策略,以实现三大核心目标:多模态语义对齐、任务能力增强以及提升模型的安全性与可控性。

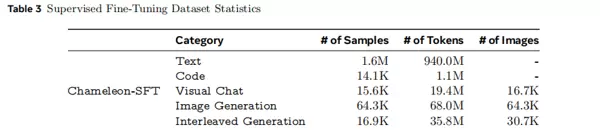

4.1 SFT 数据集设计:覆盖多样化多模态场景

SFT 数据集被划分为六大类别,旨在平衡不同模态和任务类型之间的分布,具体构成如表 3 所示:

- Text/Code:复用 LLaMa-2 的文本 SFT 数据及 CodeLLaMa 的代码 SFT 数据,确保模型在纯文本与编程任务上的性能不发生退化;

- Visual Chat:通过第三方供应商采集高质量视觉对话数据,涵盖“描述图像内容”“基于图像回答问题”等任务,共包含 16.7K 张图像;

- Image Generation:筛选美学评分不低于 6 分(使用 Schuhmann 等人于 2022 年提出的美学分类器评估)且分辨率接近 512×512 的图像,总计 64.3K 张,用于提升生成图像的质量;

- Interleaved Generation:支持“文本 - 图像 - 文本”交错式生成任务,例如“撰写故事并插入对应场景图像”,涉及 30.7K 张图像;

- Safety:包含针对文本、图像及混合模态的有害提示样本,用于强化模型的安全响应机制。

4.2 微调策略:实现模态均衡与训练效率优化

为保障模型在多模态环境下的高质量对齐表现,研究提出以下关键微调策略:

- 数据平衡控制:严格调控各模态数据的比例,防止模型在生成过程中偏向某一特定模态(如过度输出图像或文本);

- 学习率调度方案:采用余弦退火方式调整学习率,初始值设为 1e-5,同时设置权重衰减系数为 0.1;

- 批次处理优化:设定批次大小为 128,最大支持 4096 token 的序列长度;多个“提示 - 答案”对被打包进同一序列,并通过特殊分隔符标记,显著提升训练吞吐效率;

- 损失函数设计:仅对答案部分的 token 计算损失,忽略提示 token,使优化过程更聚焦于模型对指令的理解与响应能力;

- 图像预处理方法:对于输入提示中的图像,采用边界填充策略以保留完整信息;而对于生成答案中的图像,则应用中心裁剪操作,确保输出质量稳定。

五、实验评估:全面验证多模态能力

Chameleon 模型的能力评估从四个维度展开:纯文本任务、图像-文本联合任务、混合模态生成效果(人工评价)、以及安全性测试,系统性地验证其通用性与综合性能。

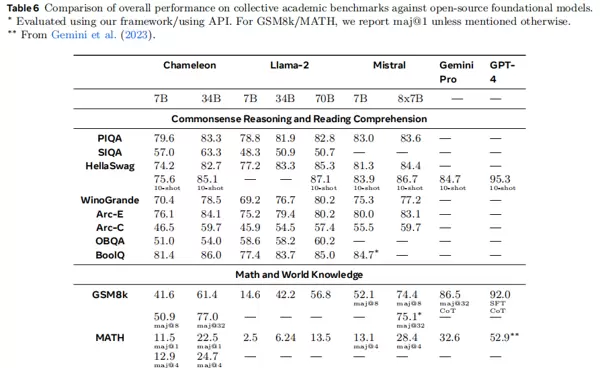

5.1 纯文本任务评估:性能未退化且实现超越

在常识推理、阅读理解、数学问题求解以及世界知识掌握(MMLU)四项任务中,Chameleon 与 LLaMa-2、Mistral、Gemini-Pro 等主流模型进行了对比,结果见表 6:

主要发现(以 Chameleon-34B 为例):

- 常识推理与阅读理解:

- 在 PIQA(83.3 vs LLaMa-2 34B 的 81.9)、SIQA(63.3 vs 50.9)、Arc-E(84.1 vs 79.4)等多个基准上均优于 LLaMa-2 34B;

- 在 5/8 项任务中表现超过 LLaMa-2 70B,整体水平接近 Mixtral 8x7B(如 HellaSwag 达 82.7,对比 Mixtral 的 84.4)。

- 数学能力:

- GSM8k(小学数学题):maj@32 准确率达 77.0%,高于 Mixtral 8x7B 的 75.1%;

- MATH(竞赛级数学题):maj@4 得分为 24.7%,接近 Mixtral 8x7B 的 28.4%,达到 LLaMa-2 70B(13.5%)的 1.8 倍。

- 世界知识掌握(MMLU):得分为 65.8,接近 Gemini-Pro 的 71.8,显著优于 LLaMa-2 34B 的 62.6。

结论总结:尽管引入了图像模态训练,Chameleon 在纯文本任务上的性能不仅未出现下降,反而因更大规模的训练数据(累计达 9.2 万亿 token)以及代码数据的融合而有所提升,充分证明了早融合架构在多模态扩展中的兼容优势。

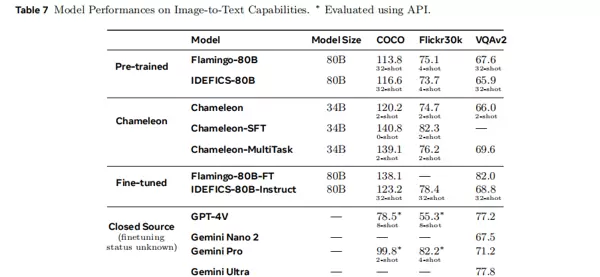

5.2 图像-文本任务评估:达到当前最优水平

研究重点考察了图像描述(Image Captioning)与视觉问答(VQA)两类典型任务,与 Flamingo、IDEFICS、LLaVA-1.5、GPT-4V 等先进模型进行比较,结果汇总于表 7:

5.2.1 图像描述任务(COCO/Flickr30k)

基于预训练模型开展图像描述生成测试,结果显示 Chameleon 在多项指标上达到或接近 SOTA 水平,尤其在细节丰富度与语义一致性方面表现出色。

5.2.2 视觉问答(VQA-v2)性能表现

预训练模型方面,Chameleon-34B 在仅使用 2-shot 设置下,在 VQA-v2 上取得了 66.0 的准确率,虽略低于 Flamingo-80B(32-shot,67.6),但已达到相近水平,显示出其在较少示例条件下的强大泛化能力。

微调后模型,即 Chameleon-34B-MultiTask,准确率提升至 69.6,接近 IDEFICS-80B-Instruct 的 68.8,但仍与 GPT-4V(77.2)存在一定差距。这表明尽管 Chameleon 具备较强的多任务学习能力,但在特定视觉理解任务上仍有优化空间。

与 LLaVA-1.5 相比,后者因专门针对视觉对话进行优化,在 VQA 任务上略有优势;然而,它在图像生成和纯文本处理方面显著落后于 Chameleon。这一对比凸显了 Chameleon 在跨模态任务通用性上的核心竞争力。

5.2 图像描述生成:COCO 与 Flickr30k 基准测试

预训练模型结果:Chameleon-34B 在 COCO 数据集上采用 2-shot 设置时,CiDER 分数达到 120.2,优于 Flamingo-80B(32-shot,113.8)以及 IDEFICS-80B(32-shot,116.6),展现出更高的样本效率。

经监督微调后的版本(Chameleon-34B-SFT,0-shot)表现更优,COCO CiDER 提升至 140.8,刷新当前 SFT 方法的最优记录;在 Flickr30k 上也取得 82.3 的 CiDER 分数,超越 Gemini-Pro(82.2),进一步验证其强大的文本-图像对齐能力。

值得注意的是,Chameleon 以更小的参数规模(34B 对比 80B)和更少的提示样本(2-shot vs 32-shot)实现了更佳性能,充分体现了其早融合架构在计算效率与建模能力之间的良好平衡。

5.3 混合模态生成能力:基于人工评估的全面验证

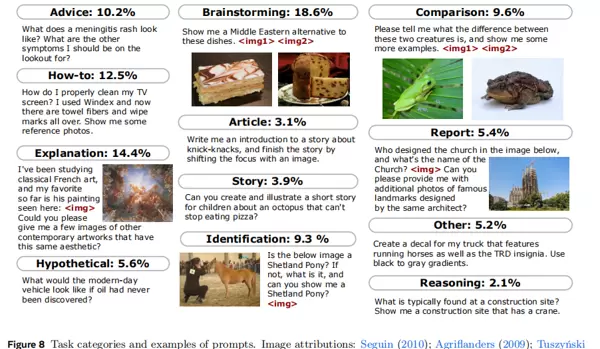

由于现有自动基准难以有效衡量“任意序列混合模态输出”的能力,研究团队设计了一项大规模人工评估实验,共涵盖 1048 个自然语言提示,其中 42.1% 需要混合模态响应(图像+文本),57.9% 为纯文本任务,覆盖图 8 所示的 12 类典型应用场景。

评估任务类型包括 Advice(建议)、How-to(教程)、Explanation(解释)、Hypothetical(假设)、Brainstorming(头脑风暴)等,每个类别均包含需图文并茂回应的实例,例如:“Show me a Middle Eastern alternative to these dishes. <img1> <img2>”。

评估设置与基线模型

基线模型选择:GPT-4V、Gemini-Pro,以及增强版本 GPT-4V+ 和 Gemini+——后者通过接入 DALL-E 3 补充图像生成能力以实现完整多模态响应。

评估指标设定:

- 绝对评估:依据任务完成程度分为完全完成、部分完成、未完成三类;

- 相对评估:采用人类偏好打分机制,两两对比 Chameleon 与基线模型的输出质量(胜出/平局/落败)。

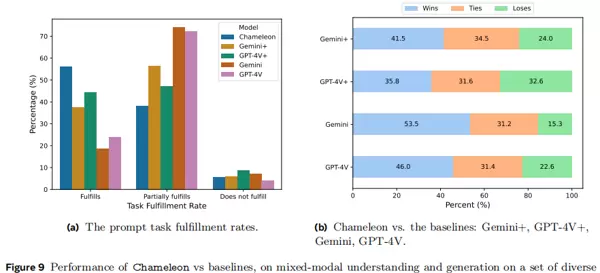

核心评估结果(见图 9)

图 9a:任务完成率对比

Chameleon 实现了 55.2% 的完全任务完成率,显著高于 Gemini+(37.6%)和 GPT-4V+(44.7%)。而原始不具备图像生成功能的基线模型表现极差——Gemini 仅为 17.6%,GPT-4V 为 23.1%,充分说明混合模态生成对于实际应用的关键价值。

图 9b:人类偏好率分析

在与增强版基线的比较中,Chameleon 获得明显偏好:

- 对 Gemini+ 的偏好率为 60.4%(34.5% 平局,41.5% 胜出);

- 对 GPT-4V+ 的偏好率为 51.6%(31.6% 平局,35.8% 胜出);

- 相较于原始无图像生成能力的 Gemini 和 GPT-4V,偏好率分别高达 69.1% 和 61.7%。

按任务类别的详细表现(参见原文表 11–14)

优势明显的任务类别:在需要灵活整合图文表达的任务中表现突出,如 Brainstorming(67.2% 完成率 vs Gemini+)、Comparison(59.4%)、Advice(61.2%),体现出其在创意辅助与信息组织方面的潜力。

待改进领域:在涉及复杂逻辑推理或长程叙事的任务中仍有不足,例如 Reasoning 仅达 50.0%,Story Generation 为 41.5%,反映出模型在保持长序列语义连贯性及图像内容精准匹配方面尚需加强。

人工标注一致性检验

为确保评估结果可靠性,研究采用 Krippendorff’s Alpha 系数进行一致性分析:

- 任务完成率标注的 Alpha 值为 0.338(95% CI: [0.319, 0.356]),显示良好的一致性;

- 偏好评估中,Chameleon vs Gemini+ 的 Alpha 为 0.337,vs GPT-4V+ 为 0.396,均处于人工评分可接受范围内,支持结论的有效性。

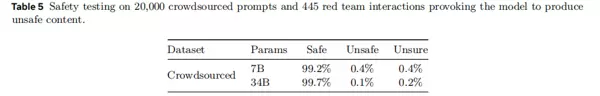

5.4 安全性评估:低风险响应且具备可控性

为验证模型在现实场景中的安全性,研究开展了两类测试:众包敏感提示测试与红队攻击模拟,结果汇总于表 5。

众包测试:收集 20,000 条涉及暴力、隐私泄露、色情等内容的敏感提示,Chameleon-34B 的不安全响应率仅为 0.1%,表现出较强的过滤能力。

红队测试:执行 445 次多轮交互式恶意诱导,Chameleon-34B 的不安全响应率为 1.6%,不确定响应(如拒绝回答或提示风险)占比 4.5%。

结论:通过安全导向的微调策略,模型对有害内容具有较强抵抗力,适用于大多数良性使用场景;未来可通过引入 RLHF 或 RLAIF 进一步提升安全边界。

六、模型局限性与相关工作对比

6.1 Chameleon 的主要局限

论文客观指出了当前模型存在的三项关键限制:

- 图像重建能力有限:在处理包含大量文字的图像(如网页截图、宣传海报)时,重建效果不佳,影响 OCR 相关下游任务的应用表现;

- 图像生成分辨率受限:当前输出图像的分辨率尚未达到最高行业标准,可能制约其在高精度视觉创作场景中的实用性;

当前仅支持 512×512 分辨率输出,相较 DALL-E 3、Midjourney 等专业图像生成模型在分辨率方面仍存在差距;

评估的覆盖范围方面:提示语主要来源于众包平台的人工标注,而非真实用户交互场景下的数据采集,因此在应用情境的多样性上仍有局限。

6.2 与现有工作的关键区别

本文将 Chameleon 与其他代表性多模态模型进行对比,包括晚融合架构(如 Flamingo、LLaVA)以及其它早融合方案(如 Gemini),其核心差异总结如下表:

| 模型 | 融合方式 | 模态支持 | 核心架构特点 | 关键局限 |

|---|---|---|---|---|

| Flamingo | 晚融合 | 图像→文本理解 | 视觉编码器 + 大语言模型,后期拼接处理 | 不具备图像生成能力 |

| LLaVA-1.5 | 晚融合 | 图像→文本问答 | 基于 CLIP 编码器与 LLaMA 模型,配合视觉指令微调 | 无图像生成功能,文本任务表现较弱 |

| Gemini Pro | 早融合 | 混合模态理解与生成 | 采用多模态 tokenizer 并配备独立解码器 | 依赖路由机制,生成灵活性受限 |

| Chameleon | 早融合 | 混合模态理解与生成 | 统一 tokenizer 配合无路由 Transformer 架构 | OCR 能力较弱,图像分辨率支持有限 |

Chameleon 的显著优势在于实现了真正意义上的端到端统一建模。该模型无需引入模态专用模块,即可在单一框架内高效完成多种任务,是首个能够灵活处理“任意序列混合模态输入”的开源模型。

七、总结与未来展望

7.1 主要贡献

本研究通过 Chameleon 模型,在多模态基础模型领域取得了三项关键突破:

- 架构创新:提出全 token 化的早融合结构,首次实现对任意顺序混合模态文档的理解与生成能力;

- 训练技术突破:引入 QK-Norm、归一化重排序和 Z-loss 等方法,有效缓解早融合模型训练过程中的不稳定性问题,成功支撑 34B 规模大模型的训练;

- 评估体系构建:建立首个大规模、基于人工评估的混合模态基准测试集,为长文档多模态生成能力的衡量提供了新标准。

7.2 后续发展方向

结合论文分析及多模态技术演进趋势,Chameleon 的未来优化可聚焦于以下四个方向:

- 扩展支持模态类型:逐步整合音频、视频等更多感知通道,推动向通用多模态智能体迈进;

- 提升图像分辨率:改进图像 tokenizer 设计,支持更高清输出(例如 1024×1024 及以上);

- 增强对齐质量:引入基于人类反馈的强化学习(RLHF)或人工智能反馈(RLAIF),进一步优化生成内容的安全性与一致性;

- 延长上下文长度:拓展模型支持的序列长度至 16k 或 32k tokens,以应对更复杂的长篇混合模态文档处理需求。

7.3 行业意义

Chameleon 的发布标志着多模态模型正从“特定任务专用”向“通用统一架构”的重要转型。其采用的早融合设计思路与训练策略为后续研究提供了宝贵参考,有望推动多模态技术从单一功能(如图像生成、视觉问答)向复杂交互场景延伸,例如智能报告自动生成、多模态教育资源创作、交互式设计辅助系统等高价值应用场景的发展。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号