今日课程提纲

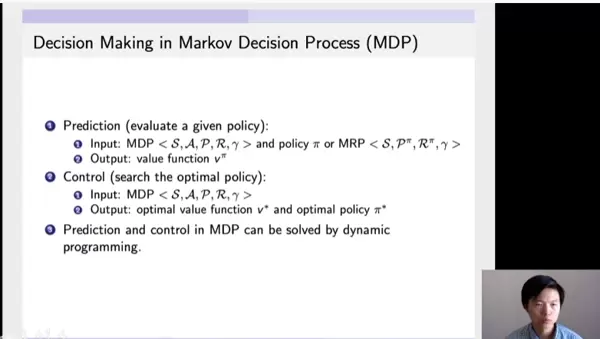

本节将重点讲解马尔科夫决策过程(MDP)中的两大核心问题:预测(prediction)与控制(control)。这两个问题构成了强化学习中策略评估与优化的基础。

一、Prediction(预测)

在已知一个完整的马尔科夫决策过程以及某个特定策略π的前提下,预测任务的目标是计算该策略下的状态价值函数(value function)。换句话说,就是评估在每个状态下遵循该策略所能获得的期望回报。这一过程不涉及策略的改进,仅聚焦于价值的准确估计。

二、Control(控制)

控制问题则更进一步,其目标是从给定的马尔科夫决策过程中寻找到最优策略。输入为环境模型本身,输出包括两个部分:一是最优价值函数(optimal value function),二是对应的最优策略(optimal policy)。通过不断迭代优化,使得智能体能够在长期运行中获得最大累积奖励。

三、Dynamic Programming 动态规划

在解决MDP中的prediction和control问题时,动态规划是一种极为有效的数学工具。它依赖于问题具备“最优子结构”(optimal substructure)的特性——即整体最优解可以通过各子问题的最优解构造而成。

马尔科夫决策过程天然满足这一条件,这主要体现在Bellman方程所体现的递归结构上。通过将当前状态的价值与其后继状态的价值相关联,一旦子状态的价值被求解出来,便可逐步反向推导出前序状态的价值。这种机制允许我们存储并重用已计算的结果,从而大幅提升计算效率。

因此,无论是进行策略评估(对应prediction),还是策略改进与优化(对应control),动态规划都提供了一套系统化的迭代方法来逼近最终解。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号