数据是记录客观事件并具备可识别性的符号,它不仅是数字,还包括文字、字母、图形、图像、音频、视频等多种形式。这些符号用于描述事物的属性、状态及其相互关系,是一种抽象且可识别的表达方式。例如,“0、1、2…”、“阴、雨、下降”或“学生的档案记录、货物运输情况”都属于数据范畴。

数据来源于对现实世界中各种现象的计量与记录过程。通过系统化的采集和整理,原始信息被转化为可用于分析的符号集合。

企业中的数据分析方向

在企业运营过程中,数据分析主要用于挖掘隐藏在大量数据背后的规律性信息,帮助管理者理解业务现状、追溯问题成因,并预测未来趋势,从而支持科学决策。

数据分析主要分为三个维度:

- 现状分析:聚焦当前的数据表现,了解整体运行状况、各组成部分的占比结构以及动态变化趋势;

- 原因分析:回溯历史数据,探究某一结果产生的根本原因,进而优化策略;

- 预测分析:基于已有数据对未来发展趋势进行建模推断。

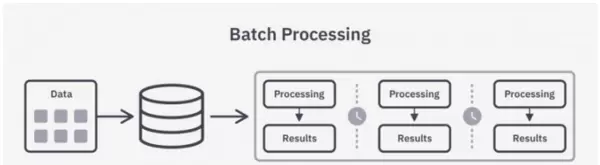

1. 原因分析 —— 离线处理模式

该类分析面向过去发生的事件,依赖已存储的历史数据进行批量化处理(Batch Processing)。由于数据处理具有周期性特征,常见如T+1(每日一次)或T+7(每周一次),因此也称为批处理分析。

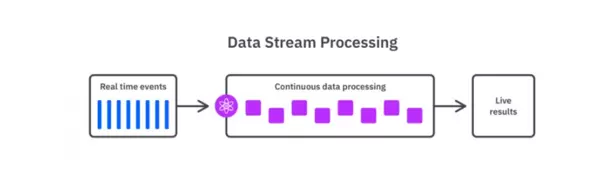

2. 现状分析 —— 实时处理模式

实时分析(Real Time Processing 或 Streaming)关注当下正在生成的数据流。其核心在于从数据产生到分析应用的时间延迟极短,通常可达秒级甚至毫秒级响应,适用于需要即时反馈的场景。

3. 预测分析 —— 机器学习驱动

利用历史数据与实时数据结合,借助数学模型对未来行为或趋势做出预测。这一过程广泛采用机器学习技术,包括分类、聚类、关联规则挖掘和回归预测等算法。

数据分析的基本流程

规范的数据分析流程能够为整个研究提供清晰的逻辑框架,确保分析结果的有效性和完整性。根据张文霖在《数据分析六步曲》中的观点,典型的数据分析应包含以下六个步骤:

Step1:明确分析目的与思路

这是整个分析工作的起点。明确“为什么要做这个分析”能为后续的数据收集与处理指明方向。同时,构建系统化的分析思路至关重要,需保证各分析环节之间存在合理的逻辑连接,避免遗漏关键维度。该过程常借助数据分析方法论来支撑,如用户行为理论、PEST模型、5W2H分析法等管理学或营销学工具。

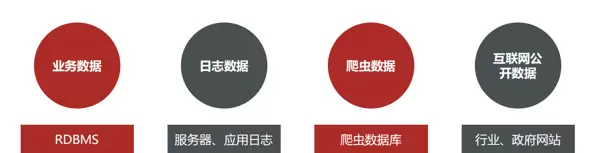

Step2:数据收集

数据收集涵盖两个层面:一是从无到有的原始数据获取,比如通过传感器采集气象信息、前端埋点追踪用户操作行为;二是将已有数据从源端传输至分析平台的过程,例如从生产数据库抽取数据至数据仓库。

Step3:数据处理(即数据预处理)

此阶段旨在将原始数据加工成适合分析的格式,主要包括数据清洗、转换、提取与计算等操作。经过处理后的数据应具备一致性与结构性,成为干净规整的二维表形式——专业上称为结构化数据,通俗理解即为格式统一、易于读取与分析的数据集。

Step4:数据分析

运用合适的分析方法与工具,对处理后的数据进行深入剖析,从中提炼出有价值的信息并形成有效结论。这一步骤要求分析师既掌握多种分析技术,又熟悉常用数据分析软件的操作。

Step5:数据展现

又称数据可视化(Data Visualization),是将分析结果以图表等形式直观呈现的过程。由于人类更擅长接收视觉信息,良好的可视化设计有助于快速传达洞察。需要注意的是,分析成果不仅限于可视化展示,还可进一步用于数据挖掘(Data Mining)或即席查询(Ad Hoc)等高级应用。

Step6:报告撰写

数据分析报告是对全过程的总结与输出,需完整呈现分析背景、实施路径、核心发现及建议方案,供决策层参考。一份高质量的报告应当有清晰的结论,并尽可能提出可行的解决方案。

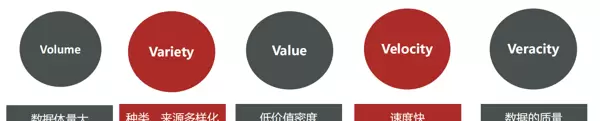

大数据的核心特征

所谓大数据(Big Data),是指那些无法用传统软件工具在合理时间内完成捕捉、管理和处理的数据集合。它需要新型处理模式才能实现更强的决策支持、洞察发现和流程优化能力,本质上是一种高增长、多样化、海量的信息资产。

大数据的特性通常由五个以“V”开头的英文单词概括:

- Volume(数据体量大):数据规模巨大,涉及采集、存储与计算等多个环节,起步单位常为TB乃至PB级别;

- Variety(类型多样):数据来源广泛,涵盖日志文本、图片、音频、视频等多种媒介;结构上包括结构化、半结构化与非结构化数据;

- Value(价值密度低):尽管总体信息量庞大,但真正有价值的内容占比偏低,需通过深度挖掘和复杂分析才能提取有用信息,往往依赖机器学习技术支持;

- Velocity(速度快):数据生成速度迅猛,同时要求高效的数据获取与处理能力,以应对高频更新;

- Veracity(数据质量):强调数据的准确性与可信度,高质量的数据是得出可靠结论的基础。

分布式与集群的基本概念

虽然常被并列提及,但“分布式”与“集群”实为两个不同的架构理念:

- 分布式:指将系统的不同组件部署在多台服务器上,各节点承担不同功能,协同完成任务;

- 集群:则是将相同的服务或组件部署在多个节点上,主要目的是提升性能、可用性与容错能力。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号