在竞争激烈的应用市场中,每一个细节都可能影响用户的决策。A/B 测试作为一种科学的验证手段,帮助团队摆脱主观猜测,转而依赖真实用户行为数据来优化产品展示。与其争论哪张截图更具吸引力,不如直接让用户通过行为“投票”。A/B 测试的核心价值在于,它能将直觉转化为可衡量、可分析的数据依据。

当应用商店算法日趋智能化,仅靠经验已难以维持优势,实验成为提升转化的关键策略。幸运的是,主流平台已提供成熟工具:Google Play管理中心与App Store Connect均内置了A/B测试功能,无需额外开发即可启用。借助这些机制,我们能够与目标用户建立直接反馈循环——提出假设、收集响应、持续迭代。

一、A/B测试的本质

A/B测试远不止是两张图片的简单对比,它是与用户进行沟通的一种方式。用户通过点击、浏览和安装等行为表达偏好,相当于对页面设计投出“赞成”或“反对”票。核心问题很明确:“哪一个版本能更有效地传达应用的价值?”答案则由实际数据给出,清晰且具备可比性。

根据测试复杂度不同,可分为几种类型:

- A/B测试:用于验证单一变量的影响,例如比较两个图标,判断哪个更能吸引注意力。

- 多变量测试:同时评估多个元素组合的效果,如屏幕截图、描述文案与视频预览的不同搭配。

- 产品页面实验:构建完整的替代页面版本,全面测试整体改版带来的转化差异。

二、测试前的准备与规划

一次成功的A/B测试离不开严谨的前期设计。在启动之前,必须明确测试对象、目标以及评估标准。

所有实验都始于一个清晰的假设。这个假设不仅要说明改动内容,还需预测其影响。例如:“若将应用图标从蓝色改为橙色,因色彩对比度增强,预计页面点击率将提升10%。”

关键原则包括:

- 每次只变更一个变量。若同时调整图标、截图和描述,则无法确定具体是哪个因素导致结果变化。应优先测试最关键元素,并逐步推进。

- 关注外部环境干扰。测试周期需覆盖工作日与周末,以平衡用户行为波动;避免在节假日或大规模广告投放期间开展实验,以防流量异常影响结论准确性。

充分准备意味着测试已成功一半。这不仅有助于获取有效数据,更能提炼出对未来优化有价值的洞察。

三、App Store中的A/B测试流程

苹果平台通过App Store Connect提供的“产品页面优化(PPO)”功能支持A/B测试。其显著特点是每个变体必须经过审核流程,通常耗时2-3天,才能正式上线运行。

系统允许同时测试最多三个备选版本加原始页面,共四个版本并行比较。测试最长可持续90天,在中等流量下也足以积累具有统计意义的数据样本。值得注意的是,本地化语言需单独设置测试,即每种语言版本需独立配置实验参数。

一旦测试启动,系统会自动分配访问流量至各版本,并提供详细的转化分析报告。这使得开发者可以在全量发布前,精准识别出最能引发用户兴趣的内容组合。

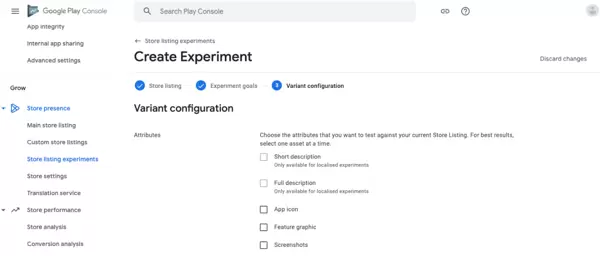

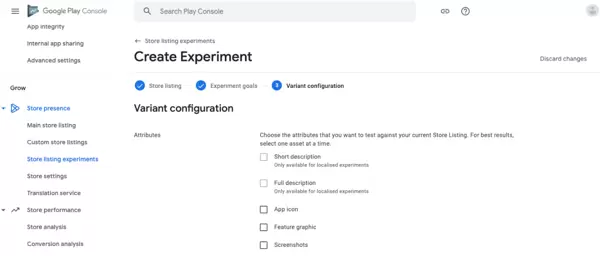

四、Google Play中的A/B测试流程

Google Play管理中心提供了“应用商店详情页面实验”这一强大工具,堪称用户偏好的研究实验室。几乎所有的页面元素均可参与测试,包括截图、宣传视频、描述文本和主图资源。唯一例外是应用标题——该字段无法通过实验修改,必须通过版本更新实现变更。

主要实验类型包括:

- 默认图形实验:针对访问应用页面的部分用户,测试不同的图形素材表现效果。

- 局部实验(本地化实验):面向使用特定语言浏览的用户群体,测试本地化内容与视觉资源的适配性。需先完成翻译配置,之后最多可并行运行五个本地化实验。

- 定价实验:根据不同市场的消费水平测试价格敏感度,支持设置区域化的应用内购价格,从而提升转化潜力。

系统最多支持三个并行页面版本,特别适用于多语言、跨区域的精细化运营。针对不同地区可创建独立测试,并结合文化习惯调整内容呈现。测试持续时间一般为7至14天,虽然官方未设定最短周期,但系统会在达到统计显著性后自动结束实验。

最大优势在于结果的高度可靠性与可视化程度。系统自动分流流量,并标注各版本的重要性等级,帮助团队做出基于数据而非直觉的决策,持续优化Google Play页面表现。

五、结果分析与解读

测试结束后,数据分析成为决定成败的关键环节。只有具备统计显著性的差异,才能被视为真实有效的结果,而非随机波动所致。

重点关注以下三大核心指标:

- 转化率:指访问页面后最终完成应用安装的用户比例,反映页面说服力。

- 点击率(CTR):衡量从搜索结果页跳转至应用详情页的比率,体现标题与缩略图的吸引力。

- 留存率:用户安装后持续使用的时长,间接反映前期宣传与实际体验的一致性。

通过对上述指标的深入分析,不仅可以判断哪个版本胜出,还能挖掘用户偏好背后的深层动因,为后续优化提供方向性指导。

即使某个版本被判定为“失败”,它依然可能带来极具价值的洞察。例如,若版本B在转化率上表现不佳,却展现出更高的用户留存率,则说明该版本虽然吸引的用户数量较少,但受众质量更高。每一个测试结果都在帮助我们更深入地理解目标用户的行为与偏好。

当一次A/B测试结束后,我们会执行以下步骤:

- 将表现最优的方案设为当前主版本;

- 把本次测试的假设和实际结果归档至团队知识库中;

- 基于所获得的洞察,提出新的优化假设,用于指导后续测试。

A/B测试本质上是一个持续循环的过程——测试、分析、实施、再测试。这一闭环机制让应用商店优化(ASO)策略不再是静态操作,而是演变为一个不断进化的系统。通过这种迭代方式,我们的应用能够逐步贴近用户的真实需求,为长期增长构建稳固基础。

常见的A/B测试误区

即便实验设计得再严谨,若忽视了一些常见陷阱,也可能导致整个测试失效。这些错误不仅影响新手,同样会困扰资深从业者,最终造成资源浪费或得出错误结论。

- 过早结束测试:在未达到统计显著性前就终止实验,容易将短期波动误判为有效趋势。通常建议测试周期不少于7至14天,以确保数据具备代表性。

- 流量分配不均:若不同版本接收到的用户流量存在明显差异,尤其是在特定时段集中曝光某一版本,会导致结果偏差。采用自动化的流量均衡分配机制是避免此类问题的最佳实践。

- 受外部因素干扰:在节假日或大规模广告投放期间进行测试,相当于在异常环境下采集数据。此时获取的结果难以准确反映改动本身的影响,参考价值有限。

- 跨平台照搬策略:不能默认某个在App Store行之有效的方案,在Google Play上也会取得相同效果。两个平台的用户行为模式存在差异,内容共鸣点也各不相同,必须独立验证。

规避上述问题,才能确保收集到的数据真实可靠,为关键决策提供有力支撑。

A/B测试并非一次性任务,而是一场与用户的持续对话。正如生命体需要不断适应环境变化,应用页面也需要持续迭代,才能紧跟用户偏好的演进节奏。这种方法最核心的优势在于其累积效应——每一次微小的优化都为下一次进步铺路,最终汇聚成显著成果。

完整记录每一轮实验过程至关重要,从初始假设到最终结论都应系统存档。这些沉淀下来的知识将成为团队共享资产的一部分,帮助新成员快速掌握历史决策背景,减少重复试错。我们不只是被动跟随市场趋势,而是主动产出数据,驱动科学决策,在激烈的用户注意力竞争中稳步前行。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号