在现代分布式系统架构中,负载均衡(Load Balancing)已从一种可选技术转变为确保系统可用性、性能和稳定性的关键基础设施。

随着互联网业务的快速增长,单机服务器的处理能力瓶颈变得越来越明显,负载均衡技术因此成为了应对高并发和大流量场景的重要手段。

服务器单机困境

以常见的Tomcat应用服务器为例,默认配置下仅能处理150个并发请求(Tomcat 8.5.x版本)。在业务高峰期间,超出线程池上限的请求只能排队等待,导致系统响应时间显著下降。这一架构的主要问题包括:

- 处理能力固定: 单台服务器的并发处理能力受到硬件资源的限制。

- 无容错能力: 服务器故障会导致业务中断。

- 扩展性差: 垂直扩展(升级硬件)成本高昂且有上限。

- 资源利用不均: 无法根据实时负载动态分配资源。

负载均衡的优势

假设单台服务器能够处理2000个并发请求,部署5台服务器并配置负载均衡后,总处理能力可提升至10000个请求。更重要的是,负载均衡带来了以下优势:

- 高可用性: 单点故障不会影响整体服务。

- 水平扩展: 通过增加服务器节点来提高容量。

- 资源优化: 根据算法策略合理分配流量。

- 灵活部署: 支持灰度发布、蓝绿部署等高级策略。

国内互联网巨头如阿里巴巴、腾讯、百度、字节跳动、美团等均广泛采用了负载均衡技术。

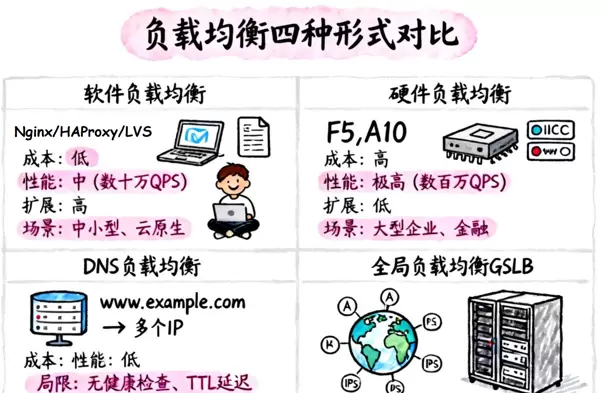

负载均衡的四种核心形式

一、软件负载均衡(SLB):灵活性与成本优势

软件负载均衡通过在通用服务器上部署代理程序实现流量分发,主要依赖软件实现。

核心实现工具

- Nginx: 高性能Web服务器,支持七层(应用层)和四层(TCP/UDP层)流量分发,具有灵活的路由策略(轮询、加权轮询、IP哈希等)。

- HAProxy: 支持七层(HTTP协议)和四层(IP加端口)流量分发,具备会话保持、URL路径匹配、ACL访问控制等功能。

- LVS(Linux Virtual Server): 四层负载均衡,基于TCP/IP和Linux内核进行路由和转发。

技术特点

- 基于通用服务器硬件,无需专用设备。

- 支持多种负载均衡算法(轮询、最少连接、哈希等)。

- 可通过配置文件灵活调整策略。

- 社区活跃,开源方案零成本。

适用场景

- 中小型企业或预算有限的项目。

- 需要快速迭代和灵活配置的业务。

- 动态扩展需求强烈的云原生架构。

- 开发测试环境。

二、硬件负载均衡(HLB):高性能与可靠性

硬件负载均衡采用专用设备实现,通过优化的芯片和固件提供卓越性能。

主流产品

- F5 Big-IP: 市场占有率最高的企业级负载均衡设备。

- A10 Networks: 高性能应用交付控制器。

- Citrix NetScaler: 应用交付和负载均衡解决方案。

技术特点

- 专用ASIC芯片实现硬件加速。

- 提供SSL卸载、深度数据包检测(DPI)等高级功能。

- 双电源、双链路等冗余设计保障高可用。

- 厂商提供专业技术支持和SLA保障。

适用场景

- 大型企业核心业务系统。

- 金融、电信等对性能和稳定性要求极高的行业。

- 超大规模并发流量场景(百万级并发)。

- 需要复杂应用层优化的场景。

三、DNS负载均衡:地理分布与简单调度

DNS负载均衡通过域名解析层面实现流量分发,是最简单的负载均衡形式。

实现原理

为同一域名配置多个A记录,DNS服务器根据策略返回不同的IP地址。

www.example.com IN A 192.168.1.1

www.example.com IN A 192.168.1.2

www.example.com IN A 192.168.1.3技术特点

- 实现极其简单,无需额外设备或软件。

- 支持基于地理位置的智能解析。

- DNS TTL控制缓存时间。

- 成本几乎为零。

适用场景

- 全球化业务的CDN加速。

- 跨地域数据中心的粗粒度调度。

- 简单的流量分发需求。

- 静态资源服务。

局限性

- DNS缓存导致切换延迟(TTL时间内无法实时调整)。

- 无法感知后端服务器健康状态。

- 无法实现会话保持。

- 调度策略简单,缺乏细粒度控制。

四、全局负载均衡(GSLB):智能调度与容灾

GSLB结合DNS与健康检查机制,对分布在不同地理位置的服务器集群进行负载均衡,实现跨数据中心的智能流量调度。

对于某个请求,应将其指定到哪个服务集群,通常考虑的因素包括距离和服务器集群的负载情况。

核心功能

- 健康检查: 实时监控后端节点状态。

- 智能路由: 基于延迟、地理位置、负载等多维度决策。

- 故障自愈: 自动将流量切换至健康节点。

- 容灾能力: 支持多活、同城双活、异地灾备等架构。

适用场景

- 多数据中心多活架构。

- 跨云、混合云部署。

- 需要智能容灾的关键业务。

- 全球化业务的精细化调度。

软硬件负载均衡深度对比

| 对比维度 | 硬件负载均衡 | 软件负载均衡 |

|---|---|---|

| 性能表现 | 专用ASIC芯片,数百万并发,微秒级延迟 | 受通用硬件限制,数十万并发,毫秒级延迟 |

| 可靠性 | 冗余设计(双电源/双链路),MTBF高 | 依赖软件稳定性,需多节点冗余保障 |

| 功能丰富度 | SSL卸载、DPI、应用层优化、全协议支持 | 基础功能完善,高级功能需插件扩展 |

| 成本投入 | 初始投资高(数十万至数百万),维保费用高 | 软件授权费用低或免费,硬件成本低 |

| 部署复杂度 | 较高 | 较低 |

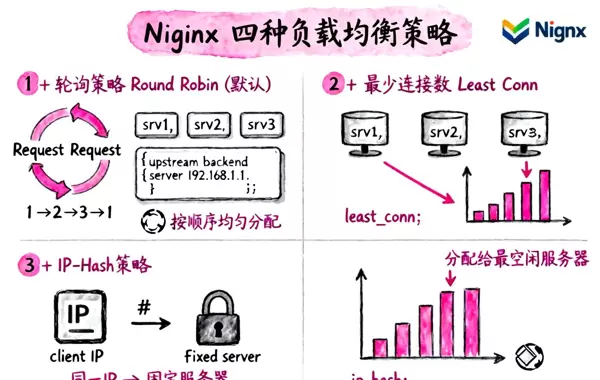

Nginx负载均衡策略详解

Nginx作为最受欢迎的软件负载均衡解决方案之一,提供了四种内置的负载均衡策略,每种策略适用于不同的应用场景。

1. 轮询策略(Round Robin)- 默认策略

原理:按照配置顺序依次将请求分配给后端服务器,确保请求的均匀分布。

配置示例:

upstream backend {

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}适用场景:

- 后端服务器性能相似

- 无状态服务(例如静态资源、API网关)

- 简单场景下的快速部署

优点:配置简便,请求分配均匀。

缺点:未考虑服务器的实际负载情况。

2. 最少连接数策略(Least Connections)

原理:优先将请求分配给当前活动连接数最少的服务器,实现动态负载均衡。

配置示例:

upstream backend {

least_conn; # 启用最少连接数策略

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}适用场景:

- 请求处理时间差异较大的业务

- 长连接服务(例如WebSocket)

- 后端服务器性能不一致的情况

优点:动态平衡负载,防止某台服务器过载。

缺点:需要维护连接状态,略微增加Nginx的开销。

3. IP-Hash策略

原理:根据客户端IP地址的哈希值确定后端服务器,确保同一客户端的请求固定分配到同一服务器。

配置示例:

upstream backend {

ip_hash; # 启用IP-Hash策略

server 192.168.1.1;

server 192.168.1.2;

server 192.168.1.3;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}适用场景:

- 会话保持需求(Session Sticky)

- 用户登录状态存储在应用服务器本地

- 无法使用Redis等中间件存储会话的场景

优点:解决会话保持问题,无需额外的中间件。

缺点:

- 负载分布不均(用户分布不均匀)

- 服务器扩缩容影响较大

- 不适用于CDN或代理后的场景

4. 加权负载均衡(Weighted)

原理:根据服务器配置的权重值分配请求,权重高的服务器获得更多的流量。

配置示例:

upstream backend {

server 192.168.1.1 weight=3; # 权重3,接收60%流量

server 192.168.1.2 weight=1; # 权重1,接收20%流量

server 192.168.1.3 weight=1; # 权重1,接收20%流量

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}配置说明:在5次请求中,3次分配给srv1,1次给srv2,1次给srv3。

适用场景:

- 后端服务器硬件配置差异大

- 新旧服务器混合部署

- 灰度发布(新版本低权重,观察稳定性)

- 需要精细化流量控制的场景

优点:充分利用高性能服务器资源,灵活控制流量分配。

缺点:需要手动配置权重,需要对服务器性能有准确的评估。

Nginx负载均衡实现原理

Nginx的负载均衡处理流程如下:

客户端 → DNS解析(域名→Nginx IP) → Nginx服务器

→ URL匹配与负载均衡算法 → 选择后端服务器

→ 代理请求至后端 → 后端处理并返回结果

→ Nginx返回给客户端关键技术点:

- 反向代理:Nginx作为中间层接收客户端请求

- 健康检查:自动检测后端服务器状态(需第三方模块或Nginx Plus)

- 连接复用:通过upstream keepalive优化性能

- 协议支持:HTTP、HTTPS、FastCGI、uwsgi、SCGI、memcached、gRPC

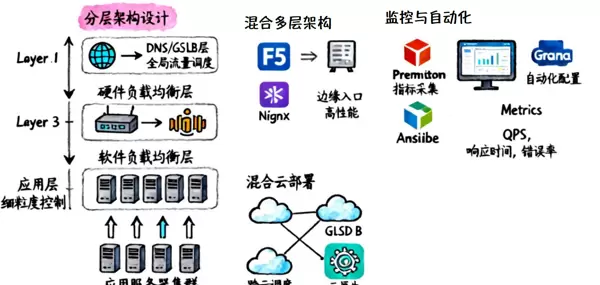

最佳实践与架构建议

1. 分层架构设计

在实际生产环境中,单一负载均衡方案往往难以满足所有需求,建议采用分层架构:

三层负载均衡架构:

[DNS/GSLB层] - 全局流量调度,跨地域容灾

↓

[硬件负载均衡层] - 边缘入口,高性能四层转发

↓

[软件负载均衡层] - 应用层负载均衡,细粒度控制

↓

[应用服务器集群]架构优势:

- 高可用性:多层冗余,单点故障影响范围小

- 性能优化:各层发挥所长,硬件处理大流量,软件实现复杂逻辑

- 灵活扩展:软件层易于横向扩展,硬件层保障性能基线

- 成本均衡:核心节点使用硬件,边缘节点使用软件

2. 混合云部署策略

随着混合云架构的普及,负载均衡需要跨越公有云、私有云和IDC:

推荐方案:

- GSLB:实现跨云流量调度和智能路由

- 云负载均衡服务:使用云厂商提供的ALB/NLB服务

- 自建Nginx集群:处理内部微服务间流量

配置示例(Nginx跨云代理):

upstream cloud_a {

server 10.1.1.1:80; # 云A的服务器

server 10.1.1.2:80;

}

upstream cloud_b {

server 10.2.1.1:80; # 云B的服务器

server 10.2.1.2:80;

}

server {

listen 80;

# 基于URL路径路由

location /api/v1/ {

proxy_pass http://cloud_a;

}

location /api/v2/ {

proxy_pass http://cloud_b;

}

}3. 监控与自动化运维

负载均衡系统需要完善的监控和自动化能力:

监控指标:

- 性能指标:QPS、响应时间、连接数、带宽

- 健康指标:后端服务器存活率、错误率

- 资源指标:CPU、内存、网络I/O

工具链推荐:

- Prometheus + Grafana:指标采集与可视化

- Ansible/Terraform:配置自动化部署

- Consul/Etcd:服务发现与配置中心

- ELK Stack:日志分析与问题排查

4. 容量规划与性能调优

容量规划需要注意以下几点:

- 冗余设计

- 分级保障(区分核心业务和边缘业务)

- 弹性伸缩(弹性扩缩容)

在实际部署中,没有一劳永逸的方案,而应采用分层架构和组合策略,充分发挥不同负载均衡技术的优势。通过硬件保障性能基线,软件提供灵活性,DNS/GSLB实现全局调度,最终构建一个高可用、高性能、易扩展的负载均衡体系,这是支撑现代分布式系统的最佳实践。

相关对比

在选择负载均衡方案时,还需要考虑以下几个方面的对比:

| 特性 | 传统方案 | Nginx方案 |

|---|---|---|

| 配置复杂度 | 需专业工程师,配置复杂,调试周期长 | Web界面或配置文件,部署快速,易于管理 |

| 扩展性 | 垂直扩展为主,横向扩展需增购设备 | 水平扩展灵活,可快速增加节点 |

| 灵活性 | 配置相对固化,调整周期长 | 配置灵活,支持热更新和快速迭代 |

| 维护成本 | 厂商技术支持,维保费用高 | 社区支持或自主运维,成本可控 |

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号