PART 01 - 技术演进:从传统程序到AI智能体

传统软件系统的局限性 传统程序本质上是“被动执行者”,依赖预设规则运行,难以应对动态变化。以温控系统为例:当温度低于18°C时启动加热,达到设定值后关闭。这种硬编码逻辑在复杂环境中暴露出三大缺陷:- 适应性差:面对突发情况(如窗户开启导致热量流失),系统仍按原逻辑运行,造成能源浪费。

- 缺乏记忆:每次决策仅基于当前输入,无法利用历史数据进行优化。

- 目标单一:无法处理多目标冲突,例如同时兼顾室温舒适度与能耗最小化。

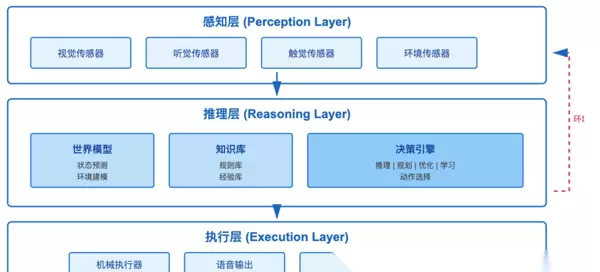

环境(Environment) → 传感器(Sensors) → 感知(Percepts) →- 感知层:借助摄像头、麦克风、传感器等多模态设备持续采集环境信息。

- 推理层:结合实时感知数据与内部模型进行分析与决策。

- 执行层:通过执行器将决策转化为具体动作(如移动、输出指令)。

- 反馈机制:动作改变环境状态,形成新的感知输入,构成动态闭环。

- 实时感知外部环境变化

- 根据当前与历史状态做出动态决策

- 从交互结果中不断优化策略,实现持续进化

- 智能程度:从条件反射式反应到具备自主学习能力

- 内部状态维护:是否拥有世界模型或历史记忆

- 决策方式:基于规则、目标驱动或效用最大化原则

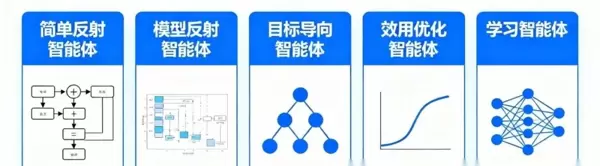

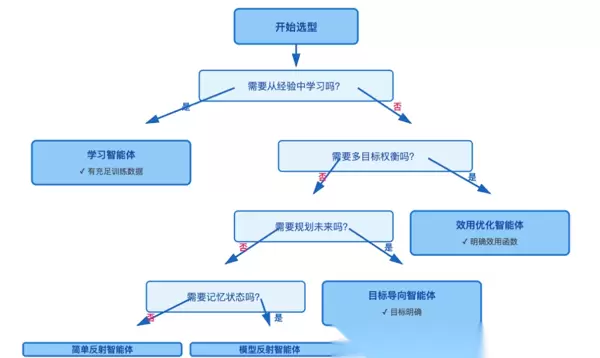

PART 02 - 五大智能体类型详解

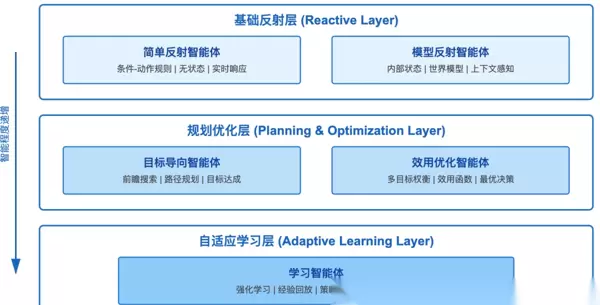

整体技术架构概览 五种智能体类型形成清晰的能力阶梯,如下图所示:

- 基础反射层:包含简单反射与模型反射智能体,支持快速响应与基本状态记忆

- 规划优化层:涵盖目标导向与效用优化智能体,可进行路径规划与多目标权衡

- 自适应学习层:指学习智能体,能通过经验积累实现策略迭代与行为进化

关键技术特征:

关键技术特征:

- 无状态设计:不保存任何历史信息

- 即时响应:决策延迟通常在毫秒级别

- 规则驱动:遵循“If 温度<18°C Then 启动加热”这类明确规则

- 确定性行为:相同输入必然产生相同输出

核心改进点:

核心改进点:

- 内部状态记录:保存“当前位置”、“已执行操作”等信息

- 构建世界模型:理解环境随时间的变化规律

- 建立动作模型:预测自身行为可能引发的结果

- 已清扫区域地图

- 障碍物分布记录

- 剩余电量与当前位置

| 对比维度 | 简单反射智能体 | 模型反射智能体 |

|---|---|---|

| 状态记忆 | 无 | 有,维护内部状态 |

| 环境理解 | 仅基于当前感知 | 结合历史与模型推断 |

| 决策灵活性 | 固定规则匹配 | 可根据上下文调整行为 |

| 适用场景 | 静态、结构化环境 | 部分可观测、动态环境 |

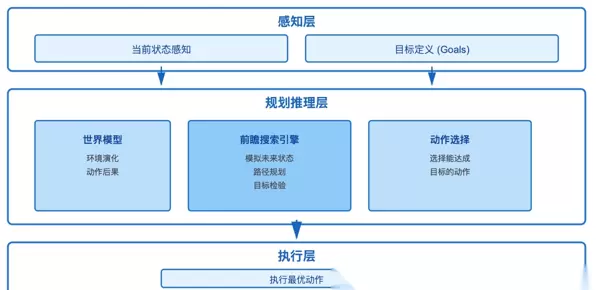

类型三:目标导向智能体(Goal-Based Agent)

决策逻辑的演进:

从“条件触发动作”转变为“预测未来结果并选择最优路径”。

核心机制包括:

- 目标定义:如“抵达地点X”或“完成任务Y”

- 前瞻搜索:模拟多个连续动作可能带来的后果

- 目标检验:判断某一未来状态是否符合预设目标

以自动驾驶为例:

目标设定:安全抵达目的地X

当前情境:位于主干道,车速为60km/h

可选行为:左转、直行、右转

未来状态预测:

- 左转 → 进入高速公路 → 预计30分钟后到达X

- 直行 → 继续沿主街行驶 → 预计45分钟后到达X

- 右转 → 偏离预定路线 → 无法抵达X

最终决策:选择左转——因其耗时最短且满足目标要求。

与模型反射型智能体的关键差异:

- 模型反射型关注“当前应采取什么行动”,属于被动响应

- 目标导向型则思考“为实现目标应如何行动”,具有主动性

此类智能体具备基本的规划能力,能够在短期代价较高的情况下,换取长期目标的达成。

类型四:效用导向智能体(Utility-Based Agent)

优化维度升级:

不再局限于“能否达成目标”,而是进一步追问“哪种方式更优”。

效用函数的设计是关键环节:

# 无人机送货效用函数示例实际应用示例——无人机配送系统需在以下多方面进行权衡:

- 速度:影响客户满意度

- 能耗:受限于电池续航

- 安全:需避开人口密集区域

- 天气因素:规避强风或恶劣气象区

对比分析:

- 目标导向智能体会选择任何可以成功送达的路径

- 效用导向智能体则会评估所有可行路径,并选出综合评分最高的方案——即使稍慢,但更节能、更安全

典型决策差异如下表所示:

| 智能体类型 | 送货路径选择逻辑 |

|---|---|

| 目标导向 | 只要能送达即可 |

| 效用导向 | 在时间、能耗、安全性之间取得最佳平衡 |

面临的技术挑战包括:

- 效用函数设计依赖领域专家经验

- 多目标权重调整需大量实验验证

- 计算复杂度随状态空间扩大呈指数级增长

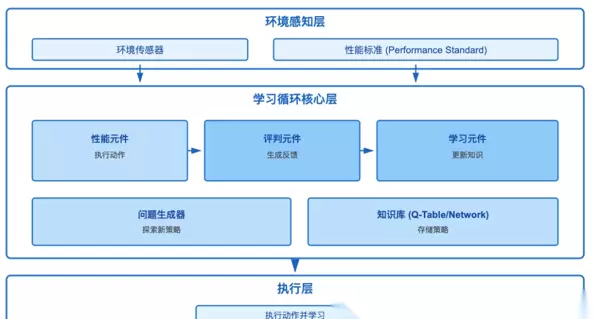

类型五:学习智能体(Learning Agent)

架构上的根本变革:

其系统由四大核心模块构成:

- 性能元件(Performance Element)

职责:依据现有知识做出动作决策

类比:棋手根据已掌握策略落子

- 评判元件(Critic)

职责:观察行为结果,对照标准生成反馈信号

输出形式:数值化奖励(例如+10表示良好,-5表示不佳)

类比:教练对棋手表现进行评价

- 学习元件(Learning Element)

职责:基于反馈信息更新内部知识库

常用方法:强化学习、深度学习、进化算法等

类比:棋手通过复盘改进战术

- 问题生成器(Problem Generator)

职责:建议尝试新的、未探索过的动作

探索策略:ε-greedy、上置信界算法(UCB)等

类比:教练鼓励尝试新颖开局

典型案例分析——AlphaGo:

- 性能元件:在当前棋局中决定落子位置的神经网络

- 评判元件:根据对弈结果给出奖励信号(胜+1,负-1)

- 学习元件:通过数百万次自我对弈不断优化策略网络参数

- 问题生成器:引入随机扰动,探索非传统下法,促进创新策略发现

关键突破:实现了从零基础起步到超越人类顶尖水平的完全自主学习过程。

技术实现框架如下:

# Q-Learning学习智能体简化实现class QLearningAgent: def不同学习范式的对比:

| 学习类型 | 数据来源 | 典型算法 | 应用场景 |

|---|---|---|---|

| 监督学习 | 标注样本 | 神经网络、决策树 | 图像分类、语音识别 |

| 强化学习 | 环境反馈 | Q-Learning、PPO | 游戏AI、机器人控制 |

| 无监督学习 | 无标注数据 | K-Means、自编码器 | 异常检测、数据聚类 |

主要局限性:

- 数据需求高:依赖大规模交互数据

- 训练周期长:如AlphaGo需数月训练时间

- 泛化能力有限:面对未见过的环境可能出现失效

- 安全风险:探索过程中可能产生危险行为

PART 03 - 智能体技术架构深度解析

感知—推理—执行闭环结构

现代人工智能智能体普遍采用标准化的三层架构,该设计融合了控制论与认知科学的思想。

各层功能划分如下:

感知层

- 实现多模态数据融合

- 原始信号采集:涵盖图像、声音、温度、位置等信息

- 特征提取:如边缘检测、语音识别、异常模式识别

- 数据预处理:包括降噪、归一化、时序对齐等操作

- 常用技术栈:OpenCV、Librosa、各类传感器驱动程序

推理层

- 负责知识推理与决策制定

- 世界建模:如SLAM地图构建、物理环境仿真

- 知识表达方式:知识图谱、规则库、神经网络等

- 决策算法:搜索算法、优化方法、概率推理技术

- 主流工具:TensorFlow、PyTorch、规则引擎系统

执行层

- 生成具体动作并实施控制

- 动作规划:路径规划、任务分解

- 运动控制:PID调节、力反馈机制

- 多执行器协调:同步调度、冲突消解

- 常用平台:ROS、专用运动控制库

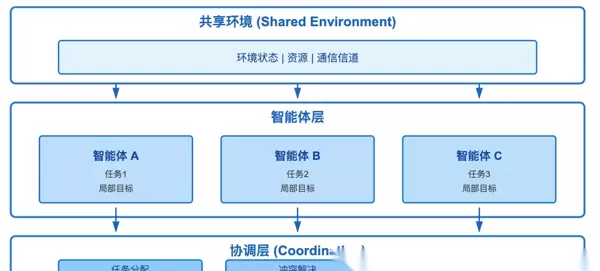

从单智能体到多智能体系统(MAS)

当多个智能体在共享环境中协同运行时,系统的整体复杂性显著上升。

常见的协作模式包括:

| 模式 | 特征 | 应用案例 |

|---|---|---|

| 竞争型 | 零和博弈,一方获益即另一方受损 | 对抗性游戏AI |

| 合作型 | 拥有共同目标,信息完全共享 | 仓库机器人群体作业 |

| 协同型 | 部分合作、部分竞争 | 自动驾驶车队协同行驶 |

典型应用场景:仓库机器人协同拣货系统

场景描述:20台机器人在同一仓库内执行订单拣选任务

面临挑战:

- 路径冲突:多台机器人同时请求通过狭窄通道

- 任务分配:如何高效匹配机器人与订单

- 充电调度:避免集中断电导致停机

解决方案:

- 中央调度器:负责全局路径规划,避免碰撞

- 拍卖机制:机器人通过竞价获取任务,提升效率

- 预测性充电策略:根据任务量预测电量消耗,提前安排充电

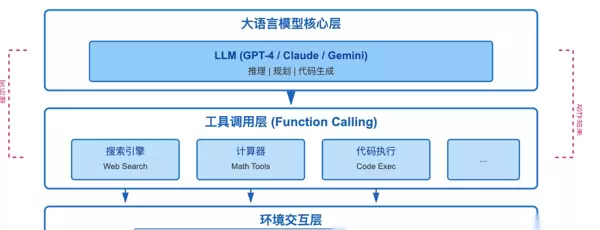

与生成式AI的深度融合趋势

2025年最具前景的发展方向之一:将大语言模型(LLM)作为智能体的“认知中枢”

LLM驱动的智能体架构正逐步成为新一代智能系统的核心范式。

技术突破:大模型智能体的核心能力

推理能力:通过思维链(Chain-of-Thought)机制,实现多步骤复杂逻辑推理,提升决策准确性。

工具使用:大语言模型具备调用外部API与专用工具的能力,扩展功能边界。

自然交互:支持用户以自然语言直接下达指令,无需编程即可驱动智能体完成任务。

快速适应:借助Few-shot Learning技术,能够在少量示例下迅速掌握新任务。

AutoGPT类智能体工作流程解析

- 目标输入:用户提出明确目标,例如“调研竞品并生成分析报告”。

- 任务分解:由LLM自动拆解为多个子任务:

- 子任务1:搜索竞品信息

- 子任务2:提取关键数据

- 子任务3:进行对比分析

- 子任务4:生成最终报告

- 自主执行:依次调用搜索API、数据提取工具、内部推理模块及文档生成工具,全流程自动化运行。

- 结果验证与优化:对输出结果进行评估,并根据反馈迭代改进,确保质量稳定可靠。

《2025最新大模型全套学习资源》PART 04 - 技术选型与对比分析

五大智能体类型选型决策树

性能对比矩阵

| 维度 | 简单反射 | 模型反射 | 目标导向 | 效用优化 | 学习智能体 |

|---|---|---|---|---|---|

| 响应延迟 | <1ms | <10ms | 10-100ms | 100ms-1s | 变化大 |

| 内存占用 | 极小(<1MB) | 小(1-10MB) | 中(10-100MB) | 大(100MB-1GB) | 极大(>1GB) |

| 适应性 | 无 | 低 | 中 | 中 | 高 |

| 可解释性 | 高 | 高 | 中 | 低 | 极低 |

| 开发成本 | 低 | 中 | 中高 | 高 | 极高 |

| 维护成本 | 低 | 中 | 中 | 中高 | 高 |

AI时代下的职业发展方向

当前,大模型技术正深刻改变就业市场格局。从ChatGPT、DeepSeek等通用助手,到自然语言处理、计算机视觉和多模态融合应用,技术的普惠化、场景的垂直化以及生态的开源化趋势正在催生一批新兴岗位。

包括但不限于:Prompt工程师、自然语言处理工程师、计算机视觉工程师、大模型算法工程师、AI应用产品经理等,已成为高增长潜力的职业方向。

由于篇幅有限,有需要的小伙伴可以扫码获取!普通人如何抓住大模型发展机遇?

AI技术的广泛应用对个体能力提出了更高要求。无论是企业组织还是个人发展,持续学习新技术、构建与AI协同工作的能力,已成为应对未来职场变化的关键。

为此,我们系统整理了一套完整的学习资源包,涵盖成长路径规划、理论书籍、视频课程、实战项目、行业研究报告及面试准备内容,助力零基础学员逐步进阶至精通水平。

1. 成长路线图与学习规划

初学者在进入大模型领域时,必须首先明确学习路径。方向错误将导致事倍功半。本资料提供详尽的成长路线图,适用于新手入门及专业人士进阶提升。

2. 大模型经典PDF书籍推荐

精选由业内权威专家撰写的高质量电子书与技术文档,内容覆盖Transformer架构、预训练机制、微调策略等核心主题,帮助建立扎实的理论体系。

所有书籍均提供PDF电子版本,便于随时查阅学习。

3. 大模型视频教程资源

针对自学困难或缺乏基础的学习者,纯文字资料可能难以理解。因此配套提供了大量可视化视频教程,通过生动演示讲解复杂概念,显著降低学习门槛。

4. 大模型项目实战训练

“学以致用”是掌握技能的核心原则。当理论积累达到一定程度后,需通过真实项目实践来检验所学知识,强化动手能力,同时为求职和职业转型积累项目经验。

5. 大模型行业趋势报告

深入分析金融、制造、医疗等多个行业的大模型应用现状与发展前景,帮助学习者识别最具潜力的应用场景,把握技术落地的关键机会点。

6. 大模型面试题库精编

面试不仅是技术实力的体现,也依赖充分准备。资料中包含精心整理的高频面试题集,覆盖算法原理、工程实现、模型优化等多个维度,助你在求职过程中脱颖而出。

为何AI大模型成为学习热点?

随着人工智能技术演进,企业用人标准已从单一技术背景转向“AI+行业”的复合型人才需求。如“金融+AI”、“制造+AI”、“医疗+AI”等跨界岗位薪资普遍上涨30%-50%。

与此同时,传统岗位面临压缩风险,近期科技巨头如英特尔宣布裁员两万人,凸显出转型AI领域的紧迫性。掌握大模型技术已成为职业发展的战略性选择。

资料专业性说明

本套学习资料由资深AI专家鲁为民博士主导研发。鲁博士毕业于清华大学本科,并获得美国加州理工学院博士学位,现任上海殷泊信息科技CEO。其创立的MoPaaS云平台荣获Forrester全球“强劲表现者”认证,服务客户涵盖航天科工、国家电网等千余家企业。

鲁博士以第一作者身份在IEEE Transactions发表论文50余篇,拥有NASA JPL火星探测系统强化学习专利在内的中美专利共35项,并荣获吴文俊人工智能奖。

课程内容由清华大学-加州理工双料博士领衔设计,覆盖从入门到高级的完整知识体系,适合不同基础的学习者全面提升技术水平与职业竞争力。

微信扫描下方CSDN官方认证二维码,免费领取【确保完全免费】

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号