在大语言模型(LLMs)迅猛发展的背景下,构建多模态 AGI 系统已成为人工智能领域的重要研究方向。然而,作为其关键环节的视觉与视觉语言基础模型,发展速度明显落后于 LLMs。由上海 AI 实验室联合多家高校提出的 InternVL 模型,通过规模化视觉编码器与大语言模型的高效对齐,有效弥补了这一技术差距。

在大语言模型(LLMs)迅猛发展的背景下,构建多模态 AGI 系统已成为人工智能领域的重要研究方向。然而,作为其关键环节的视觉与视觉语言基础模型,发展速度明显落后于 LLMs。由上海 AI 实验室联合多家高校提出的 InternVL 模型,通过规模化视觉编码器与大语言模型的高效对齐,有效弥补了这一技术差距。

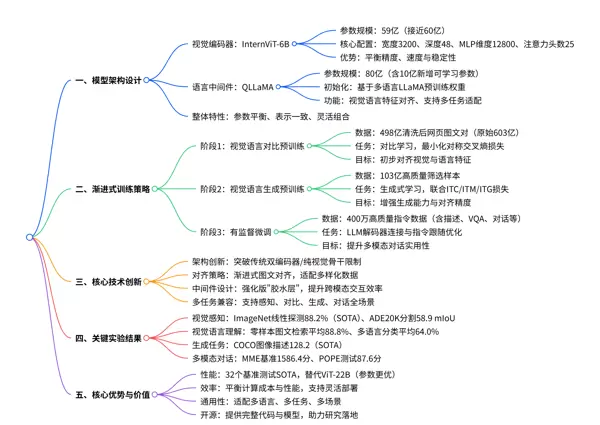

一、研究背景与核心挑战

1.1 多模态模型的发展瓶颈

尽管大语言模型凭借千亿级参数和强大的自然语言理解能力推动了通用人工智能的进程,但当前视觉大语言模型(VLLMs)中的底层视觉与视觉语言模块仍存在显著短板:- 参数规模失衡:主流 VLLM 所采用的视觉编码器通常仅有约 10 亿参数,远低于千亿级别 LLM 的容量,导致语言侧的强大能力难以被充分激发。

- 表示空间不一致:大多数视觉模型基于纯视觉数据或 BERT 类架构训练,其特征空间与 LLM 存在本质差异,阻碍了跨模态信息融合。

- 连接机制效率低下:现有方法常使用轻量级“胶水层”(如 QFormer 或线性投影)连接视觉与语言模块,无法有效建模复杂的跨模态交互关系。

1.2 核心目标设定

针对上述问题,InternVL 致力于打造一个具备以下特性的大规模视觉语言基础模型:- 提升视觉编码器参数规模,实现与 LLM 的参数平衡;

- 建立统一且高效的视觉-语言特征对齐机制;

- 设计支持对比学习与生成式学习的通用架构;

- 在多种视觉语言任务上达到 SOTA 表现。

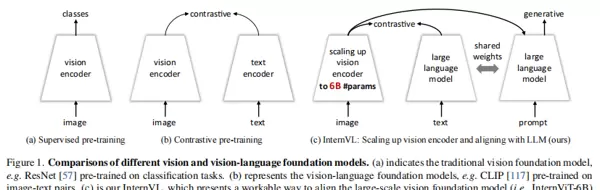

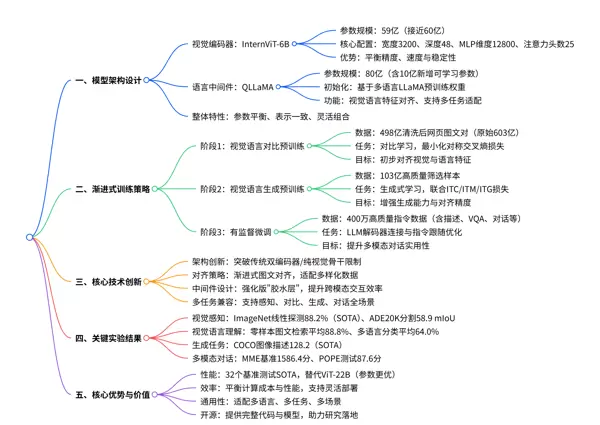

二、模型架构创新

InternVL 提出了一种新颖的“视觉编码器 + 语言中间件”结构,突破了传统双编码器或单一骨干网络的设计局限。2.1 整体架构概述

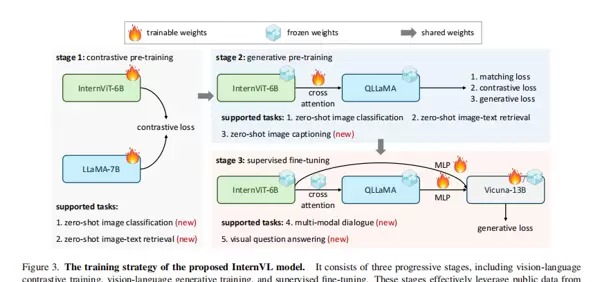

如图所示,InternVL 具备三大关键技术设计:

如图所示,InternVL 具备三大关键技术设计:

- 参数均衡的组件配置:配备 60 亿参数的视觉编码器(InternViT-6B)与 80 亿参数的语言中间件(QLLaMA),后者作为增强型“连接器”,可根据用户指令动态重组视觉特征。

- 统一的表示空间:语言中间件采用预训练多语言 LLaMA 初始化,确保其与 LLM 的语义空间高度兼容。

- 渐进式图文对齐策略:结合大规模噪声图文数据的对比学习与高质量样本的生成式训练,兼顾稳定性与性能提升。

2.2 关键模块详解

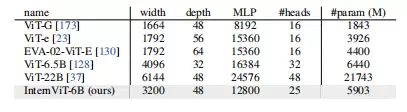

2.2.1 大规模视觉编码器 —— InternViT-6B

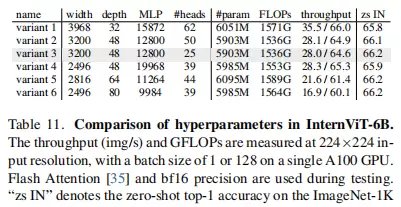

基于标准 ViT 架构,通过系统性超参数调优,在性能与计算效率之间取得平衡:- 参数总量:59 亿(接近 60 亿)

- 主要配置:宽度 3200、深度 48 层、MLP 维度 12800、注意力头数 25

- 优化方式:综合测试不同深度(32/48/64/80)、头维度(64/128)及 MLP 比例(4/8)组合,筛选出最优稳定结构

表 1 对比了 InternViT-6B 与其他主流视觉模型的架构特性。尽管其参数量远小于 ViT-22B,但凭借精细设计实现了更优的性能-效率权衡。

表 1 对比了 InternViT-6B 与其他主流视觉模型的架构特性。尽管其参数量远小于 ViT-22B,但凭借精细设计实现了更优的性能-效率权衡。

2.2.2 语言中间件 —— QLLaMA

以多语言增强版 LLaMA 为基础构建,承担视觉与语言模态之间的桥梁作用:- 总参数:80 亿,包含新增的 96 个可学习查询向量和跨注意力层(贡献约 10 亿参数)

- 核心优势包括:

- 利用预训练 LLaMA 权重初始化,天然契合 LLM 的表示体系;

- 参数规模达 QFormer 的 42 倍,无需微调 LLM 即可实现优异对话表现;

- 同时兼容对比学习与生成式学习任务,提升模型泛化能力。

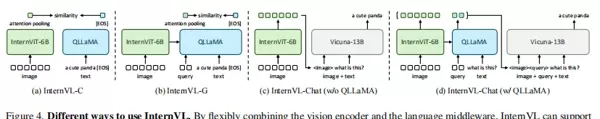

2.2.3 灵活多用的“瑞士军刀”模式

通过灵活组合视觉编码器与语言中间件,InternVL 可适配多种应用场景:- 视觉感知任务:直接将 InternViT-6B 作为骨干网络使用;

- 对比类任务(如图文检索):可选择 InternVL-C(仅视觉编码器)或 InternVL-G(加入 QLLaMA)模式;

- 生成类任务(如图像描述):借助 QLLaMA 的查询机制重构视觉特征,驱动文本生成;

- 多模态对话系统:通过 InternVL-Chat 接入 LLM 解码器,支持是否启用 QLLaMA 的两种配置。

如图 4 所示,不同模块组合可覆盖图文检索、内容生成与多轮对话等多种任务场景,展现出极强的通用性与扩展潜力。

如图 4 所示,不同模块组合可覆盖图文检索、内容生成与多轮对话等多种任务场景,展现出极强的通用性与扩展潜力。

三、渐进式训练策略

为高效利用多样化数据并保障训练稳定性,InternVL 设计了三阶段渐进式训练流程。3.1 训练流程概览

整体训练分为以下三个阶段:

整体训练分为以下三个阶段:

- 第一阶段:视觉语言对比预训练

- 数据来源:603 亿网页图文对,经清洗后保留 498 亿对(见表 2)

- 训练任务:执行对比学习,最小化图像-文本对的对称交叉熵损失

- 目标定位:完成视觉与语言特征的初步对齐,支撑零样本分类与检索等任务

- 第二阶段:视觉语言生成预训练

- 数据类型:精选高质量图文对与合成描述数据

- 训练方式:采用自回归生成目标,强化模型的语言生成能力

- 功能升级:进一步拉通视觉理解与自然语言表达,提升生成质量

- 第三阶段:下游任务微调

- 任务范围:涵盖 VQA、图像描述、多模态对话等具体应用

- 优化重点:针对特定任务进行端到端微调,释放模型全部潜力

三、训练策略与数据构建

第三阶段:有监督微调

- 数据:使用 400 万条高质量指令数据,覆盖图像描述生成、视觉问答(VQA)、多轮对话等多种任务类型(见表 3)

- 任务:连接 LLM 解码器(如 Vicuna-7B/13B),进行指令遵循能力的精细化微调

- 目标:提升模型在多模态对话场景下的表现力与实用性,增强对真实应用环境的适配能力

第一至第二阶段:生成式预训练

- 数据:从初始大规模数据集中筛选出 103 亿高质量图文样本

- 任务:采用 ITC(图文对比)、ITM(图文匹配)与 ITG(图像引导文本生成)联合损失函数进行生成式学习

- 目标:强化模型的跨模态生成能力,提升视觉与语言特征之间的对齐精度

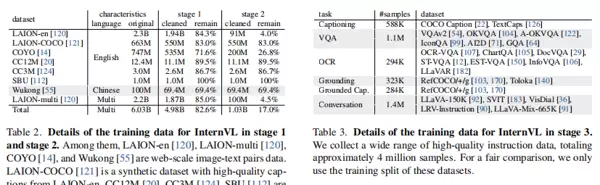

3.2 训练数据详述

阶段 1&2 数据统计(表2)

展示了前两个阶段中数据筛选的过程与规模变化。通过逐级提升数据质量,确保模型能够平稳地从基础视觉特征学习过渡到复杂的多模态理解与生成能力培养。

阶段 3 微调数据统计(表3)

呈现了用于指令微调的数据分布情况,涵盖多种视觉语言任务,有效保障了模型在多样化应用场景中的通用性与实用价值。

3.3 关键训练配置

表 4 汇总了前两阶段的核心训练参数设置,包括学习率调度策略、批次大小以及硬件资源分配方案。合理的配置设计支持了大规模模型的高效稳定训练。

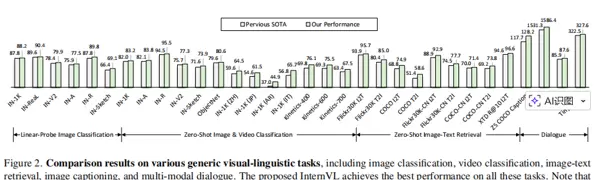

四、实验结果分析

InternVL 在共计 32 个通用视觉语言基准测试上均取得当前最优(SOTA)性能,全面覆盖视觉感知、跨模态理解与生成、视频处理及多模态对话等多个维度。

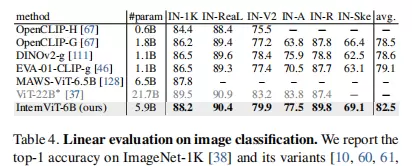

4.1 视觉感知能力评估

4.1.1 图像分类(线性探测)

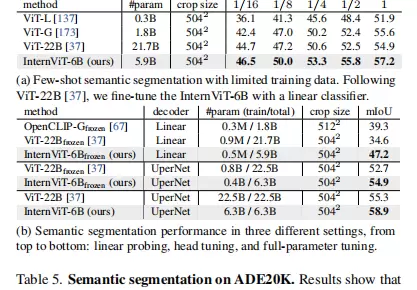

如表 5a 所示,在 ImageNet 及其变体数据集上的线性探测实验中,InternViT-6B 表现出卓越的视觉表征能力。即便未使用私有 JFT 数据集,其性能仍接近 ViT-22B 水平,展现出强大的特征提取潜力。

4.1.2 语义分割

在 ADE20K 数据集上的语义分割任务中(表 5b):

- 在线性探测设定下,InternViT-6B 实现 47.2 mIoU,比 ViT-22B 高出 12.6 mIoU

- 在全参数微调模式下,达到 58.9 mIoU,优于 ViT-22B 的 55.3 mIoU

- 在少样本学习场景中,不同训练比例下均优于 ViT-22B,表明其具备出色的泛化能力

4.2 视觉语言理解性能

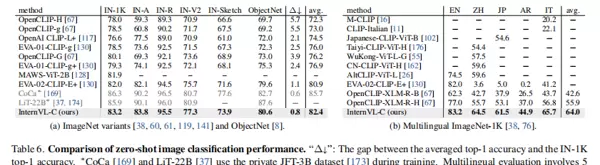

4.2.1 零样本图像分类

表 6a 显示,InternVL-C 在多个 ImageNet 变体上实现领先性能,尤其在面对分布偏移时表现出更强的鲁棒性。此外,在多语言图像分类任务中(表 6b),该模型在英语、中文、日语等五种语言上的平均准确率达到 64.0%,显著超越现有主流多语言模型。

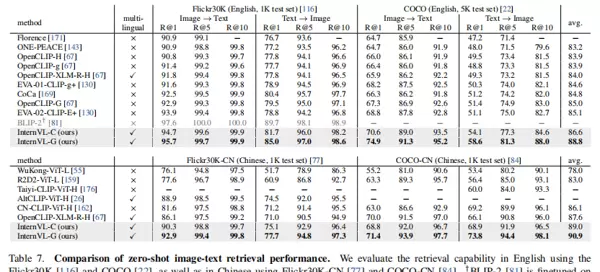

4.2.2 零样本图文检索

如表 7 所示,InternVL 在中英文双向图文检索任务中均达到 SOTA 水平。其中,InternVL-G 引入 QLLaMA 后进一步提升了匹配精度,平均性能达 88.8%,验证了渐进式训练策略的有效性。

4.3 视觉语言生成能力

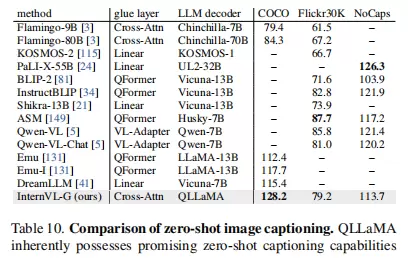

4.3.1 零样本图像描述生成

根据表 10 结果,InternVL-G 在 COCO 数据集上的零样本图像描述得分为 128.2,大幅领先现有方法;同时在 Flickr30K 和 NoCaps 上也表现优异,充分体现了其强大的生成能力。

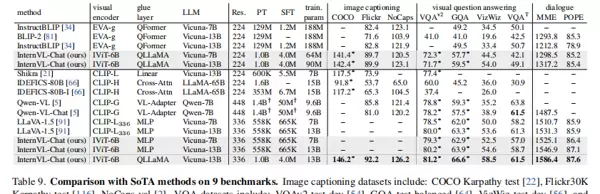

4.4 多模态对话性能

如表 9 所示,InternVL-Chat 在多模态对话任务中表现突出:

- MME 基准测试得分 1586.4

- POPE 测试得分 87.6

综合性能超越当前主流视觉大语言模型(VLLM),且在训练过程中展现出更高的参数利用效率。

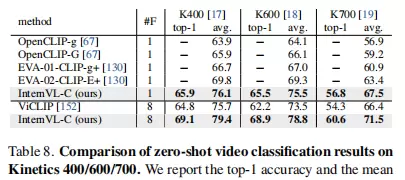

4.5 视频相关任务表现

表 8 展示了 InternVL-C 在视频分类任务中的性能:

- 单帧输入设置下,平均准确率超过 EVA-02-CLIP-E+ 4–6 个百分点

- 使用 8 帧输入时性能进一步提升

表明模型对动态视频内容具有良好的建模与泛化能力。

五、消融实验与深入分析

5.1 超参数影响研究

表 11 显示,在相近参数量条件下,模型深度和注意力头数对最终精度影响较小,但显著影响推理吞吐量。最终选定的 variant 3 在准确性、运行速度与训练稳定性之间实现了最佳权衡。

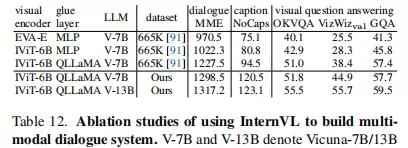

5.2 特征表示一致性探究

表 12 对比显示,InternViT-6B 相较于 EVA-E 具备更优的特征兼容性;而引入 QLLaMA 作为跨模态“胶水层”后,所有下游任务性能均获得明显提升,证明其在促进视觉-语言特征对齐方面的有效性。

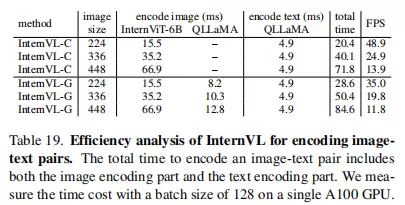

5.3 计算效率分析

如表 19 所示,InternVL 在维持高性能的同时具备合理的计算开销。图像编码为主要耗时环节;相比 InternVL-C,InternVL-G 仅带来轻微计算成本增加,但性能显著跃升,为实际部署提供了灵活的选择空间。

六、核心贡献与创新点总结

6.1 模型架构创新

- 提出“大规模视觉编码器 + 语言中间件”新范式,首次成功实现 60 亿参数级别视觉编码器与大型语言模型(LLM)的高效对齐

- 设计通用型网络结构,统一支持对比学习与生成式学习,适用于广泛的视觉语言任务

6.2 训练策略创新

- 构建分阶段渐进式训练流程,结合高质量样本筛选机制,实现从基础特征学习到高级语义理解的平滑演进

- 融合 ITC、ITM 与 ITG 多项损失函数,协同优化跨模态表示与生成能力

六、性能突破

在32项视觉语言基准测试中,InternVL实现了SOTA(当前最优)表现,覆盖感知、理解、生成以及对话等多个任务维度。通过引入ViT-22B的高效替代方案,模型在参数量仅为前者的四分之一的情况下,仍能达到相当甚至更优的性能水平,显著提升了计算资源利用效率。

提出了一种渐进式图文对齐策略,能够有效融合大规模含噪声数据与高精度标注数据,在保障训练稳定性的前提下充分挖掘不同质量数据的价值,实现性能与鲁棒性的平衡。

采用多阶段训练范式,依次经历对比学习、生成式学习,最终进行指令微调。该流程逐步增强模型的多模态理解与表达能力,使模型从基础特征对齐过渡到复杂语义推理和自然语言生成,系统性地提升整体性能。

七、总结与展望

InternVL通过规模化视觉编码器设计、创新的语言中间件结构以及渐进式训练机制,成功构建了一个高性能且通用的视觉语言基础模型,有效缩小了先进视觉模型与大语言模型之间的协同鸿沟。其核心优势体现在:参数配置均衡的网络架构、统一的跨模态特征表示空间,以及面向多样化任务的灵活适配能力,为通往多模态通用人工智能(AGI)提供了坚实的技术路径。

未来的研究方向包括:

- 进一步扩展模型规模,探索更大参数量视觉编码器的性能极限

- 优化训练过程中的计算效率,降低大规模模型的资源消耗

- 拓展对更多模态的支持,例如音频信号、3D点云数据等

- 开展面向特定领域(如医疗影像分析、自动驾驶感知等)的微调与应用研究

InternVL已在其GitHub平台开源发布,为学术界和工业界在视觉语言模型方面的研究与实践提供了重要参考,有望加速推动多模态技术的持续演进与实际场景落地。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号