一、引言:从“模型”到“智能体”,落地才是关键挑战

近两年来,大语言模型已由技术圈内的前沿探索,迅速演变为大众日常接触的基础能力。无论是智能客服、写作辅助、代码生成,还是搜索优化与办公自动化,几乎所有数字化场景都在经历重构。

然而,真正参与过企业级AI项目的人清楚地知道:

尽管大模型本身具备强大能力,但将其转化为可复用、可观测、可评估且易于运维的「智能体及业务工作流」,才是真正难点所在。

当前企业和开发者普遍面临以下问题:

- 仅能“聊天”的模型难以直接构建为稳定可控的生产系统;

- 提示词(Prompt)数量庞大,但版本混乱、质量参差、难以共享复用;

- 知识库建设与维护成本高,缺乏对增量数据接入和内容质量的有效监控机制;

- 多工具、多模型、多业务系统并存,缺少统一的调度、治理与可视化管理平台;

- 不同平台之间体验割裂,无法在一个环境中实现“从数据处理到应用上线”的完整闭环。

在此背景下,

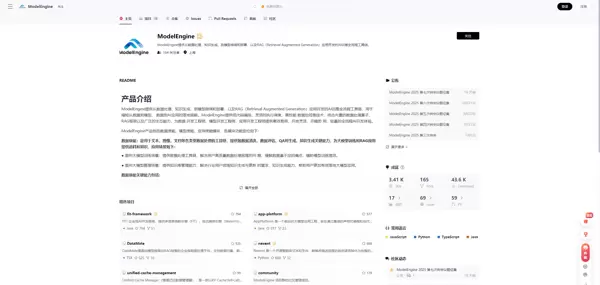

ModelEngine

作为一款覆盖“数据治理—模型训练—应用部署”全链路的AI开发平台,逐渐受到关注。它提供涵盖数据预处理、知识提取、模型微调与评测、可视化流程编排以及智能体发布的一体化工具集,旨在显著缩短“从原始数据到可用AI应用”的周期。

本文将聚焦于 ModelEngine 在智能体构建与应用流程编排方面的能力,以开发者视角深入剖析:

- 如何从零开始创建、调试并部署一个实际可用的智能体;

- 如何利用图形化界面将多个智能体功能组合成稳定、可复用的业务流程;

- 如何借助多智能体协作、插件扩展、智能表单等机制应对复杂应用场景;

- 并与 Dify、Coze、华为云 Versatile 等主流平台进行横向对比,分析各自优势与适用范围。

目标是输出一套融合了

工程方法论 + 实战经验

的切实可行的“落地实施路径”,而非停留在理论层面。

我们先来看一下 ModelEngine 的整体架构示意图:

二、实战体验:从零构建一个企业级智能办公助手

本部分将以具体案例为主线,演示在 ModelEngine 平台上如何完整搭建一个“企业内部知识型智能办公助手”。该助手需满足以下核心需求:

- 基于企业私有知识库回答员工提问;

- 自动解析新上传文档,并更新至知识库;

- 支持多轮对话、来源标注与版本追踪;

- 可根据业务反馈动态优化提示策略;

- 能够联动其他系统(如工单系统),完成“查询+任务提交”的全流程闭环。

2.1 创建智能体:从模型配置到角色定义

在 ModelEngine 中新建智能体通常包含以下几个关键环节(不同UI版本可能略有差异,但逻辑一致):

- 选择模型与调用方式:可使用平台内置的大模型服务,或通过标准API接口(如OpenAI风格)接入外部模型;在企业环境中,常采用“通用基础模型 + 领域专用模型”的混合模式。

- 设定角色与能力边界:例如定义一个“企业知识助手”,其职责包括解读公司制度与流程文件,不涉及主观判断(如绩效评定),遇到权限外问题应主动提醒用户;所有回复必须附带引用来源,包括文档名称、章节与时间戳。

- 配置运行参数:设置温度值(temperature)、最大输出长度、重复惩罚系数等;决定是否启用流式响应;是否允许调用外部函数或MCP服务等。

实践建议:

在企业级设计中,避免将单一智能体打造成“全能型选手”,而应遵循

领域聚焦 + 多智能体协同

的原则。例如:

- 一个负责知识问答;

- 一个用于结构化信息录入与校验;

- 一个专司调度各类插件或MCP服务。

这种分工模式在 ModelEngine 这类原生支持多智能体交互的平台上尤为顺畅自然。

接下来,我们参考官方提供的智能体搭建指南:

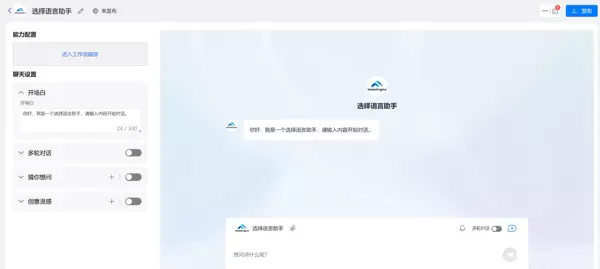

即使不具备编程背景,也能在 ModelEngine 上快速构建具备逻辑判断与交互能力的对话式AI助手。本次以“对话助手-基础编排”为例,采用AI自动生成方式,快速完成一个具备基本处理能力的智能体。

下图为最终搭建完成后的对话助手效果预览:

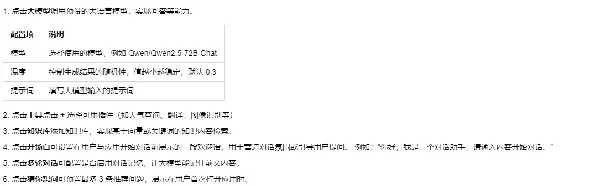

具体操作步骤如下:

步骤一:创建工作流型对话助手

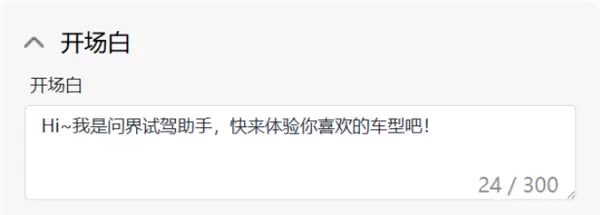

步骤二:配置基础聊天参数

步骤三:发布并上线对话助手

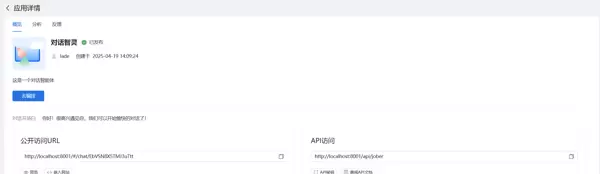

查看应用详情页面

按照上述流程操作后,一个完整的智能体即可成功上线。

2.2 构建知识库:从原始文档到结构化知识资产

要让智能体真正理解业务逻辑,关键并不在于模型本身有多强,而在于

知识的组织与语义对齐

ModelEngine 提供了一整套面向数据与知识管理的工具链,涵盖数据清洗、多模态处理算子,以及基于大模型的问答对自动生成与质量评估能力:

数据接入与清洗

- 支持多种格式文档上传(PDF、Word、Markdown等),也可对接对象存储或数据库实现自动同步;

- 内置超过50种数据处理算子,可用于文本清洗、段落切分、实体抽取、去重等操作;

- 提供数据质量评估模块,支持人工审核或自动化评分,防止低质数据输入导致“垃圾进、垃圾出”现象。

自动生成问答对(QA Pair)

利用清洗后的文本内容结合外部大模型服务,自动生成高质量问答对,可用于后续模型微调或效果评测。

支持 QA 自动评估与留用审核机制,官方披露的数据显示留用率可达 60%,显著降低人工标注所需投入的成本。

构建向量索引与 RAG 知识库

- 支持基于文本分片生成向量索引;

- 可灵活选择相似度计算方式、切片策略及窗口大小;

- 与下游应用完全解耦,通过统一的 RAG 框架进行接入。

实践建议:

优先采用增量更新:企业文档更新频繁,推荐按“目录维度 + 时间维度”实现增量式构建,提升效率。

建立分层知识结构:将基础制度、流程类内容单独成层,项目资料与常见问题(FAQ)另设一层,便于差异化设置召回与重排策略。

为知识片段附加元数据:如版本号、生效日期、文档 ID 等信息,有助于在回答时提供可追溯的引用来源。

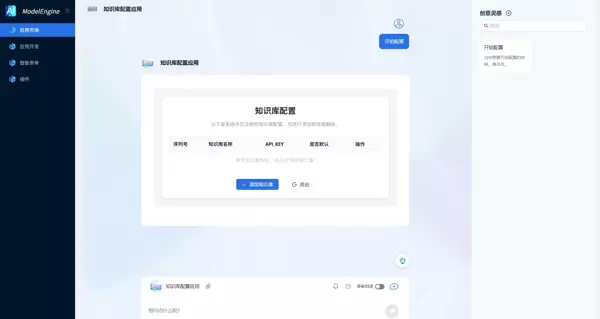

以下是知识库搭建过程中的部分截图示例:

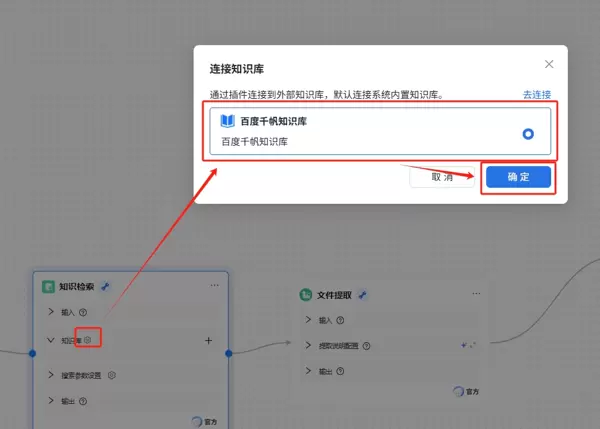

选择已配置的百度千帆 API Key,一键完成知识库授权与绑定操作。

系统支持自动同步知识库内容,并提供可视化界面用于文档管理。自定义知识库创建完成后,可在知识检索节点中选择并关联千帆平台上的对应知识库。

2.3 提示词的自动生成与迭代:从“凭感觉写 Prompt”到“数据驱动优化”

Prompt 工程已逐步演变为系统化的工作流程,不再局限于简单的文案尝试。ModelEngine 的核心优势在于,将“模型调用、知识检索、工具使用和评测数据”整合至同一流水线,支持更体系化的优化路径。

一个可行的操作流程包括:

设计基础 Prompt 模板:采用“系统提示 + 角色设定 + 能力边界 + 输出格式约束”的结构。

例如:

- 系统提示说明:你是一个企业内部的知识助手;

- 明确禁止虚构或编造公司制度;

- 要求所有回复均需附带引用来源及时间戳。

自动生成与推荐提示词:平台可根据历史对话记录和评测集,智能推荐更优的 Prompt 片段(如加入“先思考再作答,逐步推理”等指令)。随着企业使用周期延长,系统还能基于实际问答质量,生成适用于不同场景的细分 Prompt 模板。

结合离线评测与在线 AB 实验:利用评测集对各版本 Prompt 在“正确率、引用准确率、回答简洁性”等方面进行自动化评估;同时通过灰度发布,在真实用户环境中开展小流量 AB 测试,最终收敛至最优方案。

相比传统“在控制台反复修改、主观判断效果”的做法,数据驱动的 Prompt 迭代已成为企业级落地过程中不可或缺的关键环节。

2.4 智能体开发与调试:从「单轮交互」迈向「复杂任务流程」

在 ModelEngine 平台上开发智能体时,除基础对话功能外,还涵盖以下能力:

函数与工具调用(Tools/MCP):通过 MCP 协议接入外部服务,如数据库查询、工单创建、内部 API 调用等。智能体可在对话中自主判断是否需要调用工具,并将结果整合进最终响应。

多轮对话状态管理:支持会话上下文维护、会话 ID 标识、用户身份识别等功能;针对长对话场景,需合理配置上下文窗口长度与历史信息压缩策略。

调试与日志追踪:在控制台可查看每一轮调用的详细信息,包括:

- 当前使用的 Prompt 版本;

- RAG 召回的知识片段;

- MCP 服务的实际调用参数与返回结果;

- 最终模型输出内容。

这些信息对于排查“为何回答错误”或“为何未触发工具调用”等问题至关重要。

成熟的调试习惯通常包括:

开发阶段:

- 使用可视化链路追踪功能,逐层查看输入输出流转;

- 切换至“原始 JSON / 原始文本”视图,排查编码或格式异常。

试运行阶段:

- 通过日志筛选出评分低于阈值的会话;

- 重点分析其 Prompt 设计、知识检索行为及工具调用逻辑。

2.5 多智能体协作:从“独立作战”升级为“团队协同”

面对企业复杂业务需求,单一智能体难以同时胜任“知识问答、数据查询、表单填写、决策建议”等多项任务。更合理的架构是将其拆分为多个职责清晰的智能体,并由一个“上层编排器”统一调度。

在 ModelEngine 这类支持多智能体协作的平台中,可实现:

定义角色化智能体:

- 知识问答 Agent:专注于知识检索与解释;

- 业务规则 Agent:执行合规性判断;

- 工具执行 Agent:负责具体操作落地,如创建工单、修改配置;

- 审核 Agent:对关键动作进行复核并补充说明。

设定协作模式:

- 串行模式:前一个 Agent 完成处理后移交下一个;

- 并行模式:多个 Agent 同时工作,结果汇总输出;

- 竞赛模式:多个 Agent 提供解决方案,由评估 Agent 决策最优选项。

通过后续介绍的可视化应用编排方式进行统一调度。

该方案的优势在于:

- 单个智能体逻辑更聚焦,易于维护与测试;

- 与组织架构匹配度高,可邀请业务负责人参与对应 Agent 的评测与标注闭环;

- 更利于实现细粒度权限控制与操作审计。

三、应用编排创新实践:用可视化工作流连接“单项能力”形成“完整闭环”

如果说智能体是“可被调用的智能服务”,那么应用编排就是实现这些服务按业务流程协同运作的核心枢纽。

ModelEngine 在应用层面提供了可视化编排能力、声明式开发框架以及多语言插件扩展机制,旨在统一管理从毫秒级微流程到跨系统的长周期事务。

3.1 基础节点:模块化构建的抽象单元

在可视化工作流中,“节点”是最基本的构成元素,通常包含以下几类:

- 输入 / 触发节点

HTTP 请求触发、表单提交或定时任务均可作为工作流的启动方式;

此外,消息队列事件、数据库变更等异步事件也可驱动流程执行。

智能体调用节点

封装一个具体的智能体,接收上下文输入,输出回答或结构化数据;

支持配置是否保留中间执行结果,便于调试与追溯。

工具 / 插件节点

用于调用外部接口、执行脚本、访问数据库,或集成 MCP 服务;

实现与外部系统的深度联动。

控制流节点

包括条件分支、循环控制、错误处理机制以及超时重试策略;

在处理复杂业务逻辑时发挥关键作用,提升流程健壮性。

输出节点

负责最终动作的执行,如返回 HTTP 响应、写入数据库记录,或将结果推送到 IM 工具或邮箱系统。

设计建议

- 分层设计:将“智能体逻辑”与“业务编排逻辑”分离。智能体节点仅关注输入与输出,不承担路由判断职责。

- 控制集中化:条件判断和流程分支应在工作流的控制节点中完成,保持智能体职责单一。

- 复用优化:对于高频使用的子流程(例如“知识检索 → 回答生成 → 引用标注”),可封装为独立的子工作流,提升模块化程度和复用效率。

3.2 工作流开发与调试:让智能行为“可视化”

相比传统 BPM 系统或后端编码模式,可视化编排的核心优势在于——

你可以清晰地观察每一步的执行路径与运行状态。

在 ModelEngine 这类平台中,典型的工作流开发流程包括:

- 通过拖拽方式搭建流程主干;

- 为每个节点配置参数、变量映射规则及超时设置;

- 使用“单步调试”或“局部运行”功能,模拟特定输入并验证分支行为;

- 查看运行日志中的完整执行轨迹:

- 哪些节点成功执行;

- 哪个节点发生失败或超时;

- 各阶段中间变量的具体取值变化。

调试过程中需重点关注以下几点:

- 数据兼容性:例如上游智能体输出的 JSON 结构是否与下游节点期望字段匹配;

- 容错机制:所有可能出错的外部调用都应配置超时限制和备用处理路径;

- 幂等保障:确保工作流重试不会引发重复操作,如重复下单或多次通知。

3.3 自定义插件:为平台扩展专属能力

仅依赖内置节点难以覆盖全部业务需求。ModelEngine 提供了灵活的

插件扩展机制,支持使用 Java、Python 等语言开发自定义插件,并采用“热插拔”方式动态加载,使企业能将自有系统能力无缝接入 AI 工作流。

常见应用场景包括:

- 将企业核心系统(如订单管理、工单系统、CRM、ERP)的 API 封装为标准插件;

- 实现定制化的数据清洗、评分模型或聚合逻辑;

- 集成第三方服务,如飞书/钉钉机器人、告警平台等。

优秀的插件设计应遵循以下原则:

- 高内聚、低耦合:单一插件专注解决一个问题,避免嵌入过多业务分支;

- 接口稳定性:尽量维持输入输出结构不变,方便跨多个工作流复用;

- 明确的错误语义:区分“业务规则失败”、“系统异常”和“参数错误”,便于上层流程进行差异化响应。

3.4 智能表单:从自然语言到结构化交互

在许多企业场景中(如审批、报销、立项、权限申请),纯自然语言交互不足以支撑后续系统处理,仍需

结构化表单来保证数据规范性。然而手工填表效率低、用户体验差。

“智能表单”的设计理念是:

- 用户以自然语言表达诉求;

- 智能体解析其意图,并引导用户逐步补全关键字段;

- 实时校验字段合法性(如日期范围、金额上限、部门权限);

- 最终生成标准化的结构化表单并提交至下游系统。

结合 ModelEngine 的工作流能力,可实现:

- 表单字段的可视化定义与配置;

- 智能体与表单的双向交互:

- 智能体提供候选值或预填充内容;

- 用户只需确认或微调;

- 提交后自动触发后续流程,如审批流启动、工单创建等。

此类“智能表单 + 工作流”组合,已成为众多企业从“AI 演示项目”迈向“真实业务提效”的重要突破口。

四、创新应用展示:基于 ModelEngine 构建三大典型 AI 场景

为更直观呈现上述能力,以下通过三个实际场景,展示如何利用 ModelEngine 实现从零到一的完整落地。

4.1 场景一:企业知识型办公助手

目标:

为员工提供统一入口,用于查询制度规范、业务流程、模板文档及历史案例,并支持“追问 + 引用来源 + 发起后续操作”。

关键能力拆解:

- 知识库建设:整合人力资源制度、财务规定、IT 服务手册等内容;

- 借助自动 QA 对生成工具构建评测集与训练样本,持续优化问答质量;

- 智能体架构:

- 主问答 Agent:负责理解问题并执行知识检索;

- 合规检查 Agent:识别回答中是否存在过期或冲突信息,并主动提醒用户;

- 工作流编排:

- 由 HTTP 或 IM 消息触发;

- 依次调用问答 Agent 与合规 Agent;

- 返回最终答案;

- 若问题涉及“需提交工单”,则进入分支流程:

- 通过智能表单收集必要信息;

- 调用工单系统插件创建新工单;

- 将生成的工单编号回传至对话上下文中。

落地成效:

- 员工无需分散查找 Wiki 或邮件,获得一站式服务体验;

- 知识维护集中在知识库侧,不影响智能体接口稳定性;

- IT 与 HR 团队可获取高质量的问题反馈数据,反哺制度优化。

4.2 场景二:数据分析与报告生成助手

目标:

让非技术人员也能通过自然语言向数据仓库发起分析请求,并自动生成可读性强的分析报告与可视化图表。

关键能力拆解:

- 数据准备与治理:

- 利用数据处理算子对多源数据进行清洗、聚合与指标建模;

- 智能体层设计:

- 部署“分析意图理解 Agent”,将用户自然语言转化为具体分析任务;

- 例如:“按地区、按月汇总销售额,并与去年同期对比”;

构建一个“SQL 生成与校验 Agent”,能够将用户意图自动转化为结构化查询语言(SQL),并对其语法正确性与逻辑合理性进行双重校验;

同时配备一个“报告撰写 Agent”,可根据数据查询结果自动生成文字分析与结论性内容,提升信息输出效率。

工作流设计:

整体流程包括:触发请求 → 意图识别 → SQL 自动生成 → 查询执行 → 报告内容生成 → 输出为 Markdown、PDF 或 PPT 片段等多种格式。

实施关键点:

针对核心业务指标(如营收、利润等),应限制 SQL 生成 Agent 的自由发挥空间,优先采用“预定义指标模板 + 动态参数填充”的机制,确保准确性与一致性;

报告撰写 Agent 必须遵循严格的数据真实性原则,禁止虚构或推测数据,所有论述必须基于实际查询结果展开。

场景三:内容创作与营销素材自动化流水线

目标设定:

为市场运营团队打造一条覆盖“选题策划 → 大纲生成 → 多渠道文案输出 → 多版本 A/B 测试”的端到端自动化内容生产线。

核心能力分解:

输入要素:

- 市场活动基本信息:涉及产品、目标受众、预算范围、投放渠道等;

- 历史优质案例库作为参考知识源,用于增强生成质量。

智能体协同架构:

- 选题 Agent:结合活动目标与目标人群特征,输出多个创意选题方向;

- 大纲 Agent:对选定的选题自动生成文章或视频的内容框架;

- 多渠道文案 Agent:依据大纲内容,分别生成适用于微信公众号、短视频脚本、宣传海报等不同媒介形态的文本版本;

- 审稿 Agent:按照企业品牌语调和合规要求,对生成内容进行初步审核与过滤。

工作流编排策略:

通过可视化画布串联各智能体节点;

支持人工在任意关键环节介入修改与优化;

最终成果可同步至协作平台,便于团队成员共同编辑与推进。

实现价值:

将原本高度依赖个体经验的内容生产模式,升级为“半自动化流水线 + 人类创意干预”的混合协作机制;

沉淀标准化、可复用的工作流模板,助力后续营销活动快速复制与迭代。

此外,该系统还可延伸提供数据清洗与知识提取的一站式工具链,显著提升数据预处理与知识转化效率。

五、系统特性与技术优势:ModelEngine 的工程化设计亮点

在“可视化流程编排 + 智能体平台”这一技术赛道中,Dify、Coze 和华为云 Versatile 等平台均表现活跃。而 ModelEngine 的差异化在于其一体化架构设计——从底层数据处理、模型训练到上层应用流程的全链路整合,更聚焦于打造“全流程工程化 AI 平台”。

5.1 插件扩展机制:让 AI 平台成为企业系统的中枢枢纽

ModelEngine 支持多语言插件开发(如 Java、Python 等),这对已拥有大量现有业务系统的企业尤为重要:

- 可将已有功能模块(如订单查询、账单生成、审批流程启动等)封装为标准插件;

- 插件与具体工作流及智能体完全解耦,便于统一运维与治理;

- 借助“插件热插拔”机制与底座分离设计,平台可在不停机状态下持续演进与升级。

相较之下:

- Dify 更侧重于作为“大模型应用开发平台 + LLMOps 基础设施”,主要通过 RESTful API 实现外部系统对接;

- Coze 聚焦于 Bot 应用生态建设,擅长将机器人部署至社交平台(如 Telegram、抖音等),但对企业内部系统深度集成支持较弱;

- 华为云 Versatile 同样具备强大的企业级集成能力,强调多框架兼容性、MCP 服务支持以及组件化系统整合。

5.2 可视化编排与声明式开发并行:兼顾易用性与可维护性

ModelEngine 提供“图形化拖拽编排 + 声明式配置开发”的双模态能力:

- 面向产品经理或业务人员:可通过拖拽式画布快速搭建流程,实现分钟级发布;

- 面向工程师:可通过声明式配置文件定义工作流,实现版本控制、代码审查与 CI/CD 集成。

这种设计理念体现了“画布是前端界面,声明式是后端基础”的分层思想:

- 初期可用图形化方式快速验证想法;

- 成熟后可将流程固化为声明式配置,纳入正式的配置管理流程。

5.3 多智能体协作与多源工具集成:应对复杂企业场景的标准配置

在真实的企业项目中,常面临以下挑战:

- 任务跨多个部门与多个系统;

- 需同时调用多种外部接口或 RAG 知识库;

- 不同阶段存在差异化的安全策略与审计需求。

ModelEngine 在架构层面原生支持:

- 多智能体协同作业,每个智能体可独立配置模型、知识库与工具集;

- 多源工具集成,通过 MCP 协议或插件机制统一抽象外部服务能力;

- 在同一编排框架下,实现对多个智能体与工具的集中调度、运行监控与异常告警。

相比单一智能体架构,这种“多智能体 + 多工具联动”的设计更能满足大型企业在高复杂度业务场景下的实际需要。

六、开发者视角对比:ModelEngine vs Dify vs Coze vs Versatile

从开发者的立场出发,可以从以下几个维度对这些平台进行简要比较:

平台定位、应用编排能力、生态开放程度、企业适配性等。

6.1 平台定位与典型应用场景

ModelEngine

- 定位为“涵盖数据治理到应用部署的全链路 AI 工程平台”;

- 包含数据工程、模型工程、应用编排三大核心模块,更适合中大型企业开展系统性 AI 工程化实践。

Dify

- 开源的大模型应用开发平台,突出“后端即服务”与 LLMOps 能力;

- 支持多模型接入、RAG 引擎、Agent 框架及流程可视化编排,适合初创团队或开发者快速构建产品原型。

Coze

- 主打“下一代 AI 应用与 Bot 开发平台”,操作界面友好,非技术人员也能轻松上手;

- 最大特色是支持将 Bot 快速发布至 Telegram、Discord、抖音等社交平台,适合轻量级互动场景。

华为云 Versatile 是一个一站式企业级智能体平台,致力于实现“人人都能构建企业级智能体”的目标。该平台突出强调自然语言转智能体(NL2Agent)、画布式流程编排、高并发低延迟响应以及安全合规等面向企业的核心能力,满足企业在智能化转型中的多样化需求。

在应用编排与多智能体协同方面,ModelEngine 与 Versatile 具有较高的相似度,二者均支持可视化画布操作、多 Agent 协作机制,并注重企业内部系统的深度集成与全生命周期管理。相比之下,Dify 虽然也提供流程编排和 Agent 功能,但其定位更偏向于作为“应用后端 + API 网关 + LLMOps”类的基础设施,通常需要开发者结合自有的前端界面和业务逻辑系统进行二次开发。而 Coze 的编排能力则主要聚焦于 Bot 的对话行为设计与交互流程优化,适用于轻量级、用户导向型的聊天机器人场景,而非复杂的企业级业务流处理。

开发者体验主观评估

从开发者角度出发,结合不同团队背景与需求,可做出如下选择建议:

- 企业内部工程团队:若需打通数据、模型到应用的完整链路,且已有大量 Java 或 Python 技术栈系统需要对接,同时对运维监控、权限控制、操作审计等方面有较高要求,则 ModelEngine 或 Versatile 更为匹配。

- 创业团队或独立开发者:若目标是快速验证产品概念或构建 MVP,重视开源灵活性、部署自由度及活跃的社区生态,Dify 是一个极具吸引力的选择。

- 面向 C 端用户的多平台 Bot 开发者:如内容生成类机器人、娱乐互动型 Bot 等,强调跨社交平台分发能力,并希望产品经理或运营人员无需编码即可自主搭建 Bot,Coze 凭借其易用性和发布效率展现出明显优势。

值得注意的是,这些平台并非互斥关系,甚至可以在同一组织内实现协同分工:例如使用 ModelEngine 作为企业内部数据与系统的中枢引擎,借助 Dify 构建特定外部产品的后台服务,再通过 Coze 打造对外服务的智能触点,形成多层次、互补式的智能体架构体系。

此外,平台还支持模型管理与性能评估、训练与推理任务的一键下发与集中管控,提升整体开发与运维效率。

七、方法论到实践:系统化设计智能体落地路径

基于前述实践经验,可总结出一套具备通用性的“智能体落地方法论”,无论是否采用 ModelEngine,该思路均可参考复用:

- 优先选定应用场景,而非盲目追逐大模型:从实际业务痛点切入,挑选一两个效果可量化的场景(如智能办公助手、数据分析助理等),并明确成功标准,如响应准确率、处理耗时、人工工单减少数量等。

- 先完成知识与数据治理,再推进智能体建设:梳理现有数据来源,识别权威文档与待淘汰的历史信息;为核心知识领域建立高质量的知识库与评测集,为后续迭代提供坚实基础。

- 清晰定义智能体角色与职责边界:避免设计“万能 Agent”,应通过多智能体协作模式,构建“总控 Agent + 专业领域 Agent + 工具调用 Agent”的分层体系,实现高效协同。

- 利用可视化编排沉淀业务流程:将工作流转化为“技术与业务共通的语言”,降低理解门槛;鼓励非技术人员参与流程设计,使用他们熟悉的表达方式描述业务逻辑。

- 建立评测与迭代机制,推动感性反馈向量化指标转化:构建自动评测系统,包含离线测试集、在线用户反馈与人工复审环节;将 Prompt 版本、知识库更新、模型版本与评测结果关联,形成闭环追踪看板。

- 由单点试点逐步迈向平台化演进:初期可通过单一场景验证价值;在取得成效后,逐步沉淀共享知识库、标准化工作流模板与通用插件模块;最终达成“企业 AI 中台 + 多业务线复用”的成熟架构。

像 ModelEngine 这类平台的核心价值,在于为上述路径提供了完整的工程化支撑——涵盖数据层工具链、模型层管理与评测能力、应用层的可视化编排与插件扩展机制,同时具备企业级的安全治理特性。

借助此类平台,用户还能实现一站式可视化应用构建,支持分钟级的应用发布与快速迭代。

八、结语:以实践共建生动的 AI 技术生态

进入大模型时代,真正的竞争力已不再取决于“谁使用的模型参数更多”,而在于:

- 谁能更快地将原始数据转化为结构化知识资产;

- 谁能将分散的智能能力固化为可复用的智能体与标准化工作流;

- 谁能在技术实现与业务需求之间,架设起一座稳定高效的桥梁。

本文所呈现的实践表明:依托 ModelEngine 提供的知识库自动生成、提示词自动优化、多智能体协作及可视化应用编排能力,我们能够在工程技术层面系统性地回答“如何从零开始落地智能体”这一关键问题。同时,通过对 Dify、Coze、Versatile 等主流平台的对比分析,有助于各组织更精准地识别自身需求,做出符合实际场景的技术选型决策。

无论你是企业架构师、AI 工程师,还是产品或运营人员,当你亲自参与到智能体的搭建过程,亲手绘制一条业务流程,并成功运行自动化闭环的那一刻,你已经在为这个时代贡献真实可用的“技术骨骼与肌肉”。

期待未来有更多一线开发者通过实践案例分享经验教训,彼此启发,共同推动 AI 技术从演示走向真正改变生产方式的基础设施。

只有当足够多的“从 0 到 1”项目被公开记录与传播,大模型技术才能超越概念展示,成为驱动产业变革的核心力量。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号