本项目基于MATLAB平台实现了一种融合时序卷积网络(TCN)、Transformer自注意力机制与长短时记忆网络(LSTM)的混合深度学习模型,适用于多变量时间序列的多步预测任务。该模型充分发挥了各类神经网络在时序建模中的优势,具备较强的特征提取与长期依赖捕捉能力。

核心功能概述

- 构建一个集成了TCN、Transformer和LSTM结构的复合型神经网络架构,用于高效处理复杂的时间序列数据。

- 支持对多变量输入进行未来多个时间步的预测输出。

- 提供完整的训练与测试流程,包含数据预处理、模型训练、结果预测及性能评估全流程。

- 输出多种可视化图表与量化指标,便于分析模型表现。

技术实现路径

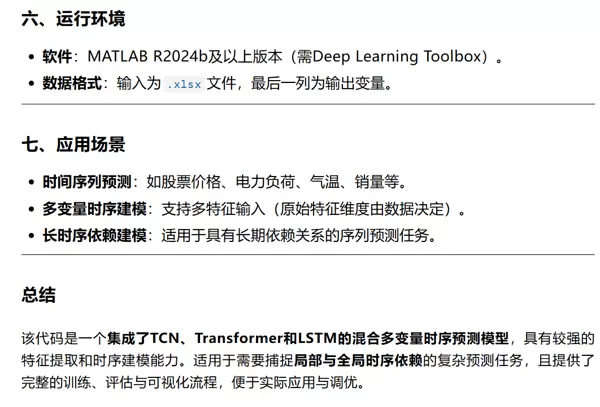

整个系统依托于MATLAB Deep Learning Toolbox完成搭建与训练,采用模块化设计思路,确保各组件协同工作。

模型整体结构如下:

输入层 → TCN模块(带残差连接的因果卷积)→ 位置编码嵌入 → Transformer模块(含因果与全局自注意力)→ LSTM层 → 全连接层 → 输出层

训练过程中使用Adam优化器,并结合分段式学习率衰减策略以提升收敛稳定性;同时引入早停机制防止过拟合,训练过程支持实时可视化监控。

算法实施步骤

1. 数据准备与预处理

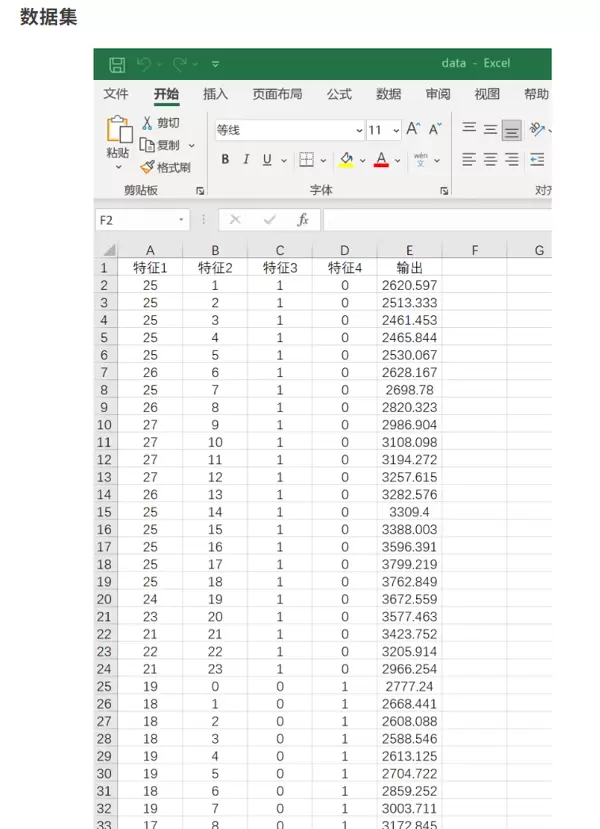

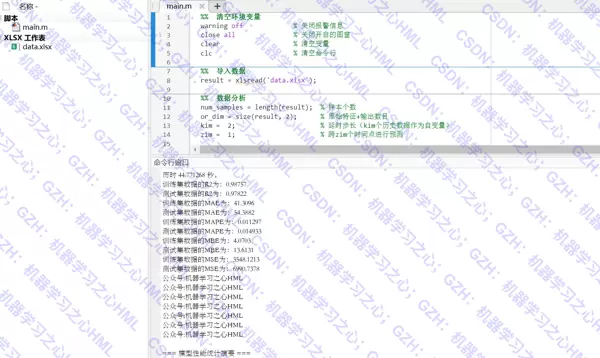

从Excel文件中加载原始多变量时间序列数据,并构造滑动窗口形式的样本对(输入序列-输出序列),以便适配序列预测任务的需求。

2. 数据集划分

按照设定比例将处理后的数据划分为训练集和测试集,确保测试数据不参与训练过程,以客观评估模型泛化能力。

3. 归一化处理

利用mapminmax函数将输入与输出变量统一映射至[0,1]区间,提升模型训练的数值稳定性和收敛速度。

4. 模型结构设计

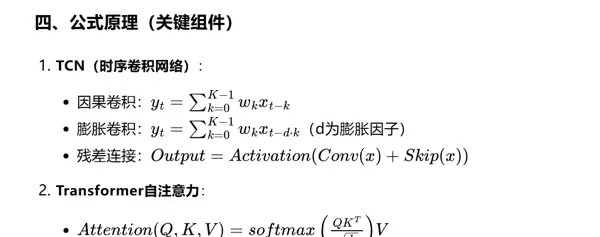

- TCN模块:通过因果卷积保证模型仅依赖当前及历史信息,结合膨胀卷积扩大感受野,配合残差连接缓解梯度消失问题,有效提取局部时序模式。

- 位置编码:为输入序列添加位置信息,弥补Transformer结构本身对顺序敏感性不足的问题。

- Transformer层:集成因果掩码自注意力与全连接前馈网络,既能捕捉长距离依赖关系,又能保留时间方向约束。

- LSTM层:进一步挖掘经过高维变换后的时间动态特征,增强模型的记忆能力。

- 全连接+回归头:最终通过线性层还原预测维度,输出目标时间序列的多步预测值。

5. 模型训练

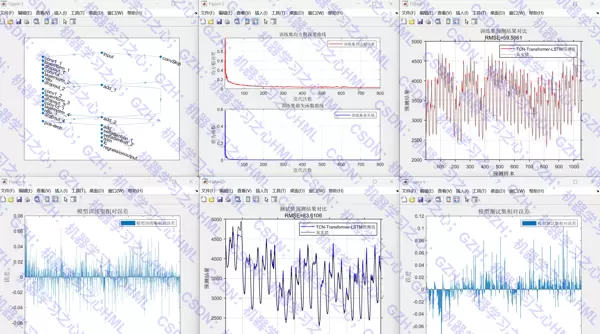

采用Adam优化器最小化均方误差损失函数,训练中启用学习率衰减与早停机制,提高训练效率并避免过拟合。训练过程支持实时绘制损失曲线等监控信息。

6. 预测与性能评估

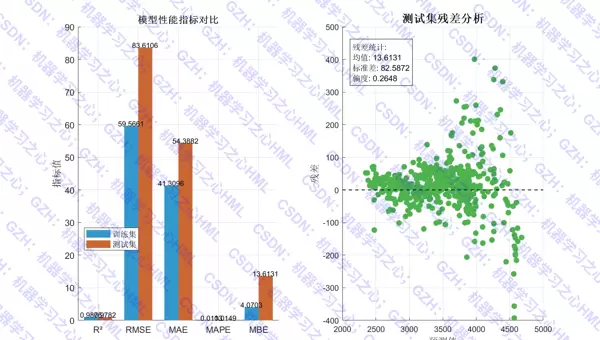

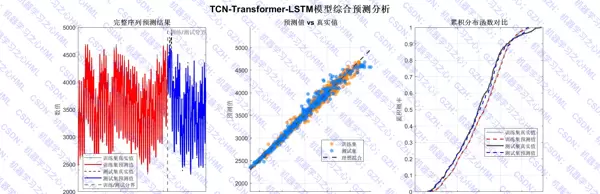

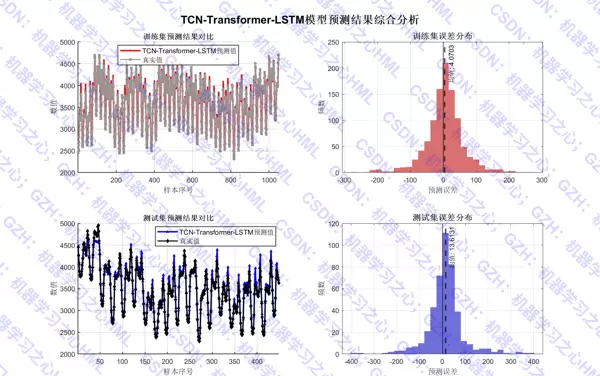

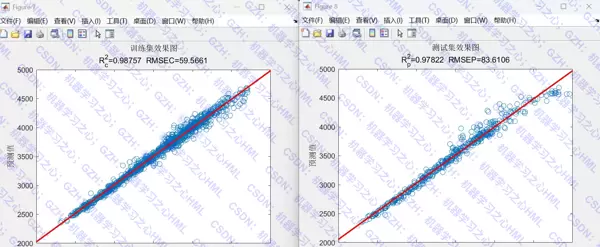

模型预测完成后,通过反归一化将结果恢复至原始量纲,随后计算多项评价指标,包括决定系数(R)、均方根误差(RMSE)、平均绝对误差(MAE)、平均绝对百分比误差(MAPE)以及平均偏差误差(MBE)。

此外,系统生成一系列可视化图表,如:

- 训练集与测试集预测对比图

- 实际值与预测值拟合图

- 误差分布直方图

- 注意力权重热力图(如适用)

以上内容完整实现了多变量时间序列预测任务的技术闭环,具备良好的可复现性与扩展性。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号