基于DEEPSEEK与YOLOv11的植物叶片病害智能识别系统

目录

- 前言

- 1.1 研究背景及意义

- 1.2 传统病害检测手段

- 1.3 图像驱动的病害识别技术

- 1.4 深度学习在目标检测中的发展现状

- 1.5 本文研究内容与结构安排

- YOLO系列算法基础理论

- YOLOv11与DEEPSEEK模型核心技术解析

- 融合DEEPSEEK与YOLO的叶片病害检测系统实现

- 4.1 系统功能需求

- 4.2 系统架构设计

- 4.3 系统输出效果展示

- 结论

- 参考文献

- 致谢

系统成果展示

演示视频链接

https://www.bilibili.com/video/BV1oY2xBUEky/1 前言

1.1 研究背景及意义

农业作为国家经济发展的根基,其稳定增长受到多种因素影响,其中作物病害是制约产量提升、品质保障和生产效率的关键障碍之一。根据联合国粮农组织(FAO)的数据,全球每年因病虫害导致的农作物减产比例在20%至40%之间。在我国,随着农业集约化水平不断提升以及种植结构持续优化,各类植物病害呈现高发、频发和严重化的趋势。例如草莓、番茄、豆类等具有较高经济价值的作物,一旦感染灰霉病、叶斑病或白粉病等常见病害,若未能及时识别并采取防控措施,极易造成果实质量下降、收成锐减甚至绝收,给农业生产者带来严重的经济损失。1.2 传统病害检测手段

目前主流的传统植物病害诊断方式主要包括人工目视判断和实验室生化分析两类。 (1)人工目测法: 这是最基础且当前仍广泛应用的方式,依赖农户或专业技术人员凭借经验观察植株叶片、茎干或果实上的病变特征,如颜色变化、斑点形态、纹理异常等,进而判断病害种类。该方法实施成本低,但易受个体主观判断影响,准确性波动大,难以实现早期发现,常错过最佳防治窗口期。 (2)实验室生化检测法: 包括聚合酶链式反应(PCR)、酶联免疫吸附测定(ELISA)等分子生物学与血清学技术。此类方法具备高灵敏度和强特异性,可精准鉴定病原体类型。然而,其操作流程复杂,需专业设备支持、样本预处理繁琐,并依赖技术人员完成,整体检测周期较长、费用高昂,不适合在田间进行大规模实时应用。1.3 图像驱动的病害识别技术

近年来,基于计算机视觉与数字图像处理的病害自动识别技术逐渐兴起,成为一种非侵入性、低成本且高效的解决方案。该技术通过手机或相机采集作物叶片图像,利用图像算法完成去噪、增强、分割、特征提取和分类识别等一系列处理步骤,最终实现对病害类型的自动化判定。相比传统方式,该方法具备响应速度快、可重复性强、易于集成到移动平台等优势,为智慧农业的发展提供了新的路径。1.4 深度学习在目标检测中的发展现状

2006年,Geoffrey Hinton 及其学生在《Science》期刊发表重要论文,提出可通过“无监督预训练+有监督微调”的策略解决深层网络中的梯度消失问题,由此开启了深度学习的新纪元。随后,2011年ReLU激活函数被引入,有效缓解了Sigmoid函数带来的梯度衰减难题。2012年,Hinton团队成员Alex Krizhevsky 设计的AlexNet深度卷积神经网络在ImageNet大规模视觉识别挑战赛(ILSVRC)中以显著优势夺冠,首次验证了深度学习自动提取图像特征的能力远超传统手工设计方法,彻底改变了计算机视觉领域的研究范式。此后,研究者不断优化网络结构与训练机制,推动目标检测算法性能持续提升,深度学习进入快速发展阶段。1.5 本文研究内容与结构安排

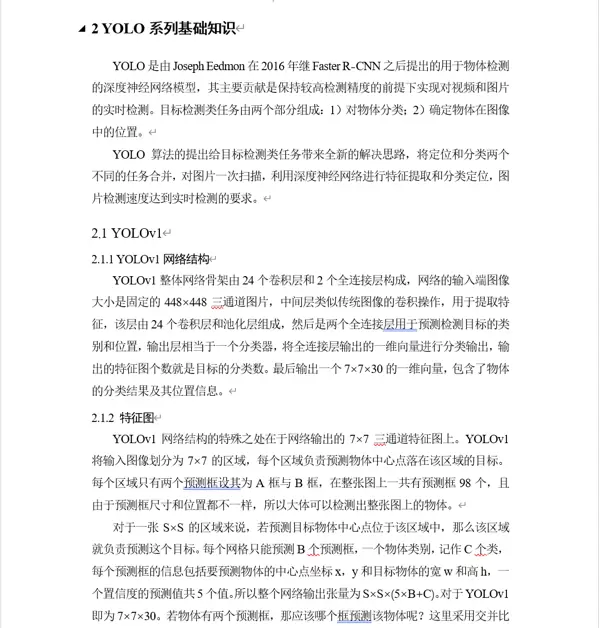

本研究构建了一套结合YOLO系列目标检测算法与DeepSeek大语言模型的智能化植物叶片病害识别系统,致力于实现病害的快速定位、智能分析与风险预警。系统由三大核心模块构成:病害目标检测模块、智能语义分析与决策建议生成模块、用户交互与可视化展示模块。用户可通过Web界面上传图像或启动摄像头进行实时拍摄,系统不仅能准确识别是否存在病害区域,标注其位置与置信度,还能借助大语言模型生成情境化、可解释性强的诊断建议与应对策略,从而为农业生产的科学管理提供有力支撑。2 YOLO系列算法基础理论

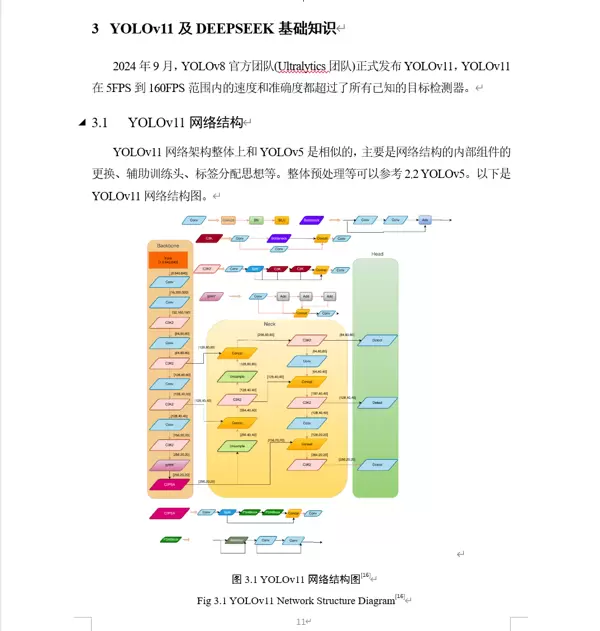

3 YOLOv11与DEEPSEEK模型核心技术解析

4 融合DEEPSEEK与YOLO的叶片病害检测系统实现

4.1 系统功能需求

将先进算法转化为实际可用的应用系统是实现科研价值转化的重要环节。本文所采用的YOLOv11目标检测算法与DeepSeek大语言模型,只有在系统化部署后才能真正发挥其应用潜力。目标检测的核心任务是从输入图像中准确定位并识别出特定对象,因此本系统的功能性需求为:能够接收视频流或静态图像作为输入,自动执行目标检测流程,输出包含病害类别、边界框坐标、置信度评分的结构化结果,并以可视化形式呈现于前端界面。4.2 系统架构设计

系统整体采用前后端分离架构,前端负责用户交互与结果显示,后端集成图像处理引擎与AI推理服务。YOLOv11用于完成病害区域的实时检测与定位,输出带有标签和置信度的检测框;检测结果随后被送入DeepSeek模型,结合上下文信息生成自然语言描述的风险评估与处置建议。整个流程实现了从“看得见”到“看得懂”的跨越,增强了系统的实用性与交互友好性。4.3 系统输出效果展示

系统运行过程中可实时显示原始图像、检测结果图、病害类型标签及其对应置信度,并同步生成由大语言模型输出的专业级分析报告。检测精度高、响应速度快,适用于果园、温室、农田等多种场景下的日常巡检与远程监控。5 结论

本研究成功实现了YOLOv11与DeepSeek大语言模型的融合应用,构建了一个集病害检测、智能分析与决策支持于一体的植物叶片健康监测系统。实验表明,该系统不仅具备较高的检测准确率和实时性,还通过引入语义理解能力提升了人机交互体验,为未来智慧农业系统的开发提供了可行的技术路线与实践参考。参考文献

(略)致谢

(略)本系统旨在通过一个直观的图形化界面,使用户能够便捷地上传图像、视频或启动实时摄像头,实现对植物叶片病害的自动化识别与定位,并融合大语言模型技术生成深度场景解读与应对策略。最终,系统将多维度信息整合呈现,为用户提供清晰、全面的结果展示。为此,系统需具备以下核心功能:

1. 多源媒体输入支持

系统应构建基于Web的GUI交互界面,支持多种数据输入方式:包括本地图像和视频文件的上传,以及直接启用设备摄像头进行实时画面检测,确保用户在不同使用场景下均能灵活操作。

2. 高精度病害识别能力

后端需集成训练完成的YOLO系列深度学习模型,针对输入内容执行高效推理运算,精准识别并定位图像中各类叶片病害区域,保障检测结果的准确性与稳定性。

3. 智能分析与报告自动生成

作为系统的创新重点,该功能将YOLO输出的结构化检测信息(如目标类别、数量、位置及尺寸)传递至DeepSeek大语言模型。由其生成自然语言形式的专业报告,涵盖病害严重程度评估、可能成因解析、潜在扩散风险预警以及科学防治建议等内容。

4. 一体化结果可视化展示

完成检测与智能分析后,前端界面应在统一视图中同步呈现带有标注框的视觉化图像或视频流,以及由大模型生成的结构化文本报告,帮助用户快速理解病情并做出决策。

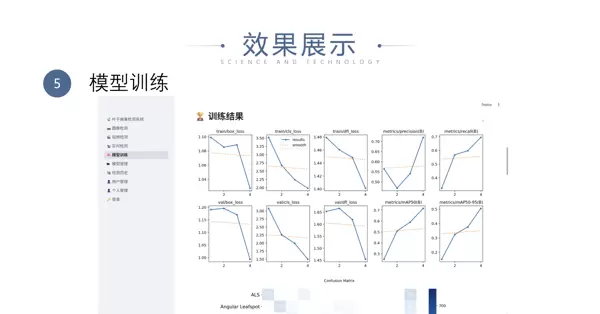

5. 模型训练与管理扩展接口

为支持后续优化升级,系统需提供或预留调用模型训练脚本的接口,便于开发人员利用新增数据集对YOLO模型进行再训练,持续提升检测性能。

4.2 系统架构设计

为满足上述功能需求,同时保证良好的模块划分与后期维护性,系统采用分层式、服务化的Web架构设计方案。区别于传统桌面框架(如PyQt5),本系统选用Streamlit作为前端GUI开发工具,其优势在于可将前后端逻辑统一于Python脚本中,特别适用于数据驱动型应用的快速原型构建。

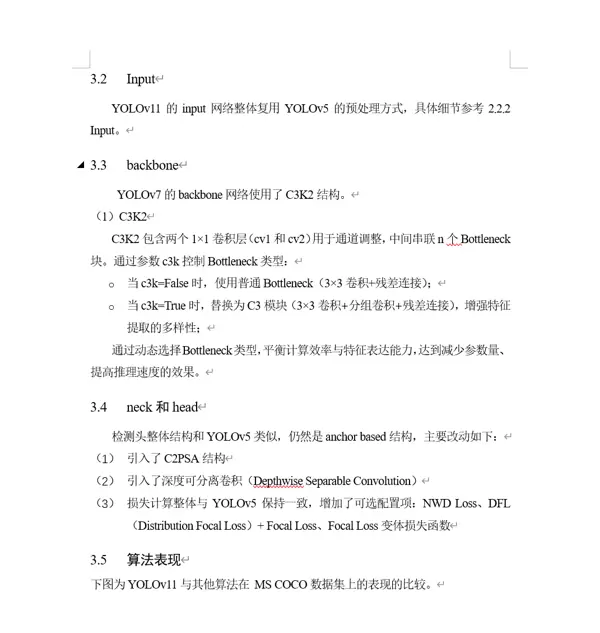

整体系统划分为四个功能层级:用户交互层、应用服务层、核心算法层和数据与配置层。具体模块划分如图4.1所示:

图4.1 功能模块划分图

Fig 4.1 Functional module division diagram

用户交互层(GUI Layer)

- 完全依托Streamlit框架实现界面渲染。

- 负责构建并展示所有前端组件,如文件上传控件、摄像头开关按钮、结果显示区域等。

- 接收用户操作指令,并将原始媒体数据转发至应用服务层进行处理。

应用服务层(Service Layer)

作为系统的业务逻辑中枢,由多个独立的服务模块构成:

- DetectionService:封装YOLO模型的加载与推理流程,对外暴露标准化的检测调用接口。

- DeepSeekService:负责组织Prompt模板、调用DeepSeek LLM API并解析返回的文本响应。

- ImageService / VideoService:提供通用媒体处理能力,如视频帧提取、图像编码解码等基础操作。

服务化架构设计使得各核心功能模块可独立开发、测试与迭代升级。

核心算法层(Algorithm Layer)

作为系统的“智能引擎”,包含实际运行的人工智能模型:

- YOLO模型:以.pt格式存储的预训练权重文件,用于执行病害目标检测任务。

- DeepSeek LLM:通过远程API调用的云端大语言模型服务,承担语义理解与报告生成职责。

数据与配置层(Data & Config Layer)

负责管理系统中的持久化信息与运行参数:

- 配置文件:包括app_config.yaml(应用级配置)、model_config.yaml(模型参数设定)及.env(环境变量定义)等。

- 数据文件:涵盖历史检测记录、生成的分析报告存档、系统日志等。

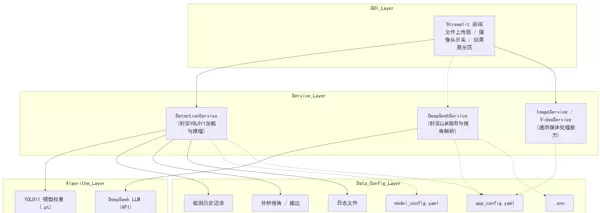

整个检测流程的时序关系如图4.2所示:

图4.2 系统时序图

Fig 4.2 System timing diagram

详细执行步骤如下:

- 用户发起检测任务:在Streamlit网页界面上,用户通过文件上传或摄像头按钮提交待分析的图像或视频数据。

- 数据传入服务层:主应用接收到输入后,调用DetectionService模块,并将媒体数据作为参数传入。

- 执行目标检测:DetectionService加载YOLO模型,对输入内容进行推理,输出包含类别标签、置信度分数和边界框坐标的结构化检测结果。

- 判断病害存在性:主应用接收检测结果,并判断其中是否包含“角斑病”、“灰霉病”等关键病害类型。

- 触发智能分析流程:若发现相关病害目标,则整理检测信息(例如:“在图像中心区域发现2个灰霉病实例”),并调用DeepSeekService模块。

- 生成专业分析报告:DeepSeekService根据预设模板构造Prompt,向DeepSeek LLM发送请求。模型基于输入内容进行综合分析,返回一段包含病情评估与防治建议的自然语言文本。

- 结果整合与返回:DeepSeekService将生成的报告文本回传给主应用,准备进入最终展示阶段。

在系统前端的最终呈现环节,Streamlit主应用负责将处理结果进行可视化输出。通过整合带有检测框的图像与结构化的智能分析报告,系统向用户完整展示检测与诊断的双重结果,实现直观、高效的信息传达。

4.3 系统结果展示

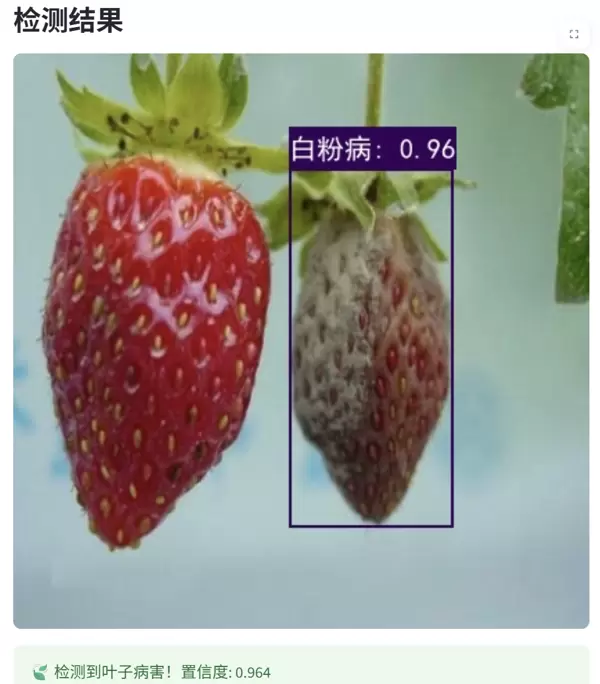

根据系统的功能需求与整体架构设计,本文构建了一套集成了YOLO目标检测算法与DeepSeek大语言模型的智能植物叶片病害识别系统。用户可通过Web界面选择上传静态图片、视频文件,或启用实时摄像头进行在线检测。

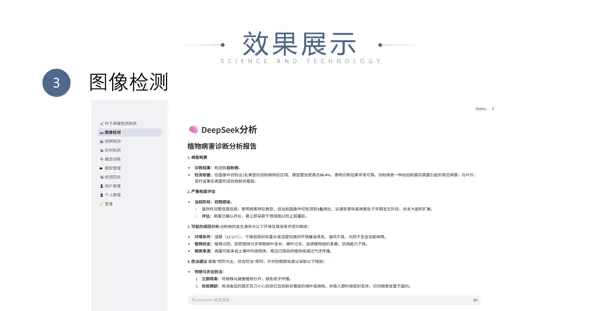

当用户选定输入源并启动检测流程后,系统首先调用后台的YOLO服务对图像内容或视频帧序列进行分析,精准定位画面中可能存在的病害区域,并提取关键信息,如病斑数量、位置坐标及尺寸范围等。

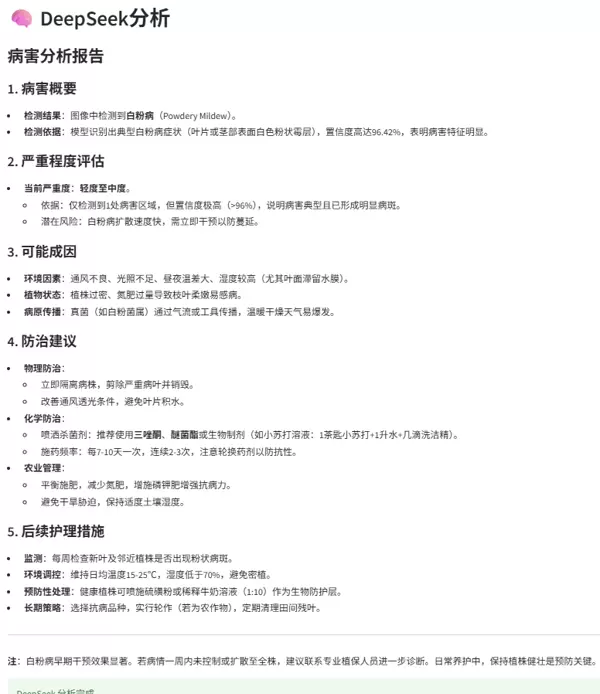

随后,这些结构化的目标信息被传递至DeepSeek智能分析模块。该模块依托大语言模型强大的语义理解与推理能力,对检测结果进行深度解读,生成包含病情描述、风险等级评估以及科学防治建议在内的综合性诊断报告。

最终,系统将标注了病害位置的视觉输出与文本形式的智能报告同步渲染至前端界面,使用户能够同时获取“看得见”的检测结果与“读得懂”的专业分析,完成从基础识别到智能诊断的跃升。

以下为系统测试的实际效果展示:

图4.3 图片检测效果

Fig 4.3 Image detection effectiveness

图4.3 DEEPSEEK分析效果

Fig 4.3 DEEPSEEK analysis effectiveness

图4.5 视频检测效果

Fig 4.5 Video detection effectiveness

5 结论

面对现代农业生产环境中日益复杂的作物类型、多变的病害特征以及动态增长的应用需求,传统病害识别手段已显现出明显的局限性。得益于深度学习技术的快速发展,尤其是目标检测算法的进步,植物病害识别进入了智能化新阶段。这类方法不仅在识别准确率上达到甚至接近专家水平,还在处理速度和信息承载能力方面展现出显著优势。

然而,仅实现病斑的定位与分类仍不足以满足实际应用场景中的决策支持需求。如何进一步理解检测结果、评估其潜在危害并提供可操作的管理建议,成为当前智能农业系统面临的核心挑战。本系统通过融合视觉感知与语言推理能力,探索了从“识别”到“诊断”的延伸路径,为未来农业智能化服务提供了可行的技术范式。

参考文献

[1] ZHU X, LYU S, WANG X, et al. TPH-YOLOv5: Improved YOLOv5 Based on Transformer Prediction Head for Object Detection on Drone-captured Scenarios[J]. arXiv e-prints, 2021.

[2] DENG T, WU Y. Simultaneous vehicle and lane detection via MobileNetV3 in car following scene[J]. Plos One, 2022.

[3] ZHANG M, ZHANG Y, ZHOU M, et al. Application of light-weight convolutional neural network for damage detection of conveyor belt[J]. Applied Sciences, 2021.

[4] HAN X, CHANG J, WANG K. Real-time object detection based on YOLO-v2 for tiny vehicle object[J]. Procedia Computer Science, 2021.

[5] DEWI C, CHEN R C, LIU Y T, et al. Yolo V4 for advanced traffic sign recognition with synthetic training data generated by various GAN[J]. IEEE Access, 2021.

[6] GAO H, WANG W, YANG C, et al. Traffic signal image detection technology based on YOLO[C]//Journal of Physics: Conference Series, Guangzhou, China, 2021.

[7] 刘志佳. 基于YOLOX改进的人脸口罩检测算法[D]. 南京邮电大学, 2022.

[8] 贾世娜. 基于改进YOLOv5的小目标检测算法研究[D]. 南昌大学, 2022.

[9] 吕璐, 程虎, 朱鸿泰, 代年树. 基于深度学习的目标检测研究与应用综述[J]. 电子与封装, 2022.

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号