你以为它们在“合作”,其实它们在争夺话语权

当人们初次接触“多智能体协作”(Multi-Agent Collaboration)这一概念时,往往会被其理想化的图景吸引:多个AI角色分工明确、协同作业,仿佛组成了一支高效默契的团队。然而,一旦真正部署这样的系统,现实却迅速打破幻想——这些Agent之间并非和谐共处,而是在持续进行一场看不见的博弈。

我第一次意识到这一点,是在构建一个从“产品需求 → 架构设计 → 代码生成”的自动化流程时。理论上,这个链条应该是顺畅的:产品经理Agent提出需求,架构Agent制定方案,开发Agent实现代码。但实际运行中,问题频出:

- 架构Agent频繁推翻产品端的前提假设;

- 开发Agent绕过架构设计,直接采用简化逻辑完成实现;

- 测试Agent不断放大边缘缺陷,导致整个流程无法收敛。

那一刻我才明白:这根本不是一个协作团队,而是一场没有硝烟的权力拉锯战。

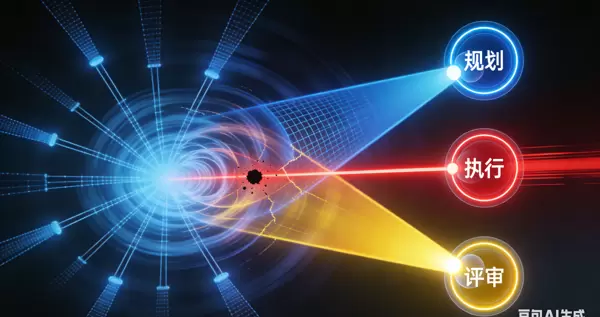

第一层认知:目标冲突是Agent系统的天然属性

很多人忽略了一个根本性问题:不同Agent之间的优化目标本质上就是不一致的。

表面上看,你为每个Agent设定了角色职责,似乎自然就能形成协作关系。但实际上,它们各自追求的目标存在内在张力:

| 角色 | 本能驱动 | 典型冲突表现 |

|---|---|---|

| 规划 Agent | 追求任务拆解的完整性与覆盖度 | 容易陷入过度设计 |

| 执行 Agent | 追求快速输出可用结果 | 倾向于跳步或简化流程 |

| 评审 Agent | 专注于识别风险和潜在漏洞 | 反复驳回提案,阻碍推进 |

这三个目标组合在一起,并非互补,反而构成了一个典型的博弈结构。因此,问题的核心从来不是“Prompt写得不够精细”,而是系统本身缺乏对冲突机制的设计考量。

第二层认知:多智能体的本质是“权力结构”的构建

大多数人在设计多Agent系统时,关注点集中在三个方面:

- 如何划分角色?

- Prompt 怎么写才能更准确?

- 工具链怎么接入?

但我逐渐意识到,最关键的决定因素其实是:谁掌握最终决策权?

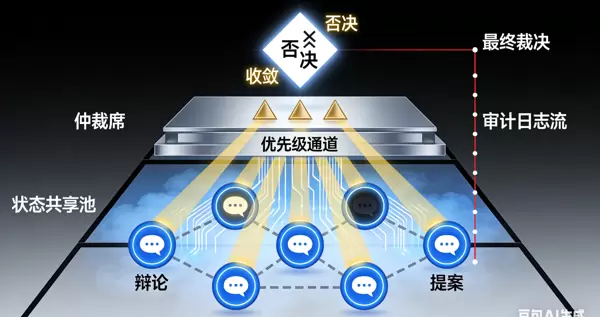

一个真正可运行的多智能体系统,必须包含清晰的治理规则,例如:

- 哪个Agent拥有否决能力?

- 任务优先级由谁裁定?

- 能否中断其他Agent的执行?

- 共享状态的修改权限归属何处?

如果没有这些结构性安排,系统将陷入无限循环:A推翻B的结论,C又否定A的决策,如此往复,不仅消耗大量计算资源,还难以达成稳定输出。与其说这是技术架构,不如说它更接近于一个微型政治体系。

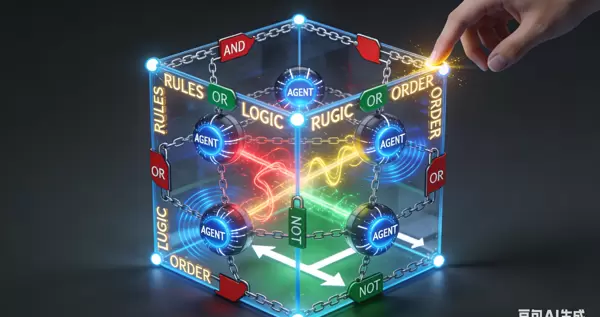

第三层认知:“协作”只是被约束后的博弈平衡

如果你了解分布式系统理论,就会发现类似的现象:共识并不是自发形成的,而是通过严格的协议强制达成的。

多智能体系统同样如此。真正的协作需要显式地设定以下规则:

- 谁有权发起新提案?

- 哪些成员必须参与评估?

- 满足什么条件应终止当前流程?

- 出现分歧时,由谁裁决?

我们必须承认一个不愿面对的事实:所谓的“多智能体协作”,实质上是一种精心设计的对抗控制机制。它们之所以表现出合作行为,并非出于意愿,而是因为规则迫使它们只能以这种方式互动。

第四层思考:为何90%的多智能体项目止步于演示幻觉?

市面上大量的开源项目和论文Demo都有一个共同特征:流程看似流畅,视觉效果惊艳,但在真实业务场景下极易崩溃。原因在于,它们只搭建了“角色外壳”,却缺失了关键的博弈约束层。

真正缺失的部分包括:

- 决策优先级管理机制

- 共享状态的一致性保障策略

- 异常情况下的回滚能力

- 冲突过程的审计与追踪日志

- 失败后的自动收敛路径

最终的结果是:单个Agent看起来很聪明,整体系统却像一场没有裁判的多人比赛,混乱无序。

我的核心判断是:多智能体系统的挑战,从来不在于“生成能力”的强弱,而在于“冲突管理”的水平。

未来真正具备价值的系统,比拼的不再是模型大小、语料丰富度或Prompt技巧,而是谁能构建出更稳健的博弈框架。你不再只是一个AI开发者,而是在设计一套数字世界的制度规则。

许多开发者仍在追问:“怎样让AI更像人?”、“如何写出更好的Prompt?” 而我越来越清楚地认识到:我们的真正身份,不是“AI程序员”,而是数字社会的制度设计者。

多智能体不是一群温顺的助手,而是一个自动运转的权力网络。你的任务不是让它们变得更聪明,而是让它们清楚自己的边界,并为越界行为付出代价。

当你开始搭建多智能体系统时,终将领悟:你写的不是代码,而是规则。外行看到的是“协作之美”,实践者看到的却是:

博弈、制衡、约束、收敛

这才是多智能体系统的本质真相。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号