CDA数据分析师:数据科学、人工智能从业者的在线大学。

数据科学(Python/R/Julia)数据分析、机器学习、深度学习

上节我们介绍了线性回归和Ridge回归,并介绍了两种回归的优缺点。本节我们重点学习下lasso回归的方法和优缺点。

和岭回归(Ridge)回归一样,lasso回归也是一种正则化的线性回归,且也是约束系数使其接近于0,不过其用到的方法不同,岭回归用到的是L2正则化,而lasso回归用到的是L1正则化(L1是通过稀疏参数(减少参数的数量)来降低复杂度,即L1正则化使参数为零,L2是通过减小参数值的大小来降低复杂度,即L2正则化项使得值最小时对应的参数变小)。

下面我们来看将lasso正则化运用到波士顿房价数据集上的效果,对应代码如下:

- import mglearn

- from sklearn.model_selection import train_test_split

- import matplotlib.pyplot as plt

- x, y = mglearn.datasets.load_extended_boston

- x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=0)

- from sklearn.linear_model import Lasso

- lasso = Lasso.fit(x_train, y_train)

- print("Training set score: {:.2f}".format(lasso.score(x_train, y_train)))

- print("Test set score: {:.2f}".format(lasso.score(x_test, y_test)))

- print("Number of features used: {}".format(np.sum(lasso.coef_!=0)))

- #我们增大max_iter的值,否则模型会警告我们,应该增大max_iter

- #下面代码则是打印各种alpha参数下的预测分数

- lasso01 = Lasso(alpha=0.1, max_iter=100000).fit(x_train, y_train)

- lasso001 = Lasso(alpha=0.01, max_iter=100000).fit(x_train, y_train)

- print("training set score: {:.2f}".format(lasso001.score(x_train, y_train)))

- print("Test set score: {:.2f}".format(lasso001.score(x_test, y_test)))

- print("Number of features used: {}".format(np.sum(lasso001.coef_!=0)))

- lasso00001 = Lasso(alpha=0.0001, max_iter=100000).fit(x_train, y_train)

- print("training set score: {:.2f}".format(lasso00001.score(x_train, y_train)))

- print("Test set score: {:.2f}".format(lasso00001.score(x_test, y_test)))

- print("Number of features used: {}".format(np.sum(lasso00001.coef_!=0)))

- #绘制对应的图形

- plt.plot(lasso.coef_, 's', label="Lasso alpha=1")

- plt.plot(lasso001.coef_, '^', label="Lasso alpha=0.01")

- plt.plot(lasso00001.coef_, 'v', label="Lasso alpha=0.0001")

- plt.plot(lasso01.coef_, 'v', label="Ridge alpha=0.1")

- plt.legend(ncol=2, loc=(0, 1.05))

- plt.ylim(-25, 25)

- plt.xlabel("Coefficient index")

- plt.ylabel("Cofficient magnitude")

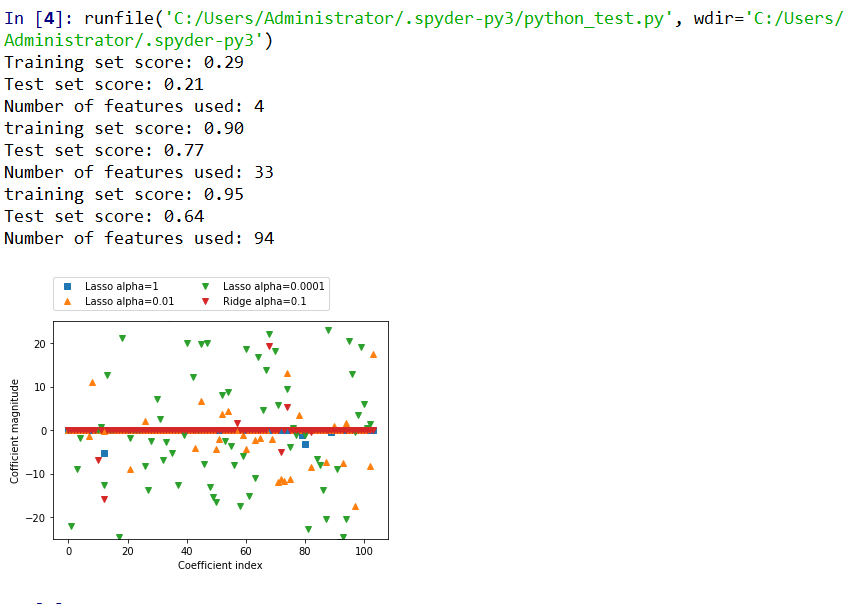

上述代码运行结果如下:

不同alpha值得lasso和岭回归(ridge)的系数比较

由上述代码我们可以看出,当使用特征数比较少时,lasso的训练集和测试集表现都很差,这表示存在欠拟合。通过调整alpha值,可以控制系数趋向于0的强度。当我们将alpha值变小,我们可以拟合一个比较复杂的模型,此时,训练集和测试集反而表现得更好,当我们将特征值从4个上升到33个是,训练集和测试集已经表现得比较好了。不过,如果将alpha值设置得太小的时候,训练集就会远大于测试集了,这是就出现了过拟合的情况。

在实践中,岭回归(Ridge)和lasso我们首选岭回归。不过如果特征数过多,但是其中只有几个特征是重要的,则选择lasso效果会更好。同时,lasso由于其模型更加便于理解(因为它只选择一部分输入特征),所以有时候用lasso回归效果也不错。当然,如果我们能够将两者进行优势互补,则会达到更佳的效果,在scikit-learn中提过了ElasticNet类,就是结合了这两种回归的惩罚项。在实践中效果会更好,不过需要同时调节L1和L2正则化参数,在以后章节中我们会介绍到。

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号