本文文字内容来自于《可视化讲解注意力机制,人工智能核心算法Transformer模型(变形金刚)的心脏》,该视频由CDA数据科学研究院重磅推出,有兴趣的小伙伴可以点击下方链接观看,了解更多关于Transformer模型的内容

cda链接:https://edu.cda.cn/goods/show/3634

引言

在人工智能的浪潮中,Transformer模型无疑是革命性的技术,尤其是在自然语言处理(NLP)领域。自从OpenAI公司的Chatgpt展现出惊人的能力以来,Transformer模型便成为了众多大模型的核心算法。本文将通过可视化的方式,深入探讨Transformer模型的前置知识——注意力机制,揭开这一人工智能的神秘。

一、Transformer模型的崛起

Transformer模型首次亮相于2017年的一篇论文《Attention is All You Need》中,该模型通过引入注意力机制,彻底改变了自然语言处理的方式。在此之前,循环神经网络(RNN)和卷积神经网络(CNN)是处理序列数据的主流方法,但在处理长距离依赖时存在局限性。Transformer模型通过自注意力(Self-Attention)机制,实现了对文本中任意两个单词之间关系的直接建模,极大地提高了模型处理长文本的能力。

二、注意力机制的基本概念

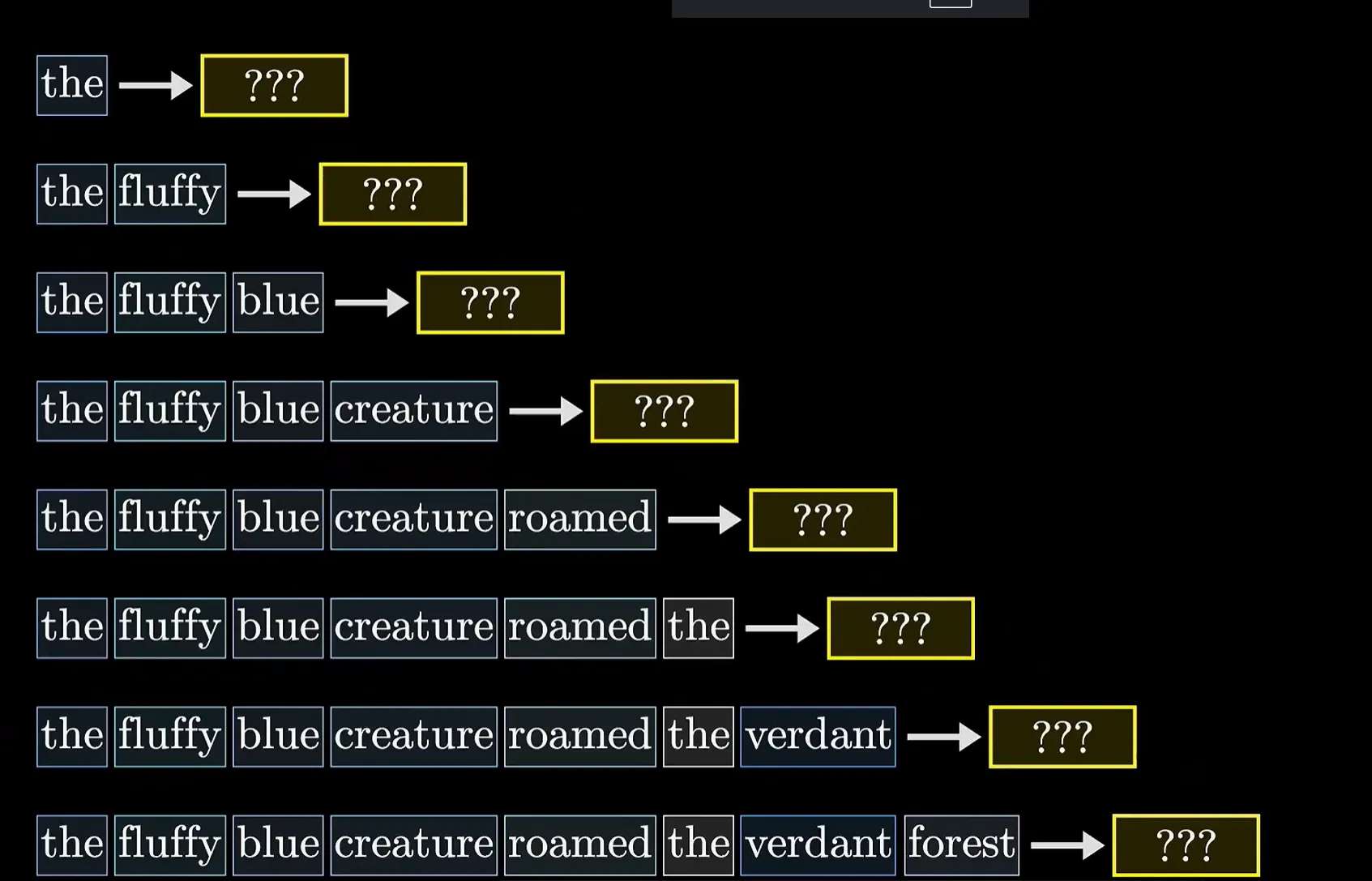

在深入Transformer模型之前,需要先了解注意力机制。简单来说,注意力机制是一种让模型在处理信息时能够“集中注意力”到重要部分的技术。在Transformer模型中,注意力机制被用来计算文本中每个单词对其他单词的关注度,从而捕捉单词之间的依赖关系。

三、Tokenization与Embedding

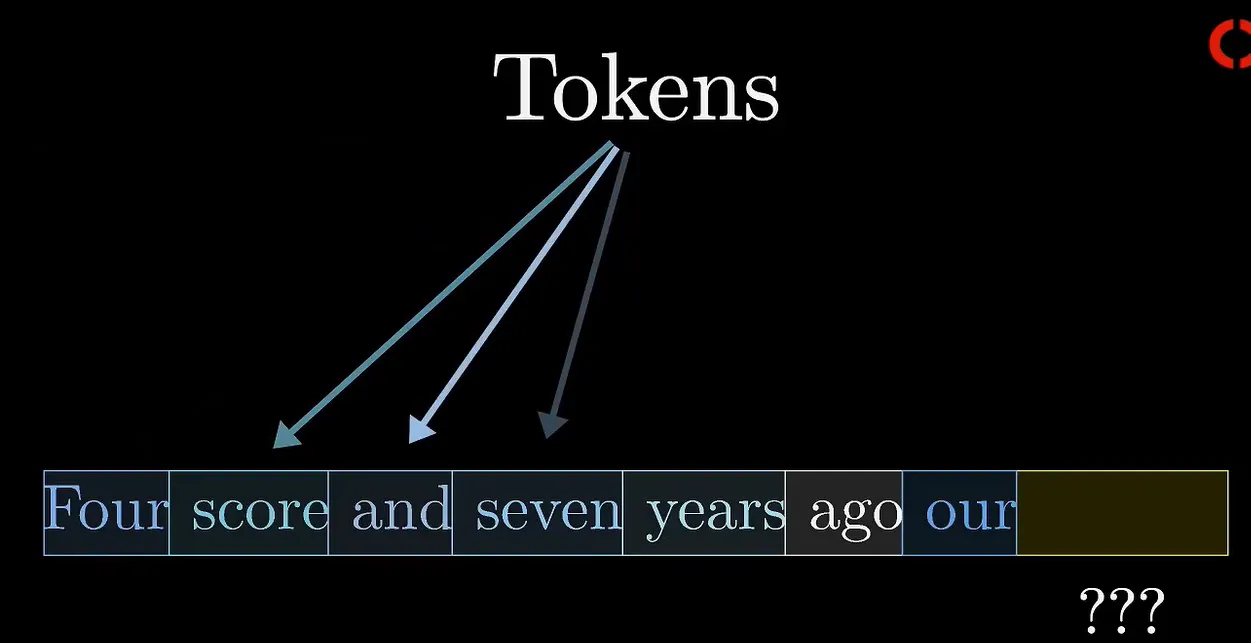

在Transformer模型中,文本首先被分割成更小的单元,这些单元被称为Token。Token通常是完整的单词或单词的一部分,是文本数据中最小的可处理单元。对于中文来说,由于语言的特殊性,Token可以是一个字或一个词。

Tokenization是将文本分解为Token的过程。例如,句子“I love NLP”可以被分词为[“I”, “love”, “NLP”]三个Token。在一些复杂的语言模型中,Token甚至可以是单词的一部分,这种细分方法在处理复杂语言和不同形态变化时非常有用。

接下来,每个Token会被转换为一个高维向量,这个过程被称为Embedding。Embedding使得模型能够在高维空间中表示单词,不同单词之间的向量距离反映了在语义上的相似性。例如,“cat”和“dog”的向量可能会比“cat”和“apple”的向量更接近,因为都属于动物类别。

四、Transformer模型的核心结构

Transformer模型主要由编码器(Encoder)和解码器(Decoder)两部分组成。编码器负责将输入文本转换为一系列向量表示,而解码器则根据这些向量表示生成输出文本。

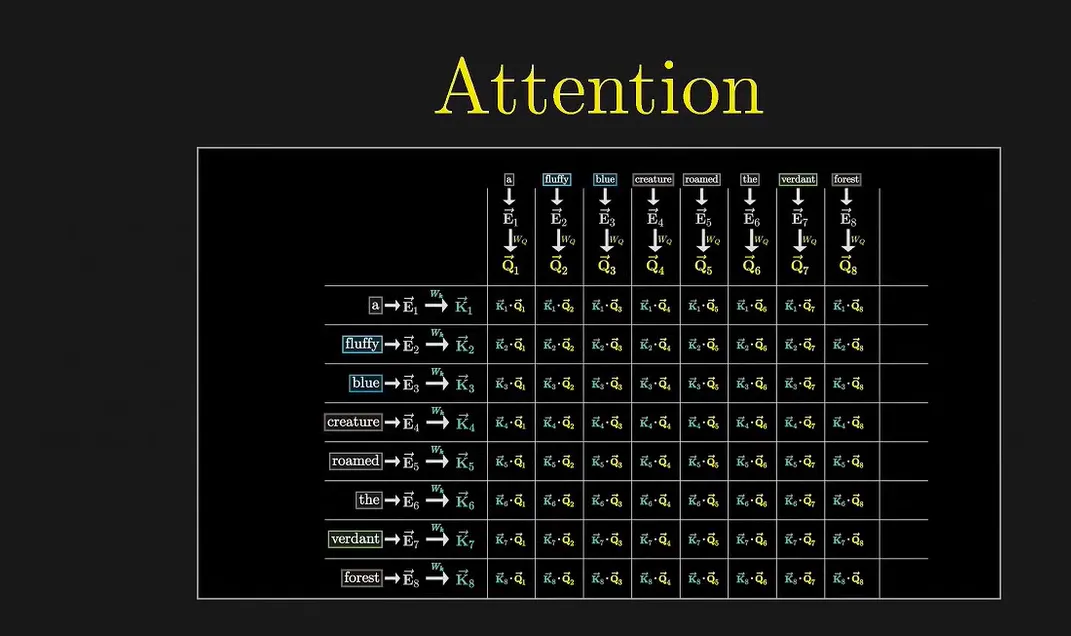

在编码器中,每个Token的Embedding首先会经过一个自注意力层(Self-Attention Layer),该层会计算当前Token对所有其他Token的关注度,并据此更新当前Token的向量表示。自注意力层之后,通常会跟随一个前馈神经网络(Feed-Forward Neural Network)和归一化层(Normalization Layer),以进一步处理Token的向量表示。

解码器的结构与编码器类似,但增加了一个编码器-解码器注意力层(Encoder-Decoder Attention Layer),用于计算解码器中的Token对编码器输出的关注度。这样,解码器在生成输出文本时,就能够参考输入文本的信息。

五、注意力机制的可视化展示

为了更好地理解注意力机制,可以通过可视化的方式展示Transformer模型在处理文本时的内部运作。例如,可以绘制一个热力图(Heatmap),其中每个单元格的颜色深浅表示两个Token之间的关注度大小。颜色越深,表示关注度越高;颜色越浅,表示关注度越低。

通过观察热力图,可以直观地看到模型在处理文本时是如何分配注意力的。例如,在处理句子“behold, a wild pi creature, foraging in its native habitat”时,模型可能会将更多的注意力分配给“wild”、“creature”和“habitat”等关键词,因为这些词对于理解整个句子的含义至关重要。

六、总结

Transformer模型通过引入注意力机制,实现了对文本中任意两个单词之间关系的直接建模,极大地提高了自然语言处理的能力。随着技术的不断发展,Transformer模型已经在机器翻译、文本生成、问答系统等多个领域取得了显著成果。未来,期待Transformer模型能够在更多领域发挥更大的作用,推动人工智能技术的进一步发展。

通过本文的讲解和可视化展示,相信大家对Transformer模型及其核心算法——注意力机制有了更深入的了解。希望这能为大家在学习和应用Transformer模型时提供一些帮助和启示。

最后,有兴趣的小伙伴可以点击下方链接观看视频,了解更多关于Transformer模型的内容

https://edu.cda.cn/goods/show/3634

雷达卡

雷达卡

京公网安备 11010802022788号

京公网安备 11010802022788号